AI Bedeutung: Zukunftstrends im Online‑Marketing verstehen

Alle reden von AI, aber kaum jemand versteht, was die AI Bedeutung im Online‑MarketingMarketing: Das Spiel mit Bedürfnissen, Aufmerksamkeit und Profit Marketing ist weit mehr als bunte Bilder, Social-Media-Posts und nervige Werbespots. Marketing ist die strategische Kunst, Bedürfnisse zu erkennen, sie gezielt zu wecken – und aus Aufmerksamkeit Profit zu schlagen. Es ist der Motor, der Unternehmen antreibt, Marken formt und Kundenverhalten manipuliert, ob subtil oder mit der Brechstange. Dieser Artikel entlarvt das... wirklich ist: weniger Buzzword-Bingo, mehr brachiale Effizienz, neue Spielregeln und gnadenlose Transparenz in Daten, Prozessen und Performance. Wer 2025 noch auf Bauchgefühl und bunte Dashboards setzt, wird von Teams überholt, die Modelle, Pipelines und Metriken beherrschen. Dieser Artikel zerlegt die AI Bedeutung ohne Romantik, erklärt Zukunftstrends ohne Hype, und zeigt dir, wie du sie technisch sauber in deinen Stack pflanzt – damit deine Kampagnen nicht mehr hoffen, sondern rechnen.

- AI Bedeutung im Online‑MarketingMarketing: Das Spiel mit Bedürfnissen, Aufmerksamkeit und Profit Marketing ist weit mehr als bunte Bilder, Social-Media-Posts und nervige Werbespots. Marketing ist die strategische Kunst, Bedürfnisse zu erkennen, sie gezielt zu wecken – und aus Aufmerksamkeit Profit zu schlagen. Es ist der Motor, der Unternehmen antreibt, Marken formt und Kundenverhalten manipuliert, ob subtil oder mit der Brechstange. Dieser Artikel entlarvt das...: was sie wirklich verändert – von ContentContent: Das Herzstück jedes Online-Marketings Content ist der zentrale Begriff jeder digitalen Marketingstrategie – und das aus gutem Grund. Ob Text, Bild, Video, Audio oder interaktive Elemente: Unter Content versteht man sämtliche Inhalte, die online publiziert werden, um eine Zielgruppe zu informieren, zu unterhalten, zu überzeugen oder zu binden. Content ist weit mehr als bloßer Füllstoff zwischen Werbebannern; er ist... bis Commerce

- Die wichtigsten Zukunftstrends: Generative AI, Automatisierung, Personalisierung, Agent Assist

- Daten-Realität 2025: Consent, Server-Side-Tracking, clean rooms und der neue MarTech‑Stack

- AI SEOSEO (Search Engine Optimization): Das Schlachtfeld der digitalen Sichtbarkeit SEO, kurz für Search Engine Optimization oder Suchmaschinenoptimierung, ist der Schlüsselbegriff für alle, die online überhaupt gefunden werden wollen. Es bezeichnet sämtliche Maßnahmen, mit denen Websites und deren Inhalte so optimiert werden, dass sie in den unbezahlten, organischen Suchergebnissen von Google, Bing und Co. möglichst weit oben erscheinen. SEO ist längst... statt Keyword-Spam: E-E-A-TE-E-A-T: Das Google-Kriterium für Qualität, Vertrauen und echte Expertise E-E-A-T steht für Experience, Expertise, Authoritativeness und Trustworthiness – also Erfahrung, Expertise, Autorität und Vertrauenswürdigkeit. Der Begriff ist das Synonym für Googles Qualitätsanspruch an Webseiten und deren Inhalte. Wer im organischen Google-Ranking nach oben will, kommt an E-E-A-T nicht vorbei. Aber was steckt dahinter, warum spielt es eine zunehmend dominante Rolle..., Knowledge GraphKnowledge Graph: Das neuronale Gedächtnis der Suchmaschinen Der Begriff Knowledge Graph beschreibt eine datenbankähnliche Struktur, die Wissen nicht mehr linear, sondern als Netzwerk von Entitäten, Attributen und Beziehungen speichert und abbildet. Vor allem Google hat den Knowledge Graph 2012 als Herzstück seiner semantischen Suche eingeführt, doch das Konzept ist viel älter und weitreichender. Der Knowledge Graph ist das, was Suchmaschinen..., Schema.org und SuchintentionSuchintention: Das unsichtbare Fundament jeder erfolgreichen SEO-Strategie Die Suchintention – auf Englisch Search Intent oder User Intent – ist der wahre Grund, warum jemand eine Suchanfrage bei Google & Co. startet. Es geht also um das „Warum“ hinter jedem Keyword. Wer SEO, Content-Marketing oder Conversion-Optimierung ohne tiefes Verständnis für Suchintention betreibt, spielt SEO-Roulette. Die Suchintention ist das unsichtbare Fundament, das...

- Paid MediaPaid Media: Die bezahlte Bühne im Online-Marketing – und warum du sie nicht ignorieren kannst Paid Media bezeichnet alle Marketing-Maßnahmen, bei denen Unternehmen für die Platzierung von Inhalten, Anzeigen oder Markenbotschaften direkt bezahlen. Ob Google Ads, Facebook Ads, Bannerwerbung, YouTube Pre-Rolls oder Native Advertising – Paid Media ist das Gegenteil von organischer Reichweite. Hier geht es um maximale Sichtbarkeit, blitzschnelle... mit AI: Bid‑Management, Creative AutomationAutomation: Der wahre Gamechanger im digitalen Zeitalter Automation ist das Zauberwort, das seit Jahren durch die Flure jeder halbwegs digitalen Company hallt – und trotzdem bleibt es oft ein Buzzword, das kaum jemand wirklich versteht. In der Realität bedeutet Automation weit mehr als nur ein paar Makros oder „Automatisierungstools“: Es ist die gezielte, systematische Übertragung wiederkehrender Aufgaben auf Software oder..., MMM/MTA und kausale Tests

- Technik-Tiefgang: LLMs, RAG, Embeddings, Vektor‑Datenbanken, Guardrails und Evaluierung

- Implementierungs‑Playbook: Architektur, Tools, Team‑Design, Governance und Monitoring

- KPIsKPIs: Die harten Zahlen hinter digitalem Marketing-Erfolg KPIs – Key Performance Indicators – sind die Kennzahlen, die in der digitalen Welt den Takt angeben. Sie sind das Rückgrat datengetriebener Entscheidungen und das einzige Mittel, um Marketing-Bullshit von echtem Fortschritt zu trennen. Ob im SEO, Social Media, E-Commerce oder Content Marketing: Ohne KPIs ist jede Strategie nur ein Schuss ins Blaue...., die wirklich zählen: Uplift, LTV‑Forecast, NDCG, Halluzinationsrate und Produktions‑SLAs

Die AI Bedeutung im Online‑MarketingMarketing: Das Spiel mit Bedürfnissen, Aufmerksamkeit und Profit Marketing ist weit mehr als bunte Bilder, Social-Media-Posts und nervige Werbespots. Marketing ist die strategische Kunst, Bedürfnisse zu erkennen, sie gezielt zu wecken – und aus Aufmerksamkeit Profit zu schlagen. Es ist der Motor, der Unternehmen antreibt, Marken formt und Kundenverhalten manipuliert, ob subtil oder mit der Brechstange. Dieser Artikel entlarvt das... ist nicht die nächste Content-Maschine mit lustigen Prompts, sondern ein struktureller Umbau von Strategie, Datenhaltung und Auslieferung. AI Bedeutung heißt, dass Modelle Entscheidungen beschleunigen, Arbeitsteilung neu definieren und Kreativität messbar machen. AI Bedeutung heißt auch, dass du Fehler schneller skalierst, wenn du deine Hausaufgaben beim TrackingTracking: Die Daten-DNA des digitalen Marketings Tracking ist das Rückgrat der modernen Online-Marketing-Industrie. Gemeint ist damit die systematische Erfassung, Sammlung und Auswertung von Nutzerdaten – meist mit dem Ziel, das Nutzerverhalten auf Websites, in Apps oder über verschiedene digitale Kanäle hinweg zu verstehen, zu optimieren und zu monetarisieren. Tracking liefert das, was in hippen Start-up-Kreisen gern als „Daten-Gold“ bezeichnet wird..., bei Datenqualität und bei Guardrails ignorierst. AI Bedeutung bedeutet, dass du ohne stabile Datengrundlage nur schöne Demos baust, die im Betrieb zusammenbrechen. AI Bedeutung zwingt dich, dein Team wie ein Produktteam zu führen, nicht wie eine Kampagnenfabrik.

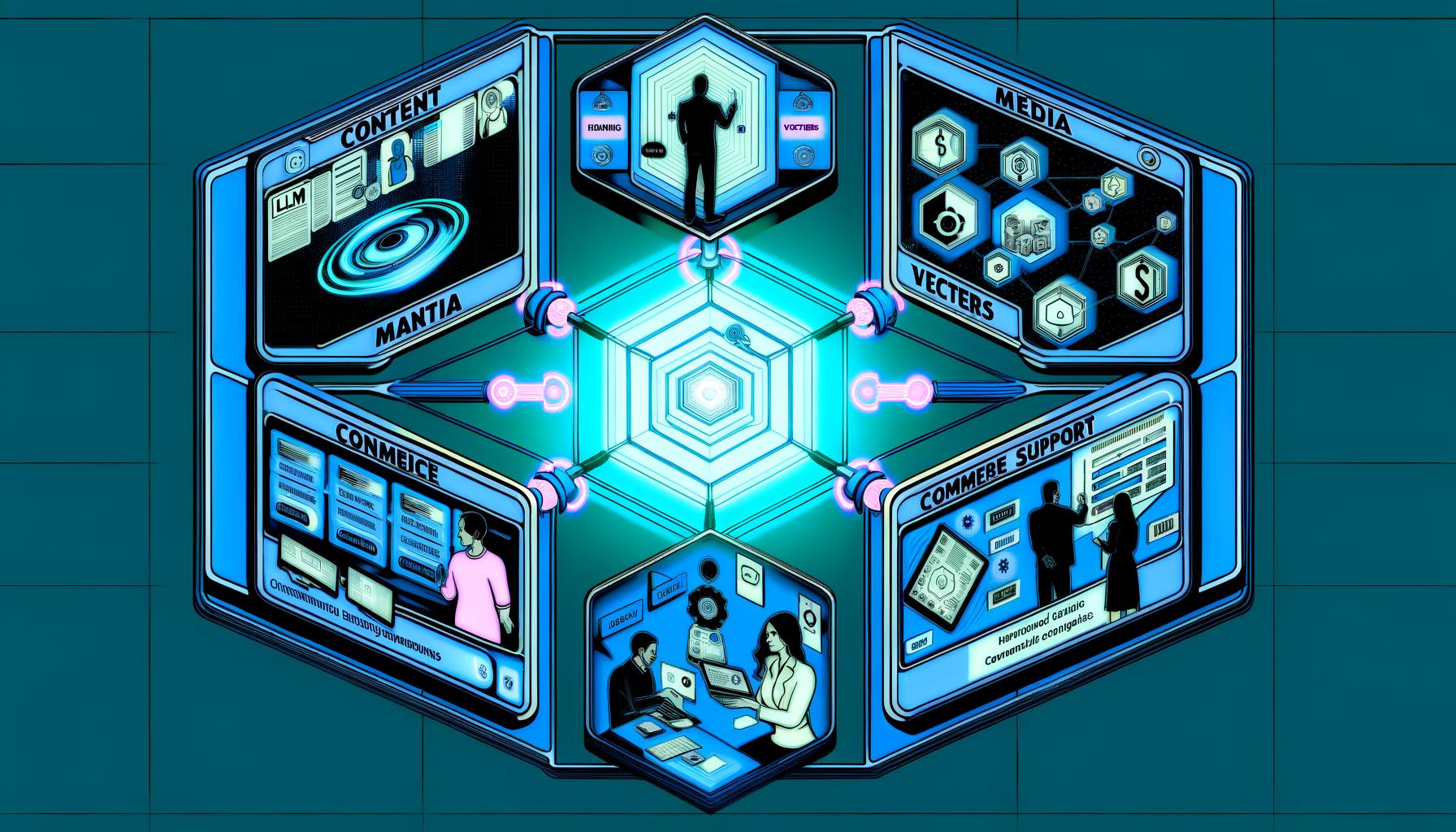

Kurz gesagt: Wer die AI Bedeutung ernst nimmt, baut einen Marketing‑Operating‑System‑Layer, der ContentContent: Das Herzstück jedes Online-Marketings Content ist der zentrale Begriff jeder digitalen Marketingstrategie – und das aus gutem Grund. Ob Text, Bild, Video, Audio oder interaktive Elemente: Unter Content versteht man sämtliche Inhalte, die online publiziert werden, um eine Zielgruppe zu informieren, zu unterhalten, zu überzeugen oder zu binden. Content ist weit mehr als bloßer Füllstoff zwischen Werbebannern; er ist..., Media, CRMCRM (Customer Relationship Management): Die Königsdisziplin der Kundenbindung und Datenmacht CRM steht für Customer Relationship Management, also das Management der Kundenbeziehungen. Im digitalen Zeitalter bedeutet CRM weit mehr als bloß eine Adressdatenbank. Es ist ein strategischer Ansatz und ein ganzes Software-Ökosystem, das Vertrieb, Marketing und Service miteinander verzahnt, mit dem Ziel: maximale Wertschöpfung aus jedem Kundenkontakt. Wer CRM auf „Newsletter..., Commerce und Support verbindet. Dieser Layer setzt auf Large Language Models, Retrieval‑Augmented Generation, Feature Stores, Event‑Pipelines und Evaluation Loops. Er reduziert Reibung zwischen Kanälen, entfernt manuelle Handoffs und bringt Messbarkeit dorthin, wo früher Meinung regierte. Und ja, das klingt technisch, weil es technisch ist – genau das unterscheidet Gewinner von Nostalgikern.

AI Bedeutung im Online‑Marketing: Definition, Nutzen, Grenzen

AI im MarketingMarketing: Das Spiel mit Bedürfnissen, Aufmerksamkeit und Profit Marketing ist weit mehr als bunte Bilder, Social-Media-Posts und nervige Werbespots. Marketing ist die strategische Kunst, Bedürfnisse zu erkennen, sie gezielt zu wecken – und aus Aufmerksamkeit Profit zu schlagen. Es ist der Motor, der Unternehmen antreibt, Marken formt und Kundenverhalten manipuliert, ob subtil oder mit der Brechstange. Dieser Artikel entlarvt das... ist die Anwendung von statistischen Lernverfahren und generativen Modellen auf Inhalte, Entscheidungen und Workflows, und die AI Bedeutung misst sich an messbaren Uplifts, nicht an Slides. Large Language Models wie GPT‑4o, Claude oder Llama nutzen Transformer‑Architekturen, Tokens und Selbstaufmerksamkeit, um Sprache, Layouts und Bilder zu erzeugen oder zu verstehen. Generative Modelle liefern Text, Bild, Video und Code; diskriminative Modelle steuern Bidding, Scoring, RankingRanking: Das kompromisslose Spiel um die Sichtbarkeit in Suchmaschinen Ranking bezeichnet im Online-Marketing die Platzierung einer Website oder einzelner URLs in den organischen Suchergebnissen einer Suchmaschine, typischerweise Google. Es ist der digitale Olymp, auf den jeder Website-Betreiber schielt – denn nur wer bei relevanten Suchanfragen weit oben rankt, existiert überhaupt im Kopf der Zielgruppe. Ranking ist keine Glückssache, sondern das... und Segmentierung. Der Nutzen entsteht erst, wenn du Modelle mit deinen First‑Party‑Daten verbindest, Operationalisierung mit MLOps absicherst und Outcomes statt Outputs bewertest. Grenzen zeigen sich bei Halluzinationen, Bias, Drift und DatenschutzDatenschutz: Die unterschätzte Macht über digitale Identitäten und Datenflüsse Datenschutz ist der Begriff, der im digitalen Zeitalter ständig beschworen, aber selten wirklich verstanden wird. Gemeint ist der Schutz personenbezogener Daten vor Missbrauch, Überwachung, Diebstahl und Manipulation – egal ob sie in der Cloud, auf Servern oder auf deinem Smartphone herumlungern. Datenschutz ist nicht bloß ein juristisches Feigenblatt für Unternehmen, sondern... – alles lösbar, aber nur mit sauberer Architektur und klaren Guardrails. Ohne Governance, Evaluierung und klare SLAs wird jede AI‑Initiative zur teuren Spielerei.

Konkreter Nutzen beginnt bei Automatisierung repetitiver Aufgaben, etwa Briefing‑Drafts, Variationen für Creatives, Quality‑Checks und Semantic Tagging. Personalisierung wird granularer, weil Embeddings semantische Ähnlichkeiten verstehen und Vektor‑Suche echte Relevanz statt Keyword‑Glück liefert. Entscheidungsmodelle optimieren Budgets per Multi‑Armed‑Bandits, Bayesian Uplift Modeling und kausalen Tests, statt Klick‑Korrelationen zu feiern. Content‑Ops profitieren von AI‑gestützter Planung, Entwurf, Redaktionsprüfung, Fakt‑Retrieval und strukturierten Ausspielungen via JSON‑LD. Customer Support nutzt Agent Assist, um Lösungen, Makros und Tonalität automatisch zu liefern, während Conversational Commerce Leads qualifiziert, Angebote erklärt und Abbrüche reduziert. Wichtig: Jede Automatisierung braucht ein Rückfallnetz aus Regeln, Reviews und Telemetrie, sonst skalierst du Fehler in Produktionsgeschwindigkeit.

Die AI Bedeutung hat aber harte Grenzen, die du nicht wegtalken kannst. Modelle kennen dein Geschäft nicht, wenn du es ihnen nicht beibringst; deshalb brauchst du RAG‑Pipelines, die über Embeddings auf geprüfte Wissensquellen zugreifen. Datenqualität frisst jede Modellgröße zum Frühstück, also investiere in Deduplication, Normalisierung, Consent‑Status und Ereignis-Schemas. Halluzinationen sinken mit Retrieval, Systemprompts, Werkzeugintegration und Output‑Validierung, verschwinden aber nie vollständig. Bias lässt sich mit Kuratierung, Gegenbeispielen und fairness‑Checks reduzieren, doch Verantwortung bleibt bei dir. Und rechtlich gilt: Datenhoheit, Urheberrecht und Markenrisiko gehören nicht in den Kleingedruckten Teil deines Projekts, sondern in die Architektur.

Zukunftstrends 2025–2028: Generative AI, Automatisierung und Personalisierung auf Steroiden

Generative AI wird vom Textgenerator zur vollintegrierten Marketing‑Runtime, die ContentContent: Das Herzstück jedes Online-Marketings Content ist der zentrale Begriff jeder digitalen Marketingstrategie – und das aus gutem Grund. Ob Text, Bild, Video, Audio oder interaktive Elemente: Unter Content versteht man sämtliche Inhalte, die online publiziert werden, um eine Zielgruppe zu informieren, zu unterhalten, zu überzeugen oder zu binden. Content ist weit mehr als bloßer Füllstoff zwischen Werbebannern; er ist..., Strategie und Ausspielung synchronisiert. Multi‑Modalität verknüpft Sprache, Bild, Video und Interaktion, wodurch Kampagnen aus einem semantischen Kern hunderte Varianten für Kanäle, Zielgruppen und Formate erzeugen. Orchestrierungslayer verbinden LLMs mit Tools wie PIM, DAM, CMSCMS (Content Management System): Das Betriebssystem für das Web CMS steht für Content Management System und ist das digitale Rückgrat moderner Websites, Blogs, Shops und Portale. Ein CMS ist eine Software, die es ermöglicht, Inhalte wie Texte, Bilder, Videos und Strukturelemente ohne Programmierkenntnisse zu erstellen, zu verwalten und zu veröffentlichen. Ob WordPress, TYPO3, Drupal oder ein Headless CMS – das..., CDP und Ad‑APIs, sodass Workflows automatisch Daten ziehen, Regeln prüfen und Ergebnisse publishen. Auto‑Evaluierung vergleicht Varianten mit NDCG, CTR‑Forecasts und LTV‑Proxys, und dreht Parameter, wenn Metriken abrutschen. Synthetic Data ergänzt rare Beispiele für Nischen, ohne echte Kunden zu belasten, solange du klare Wasserzeichen und Eval‑Protokolle einsetzt. Kurz: ContentContent: Das Herzstück jedes Online-Marketings Content ist der zentrale Begriff jeder digitalen Marketingstrategie – und das aus gutem Grund. Ob Text, Bild, Video, Audio oder interaktive Elemente: Unter Content versteht man sämtliche Inhalte, die online publiziert werden, um eine Zielgruppe zu informieren, zu unterhalten, zu überzeugen oder zu binden. Content ist weit mehr als bloßer Füllstoff zwischen Werbebannern; er ist... wird billiger, Distribution smarter, und Differenzierung verschiebt sich zu Daten, Tonalität und Markenlogik.

Personalisierung löst sich von Micro‑Segments hin zu Echtzeit‑Relevanz über semantische Profile und Kontext‑Features. Embeddings erfassen Absicht, Stil und Produktaffinitäten, Vektor‑Datenbanken liefern in Millisekunden passende Inhalte, und RAG injiziert aktuelle Infos in Antworten, ohne Modelle komplett neu zu trainieren. Bandit‑Algorithmen wie Thompson Sampling finden schnell funktionierende Varianten, während kausale Modelle echten Uplift statt Klick‑Artefakten messen. Reinforcement Learning kommt in Produktsuche, Onsite‑Rekommandationen und Pricing‑Experimente, aber nur mit harter Safety‑Schicht und Rollback‑Strategie. Ergebnis: Weniger Jägerlatein im Reporting, mehr lernende Systeme, die mit jedem Ereignis smarter werden. Die Grenze ist nicht die Modellgröße, sondern die Reife deiner Daten- und Experimentierkultur.

Der vielleicht unterschätzte Trend ist Agent Assist über die gesamte Wertschöpfung: vom Media‑Planner bis zum Account‑Manager. Copiloten fassen Calls zusammen, extrahieren To‑dos, bauen Decks, prüfen Kampagnenregeln und warnen bei Anomalien in Spend, CR oder CPACPA (Cost per Action): Performance-Marketing ohne Bullshit CPA steht für Cost per Action, manchmal auch als Cost per Acquisition bezeichnet. Es ist ein Abrechnungsmodell im Online-Marketing, bei dem Werbetreibende nur dann zahlen, wenn eine vorher festgelegte Aktion durch den Nutzer tatsächlich ausgeführt wird – sei es ein Kauf, eine Anmeldung oder das Ausfüllen eines Formulars. Klingt simpel, ist aber in.... In Commerce‑Stacks übernehmen Shop‑Bots Beratung, Bundles und Nachfass‑Sequenzen, inklusive Hand‑off an Menschen bei Unsicherheit. Content‑Teams nutzen AI‑Review‑Pipelines für Stil, Fakten und Markenleitfäden, bevor ein Mensch finalisiert. Operations sehen weniger Firefighting, weil Alerting, Root‑Cause‑Analysen und Remediation‑Vorschläge direkt in Slack oder Teams landen. Wer das orchestriert, spart nicht nur Stunden, sondern gewinnt Taktzeit – und Taktzeit schlägt Budget.

Daten, Tracking und Privacy: AI, Consent und der neue MarTech‑Stack

Ohne Daten kein Lernen, und ohne saubere Erfassung keine AI Bedeutung in der Praxis. Server‑Side‑Tagging verlagert Events vom fragilen Browser‑Zoo in kontrollierte Server‑Umgebungen, stabilisiert Signale und reduziert Ad‑Blocker‑Verluste. Consent Mode v2 sorgt dafür, dass du modellierte und echte Daten korrekt trennst, AttributionAttribution: Die Kunst der Kanalzuordnung im Online-Marketing Attribution bezeichnet im Online-Marketing den Prozess, bei dem der Erfolg – etwa ein Kauf, Lead oder eine Conversion – den einzelnen Marketingkanälen und Touchpoints auf der Customer Journey zugeordnet wird. Kurz: Attribution versucht zu beantworten, welcher Marketingkontakt welchen Beitrag zum Ergebnis geleistet hat. Klingt simpel. In Wirklichkeit ist Attribution jedoch ein komplexes, hoch... fair bleibt und Audits nicht im Chaos enden. Clean Rooms ermöglichen kooperative Analysen mit Partnern, ohne Rohdaten zu teilen, während Differential Privacy sensible Infos schützt. In der Google Privacy Sandbox lösen Topics APIAPI – Schnittstellen, Macht und Missverständnisse im Web API steht für „Application Programming Interface“, zu Deutsch: Programmierschnittstelle. Eine API ist das unsichtbare Rückgrat moderner Softwareentwicklung und Online-Marketing-Technologien. Sie ermöglicht es verschiedenen Programmen, Systemen oder Diensten, miteinander zu kommunizieren – und zwar kontrolliert, standardisiert und (im Idealfall) sicher. APIs sind das, was das Web zusammenhält, auch wenn kein Nutzer je eine... und Protected Audience alte Third‑Party‑CookiesCookies: Die Wahrheit über die kleinen Datenkrümel im Web Cookies sind kleine Textdateien, die Websites im Browser eines Nutzers speichern, um Informationen über dessen Aktivitäten, Präferenzen oder Identität zu speichern. Sie gehören zum technischen Rückgrat des modernen Internets – oft gelobt, oft verteufelt, meistens missverstanden. Ob personalisierte Werbung, bequeme Logins oder penetrante Cookie-Banner: Ohne Cookies läuft im Online-Marketing fast gar... ab, was TargetingTargeting: Präzision statt Streuverlust im digitalen Marketing Targeting beschreibt im Online-Marketing die Kunst – und Wissenschaft – der präzisen Zielgruppenansprache. Es geht darum, Werbebotschaften, Inhalte oder Angebote genau den Nutzern auszuspielen, die am wahrscheinlichsten konvertieren, kaufen oder sich engagieren. Targeting ist die Antwort auf die teuerste Plage des Marketings: Streuverluste. Wer im Jahr 2024 noch mit der Gießkanne wirbt, verbrennt... und RemarketingRemarketing: Die Kunst, Nutzer aus dem digitalen Off zurückzuholen Remarketing ist im Online-Marketing so etwas wie der Boomerang unter den Werbemaßnahmen: Der Nutzer war schon mal da, ist aber wieder verschwunden – und jetzt wird er gezielt zurückgeholt. Remarketing (auch Retargeting genannt) bezeichnet Strategien und Technologien, mit denen gezielt ehemalige Besucher einer Website oder App erneut angesprochen werden, um sie... neu kalibriert. Wer hier nicht baut, wird blind, und blinde Modelle fahren Kampagnen gegen die Wand.

Der moderne MarTech‑Stack ist events‑first und API‑getrieben. Eine CDP aggregiert First‑Party‑Daten, reichert Profile an und aktiviert Audiences, während Feature Stores Merkmale konsistent für Echtzeit‑Modelle bereitstellen. Event‑Pipelines auf Basis von Kafka, Pub/Sub oder Kinesis transportieren Transaktionen, Sessions und Interaktionen in AnalyticsAnalytics: Die Kunst, Daten in digitale Macht zu verwandeln Analytics – das klingt nach Zahlen, Diagrammen und vielleicht nach einer Prise Langeweile. Falsch gedacht! Analytics ist der Kern jeder erfolgreichen Online-Marketing-Strategie. Wer nicht misst, der irrt. Es geht um das systematische Sammeln, Auswerten und Interpretieren von Daten, um digitale Prozesse, Nutzerverhalten und Marketingmaßnahmen zu verstehen, zu optimieren und zu skalieren...., Warehouses und Modelle. Vektor‑Datenbanken wie Pinecone, Weaviate oder Milvus halten Embeddings für Suche, Personalisierung und RAG bereit. Identity‑Resolution verbindet Geräte und Kanäle anhand deterministischer und probabilistischer Signale, respektiert aber Consent und regionale Rechtslagen. Das Ziel ist einfache Wahrheit: eine konsistente, latenzarme Datenbasis, auf die Modelle und Teams vertrauen können.

Qualität schlägt Quantität, deshalb brauchst du Contracts, Tests und Monitoring. Schemas definieren, welche Events Pflichtfelder haben, welche Wertebereiche gelten und wie Versionierung funktioniert. Unit‑ und Integrationstests fangen defekte Tags ab, bevor sie Metriken zerstören, während Data‑Quality‑Jobs Anomalien in Volumen, Distribution und Korrelation detektieren. Model Drift wird mit Referenzverteilungen, PSI‑Scores und Shadow Deployment überwacht, damit du nicht mit veralteten Annahmen optimierst. Lineage‑Tools zeigen, wie ein KPIKPI: Key Performance Indicator – Die erbarmungslose Messlatte im Online-Marketing KPI steht für Key Performance Indicator, auf Deutsch: „Leistungskennzahl“. Im digitalen Marketing und speziell im Online-Business sind KPIs die objektiven Maßstäbe, an denen sich Erfolg oder Misserfolg schonungslos messen lässt. Wer mit Marketing-Buzzwords um sich wirft, aber seine KPI nicht kennt – oder schlimmer: nicht messen kann –, spielt nicht... entsteht und welche Pipelines ihn beeinflussen, was Audits beschleunigt. So wird aus Datenmagie echte Ingenieurskunst – und deine AI sitzt nicht länger auf einem Kartenhaus.

AI SEO: Content, E‑E‑A‑T, Knowledge Graph und SERP‑Strategien

AI SEOSEO (Search Engine Optimization): Das Schlachtfeld der digitalen Sichtbarkeit SEO, kurz für Search Engine Optimization oder Suchmaschinenoptimierung, ist der Schlüsselbegriff für alle, die online überhaupt gefunden werden wollen. Es bezeichnet sämtliche Maßnahmen, mit denen Websites und deren Inhalte so optimiert werden, dass sie in den unbezahlten, organischen Suchergebnissen von Google, Bing und Co. möglichst weit oben erscheinen. SEO ist längst... beginnt mit dem Eingeständnis, dass Texte allein nicht reichen und die SuchintentionSuchintention: Das unsichtbare Fundament jeder erfolgreichen SEO-Strategie Die Suchintention – auf Englisch Search Intent oder User Intent – ist der wahre Grund, warum jemand eine Suchanfrage bei Google & Co. startet. Es geht also um das „Warum“ hinter jedem Keyword. Wer SEO, Content-Marketing oder Conversion-Optimierung ohne tiefes Verständnis für Suchintention betreibt, spielt SEO-Roulette. Die Suchintention ist das unsichtbare Fundament, das... König bleibt. Modelle helfen bei der Themenarchitektur, indem sie Entitäten, Relationen und Fragen aus Knowledge‑Graph‑Sicht ordnen, statt stumpf KeywordsKeywords: Der Taktgeber jeder erfolgreichen Online-Marketing-Strategie Keywords sind das Herzstück jeder digitalen Sichtbarkeitsstrategie. Sie sind die Brücke zwischen dem, was Nutzer in Suchmaschinen eintippen, und den Inhalten, die Unternehmen bereitstellen. Ob SEO, SEA, Content-Marketing oder Conversion-Optimierung – ohne die richtigen Keywords läuft gar nichts. Wer denkt, Keywords seien nur ein alter SEO-Hut, hat die Entwicklung der letzten Jahre schlicht verschlafen.... zu zählen. RAG liefert geprüfte Fakten in Drafts, während strukturierte DatenStrukturierte Daten: Das Power-Upgrade für SEO, Rich Snippets & Maschinenverständnis Strukturierte Daten sind der geheime Zaubertrank im SEO-Arsenal: Sie machen Inhalte maschinenlesbar und verhelfen Websites zu prominenteren Darstellungen in den Suchergebnissen – Stichwort Rich Snippets. Im Kern geht es darum, Informationen so zu kennzeichnen, dass Suchmaschinen wie Google, Bing oder Yandex exakt verstehen, worum es auf einer Seite geht. Keine... in JSON‑LD Google die Bedeutung deiner Inhalte explizit machen. Interne VerlinkungInterne Verlinkung: Das unterschätzte Rückgrat jeder erfolgreichen Website Interne Verlinkung ist der technische und strategische Prozess, bei dem einzelne Seiten einer Website durch Hyperlinks miteinander verbunden werden. Was für viele wie banale Blaupausen im Content Management System wirkt, ist in Wahrheit einer der mächtigsten Hebel für SEO, Nutzerführung und nachhaltiges Wachstum. Ohne eine durchdachte interne Linkstruktur bleibt selbst der beste... folgt semantischen Clustern, nicht nur Navigationswillkür, und reduziert Klicktiefe für wichtige Knoten. E‑E‑A‑T wird greifbar durch Autorenschaft, Quellen, Reputationssignale und nachvollziehbare Belege, die AI‑Pipelines automatisch prüfen und markieren. Ergebnis: Inhalte, die SuchmaschinenSuchmaschinen: Das Rückgrat des Internets – Definition, Funktionsweise und Bedeutung Suchmaschinen sind die unsichtbaren Dirigenten des digitalen Zeitalters. Sie filtern, sortieren und präsentieren Milliarden von Informationen tagtäglich – und entscheiden damit, was im Internet gesehen wird und was gnadenlos im Daten-Nirwana verschwindet. Von Google bis Bing, von DuckDuckGo bis Yandex – Suchmaschinen sind weit mehr als simple Datenbanken. Sie sind... verstehen, weil du ihnen Bedeutung gibst – nicht weil du mehr Worte schreibst.

Technisch setzt du auf schnelle Auslieferung, saubere Renderpfade und Indexierungssicherheit. Core Web VitalsCore Web Vitals: Die Messlatte für echte Website-Performance Core Web Vitals sind Googles knallharte Antwort auf die Frage: „Wie schnell, stabil und nutzerfreundlich ist deine Website wirklich?“ Es handelt sich um eine Reihe von Metriken, die konkret messbar machen, wie Besucher die Ladezeit, Interaktivität und visuelle Stabilität einer Seite erleben. Damit sind die Core Web Vitals kein weiteres Buzzword, sondern... bleiben Pflicht: LCP, CLS und INP sind nicht Dekoration, sondern Ranking‑Requisite. JavaScript‑Frameworks brauchen SSR oder ISR, damit CrawlerCrawler: Die unsichtbaren Arbeiter der digitalen Welt Crawler – auch bekannt als Spider, Bot oder Robot – sind automatisierte Programme, die das Fundament des modernen Internets bilden. Sie durchforsten systematisch Webseiten, erfassen Inhalte, analysieren Strukturen und übermitteln diese Daten an Suchmaschinen, Plattformen oder andere zentrale Dienste. Ohne Crawler wäre Google blind, SEO irrelevant und das World Wide Web ein chaotischer... Inhalte im ersten Pass sehen, während Hydration Interaktivität nachlädt. Vektor‑Suche kann Onsite‑Suchergebnisse verbessern, was Dwell Time und Konversionen anhebt, wenn Inhalte wirklich relevant sind. Für internationale Sites sichern hreflang, Canonicals und ein stabiler Sitemap‑WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... die richtige Zuordnung. Logfile‑Analysen zeigen, wie der Bot wirklich crawlt, wo Budget verpufft und welche Knoten du priorisieren musst.

Bewertung und Qualitätssicherung sind keine Bauchgefühle, sondern Metriken und Tests. Für generierte Texte trackst du Halluzinationsrate, Quellenabdeckung und stilistische Abweichungen gegen Guidelines. Retrieval‑Qualität misst du mit NDCG, MRR und Click‑Through‑Proxy‑Signalen, bevor du SERP‑Effekte siehst. A/B‑Tests prüfen Title‑Varianten, Intro‑Blöcke und Schema‑Auszeichnungen auf CTR‑Impact, statt Vermutungen zu konservieren. Human‑in‑the‑Loop Reviews bleiben Pflicht bei sensiblen Themen, aber AI‑Prechecks fangen 80 Prozent der Fehler ab. Wichtig ist ein Review‑Takt: nach dem Launch, nach 7 Tagen, nach 30 Tagen, und bei jedem größeren Modell‑ oder Datenupdate. So bleibt dein SEOSEO (Search Engine Optimization): Das Schlachtfeld der digitalen Sichtbarkeit SEO, kurz für Search Engine Optimization oder Suchmaschinenoptimierung, ist der Schlüsselbegriff für alle, die online überhaupt gefunden werden wollen. Es bezeichnet sämtliche Maßnahmen, mit denen Websites und deren Inhalte so optimiert werden, dass sie in den unbezahlten, organischen Suchergebnissen von Google, Bing und Co. möglichst weit oben erscheinen. SEO ist längst... ein System, nicht eine Jahresaufgabe.

Paid Media trifft AI: Bidding, Creative Automation und Attribution neu gedacht

Gebotsstrategien sind längst hybrid aus Plattform‑AI und eigenen Signalen, und genau hier entscheidet sich Effizienz. Du fütterst Smart BiddingSmart Bidding: Automatisierte Gebotsstrategien im Zeitalter von KI und Performance-Marketing Smart Bidding ist die Antwort von Google Ads auf das Zeitalter der Automatisierung im Online-Marketing. Es handelt sich um eine Reihe von automatisierten Gebotsstrategien, die auf Machine Learning basieren und das Ziel haben, das Maximum aus jedem Werbebudget herauszuholen. Mit Smart Bidding wird das alte manuelle CPC-Gefrickel zur Fußnote der... mit sauberen Conversion‑Events, Mehrwertsignalen wie Profit‑Margins oder LTV‑Proxies und nutzt Value‑Based Bidding statt stumpfer CPA‑Korsetts. Bandits testen schnelle Creative‑Varianten, während Bayesian Updating Lerneffekte stabilisiert, wenn Volumen schwankt. AI generiert Headline‑Bündel, Value Props und Visuals, aber Guardrails prüfen Claims, Markenstil und Compliance, bevor etwas live geht. Spend‑Anomalien werden durch Zeitreihenmodelle erkannt, die Saisonalität, Kampagnenmix und externe Effekte einkalkulieren. Kurz: Du steuerst das System, nicht einzelne Schalter – und dein Job verschiebt sich von Klicks zu Kausalität.

AttributionAttribution: Die Kunst der Kanalzuordnung im Online-Marketing Attribution bezeichnet im Online-Marketing den Prozess, bei dem der Erfolg – etwa ein Kauf, Lead oder eine Conversion – den einzelnen Marketingkanälen und Touchpoints auf der Customer Journey zugeordnet wird. Kurz: Attribution versucht zu beantworten, welcher Marketingkontakt welchen Beitrag zum Ergebnis geleistet hat. Klingt simpel. In Wirklichkeit ist Attribution jedoch ein komplexes, hoch... wächst endlich aus dem Schatten des “Last Klick” heraus, weil Privacy harte Grenzen setzt und Modellierung erwachsen wird. Marketing MixMarketing Mix: Das strategische Fundament jedes erfolgreichen Marketings Der Begriff Marketing Mix steht für das orchestrierte Zusammenspiel der wichtigsten Stellschrauben im Marketing, um Produkte oder Dienstleistungen optimal am Markt zu platzieren. Ursprünglich als 4P-Modell bekannt (Product, Price, Place, Promotion), beschreibt der Marketing Mix die Gesamtheit aller Maßnahmen, mit denen Unternehmen ihre Zielgruppen erreichen, beeinflussen und zum Kauf bewegen. Wer glaubt,... Modeling (MMM) liefert Kanal‑Uplifts auf Wochenebene, robust gegen Cookie‑Löcher und Gerätewechsel. Multi‑Touch‑AttributionAttribution: Die Kunst der Kanalzuordnung im Online-Marketing Attribution bezeichnet im Online-Marketing den Prozess, bei dem der Erfolg – etwa ein Kauf, Lead oder eine Conversion – den einzelnen Marketingkanälen und Touchpoints auf der Customer Journey zugeordnet wird. Kurz: Attribution versucht zu beantworten, welcher Marketingkontakt welchen Beitrag zum Ergebnis geleistet hat. Klingt simpel. In Wirklichkeit ist Attribution jedoch ein komplexes, hoch... (MTA) existiert weiter, aber als ergänzendes, datennahes Perspektivinstrument, nicht als Wahrheit. Geo‑Experimente, Holdouts und Switchback‑Tests schaffen kausale Evidenz, wo Modelle allein spekulieren würden. Aus der Kombination entsteht Budget‑Orchestrierung, die Saison, Region, Creative‑Qualität und Lagerbestand adaptiv berücksichtigt. Ergebnis: Du investierst in Wirkung, nicht in SichtbarkeitSichtbarkeit: Die unbarmherzige Währung des digitalen Marketings Wenn es im Online-Marketing eine einzige Währung gibt, die wirklich zählt, dann ist es Sichtbarkeit. Sichtbarkeit – im Fachjargon gern als „Visibility“ bezeichnet – bedeutet schlicht: Wie präsent ist eine Website, ein Unternehmen oder eine Marke im digitalen Raum, insbesondere in Suchmaschinen wie Google? Wer nicht sichtbar ist, existiert nicht. Punkt. In diesem..., und kannst es beweisen.

Creatives werden zum Performance‑Hebel Nummer eins, sobald Bidding halbwegs effizient ist. Generative Systeme liefern 100 Varianten aus einer Kernidee, aber ein strenger Evaluations‑Loop sortiert Müll aus, bevor Geld verbrannt wird. Vision‑Modelle testen Komposition, Lesbarkeit und Brand‑Guidelines, während On‑Device‑Previews mobile Realität statt Desktop‑Illusion abbilden. Asset‑Management über DAM und PIM stellt sicher, dass Produktdaten, Preise und Verfügbarkeiten synchron bleiben, damit AI keinen Unsinn verspricht. Für Social und Video entstehen Schnittroutinen, die Hook‑Stärken, Pace und Text‑Overlay gegen Benchmarks prüfen. Wer seine Creative‑Ops industrialisiert, gewinnt kontinuierlich kleine Uplifts – und kleine Uplifts multiplizieren sich.

Implementierung: Architektur, Tools, Team‑Design und ein realistisches Playbook

Architektur zuerst, Tools danach – sonst wirst du zum Demo‑Sammler. Baue einen klaren Fluss: Events rein, Validierung, Speicherung, Feature‑Engineering, Modellierung, Auslieferung, Evaluierung, Monitoring. Für generative Anwendungsfälle ergänzt du Retrieval‑Pipelines mit Embeddings und Vektor‑Suche, Toolformer‑Integrationen für Aktionen und Safety‑Schichten für Moderation. Wähle LLM‑Strategien pragmatisch: API‑Modelle für Tempo, Open‑Source für Kontrolle, Fine‑Tuning nur bei echten Wiederholmustern. Kostenkontrolle kommt über Token‑Budgets, Caching, Prompt‑Kompaktierung und Response‑Limits, sonst frisst Inferenz dein Media‑Budget. Und bitte: Schreibe Systemprompts wie Infrastruktur – versioniert, getestet, mit Rollback.

Team‑Design entscheidet, ob AI Betrieb wird oder Pilot bleibt. Du brauchst drei Funktionen: Produktführung mit Business‑Verständnis, Data/ML‑Engineering für Pipelines, und Domain‑Experts in ContentContent: Das Herzstück jedes Online-Marketings Content ist der zentrale Begriff jeder digitalen Marketingstrategie – und das aus gutem Grund. Ob Text, Bild, Video, Audio oder interaktive Elemente: Unter Content versteht man sämtliche Inhalte, die online publiziert werden, um eine Zielgruppe zu informieren, zu unterhalten, zu überzeugen oder zu binden. Content ist weit mehr als bloßer Füllstoff zwischen Werbebannern; er ist..., SEOSEO (Search Engine Optimization): Das Schlachtfeld der digitalen Sichtbarkeit SEO, kurz für Search Engine Optimization oder Suchmaschinenoptimierung, ist der Schlüsselbegriff für alle, die online überhaupt gefunden werden wollen. Es bezeichnet sämtliche Maßnahmen, mit denen Websites und deren Inhalte so optimiert werden, dass sie in den unbezahlten, organischen Suchergebnissen von Google, Bing und Co. möglichst weit oben erscheinen. SEO ist längst..., Paid und CRMCRM (Customer Relationship Management): Die Königsdisziplin der Kundenbindung und Datenmacht CRM steht für Customer Relationship Management, also das Management der Kundenbeziehungen. Im digitalen Zeitalter bedeutet CRM weit mehr als bloß eine Adressdatenbank. Es ist ein strategischer Ansatz und ein ganzes Software-Ökosystem, das Vertrieb, Marketing und Service miteinander verzahnt, mit dem Ziel: maximale Wertschöpfung aus jedem Kundenkontakt. Wer CRM auf „Newsletter.... Rollen wie Prompt Engineer verschwinden im Betrieb, ersetzt durch Applied ML Engineers, die Modelle, Tools und Use Cases verbinden. Governance bedeutet Freigabeprozesse, Audit‑Trails, Modellkataloge, Datennutzungsrichtlinien und Incident‑Response. Security umfasst Secret‑Management, PII‑Minimierung, Red‑Team‑Tests für Jailbreaks und Output‑Wasserzeichen, wo sinnvoll. Kultur heißt: Experimente als Serien, nicht als Events, mit klaren Abbruchkriterien und Lernarchiv.

Setze auf ein Playbook, das ohne Helden auskommt und jeden Schritt überprüfbar macht. Baue mit GitOps deine Infra reproduzierbar, nutze Feature Stores für Konsistenz zwischen Training und Inferenz, und standardisiere Evaluierungssuiten pro Use Case. Für SEO‑Generierung definierst du Fakten‑Quellen und Zitierpflicht, für Paid‑Ops definierst du Budget‑Guardrails und Safe‑Modes, und für Support legst du Escalation‑Policies fest. Tool‑Beispiele sind pragmatisch: GA4 und BigQuery für AnalyticsAnalytics: Die Kunst, Daten in digitale Macht zu verwandeln Analytics – das klingt nach Zahlen, Diagrammen und vielleicht nach einer Prise Langeweile. Falsch gedacht! Analytics ist der Kern jeder erfolgreichen Online-Marketing-Strategie. Wer nicht misst, der irrt. Es geht um das systematische Sammeln, Auswerten und Interpretieren von Daten, um digitale Prozesse, Nutzerverhalten und Marketingmaßnahmen zu verstehen, zu optimieren und zu skalieren...., dbt für Transformation, Airflow oder Dagster für Orchestrierung, Pinecone oder Weaviate für Vektor‑Suche, LangChain oder LlamaIndex als Orchestrierer, Weights & Biases oder MLflow für MLOps, plus ein DAM/CMS mit API‑First‑Denken. Den Rest entscheidet dein Kontext, nicht ein Vergleichsblog. Und ja, du wirst zwei Mal umbauen – Plane es ein, dämpfe die Schmerzen.

- Use‑Cases priorisieren: Umsatzhebel, Datenverfügbarkeit, Risiko, Implementierungsaufwand.

- Datengrundlage sichern: Event‑Schema, Consent‑Flows, Server‑Side‑Tagging, Qualitätschecks.

- Architektur skizzieren: Ingest, Warehouse, Feature Store, Vektor‑DB, Orchestrierung, Observability.

- MVP bauen: ein Kanal, ein Prozess, messbarer Uplift, strenge Guardrails.

- Evaluieren: Offline‑Tests, Red‑Team, Halluzinations‑Scans, A/B‑ oder Geo‑Tests live.

- Produktisieren: SLAs, On‑Call, Dashboards, Alerting, Runbooks, Rollback‑Pfad.

- Skalieren: weitere Kanäle, Automationsgrad erhöhen, Kosten optimieren, Caching.

- Governance härten: Model‑Registry, Prompt‑Versionierung, Berechtigungen, Audit‑Logs.

- Schulen: Playbooks, Pairing‑Sessions, Hand‑offs, Dokumentation im Repo, nicht in PDFs.

- Zyklus wiederholen: Daten verbessern, Modelle aktualisieren, Metriken schärfen.

Messung ist der Schlussstein, ohne den alles bröckelt. Für Generierung trackst du Akzeptanzquote, Korrektheits‑Score, Zeitersparnis und Produktionslatenz; für Media zählen inkrementeller ROASROAS (Return on Advertising Spend): Der brutal ehrliche Maßstab für Werbeerfolg ROAS steht für „Return on Advertising Spend“ und ist der eine KPI, der bei Online-Marketing-Budgets keine Ausreden duldet. ROAS misst knallhart, wie viel Umsatz du für jeden investierten Werbe-Euro zurückbekommst – ohne Bullshit, ohne Schönrechnerei. Wer seinen ROAS nicht kennt, steuert sein Marketing blind und verbrennt im Zweifel sein..., CPA‑Uplift und Spend‑Stabilität; für SEOSEO (Search Engine Optimization): Das Schlachtfeld der digitalen Sichtbarkeit SEO, kurz für Search Engine Optimization oder Suchmaschinenoptimierung, ist der Schlüsselbegriff für alle, die online überhaupt gefunden werden wollen. Es bezeichnet sämtliche Maßnahmen, mit denen Websites und deren Inhalte so optimiert werden, dass sie in den unbezahlten, organischen Suchergebnissen von Google, Bing und Co. möglichst weit oben erscheinen. SEO ist längst... zählen Indexierungsquote, SERP‑CTRCTR (Click-Through-Rate): Die ehrliche Währung im Online-Marketing CTR steht für Click-Through-Rate, auf Deutsch: Klickrate. Sie ist eine der zentralen Metriken im Online-Marketing, SEA, SEO, E-Mail-Marketing und überall dort, wo Impressionen und Klicks gezählt werden. Die CTR misst, wie oft ein Element – zum Beispiel ein Suchergebnis, eine Anzeige oder ein Link – tatsächlich angeklickt wird, im Verhältnis dazu, wie häufig..., NDCG und organischer Uplift gegen Kontrollen. Für CRMCRM (Customer Relationship Management): Die Königsdisziplin der Kundenbindung und Datenmacht CRM steht für Customer Relationship Management, also das Management der Kundenbeziehungen. Im digitalen Zeitalter bedeutet CRM weit mehr als bloß eine Adressdatenbank. Es ist ein strategischer Ansatz und ein ganzes Software-Ökosystem, das Vertrieb, Marketing und Service miteinander verzahnt, mit dem Ziel: maximale Wertschöpfung aus jedem Kundenkontakt. Wer CRM auf „Newsletter... und Support misst du First‑Contact‑Resolution, CSAT, AHT und Eskalationsrate. Modelle bewertest du kontinuierlich mit Offline‑Benchmarks und Online‑Experimenten, damit Offline‑Glanz nicht Online‑Nebel bleibt. Und wenn eine Metrik nicht in Geld, Risiko oder Zeit rückführbar ist, streiche sie – Reportings sind kein Sammelalbum.

Die AI Bedeutung im Online‑MarketingMarketing: Das Spiel mit Bedürfnissen, Aufmerksamkeit und Profit Marketing ist weit mehr als bunte Bilder, Social-Media-Posts und nervige Werbespots. Marketing ist die strategische Kunst, Bedürfnisse zu erkennen, sie gezielt zu wecken – und aus Aufmerksamkeit Profit zu schlagen. Es ist der Motor, der Unternehmen antreibt, Marken formt und Kundenverhalten manipuliert, ob subtil oder mit der Brechstange. Dieser Artikel entlarvt das... ist kein Mythos, sondern ein Wettbewerbsvorteil mit Ablaufdatum für Zauderer. Wer Daten ernst nimmt, Modelle wie Produkte betreibt und Teams konsequent befähigt, skaliert Wirkung statt Aufwand. Zukunftstrends sind nur dann Trends, wenn du sie laufen lässt, und laufen lassen heißt: bauen, messen, lernen, wiederholen. Der Rest ist Dekoration, und Dekoration verkauft nichts.

Fassen wir zusammen: AI verschiebt die Macht von Meinungen zu Metriken, von Silos zu Pipelines, von Einzelfällen zu Systemen. Wenn du heute die AI Bedeutung umsetzt, baust du ein Marketing‑Betriebssystem, das ContentContent: Das Herzstück jedes Online-Marketings Content ist der zentrale Begriff jeder digitalen Marketingstrategie – und das aus gutem Grund. Ob Text, Bild, Video, Audio oder interaktive Elemente: Unter Content versteht man sämtliche Inhalte, die online publiziert werden, um eine Zielgruppe zu informieren, zu unterhalten, zu überzeugen oder zu binden. Content ist weit mehr als bloßer Füllstoff zwischen Werbebannern; er ist..., Media, CRMCRM (Customer Relationship Management): Die Königsdisziplin der Kundenbindung und Datenmacht CRM steht für Customer Relationship Management, also das Management der Kundenbeziehungen. Im digitalen Zeitalter bedeutet CRM weit mehr als bloß eine Adressdatenbank. Es ist ein strategischer Ansatz und ein ganzes Software-Ökosystem, das Vertrieb, Marketing und Service miteinander verzahnt, mit dem Ziel: maximale Wertschöpfung aus jedem Kundenkontakt. Wer CRM auf „Newsletter... und Support synchronisiert, Privacy respektiert und Wachstum belegt. Wenn nicht, wirst du bald erklären müssen, warum dein schöner ContentContent: Das Herzstück jedes Online-Marketings Content ist der zentrale Begriff jeder digitalen Marketingstrategie – und das aus gutem Grund. Ob Text, Bild, Video, Audio oder interaktive Elemente: Unter Content versteht man sämtliche Inhalte, die online publiziert werden, um eine Zielgruppe zu informieren, zu unterhalten, zu überzeugen oder zu binden. Content ist weit mehr als bloßer Füllstoff zwischen Werbebannern; er ist... gegen kalte Mathematik verloren hat. Willkommen bei 404 – wo Ausreden nicht ranken.