Airflow Guide: Profi-Tipps für effiziente Workflows

Du willst endlich aufhören, in deinem Data Engineering Alltag mehr Zeit mit Debugging als mit Analyse zu verbringen? Willkommen in der gnadenlosen Realität moderner Workflow-Automatisierung – und in der Welt von Apache Airflow. Hier gibt’s keine Zauberei, dafür jede Menge Stolperfallen, Best Practices, technische Abgründe und die schonungslose Wahrheit: Wer Airflow effizient nutzen will, braucht mehr als einen Quickstart-Guide und muss verstehen, wie der Hase wirklich läuft. Dieser Guide ist deine letzte Ausfahrt vor dem Chaos.

- Was Airflow wirklich ist – und warum Workflow Orchestration 2025 nicht mehr ohne geht

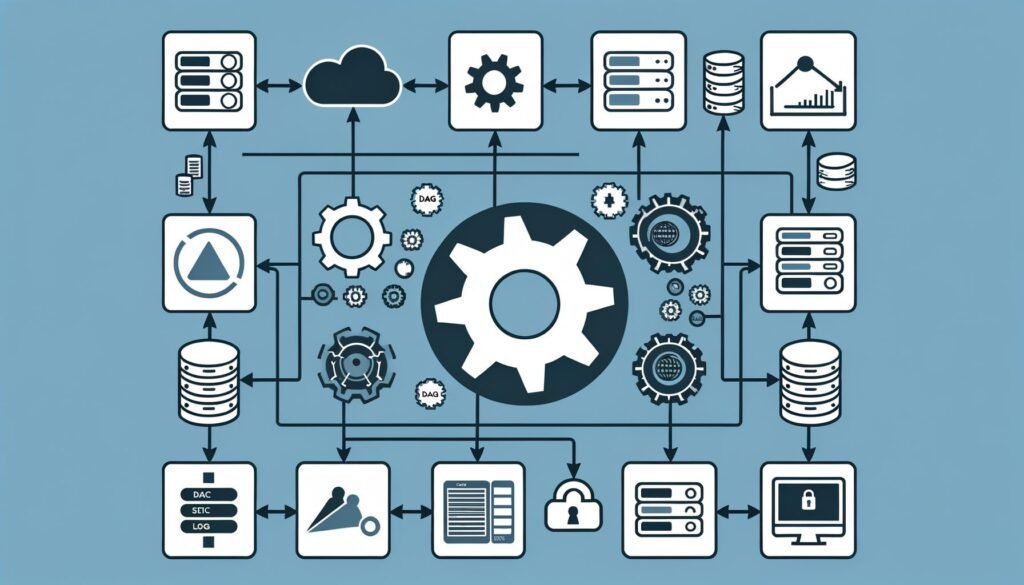

- Die wichtigsten Architekturkomponenten: DAGs, Scheduler, Executor, Worker und Metadatenbank

- Wie du mit Airflow effiziente Workflows aufbaust und klassische Fehler vermeidest

- Best Practices für skalierbare DAGs, Dependency Management und Monitoring

- Warum Airflow Performance kein Zufall ist, sondern harte Technik-Arbeit

- Security, Logging, Alerting: So bleibt dein Workflow sauber und auditierbar

- Typische Stolperfallen und wie du sie kompromisslos umschiffst

- Welche Airflow-Plugins, Operatoren und Integrationen wirklich Sinn machen

- Step-by-Step: So setzt du Airflow in Produktion, ohne im Debugging zu versinken

- Fazit: Warum ein effizienter Workflow mit Airflow über Erfolg oder Misserfolg deiner Datenstrategie entscheidet

Effiziente Workflows sind nicht die Kür, sondern die Pflicht im Zeitalter von Data Engineering, Automatisierung und Machine Learning. Während die meisten Unternehmen noch mit Cronjobs und Bash-Skripten jonglieren, ist Apache Airflow längst der Standard für orchestrierte, reproduzierbare und skalierbare Workflows. Doch so simpel die Oberfläche auch wirkt – unter der Haube ist Airflow ein Biest. Wer nicht versteht, wie DAGs, Scheduler, Executor und Metadatenbank zusammenspielen, produziert Chaos statt Automatisierung. Dieser Guide liefert dir die ungeschminkte Wahrheit: Was Airflow kann, wo es brutal abkackt, und wie du das Maximum rausholst. Schluss mit Halbwissen, jetzt wird’s technisch – und ehrlich.

Was ist Apache Airflow? Workflow Orchestration für Profis erklärt

Apache Airflow ist der De-facto-Standard im Bereich Workflow Orchestration. Das System wurde entwickelt, um komplexe, wiederkehrende Aufgaben (Workflows) als sogenannte Directed Acyclic Graphs (DAGs) zu definieren und zu steuern. Anders als bei stumpfen Task-Schedulern wie Cron erlaubt Airflow, Abhängigkeiten zwischen Tasks explizit zu modellieren, Wiederholungen zu managen, Fehler sauber zu behandeln und das Monitoring auf ein neues Level zu heben.

Der Kern von Airflow ist der DAG – ein gerichteter, azyklischer Graph, in dem jeder Knoten (Task) eine klar definierte Funktion abbildet. Abhängigkeiten werden explizit im Python-Code festgelegt, was ein Höchstmaß an Flexibilität ermöglicht. Und genau hier trennt sich die Spreu vom Weizen: Wer seine DAGs schlampig strukturiert, produziert ein Debugging-Desaster. Wer sie richtig aufsetzt, gewinnt an Skalierbarkeit, Nachvollziehbarkeit und Effizienz.

Airflow ist kein ETL-Tool, sondern ein Orchestrator. Das bedeutet: Airflow führt keine Datenverarbeitung selbst durch, sondern steuert, wann, wie und in welcher Reihenfolge verschiedene Tasks und externe Systeme ausgeführt werden. Die eigentliche Logik steckt meist in Operatoren, die Bash, Python, SQL, Cloud-Funktionen oder externe Jobs triggern. Airflow ist dabei die Schaltzentrale, nicht der Motor.

Im Unternehmenskontext ist Airflow längst Pflichtprogramm. Wer Machine Learning Pipelines, tägliche Datenextraktionen, API-Integrationen oder Reporting automatisieren will, kommt an Airflow nicht vorbei. Der Grund ist brutal simpel: Komplexität lässt sich nicht mehr mit Shell-Skripten bändigen. Airflow ist der Hebel, um den Wildwuchs in produktive, kontrollierte Bahnen zu lenken.

Die Architektur von Airflow: DAGs, Scheduler, Executor & Metadatenbank im Detail

Wer Airflow effizient betreiben will, muss seine Architektur verstehen – alles andere ist Glücksspiel. Die wichtigsten Komponenten: Der Scheduler, der DAG Parser, der Executor, die Worker, die Metadatenbank und die Weboberfläche. Jeder Baustein hat seine eigenen Tücken, Skalierungsgrenzen und Abhängigkeiten.

Der Scheduler ist das Herzstück. Er liest DAG-Files, erkennt neue Runs, plant Tasks und weist sie dem Executor zu. Entscheidend ist, dass der Scheduler kein Worker ist – er startet keine Tasks, sondern delegiert sie nur. Wer den Scheduler überlastet, sorgt für Delays und verpasste Deadlines. Der DAG Parser wiederum liest die Python-DAGs regelmäßig ein. Syntaxfehler, zu große DAG-Files oder zu viele dynamisch erzeugte Tasks sind hier die klassischen Performance-Killer.

Der Executor entscheidet, wie und wo Tasks ausgeführt werden. Im SequentialExecutor laufen Tasks nacheinander (brauchbar nur für Tests). Der LocalExecutor parallelisiert auf einer Maschine. Der CeleryExecutor und KubernetesExecutor verteilen Tasks auf Worker im Cluster – Skalierung ist hier kein Luxus, sondern Notwendigkeit. Wer glaubt, mit dem LocalExecutor produktiv arbeiten zu können, hat Airflow nicht verstanden.

Die Worker – egal ob lokal, Celery, Kubernetes oder anderweitig orchestriert – sind die eigentlichen Task-Ausführer. Jedes Worker-Nodes zieht sich Tasks aus der Queue und führt sie isoliert aus. Instabile Worker, schlecht konfigurierte Queues, fehlende Ressourcen? Willkommen in der Welt der “Zombie Tasks” und endlosen Retries.

Die Metadatenbank (meistens PostgreSQL oder MySQL) speichert alles: Runs, Task-Status, Logs, Variablen, Verbindungen. Hier entscheidet sich, wie performant und stabil dein gesamtes Airflow-Setup ist. Langsame Datenbanken, fehlende Indizes oder zu kleine Instanzen machen jedes Cluster zur Kriechspur.

Die Weboberfläche (Webserver) ist das Dashboard für Monitoring, Trigger, Logs und Debugging. Aber Vorsicht: Sie ist kein Ersatz für echtes Alerting oder automatisiertes Monitoring. Wer sich auf die UI verlässt, merkt Fehler oft zu spät.

DAGs in Airflow: Effizient, modular, skalierbar

Der DAG (Directed Acyclic Graph) ist das Rückgrat jedes Airflow-Projekts – und die häufigste Fehlerquelle. Ein effizienter DAG ist klar strukturiert, modular aufgebaut, und vermeidet zyklische Abhängigkeiten um jeden Preis. Die Realität? 90% aller DAGs in Unternehmen sind ein Spaghetti-Haufen aus schlecht dokumentierten Tasks, redundanten Operatoren und endlosen Try-Except-Blöcken. Hier trennt sich Amateur von Profi.

Im ersten Drittel deines Airflow-Setups sollte der Begriff “DAG” mindestens fünfmal auftauchen – so wichtig ist das Konzept. Ein DAG definiert, welche Tasks wann, wie oft und in welcher Reihenfolge ausgeführt werden. Die Struktur ist entscheidend für Effizienz, Monitoring und Fehlerbehandlung. Wer Tasks hart codiert und Abhängigkeiten nicht explizit macht, riskiert Deadlocks und undurchschaubare Workflows.

Best Practices für effiziente DAGs:

- Modularisierung: Baue wiederverwendbare Python-Modules für Operatoren und Task-Logic.

- Verwende SubDAGs und TaskGroups für größere Pipelines, um die Übersicht zu behalten.

- Nutze Jinja-Templating und dynamische Parameter, aber halte die Task-Anzahl pro DAG im Zaum.

- Vermeide zyklische Abhängigkeiten – der DAG muss acyclic bleiben!

- Dokumentiere jede Task klar – was macht sie, welche Inputs und Outputs gibt es?

Skalierbarkeit erreichst du nur, wenn du kleine, unabhängige Tasks baust, die parallelisiert werden können. Wer versucht, ETL-Jobs in einen Monster-Task zu pressen, hat Airflow nicht verstanden. Monitoring und Debugging profitieren enorm von granularen, gut dokumentierten Tasks – sonst suchst du im Fehlerfall die Nadel im Heuhaufen.

Ein sauberer DAG-Entwurf ist auch die Basis für effektives Dependency Management. Explizite Task-Dependencies sind Pflicht. Wer Tasks “on the fly” triggert oder via TriggerDagRunOperator wild DAGs verschachtelt, produziert Wartungsalbträume und Debugging-Hölle. Hier gilt: Weniger Magie, mehr Klarheit.

Airflow Performance: Keine Magie, nur harte Technik

Die Performance von Airflow ist kein Zufallsprodukt, sondern das Ergebnis harter technischer Arbeit. Wer glaubt, ein “pip install apache-airflow” reicht für skalierbare, stabile Workflows, lebt im Märchen. Schon bei mittleren DAG-Anzahlen und hohen Frequenzen stößt Airflow schnell an Grenzen – und die meisten Probleme sind hausgemacht.

Die größten Performance-Killer im Airflow-Umfeld:

- Überladene Metadatenbank: Zu viele DAGs, zu viele Task-Instanzen, fehlende Indizes.

- Suboptimale Executor-Konfiguration: LocalExecutor im Produktivbetrieb? Viel Spaß mit Bottlenecks.

- Unsaubere DAG-Parsing-Strategien: Dynamisch generierte DAGs mit tausenden Tasks killen die Scheduler-Performance.

- Fehlende Ressourcen: Worker mit zu wenig RAM/CPU, zu kleine Datenbankinstanzen, oder ein Scheduler, der auf Billig-Hardware läuft.

- Schlechte Log-Konfiguration: Endlose Logfiles auf NFS-Shares oder langsamen Storage-Systemen blockieren alles.

Die Lösung? Systematisch vorgehen:

- Nutze den CeleryExecutor oder KubernetesExecutor ab mittlerer Größe – alles andere ist Murks.

- Halte die Metadatenbank schlank: Nutze Airflow Cleanup-Jobs, lösche alte Runs, archiviere Logs regelmäßig.

- Beobachte die Scheduler-Latenz: Je höher die “DagProcessing.time”, desto wahrscheinlicher ist ein Parsing-Problem.

- Automatisiere das Scaling der Worker (Horizontal Pod Autoscaler bei Kubernetes oder Celery Autoscaling).

- Separate Ressourcen: Scheduler, Webserver und Worker sollten auf eigenen Maschinen laufen.

Monitoring ist Pflicht: Nutze Prometheus, Grafana, oder das Airflow-eigene Metrics-Subsystem. Metriken wie Scheduler Delay, Task Run Duration, Database Connections und Task Failures sind dein Frühwarnsystem. Wer hier spart, bezahlt später mit Ausfällen und Datenchaos.

Security, Logging und Monitoring: Airflow sauber und auditierbar betreiben

Airflow ist ein kritisches System – und damit ein potenzielles Einfallstor für Angreifer, Datenverluste und DSGVO-Desaster. Wer Security und Logging ignoriert, spielt Russisch Roulette mit seinem Datenbestand. Das fängt bei simplen Dingen wie Zugangskontrolle an und hört bei verschlüsselten Verbindungen noch lange nicht auf.

Best Practices für Airflow Security und Auditing:

- Aktiviere rollenbasierte Zugriffskontrolle (RBAC) in der Weboberfläche.

- Nutze sichere Verbindungen zur Metadatenbank (SSL/TLS) und zu externen Systemen.

- Speichere Verbindungsdaten und Variablen niemals im Klartext – nutze Secrets Backends (z.B. HashiCorp Vault, AWS Secrets Manager).

- Aktiviere Audit Logging für alle kritischen Aktionen (z.B. Trigger, Pausen, Änderungen an DAGs).

- Automatisiere Backups der Metadatenbank – ein Datenbankverlust bedeutet Totalverlust aller Runs und Logs.

Logging ist bei Airflow kein Selbstläufer. Logs gehören auf ein zentrales, schnelles Storage (S3, GCS oder dediziertes NAS) – nicht auf lokale Disks. Für Monitoring empfiehlt sich ein Stack aus Prometheus, Grafana und Alertmanager, der alle kritischen Metriken überwacht. Alerts für fehlgeschlagene DAGs, hohe Scheduler-Latenz oder Datenbank-Timeouts sind Pflicht. Wer erst beim Blick in die Weboberfläche merkt, dass etwas schiefläuft, ist eigentlich schon zu spät dran.

Compliance und Auditierbarkeit werden immer wichtiger. Jedes Task-Run-Event, jede Änderung am DAG-Code und jede User-Aktion sollte nachvollziehbar und auswertbar sein. Airflow bietet dazu Hooks ins Audit-Log und kann mit externen Systemen wie ELK-Stack oder Splunk integriert werden. Wer das ignoriert, riskiert nicht nur Bußgelder, sondern auch das Vertrauen der eigenen Nutzer und Partner.

Typische Airflow-Stolperfallen und wie du sie radikal vermeidest

Airflow ist mächtig – aber gnadenlos, wenn man die Basics missachtet. Die häufigsten Fehler sind keine Bagatellen, sondern echte Showstopper. Hier ein paar Klassiker – und wie du sie kompromisslos vermeidest:

- DAGs mit zu vielen Tasks: Airflow ist kein Ersatz für Subprozesse. Halte die Task-Anzahl pro DAG überschaubar, nutze TaskGroups und SubDAGs.

- Fehlende Idempotenz: Jeder Task muss bei Wiederholung dasselbe Ergebnis liefern. Sonst endest du im Datenchaos.

- Unsaubere Fehlerbehandlung: Nutze Retries, Alerts und “on_failure_callback” sinnvoll. Tasks, die einfach stillschweigend crashen, sind ein No-Go.

- Hart codierte Parameter: Nutze Airflow Variables, Connections und Secrets. Alles andere ist unwartbar und unsicher.

- Keine Tests: Schreibe Unit-Tests für Operatoren und DAG-Integrity-Checks. Airflow bietet Testmodi – nutze sie!

Wer diese Fehler vermeidet, ist schon weiter als 80% der Airflow-Nutzer. Step-by-Step geht das so:

- Starte mit einem klaren DAG-Design und dokumentiere alles.

- Teste jeden neuen Operator isoliert – nicht erst im Produktivbetrieb.

- Automatisiere das Deployment (CI/CD), damit keine manuelle Flickschusterei entsteht.

- Richte Monitoring und Alerting von Anfang an ein.

- Baue Security, Logging und Compliance direkt ins Setup ein.

Step-by-Step: Airflow in Produktion bringen und effizient betreiben

Den Sprung von der lokalen Testumgebung in die Produktion versauen 90% der Teams. Warum? Weil Airflow ohne saubere Planung, Monitoring und Skalierungsstrategie schnell zur Blackbox wird. Hier der ungeschönte Ablauf, wie du Airflow produktiv, skalierbar und effizient betreibst – ohne im Debugging-Sumpf zu versinken:

- Architektur festlegen: Wähle den passenden Executor (Celery/Kubernetes), plane getrennte Ressourcen für Scheduler, Worker und Webserver, setze auf eine robuste Metadatenbank.

- Deployment automatisieren: Nutze Helm-Charts (K8s) oder Docker-Compose für reproduzierbare Deployments. Keine manuellen Installationen!

- Konfigurationsmanagement: Alle Einstellungen gehören in Version Control – keine “Snowflake”-Server.

- DAGs modularisieren: Baue Libraries für Operatoren, Hook-Integrationen und Utility-Funktionen.

- Security und Compliance: RBAC, Secrets-Backend, Audit-Logging und verschlüsselte Verbindungen implementieren.

- Monitoring einrichten: Prometheus, Grafana, Alertmanager – Alerts auf Scheduler, Worker, Datenbank und kritische DAGs.

- Logging centralisieren: Logs auf S3, GCS oder dediziertem Storage ablegen, Rotation und Retention Policies definieren.

- Testing und Staging: Jede Änderung erst in Test/Staging-DAGs durchlaufen lassen. Fehler erst im Produktivsystem zu entdecken ist Dilettantismus.

- Automatisiertes Cleanup: Regelmäßige Jobs zur Bereinigung alter Task-Instanzen, Runs und Logs einrichten.

- Regelmäßige Reviews und Audits: DAGs, Operatoren und Sicherheitssettings regelmäßig auf Schwachstellen und technische Schulden prüfen.

Fazit: Effiziente Workflows mit Airflow – oder digitaler Blindflug

Apache Airflow ist das Rückgrat moderner Workflow-Orchestration – aber nur für Teams, die Technik ernst nehmen. Wer Airflow als simples Scheduling-Tool betrachtet, verschenkt Potenzial und produziert Chaos. Effiziente Workflows mit Airflow sind das Ergebnis von durchdachtem DAG-Design, sauberer Architektur, kompromisslosem Monitoring und technischer Disziplin. Wer das ignoriert, läuft sehenden Auges ins Debugging-Desaster.

Die Wahrheit ist einfach: Ohne Airflow bleibt Workflow-Automatisierung 2025 Flickwerk. Aber Airflow ohne Verständnis, Best Practices und Monitoring ist noch schlimmer. Investiere in saubere Strukturen, teste und überwache alles – dann wird Airflow vom Problemkind zum Power-Tool. Alles andere ist digitaler Blindflug. Willkommen bei 404 – wo Workflow-Mythen sterben und echte Technik zählt.