Behördensoftware 1995 exposed: Geheimnisse der Ära enthüllt

Du glaubst, deutsche Behörden-IT war schon immer ein Synonym für lähmende Prozesse und kryptische Oberflächen? Dann schnall dich an: Wir zerlegen die Software-Dinosaurier der 90er, lüften die Geheimnisse hinter den legendär schlechten User Interfaces, und zeigen, warum selbst die Bundesdruckerei beim Anblick von Windows 3.11 schwitzige Hände bekam. Willkommen zu einer Reise, bei der der Begriff Digitalisierung noch nach Raubkopien auf Disketten klang – und bei der der Albtraum von 1995 bis heute nachwirkt.

- Warum Behördensoftware 1995 das digitale Fundament von heute (leider) noch prägt

- Die technischen Rahmenbedingungen: Netzwerk, Hardware, Betriebssysteme und Datenbanken der 90er

- Legendäre Software-Architekturen: Monolithen, Mainframes und fatale Schnittstellen

- Usability-Horror: Warum Nutzerfreundlichkeit für Behörden ein Fremdwort war

- Sicherheitskonzepte, die keine waren – und wie Daten trotzdem überlebten

- Wie proprietäre Standards Behörden über Jahrzehnte in Geiselhaft nahmen

- Der Mythos “Legacy”: Warum heute noch COBOL und Access im öffentlichen Dienst leben

- Was wir aus dem digitalen Mittelalter lernen – und warum der Sprung in die Cloud sich wie ein Quantensprung anfühlt

Die Mär von der deutschen Behörden-Digitalisierung ist so alt wie der Spruch “Das haben wir schon immer so gemacht”. Was in den Amtsstuben der 90er als Fortschritt verkauft wurde, entpuppte sich spätestens im 21. Jahrhundert als digitales Minenfeld. Wer heute noch glaubt, dass ein paar Access-Datenbanken und handgestrickte Visual-Basic-Masken Innovation bedeuten, hat den Kern des Problems nie verstanden. Behördensoftware 1995 ist nicht nur ein technisches Relikt – sie ist das perfekte Lehrstück für alles, was schiefgehen kann, wenn Technologie, Politik und Bürokratie in einem Raum sitzen. Und ja, wir reden hier von echtem Legacy-Code, von Datenmodellen, die noch nach Lochkarten riechen, und von Netzwerken, die schon bei der Erwähnung von TCP/IP in Schockstarre verfallen.

Klar, die 90er waren ein anderes Jahrzehnt. Aber dass noch heute Millionen von Zeilen Code aus dieser Epoche deutsche Verwaltungsprozesse bestimmen, ist keine Anekdote, sondern bittere Realität. In diesem Artikel packen wir die Lupe aus, bohren durch die staubigen Schichten der Verwaltungsgeschichte und zeigen, warum die Digitalisierung in Deutschland bis heute von den Schatten der Behördensoftware 1995 verfolgt wird. Bereit für ein Déjà-vu der digitalen Steinzeit? Dann los.

Technische Rahmenbedingungen: Was war 1995 wirklich möglich?

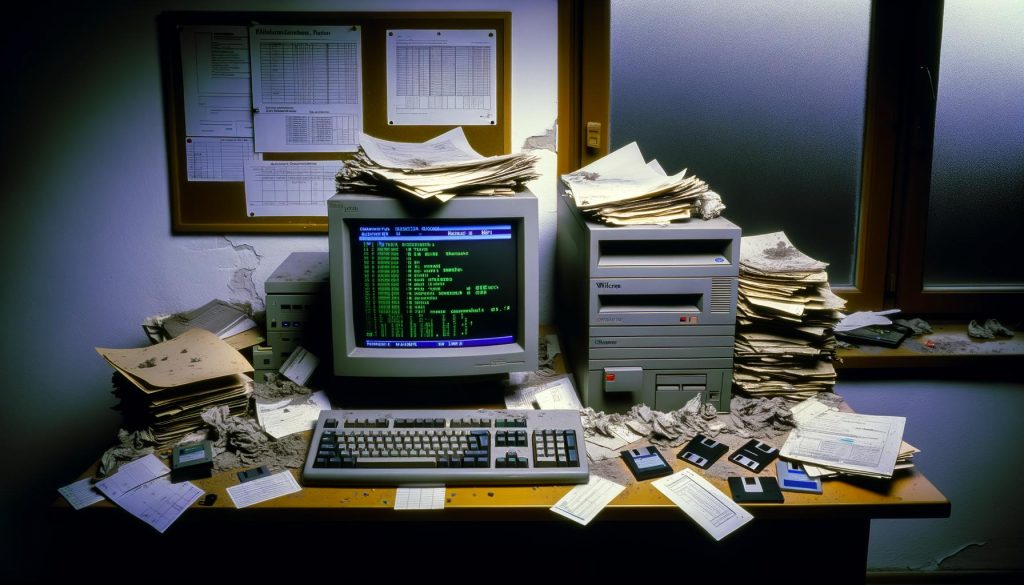

Wer heute über “digitale Transformation” schwadroniert, vergisst gerne, dass die meisten Behörden 1995 froh waren, wenn der Nadeldrucker nicht wieder mitten im Formular ausgestiegen ist. Die Hardware war eine Mischung aus Altmetall und Hoffnung: 386er, 486er oder – mit sehr viel Glück – ein Pentium mit 8 MB RAM, 500 MB Festplatte und einem Röhrenmonitor, der bei jedem Refresh das halbe Büro erleuchtete. Betriebssysteme? DOS, Windows 3.1, OS/2 – alles, was irgendwie bunte Fenster und Abstürze versprach.

Netzwerk? In kleineren Behörden war das “Netzwerk” ein Aktenwagen. Wo es IT gab, liefen Novell NetWare, Banyan VINES oder, bei den ganz Mutigen, Windows for Workgroups. TCP/IP? Ein Fremdwort – IPX/SPX und NetBEUI waren der heiße Scheiß. Internet? Wenn überhaupt, dann als Modem-Dialup in der Zentrale. Email? Ja, aber nur für die Chefs, und meistens in Form von Lotus Notes oder GroupWise.

Datenbanken waren ein weiteres Abenteuer. Wer es sich leisten konnte, setzte auf Oracle oder IBM DB2. Die breite Masse vertraute auf Microsoft Access oder Paradox. SQL war selten, stattdessen dominierten Flatfiles, ISAM und – kein Witz – dBase III+. Backup? Irgendwo lag eine Magnetbandkassette, aber niemand wusste, wie sie einzulegen war.

Softwareentwicklung war Handwerk, kein Engineering. Source Control? Manuell per Diskette. Dokumentation? Auf Papier, im besten Fall handschriftlich. Release Management? “Freitag nach 15 Uhr deployen, dann ist eh keiner mehr da.” Willkommen in der Welt, in der Fehler nicht gefixt, sondern umgangen wurden.

Legendäre Software-Architekturen: Monolithen, Mainframes und Monster-Schnittstellen

Behördensoftware 1995 war gebaut für die Ewigkeit – zumindest dachten das die Entwickler. Das Ergebnis: Monolithische Applikationen, meist in COBOL, Clipper, Visual Basic oder – der ganz harte Stoff – in Natural oder PL/1. Modularität? Fehlanzeige. Das Datenmodell war so fest im Code verankert, dass jede Erweiterung zur Operation am offenen Herzen wurde.

Die wenigsten Behörden konnten oder wollten sich echte Mainframes leisten. Wer einen hatte, war König – aber die meisten mussten mit Mini-Computern oder PC-Netzen vorliebnehmen. Die Software-Architektur war geprägt von Client-Server-Modellen, bei denen “Server” oft bedeutete: Ein Rechner im Keller, der nie neu gestartet werden durfte. Middleware gab es selten, Schnittstellen waren proprietär, meist auf Dateiebene – CSV, EBCDIC oder, für die ganz Mutigen, OLE-Automation.

Und dann: Die Schnittstellenhölle. Jede Behörde hatte ihr eigenes Datenmodell, eigene Geschäftslogik, eigene Phantasie-Formate. Datenaustausch? XML war in weiter Ferne. Stattdessen wurden Exporte auf Diskette oder Magnetband verschickt, importiert, manuell geprüft, und die Datensätze, die nicht passten, wurden einfach gelöscht. Konsistenz? Hauptsache, das Geburtsdatum lag nicht vor dem 1.1.1900.

Was heute “Legacy” heißt, war damals cutting edge. Aber schon damals wusste jeder: Wer einmal im Code-Dschungel der Behörden gelandet ist, kommt so schnell nicht wieder raus. Und so laufen bis heute Prozesse auf Software, deren Entwickler seit Jahrzehnten im Ruhestand sind – und deren Dokumentation in irgendeiner Schublade verschimmelt.

Usability-Horror: Warum Nutzerfreundlichkeit für Behörden ein Fremdwort war

Wer heute über User Experience (UX) spricht, meint meist Responsive Design, Accessibility und Onboarding-Flows. 1995 stand UX für: “Wie viele Tasten muss ich drücken, bis das Fax rausgeht?” Die Oberflächen von Behördensoftware waren eine Mischung aus Tabellenkalkulation, Textadventure und Minesweeper. Farben? Grau, Hellgrau, Dunkelgrau. Icons? Wenn überhaupt, dann als 16×16-Pixel-Kunstwerke, die aussahen wie MS Paint-Unfälle.

Die Navigation war ein Albtraum: Menüleisten mit 40 Einträgen, Funktionsaufrufe per Tastenkombinationen, die nur Power User kannten. Tooltips? Fehlanzeige. Hilfetexte? Auf Papier, im DIN-A5-Format und meistens nicht aktuell. Fehlerbehandlung? Meistens poppte ein Fenster auf mit dem Hinweis: “Unbekannter Fehler. Bitte wenden Sie sich an Ihren Systembetreuer.” Systembetreuer? Der war leider gerade im Urlaub.

Der berühmte “Workflow” bestand oft aus drei geöffneten Programmen, Copy & Paste zwischen DOS-Fenstern und dem berüchtigten Alt+F4 als Universalheilmittel. Wer einmal ein Amt besucht hat, weiß: Die Geschwindigkeit am Schalter hat selten mit der Leistungsfähigkeit der Software zu tun. Vielmehr war sie ein Tribut an Workarounds, Excel-Tabellen und Papierausdrucke, die den eigentlichen Prozess am Laufen hielten – die Software selbst war selten die Lösung, meist das Problem.

Sicherheitskonzepte: Zwischen Netzwerkkabel und Passwort auf dem Monitor

IT-Security in Behörden 1995? Ein frommer Wunsch. Die größten Risiken waren offene Türen, Disketten mit Makroviren und Passwörter, die als Post-it am Monitor klebten. Firewalls? In der Theorie. In der Praxis war das größte Sicherheitsfeature, dass niemand wusste, wie man von außen auf das Netz zugreift. Virenscanner liefen, wenn überhaupt, als Norton Antivirus auf DOS-Basis – und aktualisiert wurden sie, wenn der Außendienst mit neuen Disketten vorbeikam.

Rechteverwaltung? Eher symbolisch. Wer Zugriff auf den PC hatte, hatte Zugriff auf alles. Netzlaufwerke waren für jeden erreichbar, sensible Daten lagen in frei zugänglichen Ordnern. Verschlüsselung? Höchstens bei der Übermittlung von Gehaltsdaten an die Zentrale – und selbst da nur, weil es im Pflichtenheft stand. Protokollierung? Fehlanzeige. Die einzige Log-Datei war das Zugriffsprotokoll am Aktenschrank.

Der Datenschutz wurde zwar schon damals großgeschrieben, aber eher als juristische Pflicht denn als technisches Konzept. DSGVO? Ein Science-Fiction-Plot. Und so überlebten zahlreiche Datenpannen im Alltag, weil einfach niemand nachschaute, wer Zugriff auf was hatte. Wenn überhaupt, wurde “Sicherheit” durch die Komplexität der Software garantiert: Wer sich nicht auskannte, kam eh nicht rein.

Proprietäre Standards und der Fluch der Abhängigkeit

Die große Stärke der Behördensoftware 1995 war ihr größtes Problem: Alles war proprietär. Jede Lösung ein Unikat, jede Datenbank ein Einzelstück. Das bedeutete: Wer sich einmal für ein System entschieden hatte, war gefangen. Migration? Ein Alptraum. Schnittstellen zu anderen Behörden? Nur mit teuren Spezialentwicklungen und häufig mit Datenverlust. Open Source? In deutschen Behörden damals so exotisch wie vegane Currywurst.

Die Standardisierung scheiterte oft an föderalen Grabenkämpfen, Budgetkürzungen und der Angst, dass ein bundesweites System zu viel Transparenz bringen könnte. So setzte man lieber auf Insellösungen, die zwar kurzfristig funktionierten, langfristig aber zu einem Flickenteppich führten, der bis heute jede Modernisierung ausbremst. Die Folge: Noch 2024 findet man Behörden, in denen Altsysteme auf DOS-Basis laufen, weil niemand weiß, wie man die Daten in ein modernes System migriert.

Technisch bedeutete das: Datenformate wie EBCDIC, OLE oder CSV in proprietären Codierungen. Dokumente im WordPerfect- oder Lotus-Format. Authentifizierung über selbstgestrickte Mechanismen, die jeden Penetrationstest heute in Sekunden explodieren lassen würden. Und jede neue Anwendung brachte neue Abhängigkeiten, neue Datenmodelle und neue Probleme. Willkommen im digitalen Bermuda-Dreieck.

Legacy lebt: Warum Behörden immer noch von 1995 träumen

Wer glaubt, dass all das längst Geschichte ist, sollte mal bei der nächsten Führerscheinstelle nachfragen, warum der Antrag so lange dauert. Die Antwort: Weil irgendwo im Backend noch Access 2.0, COBOL-Module oder eine Paradox-DB laufen, für die es seit 15 Jahren keine Entwickler mehr gibt. “Legacy” ist kein Buzzword, sondern Alltag. Die Modernisierung ist ein Spagat zwischen dem Erhalt alter Daten, der Integration neuer Schnittstellen und dem Versuch, nicht bei jeder Änderung das Kartenhaus zum Einsturz zu bringen.

Viele Behörden haben längst erkannt, dass die Digitalisierung ohne den Abschied von den 90er-Systemen nicht funktioniert. Doch der Migrationsaufwand ist gigantisch, die Risiken enorm, und die Angst vor Datenverlust lähmt jede Initiative. Die Folge: Parallelsysteme, die alten Monolithen als Schatten-IT und eine Abhängigkeit von Dienstleistern, die oft die einzigen sind, die den Legacy-Code noch lesen können.

Selbst Cloud-Strategien und moderne Web-Technologien kommen nur schleppend voran, weil die Altlasten von 1995 wie Bleigewichte am Fortschritt hängen. Wer “digitale Souveränität” fordert, muss erst einmal das digitale Mittelalter hinter sich lassen – und das ist leichter gesagt als getan.

Lessons learned – und warum der Sprung in die Cloud so schmerzhaft ist

Was bleibt von der Ära Behördensoftware 1995? Ein technologischer Scherbenhaufen, aber auch eine wertvolle Lektion: Proprietäre Monolithen, fehlende Standards und mangelhafte Usability führen zwangsläufig zur digitalen Stagnation. Der Sprung in die Cloud, der heute als Heilsbringer gehandelt wird, ist für viele Behörden weniger ein Upgrade als ein Quantensprung – nicht, weil die Technik so neu ist, sondern weil die Altlasten so gewaltig sind.

Wer heute Behörden digitalisieren will, muss nicht nur neue Systeme einführen, sondern auch die Geister der Vergangenheit austreiben. Datenmigration, Schnittstellenmodernisierung, Sicherheitskonzepte nach Stand der Technik – all das ist nur möglich, wenn der Wille da ist, alte Zöpfe radikal abzuschneiden. Und das tut weh, kostet Geld, Zeit und Nerven. Aber die Alternative ist ein ewiger Kreislauf aus Flickwerk, Workarounds und Digitalisierung auf Papierniveau. Wer mutig ist, zieht den Stecker und startet neu – alle anderen verwalten weiter den digitalen Stillstand.

Fazit: Behördensoftware 1995 ist mehr als ein technisches Fossil. Sie ist das Mahnmal für alles, was in der deutschen Digitalgeschichte schiefgelaufen ist – und ein warnendes Beispiel dafür, wie schwerfällig, teuer und riskant echte Transformation sein kann. Wer heute noch glaubt, dass Modernisierung mit ein paar neuen Oberflächen getan ist, hat den Kern des Problems nie verstanden. Erst wenn die letzten Monolithen gefallen sind, kann auch die Verwaltung im 21. Jahrhundert ankommen.

Die Lektion aus 1995? Technologie entscheidet nicht nur über Effizienz, sondern über die Handlungsfähigkeit eines ganzen Staates. Und wer immer noch glaubt, dass ein bisschen Digitalisierung reicht, um den Rückstand aufzuholen, sollte sich dringend mal ein Behörden-Frontend von 1995 anschauen. Willkommen im echten digitalen Wandel – der beginnt da, wo der alte Code endlich stirbt.