BigQuery Analyse: Datenpower für smarte Insights entfesseln

Du glaubst, Datenanalyse sei nur was für Konzern-Nerds mit zu viel Zeit und zu wenig Kreativität? Dann halt dich fest: BigQuery Analyse ist der Raketenantrieb für jedes datengetriebene Online-Marketing – vorausgesetzt, du weißt, wie du die Datenlawine bändigst. Hier erfährst du, warum du ohne BigQuery in Zukunft ein digitales Fossil bist, wie du endlich echten Impact aus deinen Metriken holst und warum “Excel reicht schon” heute ungefähr so innovativ ist wie Faxgeräte. Willkommen im Maschinenraum des modernen Marketings – hier wird nicht gekleckert, hier wird BigQuery-Analyse gemacht!

- Was BigQuery Analyse wirklich ist – jenseits von Buzzwords und Google-Hype

- Warum klassische BI-Tools gegen BigQuery gnadenlos abstinken

- Wie du BigQuery Analyse für Online-Marketing, SEOSEO (Search Engine Optimization): Das Schlachtfeld der digitalen Sichtbarkeit SEO, kurz für Search Engine Optimization oder Suchmaschinenoptimierung, ist der Schlüsselbegriff für alle, die online überhaupt gefunden werden wollen. Es bezeichnet sämtliche Maßnahmen, mit denen Websites und deren Inhalte so optimiert werden, dass sie in den unbezahlten, organischen Suchergebnissen von Google, Bing und Co. möglichst weit oben erscheinen. SEO ist längst... und Conversion-Optimierung nutzt

- Die wichtigsten Features: SQL, Datasets, Partitionierung, Skalierung und Preisstruktur

- Schritt-für-Schritt-Anleitung von der Datenintegration bis zum Insight – ohne Bullshit

- Fehlerquellen, Limitierungen und Best Practices für skalierbare BigQuery-Workflows

- Welche Schnittstellen und Tools BigQuery erst richtig mächtig machen

- Wie du Machine LearningMachine Learning: Algorithmische Revolution oder Buzzword-Bingo? Machine Learning (auf Deutsch: Maschinelles Lernen) ist der Teilbereich der künstlichen Intelligenz (KI), bei dem Algorithmen und Modelle entwickelt werden, die aus Daten selbstständig lernen und sich verbessern können – ohne dass sie explizit programmiert werden. Klingt nach Science-Fiction, ist aber längst Alltag: Von Spamfiltern über Gesichtserkennung bis zu Produktempfehlungen basiert mehr digitale Realität... und Predictive AnalyticsAnalytics: Die Kunst, Daten in digitale Macht zu verwandeln Analytics – das klingt nach Zahlen, Diagrammen und vielleicht nach einer Prise Langeweile. Falsch gedacht! Analytics ist der Kern jeder erfolgreichen Online-Marketing-Strategie. Wer nicht misst, der irrt. Es geht um das systematische Sammeln, Auswerten und Interpretieren von Daten, um digitale Prozesse, Nutzerverhalten und Marketingmaßnahmen zu verstehen, zu optimieren und zu skalieren.... direkt in BigQuery realisierst

- Fazit: Warum BigQuery Analyse das nächste Level für datengesteuertes MarketingMarketing: Das Spiel mit Bedürfnissen, Aufmerksamkeit und Profit Marketing ist weit mehr als bunte Bilder, Social-Media-Posts und nervige Werbespots. Marketing ist die strategische Kunst, Bedürfnisse zu erkennen, sie gezielt zu wecken – und aus Aufmerksamkeit Profit zu schlagen. Es ist der Motor, der Unternehmen antreibt, Marken formt und Kundenverhalten manipuliert, ob subtil oder mit der Brechstange. Dieser Artikel entlarvt das... ist

BigQuery Analyse ist das, was passiert, wenn Google seine Cloud-Power mit der Gnadenlosigkeit von SQL kombiniert. Während die meisten Marketer noch mit Tableau rumspielen oder versuchen, aus Google AnalyticsGoogle Analytics: Das absolute Must-have-Tool für datengetriebene Online-Marketer Google Analytics ist das weltweit meistgenutzte Webanalyse-Tool und gilt als Standard, wenn es darum geht, das Verhalten von Website-Besuchern präzise und in Echtzeit zu messen. Es ermöglicht die Sammlung, Auswertung und Visualisierung von Nutzerdaten – von simplen Seitenaufrufen bis hin zu ausgefeilten Conversion-Funnels. Wer seine Website im Blindflug betreibt, ist selbst schuld:... irgendwie brauchbare Reports zu extrahieren, läuft in der echten Champions League längst BigQuery. Hier reden wir nicht mehr über bunte Dashboards, sondern über die Fähigkeit, Milliarden von Zeilen in Sekunden zu durchforsten, komplexe Funnel-Analysen zu fahren und Machine LearningMachine Learning: Algorithmische Revolution oder Buzzword-Bingo? Machine Learning (auf Deutsch: Maschinelles Lernen) ist der Teilbereich der künstlichen Intelligenz (KI), bei dem Algorithmen und Modelle entwickelt werden, die aus Daten selbstständig lernen und sich verbessern können – ohne dass sie explizit programmiert werden. Klingt nach Science-Fiction, ist aber längst Alltag: Von Spamfiltern über Gesichtserkennung bis zu Produktempfehlungen basiert mehr digitale Realität... direkt auf die Rohdaten zu knallen. Wer glaubt, das sei Overkill, hat schlicht nicht verstanden, wie datengetriebenes MarketingMarketing: Das Spiel mit Bedürfnissen, Aufmerksamkeit und Profit Marketing ist weit mehr als bunte Bilder, Social-Media-Posts und nervige Werbespots. Marketing ist die strategische Kunst, Bedürfnisse zu erkennen, sie gezielt zu wecken – und aus Aufmerksamkeit Profit zu schlagen. Es ist der Motor, der Unternehmen antreibt, Marken formt und Kundenverhalten manipuliert, ob subtil oder mit der Brechstange. Dieser Artikel entlarvt das... heute funktioniert. BigQuery Analyse ist das Rückgrat jeder skalierbaren Data-Strategie – und der Unterschied zwischen digitalem Mittelmaß und wirklichem Wettbewerbsvorteil.

BigQuery Analyse erklärt: Was steckt hinter dem Hype?

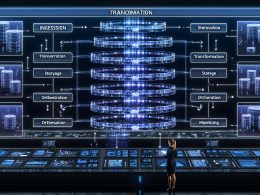

BigQuery Analyse ist mehr als nur irgendein weiteres Cloud-Tool von Google – es ist ein vollständig verwaltetes, serverloses Data Warehouse, das darauf spezialisiert ist, riesige Datenmengen in Lichtgeschwindigkeit zu analysieren. Das Herzstück: Die Fähigkeit, per SQL-Abfrage Billionen von Datensätzen quasi in Echtzeit zu durchleuchten. Die Alternative? On-Premise Datenbanken, die schon bei ein paar Millionen Zeilen ins Schwitzen kommen und deren Wartung so viel Spaß macht wie Steuererklärung per Hand.

Der Clou an BigQuery Analyse? Skalierbarkeit. Keine Server, keine Hardware, kein IT-Overhead – einfach Daten rein, SQL drauf, Insights raus. Die Architektur basiert auf Dremel, Googles legendärer Query-Engine, die spaltenbasiert arbeitet und horizontale Skalierung ohne Limits ermöglicht. Die Folge: Abfragen, die mit klassischer BI-Infrastruktur Minuten oder Stunden dauern, sind in BigQuery Analyse oft in Sekunden erledigt. Das ist besonders dann ein Gamechanger, wenn du mit Echtzeit-Datenströmen, Multi-Channel-Tracking oder granularen Customer-Journey-Analysen arbeitest.

Und nein, BigQuery Analyse ist kein weiteres Buzzword aus dem Google-Cloud-Marketing. Es ist die Antwort auf die Frage, wie du aus dem Chaos von Analytics-Daten, CRMCRM (Customer Relationship Management): Die Königsdisziplin der Kundenbindung und Datenmacht CRM steht für Customer Relationship Management, also das Management der Kundenbeziehungen. Im digitalen Zeitalter bedeutet CRM weit mehr als bloß eine Adressdatenbank. Es ist ein strategischer Ansatz und ein ganzes Software-Ökosystem, das Vertrieb, Marketing und Service miteinander verzahnt, mit dem Ziel: maximale Wertschöpfung aus jedem Kundenkontakt. Wer CRM auf „Newsletter..., E-CommerceE-Commerce: Definition, Technik und Strategien für den digitalen Handel E-Commerce steht für Electronic Commerce, also den elektronischen Handel. Damit ist jede Art von Kauf und Verkauf von Waren oder Dienstleistungen über das Internet gemeint. Was früher mit Fax und Katalog begann, ist heute ein hochkomplexes Ökosystem aus Onlineshops, Marktplätzen, Zahlungsdienstleistern, Logistik und digitalen Marketing-Strategien. Wer im digitalen Handel nicht mitspielt,... und Social MediaSocial Media: Die digitale Bühne für Marken, Meinungsmacher und Marketing-Magier Social Media bezeichnet digitale Plattformen und Netzwerke, auf denen Nutzer Inhalte teilen, diskutieren und interagieren – in Echtzeit, rund um den Globus. Facebook, Instagram, Twitter (X), LinkedIn, TikTok und YouTube sind die üblichen Verdächtigen, aber das Biest „Social Media“ ist weit mehr als ein paar bunte Apps. Es ist Kommunikationskanal,... endlich Insights generierst, die nicht nur hübsch aussehen, sondern Umsatz bringen. Wer als Marketer heute noch glaubt, mit “Google Data Studio reicht schon” sei das Thema durch, lebt in einer Parallelwelt – sorry, not sorry.

Ein weiterer, oft unterschätzter Aspekt: BigQuery Analyse ist serverlos. Das heißt, du musst dich nicht um Instanzen, Updates oder Speicherplatz kümmern. Die Preisstruktur ist nutzungsbasiert – du zahlst für Abfragen und Storage, nicht für “geparkte” Ressourcen. Das Modell zwingt dich, effizient zu denken, statt endlose Datenhalden anzulegen, die nie jemand analysiert.

Warum BigQuery Analyse klassische BI-Tools zerlegt

Stell dir vor, du versuchst, eine Customer JourneyCustomer Journey: Die Reise des Kunden im digitalen Zeitalter Die Customer Journey ist das Rückgrat jeder ernstzunehmenden Online-Marketing-Strategie – und doch wird sie von vielen immer noch auf das banale „Kaufprozess“-Schaubild reduziert. Dabei beschreibt die Customer Journey alle Berührungspunkte (Touchpoints), die ein potenzieller Kunde mit einer Marke durchläuft – vom ersten Impuls bis weit nach dem Kauf. Wer heute digital... mit Millionen Touchpoints per Excel oder Tableau zu analysieren. Viel Spaß beim Zusehen, wie dein Laptop abraucht. Klassische BI-Tools sind bei komplexen Online-Marketing-Daten schnell am Limit: Sie sind nicht für Echtzeit-Analysen gebaut, skalieren schlecht bei exponentiell wachsenden Datenmengen und sind oft auf lokale Datenquellen beschränkt. Das führt zu Reports, die entweder veraltet sind oder schlicht nie fertig werden.

BigQuery Analyse räumt mit diesen Limitierungen auf. Die Plattform kann problemlos Daten aus unterschiedlichsten Quellen (GA4, CRMCRM (Customer Relationship Management): Die Königsdisziplin der Kundenbindung und Datenmacht CRM steht für Customer Relationship Management, also das Management der Kundenbeziehungen. Im digitalen Zeitalter bedeutet CRM weit mehr als bloß eine Adressdatenbank. Es ist ein strategischer Ansatz und ein ganzes Software-Ökosystem, das Vertrieb, Marketing und Service miteinander verzahnt, mit dem Ziel: maximale Wertschöpfung aus jedem Kundenkontakt. Wer CRM auf „Newsletter..., E-CommerceE-Commerce: Definition, Technik und Strategien für den digitalen Handel E-Commerce steht für Electronic Commerce, also den elektronischen Handel. Damit ist jede Art von Kauf und Verkauf von Waren oder Dienstleistungen über das Internet gemeint. Was früher mit Fax und Katalog begann, ist heute ein hochkomplexes Ökosystem aus Onlineshops, Marktplätzen, Zahlungsdienstleistern, Logistik und digitalen Marketing-Strategien. Wer im digitalen Handel nicht mitspielt,..., Ad-Server, Social MediaSocial Media: Die digitale Bühne für Marken, Meinungsmacher und Marketing-Magier Social Media bezeichnet digitale Plattformen und Netzwerke, auf denen Nutzer Inhalte teilen, diskutieren und interagieren – in Echtzeit, rund um den Globus. Facebook, Instagram, Twitter (X), LinkedIn, TikTok und YouTube sind die üblichen Verdächtigen, aber das Biest „Social Media“ ist weit mehr als ein paar bunte Apps. Es ist Kommunikationskanal,..., Logfiles, IoT-Streams) in ein zentrales Warehouse integrieren. Dank nativer SQL-Unterstützung kannst du nicht nur Standard-Abfragen, sondern auch komplexe Joins, Window-Functions und sogar Machine Learning-Modelle direkt auf deine Daten anwenden. Wer noch nie einen Funnel-Report mit 500 Millionen Events in unter 10 Sekunden gebaut hat, versteht nicht, was Geschwindigkeit heute bedeutet.

Ein weiteres Killer-Feature: BigQuery Analyse ist vollständig Cloud-basiert. Das bedeutet, du kannst kollaborativ arbeiten, ohne dich um Zugriffskonflikte, lokale Datenkopien oder Versionierung zu sorgen. Und: Durch automatische Partitionierung und Clustering lassen sich Performance und Kosten granular steuern. Du bezahlst nur für die Daten, die du tatsächlich abfragst – kein Vergleich zu Lizenzmodellen klassischer BI-Suiten, die dich schon für inaktive Nutzer zur Kasse bitten.

Die Integration mit anderen Google Cloud-Services wie Dataflow, Pub/Sub, Looker oder Vertex AI macht BigQuery Analyse zum Herzstück eines modernen Data-Stacks. Wer smart ist, automatisiert ETL-Prozesse, baut Predictive AnalyticsAnalytics: Die Kunst, Daten in digitale Macht zu verwandeln Analytics – das klingt nach Zahlen, Diagrammen und vielleicht nach einer Prise Langeweile. Falsch gedacht! Analytics ist der Kern jeder erfolgreichen Online-Marketing-Strategie. Wer nicht misst, der irrt. Es geht um das systematische Sammeln, Auswerten und Interpretieren von Daten, um digitale Prozesse, Nutzerverhalten und Marketingmaßnahmen zu verstehen, zu optimieren und zu skalieren.... und steuert Marketing-Kampagnen in Echtzeit – alles aus einer Plattform heraus. Und ja, es gibt auch eine REST-API für die ganz Verrückten, die BigQuery in eigene Tools einbauen wollen.

BigQuery Analyse in der Online-Marketing-Praxis: Mehr als nur Zahlenakrobatik

BigQuery Analyse ist im Online-Marketing keine Spielerei, sondern die Grundlage für alles, was über simple Channel-Reports hinausgeht. Wer wirklich wissen will, wie Kampagnen performen, welche Kanäle welche Customer Lifetime Value (CLV)Customer Lifetime Value (CLV): Der Wert eines Kunden im Online-Marketing Customer Lifetime Value (CLV): Der Wert eines Kunden im Online-Marketing Customer Lifetime Value (kurz: CLV, manchmal auch als Kundenwert bezeichnet) ist der heilige Gral im datengetriebenen Marketing. Der CLV misst, wie viel ein einzelner Kunde im Laufe seiner gesamten Geschäftsbeziehung tatsächlich wert ist – und zwar nicht als vage Schätzung,... liefern oder wo die Conversion-Leaks im FunnelFunnel: Der ultimative Trichter im Online-Marketing – Funktionsweise, Aufbau und Optimierung Der Begriff „Funnel“ ist eines dieser magischen Buzzwords, das jeder Online-Marketer mindestens dreimal pro Tag verwendet – meistens, ohne es wirklich zu begreifen. Ein Funnel (deutsch: Trichter) beschreibt die strategische Abfolge von Schritten, mit denen potenzielle Kunden systematisch vom ersten Kontakt bis zum Kauf (und darüber hinaus) geführt werden.... sitzen, kommt um BigQuery Analyse nicht herum. Die Plattform erlaubt es, Rohdaten aus Google AnalyticsGoogle Analytics: Das absolute Must-have-Tool für datengetriebene Online-Marketer Google Analytics ist das weltweit meistgenutzte Webanalyse-Tool und gilt als Standard, wenn es darum geht, das Verhalten von Website-Besuchern präzise und in Echtzeit zu messen. Es ermöglicht die Sammlung, Auswertung und Visualisierung von Nutzerdaten – von simplen Seitenaufrufen bis hin zu ausgefeilten Conversion-Funnels. Wer seine Website im Blindflug betreibt, ist selbst schuld:... 4 (GA4), Google AdsGoogle Ads: Das Werkzeug für bezahlte Sichtbarkeit – und wie man es wirklich meistert Google Ads ist das Synonym für Suchmaschinenwerbung (SEA) – und der Platzhirsch, wenn es darum geht, gezielt Traffic, Leads oder Verkäufe zu kaufen. Von Textanzeigen in der Google-Suche über Display-Banner und Shopping-Kampagnen bis hin zu YouTube-Videoanzeigen: Google Ads ist das Schweizer Taschenmesser des Online-Marketings. Doch wer..., Facebook, Shopify, Salesforce und vielen anderen Quellen zu vereinheitlichen – und zwar auf Query-Ebene, nicht im Spreadsheet.

Ein typischer WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... für BigQuery Analyse im MarketingMarketing: Das Spiel mit Bedürfnissen, Aufmerksamkeit und Profit Marketing ist weit mehr als bunte Bilder, Social-Media-Posts und nervige Werbespots. Marketing ist die strategische Kunst, Bedürfnisse zu erkennen, sie gezielt zu wecken – und aus Aufmerksamkeit Profit zu schlagen. Es ist der Motor, der Unternehmen antreibt, Marken formt und Kundenverhalten manipuliert, ob subtil oder mit der Brechstange. Dieser Artikel entlarvt das... sieht so aus:

- Datenintegration: Rohdaten aus AnalyticsAnalytics: Die Kunst, Daten in digitale Macht zu verwandeln Analytics – das klingt nach Zahlen, Diagrammen und vielleicht nach einer Prise Langeweile. Falsch gedacht! Analytics ist der Kern jeder erfolgreichen Online-Marketing-Strategie. Wer nicht misst, der irrt. Es geht um das systematische Sammeln, Auswerten und Interpretieren von Daten, um digitale Prozesse, Nutzerverhalten und Marketingmaßnahmen zu verstehen, zu optimieren und zu skalieren...., CRMCRM (Customer Relationship Management): Die Königsdisziplin der Kundenbindung und Datenmacht CRM steht für Customer Relationship Management, also das Management der Kundenbeziehungen. Im digitalen Zeitalter bedeutet CRM weit mehr als bloß eine Adressdatenbank. Es ist ein strategischer Ansatz und ein ganzes Software-Ökosystem, das Vertrieb, Marketing und Service miteinander verzahnt, mit dem Ziel: maximale Wertschöpfung aus jedem Kundenkontakt. Wer CRM auf „Newsletter..., E-CommerceE-Commerce: Definition, Technik und Strategien für den digitalen Handel E-Commerce steht für Electronic Commerce, also den elektronischen Handel. Damit ist jede Art von Kauf und Verkauf von Waren oder Dienstleistungen über das Internet gemeint. Was früher mit Fax und Katalog begann, ist heute ein hochkomplexes Ökosystem aus Onlineshops, Marktplätzen, Zahlungsdienstleistern, Logistik und digitalen Marketing-Strategien. Wer im digitalen Handel nicht mitspielt,... und Ad-Servern werden via Data Pipelines oder SDKs in BigQuery geladen.

- Data Cleaning: Mithilfe von SQL werden irrelevante, fehlerhafte oder doppelte Datensätze entfernt – keine Ausreden mehr für “schlechte Datenqualität”.

- Segmentierung & Attribute Building: Nutzer werden nach Verhalten, Kanal, CLV, Produktinteresse oder Funnel-Position segmentiert.

- Funnel- und Kohortenanalysen: Mit Window-Functions und komplexen Joins werden Customer Journeys und RetentionRetention: Die Königsdisziplin für nachhaltiges Wachstum im Online-Marketing Retention bezeichnet im Online-Marketing und in der Digitalwirtschaft die Fähigkeit eines Unternehmens, bestehende Nutzer, Kunden oder Abonnenten langfristig zu binden und wiederkehrend zu aktivieren. Während Akquise immer noch als sexy gilt, ist Retention der unterschätzte, aber entscheidende Hebel für nachhaltiges Wachstum, Profitabilität und Markenrelevanz. Wer seine Retention nicht versteht – und optimiert... ausgewertet – in Echtzeit und auf beliebiger Granularität.

- Machine LearningMachine Learning: Algorithmische Revolution oder Buzzword-Bingo? Machine Learning (auf Deutsch: Maschinelles Lernen) ist der Teilbereich der künstlichen Intelligenz (KI), bei dem Algorithmen und Modelle entwickelt werden, die aus Daten selbstständig lernen und sich verbessern können – ohne dass sie explizit programmiert werden. Klingt nach Science-Fiction, ist aber längst Alltag: Von Spamfiltern über Gesichtserkennung bis zu Produktempfehlungen basiert mehr digitale Realität... & Predictive AnalyticsAnalytics: Die Kunst, Daten in digitale Macht zu verwandeln Analytics – das klingt nach Zahlen, Diagrammen und vielleicht nach einer Prise Langeweile. Falsch gedacht! Analytics ist der Kern jeder erfolgreichen Online-Marketing-Strategie. Wer nicht misst, der irrt. Es geht um das systematische Sammeln, Auswerten und Interpretieren von Daten, um digitale Prozesse, Nutzerverhalten und Marketingmaßnahmen zu verstehen, zu optimieren und zu skalieren....: Native ML-Modelle (z.B. für Churn Prediction oder Next Best Offer) werden direkt auf die Daten angewendet.

- Visualisierung & Reporting: Die Ergebnisse werden via Looker Studio, Tableau oder direkt per APIAPI – Schnittstellen, Macht und Missverständnisse im Web API steht für „Application Programming Interface“, zu Deutsch: Programmierschnittstelle. Eine API ist das unsichtbare Rückgrat moderner Softwareentwicklung und Online-Marketing-Technologien. Sie ermöglicht es verschiedenen Programmen, Systemen oder Diensten, miteinander zu kommunizieren – und zwar kontrolliert, standardisiert und (im Idealfall) sicher. APIs sind das, was das Web zusammenhält, auch wenn kein Nutzer je eine... in Dashboards ausgespielt.

Der große Vorteil: BigQuery Analyse macht Schluss mit Datensilos. Endlich kannst du Conversion-Path-Analysen fahren, Attribution-Modelle testen oder Lookalike Audiences direkt aus den Rohdaten bauen. Wer clever ist, automatisiert sogar Alerts für auffällige KPIsKPIs: Die harten Zahlen hinter digitalem Marketing-Erfolg KPIs – Key Performance Indicators – sind die Kennzahlen, die in der digitalen Welt den Takt angeben. Sie sind das Rückgrat datengetriebener Entscheidungen und das einzige Mittel, um Marketing-Bullshit von echtem Fortschritt zu trennen. Ob im SEO, Social Media, E-Commerce oder Content Marketing: Ohne KPIs ist jede Strategie nur ein Schuss ins Blaue.... – zum Beispiel, wenn die Conversion RateConversion Rate: Die härteste Währung im Online-Marketing Die Conversion Rate ist der KPI, an dem sich im Online-Marketing letztlich alles messen lassen muss. Sie zeigt an, wie viele Besucher einer Website tatsächlich zu Kunden, Leads oder anderen definierten Zielen konvertieren. Anders gesagt: Die Conversion Rate trennt digitales Wunschdenken von echtem Geschäftserfolg. Wer glaubt, Traffic allein sei das Maß aller Dinge,... eines Kanals plötzlich abstürzt oder ein Produkt viral geht.

Und weil BigQuery Analyse auf SQL basiert, kannst du – im Gegensatz zu vielen “No-Code”-Tools – jeden Schritt dokumentieren, versionieren und beliebig erweitern. Das Ergebnis: Ein skalierbarer, nachvollziehbarer Analyse-Workflow, der weit über das hinausgeht, was mit klassischen BI-Tools möglich ist.

BigQuery Analyse: Architektur, Features und Preisstruktur im Detail

BigQuery Analyse lebt von einer kompromisslos skalierbaren Architektur. Die Daten werden spaltenbasiert gespeichert (Columnar Storage), was vor allem bei analytischen Abfragen für massive Performance sorgt. Partitionierung nach Zeitstempel oder anderen Schlüsseln ermöglicht Abfragen auf riesigen Datensätzen, ohne das komplette Warehouse lesen zu müssen. Clustering sorgt zusätzlich dafür, dass verwandte Daten physisch nah beieinander liegen – was Abfragen nochmals beschleunigt und Kosten spart.

Das Herzstück der BigQuery Analyse ist SQL. Aber nicht irgendein SQL, sondern ein mächtiger Dialekt mit Unterstützung für Arrays, Strukturen, Window-Functions, rekursive Joins und sogar User-Defined Functions in JavaScriptJavaScript: Das Rückgrat moderner Webentwicklung – und Fluch für schlechte Seiten JavaScript ist die universelle Programmiersprache des Webs. Ohne JavaScript wäre das Internet ein statisches Museum aus langweiligen HTML-Seiten. Mit JavaScript wird aus einer simplen Webseite eine interaktive Webanwendung, ein dynamisches Dashboard oder gleich ein kompletter Online-Shop. Doch so mächtig die Sprache ist, so gnadenlos ist sie auch bei schlechter.... Damit kannst du selbst komplexe Transformationen und Analysen direkt in der Datenbank ausführen, ohne externe Tools oder Skripte.

Ein besonderes Feature ist das Streaming-Insert: Daten aus externen Quellen (z.B. Echtzeit-Tracking oder IoT) können in Sekundenbruchteilen in BigQuery eingefügt werden – perfekt für Dashboards, die immer aktuell sein müssen. Und: Mit der BigQuery ML-Extension lassen sich Machine Learning-Modelle (Regression, Klassifikation, Clustering) direkt im Warehouse trainieren und ausführen – ohne dass du je einen Datenexport machen musst.

Zur Preisstruktur: BigQuery Analyse arbeitet nach Pay-per-Query-Prinzip. Du zahlst pro abgefragtem Datenvolumen (aktuell rund 5 Dollar pro TB) und für den belegten Speicherplatz. Partitionierung und effiziente Abfragen zahlen sich also direkt in barer Münze aus. Wer wild drauflos abfragt, verbrennt Budget – wer sauber arbeitet, kann mit minimalen Kosten maximalen Output erzeugen.

Kurz: Die Features von BigQuery Analyse sind kein Marketing-Gewäsch, sondern echte Werkzeuge für alle, die mehr wollen als hübsche Reports. Das System wächst mit deinen Anforderungen – egal, ob du mit ein paar GB oder ein paar PB jonglierst.

Schritt-für-Schritt: So setzt du BigQuery Analyse im Online-Marketing ein

BigQuery Analyse ist kein Plug-and-Play-Tool – aber mit dem richtigen Ansatz kannst du in wenigen Schritten von Null auf Datenpower gehen. Hier der No-Bullshit-Ablauf, wie du BigQuery Analyse für deine Marketingziele optimal nutzt:

- 1. Datenquellen identifizieren und anbinden: Finde heraus, welche Daten du wirklich brauchst (GA4, Facebook, CRMCRM (Customer Relationship Management): Die Königsdisziplin der Kundenbindung und Datenmacht CRM steht für Customer Relationship Management, also das Management der Kundenbeziehungen. Im digitalen Zeitalter bedeutet CRM weit mehr als bloß eine Adressdatenbank. Es ist ein strategischer Ansatz und ein ganzes Software-Ökosystem, das Vertrieb, Marketing und Service miteinander verzahnt, mit dem Ziel: maximale Wertschöpfung aus jedem Kundenkontakt. Wer CRM auf „Newsletter..., E-CommerceE-Commerce: Definition, Technik und Strategien für den digitalen Handel E-Commerce steht für Electronic Commerce, also den elektronischen Handel. Damit ist jede Art von Kauf und Verkauf von Waren oder Dienstleistungen über das Internet gemeint. Was früher mit Fax und Katalog begann, ist heute ein hochkomplexes Ökosystem aus Onlineshops, Marktplätzen, Zahlungsdienstleistern, Logistik und digitalen Marketing-Strategien. Wer im digitalen Handel nicht mitspielt,..., Server-Logs etc.). Nutze Standard-Connectoren oder baue eigene ETL-Pipelines mit Tools wie Dataflow oder Fivetran.

- 2. Datenmodell planen: Lege fest, wie deine Datasets, Tabellen und Partitionen strukturiert werden sollen. Achte auf Naming-Conventions und dokumentiere jeden Schritt.

- 3. Daten importieren und bereinigen: Lade die Rohdaten via Batch-Upload oder Streaming ein. Bereinige sie direkt per SQL – filtere Fehler, Dubletten oder irrelevante Felder raus.

- 4. Analysen und Transformationen bauen: Schreibe SQL-Queries für Funnel-Analysen, Segmentierungen, Attributionsmodelle oder Customer Lifetime Value-Auswertungen. Nutze Window-Functions, Joins und Aggregationen, um tiefer zu graben als jedes DashboardDashboard: Die Kommandozentrale für Daten, KPIs und digitale Kontrolle Ein Dashboard ist weit mehr als ein hübsches Interface mit bunten Diagrammen – es ist das digitale Cockpit, das dir in Echtzeit den Puls deines Geschäfts, deiner Website oder deines Marketings zeigt. Dashboards visualisieren komplexe Datenströme aus unterschiedlichsten Quellen und machen sie sofort verständlich, steuerbar und nutzbar. Egal ob Webanalyse, Online-Marketing,....

- 5. Automatisierung etablieren: Nutze Scheduled Queries, um Analysen regelmäßig auszuführen. Richte Alerts für kritische KPIsKPIs: Die harten Zahlen hinter digitalem Marketing-Erfolg KPIs – Key Performance Indicators – sind die Kennzahlen, die in der digitalen Welt den Takt angeben. Sie sind das Rückgrat datengetriebener Entscheidungen und das einzige Mittel, um Marketing-Bullshit von echtem Fortschritt zu trennen. Ob im SEO, Social Media, E-Commerce oder Content Marketing: Ohne KPIs ist jede Strategie nur ein Schuss ins Blaue.... ein (z.B. ConversionConversion: Das Herzstück jeder erfolgreichen Online-Strategie Conversion – das mag in den Ohren der Marketing-Frischlinge wie ein weiteres Buzzword klingen. Wer aber im Online-Marketing ernsthaft mitspielen will, kommt an diesem Begriff nicht vorbei. Eine Conversion ist der Moment, in dem ein Nutzer auf einer Website eine gewünschte Aktion ausführt, die zuvor als Ziel definiert wurde. Das reicht von einem simplen... Drop, Traffic-Peaks, Anomalien).

- 6. Visualisierung und Reporting: Integriere Looker Studio, Tableau oder Power BI direkt mit BigQuery. Baue interaktive Dashboards, die auf Echtzeitdaten basieren – keine Sekunden alten Snapshots.

- 7. Machine LearningMachine Learning: Algorithmische Revolution oder Buzzword-Bingo? Machine Learning (auf Deutsch: Maschinelles Lernen) ist der Teilbereich der künstlichen Intelligenz (KI), bei dem Algorithmen und Modelle entwickelt werden, die aus Daten selbstständig lernen und sich verbessern können – ohne dass sie explizit programmiert werden. Klingt nach Science-Fiction, ist aber längst Alltag: Von Spamfiltern über Gesichtserkennung bis zu Produktempfehlungen basiert mehr digitale Realität... integrieren: Trainiere ML-Modelle direkt in BigQuery (z.B. Churn Prediction oder Next-Best-Offer). Nutze die Ergebnisse, um Marketingkampagnen automatisch zu steuern.

- 8. Kosten- und Performance-Monitoring: Überwache Query-Kosten, Storage-Nutzung und Abfragezeiten. Optimiere Partitionierung, Clustering und Query-Logik regelmäßig.

Wichtig: Dokumentiere jeden Schritt und baue dir eine Library aus wiederverwendbaren SQL-Queries. So wird aus BigQuery Analyse kein Blackbox-Projekt, sondern ein skalierbarer, kontrollierbarer WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz.... Und: Ohne solides Datenmodell und saubere Prozesse wird auch mit BigQuery nur Datenmüll recycelt – also investiere Zeit in Planung und Datenqualität.

Fehlerquellen, Limitierungen und Best Practices in der BigQuery Analyse

BigQuery Analyse ist mächtig – aber kein Wunderwerkzeug. Wer glaubt, einfach “Daten rein, Magic raus” zu machen, wird schnell vom Preismodell oder den Limitierungen eingeholt. Typische Fehlerquellen sind ineffiziente Queries (z.B. SELECT * über ganze Datasets), fehlende Partitionierung oder schlechte Datenmodelle. Das Ergebnis: Abfragekosten explodieren, Analysen dauern ewig oder liefern falsche Ergebnisse.

Eine weitere Falle: Überschätzung der eigenen SQL-Skills. BigQuery Analyse verzeiht keine Syntax- oder Logikfehler – und zieht im Zweifel auch mal einen TB durch, weil jemand vergessen hat, WHERE-Klauseln zu setzen. Deshalb: Immer Preview-Queries fahren und mit LIMIT testen, bevor große Abfragen laufen.

Auch die Integration externer Datenquellen ist kein Selbstläufer. Unterschiedliche Datenformate, Zeitstempel, IDs oder Zeichencodierungen führen schnell zu Bruchlandungen. Hier helfen strukturierte ETL-Prozesse und automatisierte Datenvalidierung. Wer regelmäßig mit Third-Party-APIs arbeitet, sollte auf API-Limits, Latenzen und Formatwechsel achten – sonst gehen wichtige Daten verloren.

Best Practices für BigQuery Analyse:

- Daten immer partitionieren und clustern – das spart Zeit und Geld

- Nur relevante Felder abfragen – SELECT * ist der Tod für Kosten und Performance

- SQL-Queries modular und wiederverwendbar bauen

- Regelmäßig Kosten- und Abfrage-Logs auswerten

- Datenqualität automatisiert überwachen (z.B. mit Scheduled Checks)

- Integrationen und Workflows dokumentieren – keine Blackbox-Prozesse

Wer diese Prinzipien beachtet, macht aus BigQuery Analyse einen echten Wettbewerbsvorteil – und keine Geldverbrennungsmaschine. Alles andere ist teuer, langsam und meistens einfach nur peinlich.

BigQuery Analyse, Schnittstellen und Machine Learning: Das volle Potenzial entfesseln

BigQuery Analyse ist kein Inselsystem. Die wahre Power entfaltet sich erst durch clevere Schnittstellen und Integration mit anderen Cloud-Services. Über die REST- und Streaming-APIs kannst du Daten in Echtzeit einspielen, mit Dataflow oder Apache Beam komplexe Data-Pipelines bauen oder mit Pub/Sub Event-Streams in BigQuery analysieren. Die direkte Verbindung zu Looker, Tableau oder Power BI macht Reporting nicht nur hübsch, sondern auch skalierbar und kollaborativ.

Der nächste Level: Machine LearningMachine Learning: Algorithmische Revolution oder Buzzword-Bingo? Machine Learning (auf Deutsch: Maschinelles Lernen) ist der Teilbereich der künstlichen Intelligenz (KI), bei dem Algorithmen und Modelle entwickelt werden, die aus Daten selbstständig lernen und sich verbessern können – ohne dass sie explizit programmiert werden. Klingt nach Science-Fiction, ist aber längst Alltag: Von Spamfiltern über Gesichtserkennung bis zu Produktempfehlungen basiert mehr digitale Realität... direkt in BigQuery Analyse. Mit BigQuery ML trainierst du Modelle für Regression, Klassifikation, Clustering oder Zeitreihen-Prognosen direkt auf dem Data Warehouse. Kein Umweg über Python, kein Datenexport – der gesamte ML-Workflow läuft per SQL. Das ist besonders mächtig für Predictive MarketingMarketing: Das Spiel mit Bedürfnissen, Aufmerksamkeit und Profit Marketing ist weit mehr als bunte Bilder, Social-Media-Posts und nervige Werbespots. Marketing ist die strategische Kunst, Bedürfnisse zu erkennen, sie gezielt zu wecken – und aus Aufmerksamkeit Profit zu schlagen. Es ist der Motor, der Unternehmen antreibt, Marken formt und Kundenverhalten manipuliert, ob subtil oder mit der Brechstange. Dieser Artikel entlarvt das..., Churn-Analysen, dynamische Pricing-Strategien oder Personalisierung in Echtzeit. Die ML-Ergebnisse landen direkt in deinen Datasets und können sofort operationalisiert werden – zum Beispiel als Trigger für automatisierte Kampagnen oder personalisierte Nutzeransprache.

Und weil BigQuery Analyse vollständig Cloud-nativ ist, lassen sich alle Prozesse automatisieren, versionieren und beliebig skalieren. Wer will, baut mit Vertex AI, Cloud Functions oder sogar eigenen Microservices eine vollständig orchestrierte Data-Factory – alles auf Basis der BigQuery-Engine.

Kurz: Wer BigQuery Analyse nur als “Reporting-Tool” sieht, hat die Pointe verpasst. Das System ist die Schaltzentrale für alles, was datengetriebenes MarketingMarketing: Das Spiel mit Bedürfnissen, Aufmerksamkeit und Profit Marketing ist weit mehr als bunte Bilder, Social-Media-Posts und nervige Werbespots. Marketing ist die strategische Kunst, Bedürfnisse zu erkennen, sie gezielt zu wecken – und aus Aufmerksamkeit Profit zu schlagen. Es ist der Motor, der Unternehmen antreibt, Marken formt und Kundenverhalten manipuliert, ob subtil oder mit der Brechstange. Dieser Artikel entlarvt das... heute ausmacht – von der Datenintegration über Echtzeit-Analyse bis zum Machine LearningMachine Learning: Algorithmische Revolution oder Buzzword-Bingo? Machine Learning (auf Deutsch: Maschinelles Lernen) ist der Teilbereich der künstlichen Intelligenz (KI), bei dem Algorithmen und Modelle entwickelt werden, die aus Daten selbstständig lernen und sich verbessern können – ohne dass sie explizit programmiert werden. Klingt nach Science-Fiction, ist aber längst Alltag: Von Spamfiltern über Gesichtserkennung bis zu Produktempfehlungen basiert mehr digitale Realität.... Wer das nicht nutzt, läuft mit angezogener Handbremse durch den digitalen Wettbewerb.

Fazit: BigQuery Analyse ist das Pflichtprogramm für datengetriebenes Marketing

BigQuery Analyse ist nicht die Zukunft – es ist das Jetzt. Wer heute im Online-Marketing, in SEOSEO (Search Engine Optimization): Das Schlachtfeld der digitalen Sichtbarkeit SEO, kurz für Search Engine Optimization oder Suchmaschinenoptimierung, ist der Schlüsselbegriff für alle, die online überhaupt gefunden werden wollen. Es bezeichnet sämtliche Maßnahmen, mit denen Websites und deren Inhalte so optimiert werden, dass sie in den unbezahlten, organischen Suchergebnissen von Google, Bing und Co. möglichst weit oben erscheinen. SEO ist längst... oder im E-CommerceE-Commerce: Definition, Technik und Strategien für den digitalen Handel E-Commerce steht für Electronic Commerce, also den elektronischen Handel. Damit ist jede Art von Kauf und Verkauf von Waren oder Dienstleistungen über das Internet gemeint. Was früher mit Fax und Katalog begann, ist heute ein hochkomplexes Ökosystem aus Onlineshops, Marktplätzen, Zahlungsdienstleistern, Logistik und digitalen Marketing-Strategien. Wer im digitalen Handel nicht mitspielt,... ernsthaft wachsen will, kommt an BigQuery nicht vorbei. Die Fähigkeit, Milliarden von Datenpunkten in Echtzeit zu analysieren, Kampagnen granular zu steuern und Machine LearningMachine Learning: Algorithmische Revolution oder Buzzword-Bingo? Machine Learning (auf Deutsch: Maschinelles Lernen) ist der Teilbereich der künstlichen Intelligenz (KI), bei dem Algorithmen und Modelle entwickelt werden, die aus Daten selbstständig lernen und sich verbessern können – ohne dass sie explizit programmiert werden. Klingt nach Science-Fiction, ist aber längst Alltag: Von Spamfiltern über Gesichtserkennung bis zu Produktempfehlungen basiert mehr digitale Realität... direkt auf dem Data Warehouse zu betreiben, ist der Gamechanger, der Mittelmaß von Champions trennt. Klassische BI-Tools spielen da nicht mehr mit – die Zukunft gehört denen, die Daten endlich ernst nehmen und BigQuery Analyse als Rückgrat ihrer Data-Strategie einsetzen.

Das klingt nach Aufwand? Ist es auch – aber der ROIROI (Return on Investment): Die härteste Währung im Online-Marketing ROI steht für Return on Investment – also die Rendite, die du auf einen eingesetzten Betrag erzielst. In der Marketing- und Business-Welt ist der ROI der unbestechliche Gradmesser für Erfolg, Effizienz und Wirtschaftlichkeit. Keine Ausrede, kein Blabla: Wer den ROI nicht kennt, spielt blind. In diesem Glossar-Artikel bekommst du einen schonungslos... ist brutal. Wer einmal verstanden hat, wie viel schneller, smarter und skalierbarer BigQuery Analyse funktioniert, will nie wieder zurück zu Excel, Tableau oder Data-Studio-Insellösungen. Die Wahrheit ist: Wer heute noch ohne BigQuery Analyse arbeitet, ist morgen schon irrelevant. Also, Daten rein, SQL drauf, Insights raus – und endlich MarketingMarketing: Das Spiel mit Bedürfnissen, Aufmerksamkeit und Profit Marketing ist weit mehr als bunte Bilder, Social-Media-Posts und nervige Werbespots. Marketing ist die strategische Kunst, Bedürfnisse zu erkennen, sie gezielt zu wecken – und aus Aufmerksamkeit Profit zu schlagen. Es ist der Motor, der Unternehmen antreibt, Marken formt und Kundenverhalten manipuliert, ob subtil oder mit der Brechstange. Dieser Artikel entlarvt das... machen, das diesen Namen verdient.