BigQuery Workflow: Datenflüsse clever automatisieren und steuern

Du glaubst, Datenanalyse sei ein mühsamer Alptraum aus Copy-Paste-Marathons und endlosen Excel-Makros? Willkommen im Jahr 2025, wo BigQuery Workflows dir zeigt, wie du deine Datenflüsse automatisiert, kontrolliert und mit chirurgischer Präzision orchestrierst – oder gnadenlos untergehst. Wer Daten noch manuell bewegt, hat den Anschluss längst verloren. In diesem Artikel zerlegen wir gnadenlos, was ein moderner BigQuery WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... wirklich leisten muss, warum 99% aller “Automatisierungen” in der Praxis kläglich scheitern, und wie du mit den richtigen Strategien, Tools und Techniken endlich Kontrolle über deine Datenströme bekommst. Ready für den Deep Dive? Dann anschnallen – es wird technisch, ehrlich und schmerzhaft effizient.

- Was ein BigQuery WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... ist – und warum manuelle Datenpipelines tot sind

- Die wichtigsten Komponenten für automatisierte Datenflüsse in BigQuery

- Wie du ETL und ELT mit BigQuery Workflows wirklich skalierbar machst

- Welche Tools, APIs und Trigger deinen Datenfluss steuern – und welche du vergessen kannst

- Step-by-Step: So baust du eine automatisierte BigQuery Pipeline ohne nervige Sackgassen

- Typische Fehler in BigQuery Workflows – und wie du sie brutal vermeidest

- Monitoring, Logging und Fehlerbehandlung: Wie du schlaflose Nächte vermeidest

- Security, Kosten und Skalierung – die drei BigQuery-Tabus, die keiner offen anspricht

- Warum ein guter WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... mehr ist als ein paar SQL-Jobs mit Timer

Wer bei BigQuery WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... nur an ein paar geplante Abfragen denkt, hat nicht verstanden, wie Datenarchitektur heute aussieht. Der moderne WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... ist kein Flickenteppich aus Cronjobs und Cloud Functions, sondern ein komplexes Zusammenspiel aus ETL/ELT-Jobs, Triggern, Monitoring, Fehlerbehandlung und Security-Konzepten. Und ja: Wer dabei die Kontrolle verliert, zahlt – mit explodierenden Kosten, Datenverlusten und digitalen Totalschäden. In diesem Artikel bekommst du die schonungslose Wahrheit, die besten Strategien und den technischen Deep Dive, um mit BigQuery Workflows endlich Datenflüsse zu automatisieren, zu steuern – und zu gewinnen.

BigQuery Workflow: Was ist das überhaupt und warum ist Automatisierung Pflicht?

Der Begriff “BigQuery WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz...” geistert durch LinkedIn-Posts, Marketing-Folien und Cloud-Konferenzen – und wird meist so falsch verstanden wie Search IntentSearch Intent: Die wahre Währung des SEO – Nutzerbedürfnisse verstehen, Rankings dominieren Search Intent – oder auf Deutsch: Suchintention – steht im Zentrum jeder erfolgreichen SEO-Strategie. Es geht um die simple, aber alles entscheidende Frage: Was will der Nutzer wirklich, wenn er einen Suchbegriff in Google & Co. eintippt? Wer die Search Intent seiner Zielgruppe nicht versteht, spielt SEO wie... bei Affiliate-SEOs. Ein BigQuery WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... ist eben nicht das manuelle Ausführen von SQL-Statements oder das morgendliche Hochladen von CSVs. Es geht um die komplette, automatisierte Steuerung von Datenflüssen: vom Datenimport über Transformation und Aggregation bis zum Reporting. Und zwar so, dass alles zuverlässig, wiederholbar und skalierbar läuft – ohne dass du nachts um drei in der Google Cloud Console Fehler logs durchscrollen musst.

Der BigQuery WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... ist das Rückgrat moderner Datenarchitekturen. Ohne Workflow-Automatisierung wird aus jeder noch so schicken Analytics-Lösung ein unübersichtlicher, fehleranfälliger Haufen aus Ad-hoc-Jobs und Notfallskripten. Und ja: Wer glaubt, das bisschen Datenhandling mit Makros oder Cronjobs zu lösen, hat den Schuss nicht gehört. Denn: Datenmengen explodieren, Anforderungen wachsen, und Fehler im Datenfluss sind nicht nur peinlich, sondern geschäftsschädigend.

Automatisierung ist kein Buzzword, sondern Überlebensstrategie. Ein sauber konfigurierter BigQuery WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... spart nicht nur Zeit und Nerven, sondern sorgt auch für Compliance, Datenintegrität und planbare Kosten. Alles andere ist digitaler Selbstmord auf Raten. BigQuery WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... ist das Werkzeug, mit dem du aus Daten endlich einen echten Wettbewerbsvorteil machst – oder eben grandios scheiterst.

In den ersten Drittel dieses Artikels wirst du den Begriff “BigQuery WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz...” immer wieder lesen – und das mit Absicht. Denn nur wer wirklich versteht, dass der BigQuery WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... das Herzstück jeder datengetriebenen Organisation ist, kann ihn auch richtig nutzen. BigQuery WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... ist mehr als ein paar geplante Abfragen: Es ist das Framework, das aus Daten Chaos Ordnung macht.

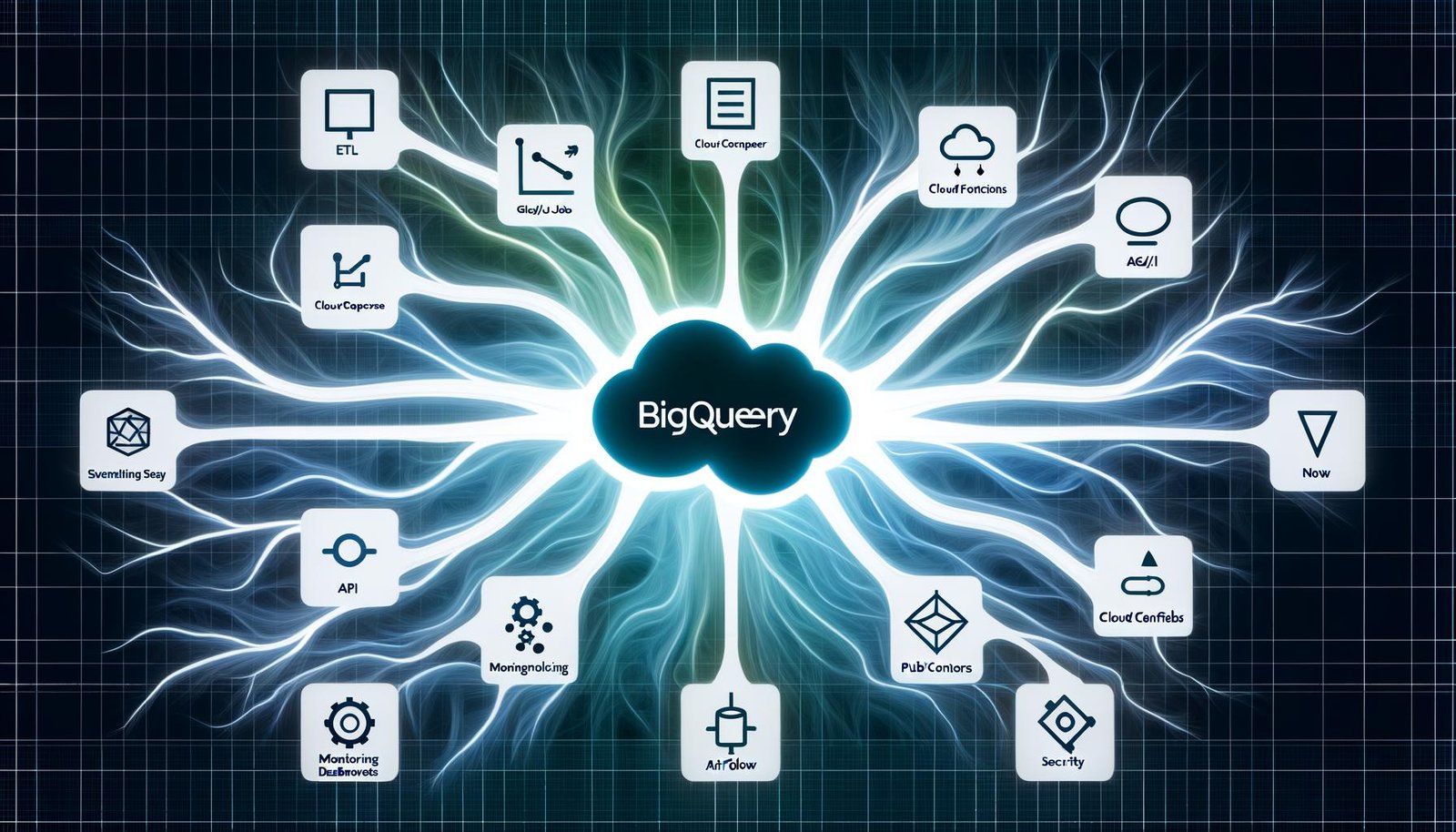

Die Komponenten eines modernen BigQuery Workflow: Von ETL bis Orchestrierung

Ein BigQuery WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... besteht nicht aus einzelnen SQL-Statements oder Copy-Paste-Skripten. Er ist ein hochvernetztes System. Die wichtigsten Komponenten? ETL/ELT-Pipelines, Trigger, Scheduling, Monitoring, Logging, Fehlerbehandlung und Security. Wer hier schludert, bekommt Chaos – und zahlt mit Datenverlust oder explodierenden Cloud-Kosten.

ETL (Extract, Transform, Load) und ELT (Extract, Load, Transform) sind die grundlegenden Prinzipien, mit denen du Daten in BigQuery Workflows verarbeitest. Dabei werden Daten aus verschiedenen Quellen extrahiert, transformiert (bereinigt, angereichert, aggregiert) und schließlich in BigQuery geladen. Der Unterschied zwischen ETL und ELT? Bei ETL wird vor dem Laden transformiert, bei ELT erst nach dem Laden – was bei BigQuery Workflows meist effizienter ist, weil du die Power der BigQuery Engine für die Transformation nutzt.

Doch ein BigQuery WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... geht weit über ETL hinaus: Er nutzt Tools wie Cloud Composer (basierend auf Apache Airflow), Dataflow, Cloud Functions und Pub/Sub für die Orchestrierung. Damit steuerst du, wann welcher Job wie ausgeführt wird – und kannst Abhängigkeiten, Fehlerfälle und Wiederholungen granular definieren. Scheduler und Trigger (z.B. Zeitpläne, Datei-Uploads oder API-Calls) sind die Startpunkte deiner Workflows. Hier entscheidet sich, ob dein BigQuery WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... robust und flexibel ist – oder zum 1-Euro-Skript verkommt.

Monitoring und Logging sind im BigQuery WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... keine Kür, sondern Pflicht. Ohne ein sauberes Logging und Alerting stehst du im Fehlerfall im Dunkeln. Stackdriver (jetzt: Cloud Logging), BigQuery Audit Logs und individuelle Monitoring-Lösungen mit Prometheus oder Datadog helfen dir, jeden Schritt im BigQuery WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... nachvollziehbar und kontrollierbar zu machen. Das Ziel: Null Blindflug, volle Kontrolle.

BigQuery Workflow automatisieren: Tools, APIs und Trigger im Vergleich

Wer bei BigQuery WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... nur auf die interne Scheduling-Funktion setzt, verschenkt Potenzial – und riskiert, bei komplexen Datenflüssen schnell an die Wand zu fahren. Die Wahrheit: Ein professioneller BigQuery WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... nutzt externe Orchestrierungstools und APIs, um Jobs zuverlässig, wiederholbar und skalierbar zu automatisieren. Die wichtigsten Tools im Überblick:

- Cloud Composer (Apache Airflow): Das Orchestrierungs-Flaggschiff für BigQuery Workflows. Hier baust du DAGs (Directed Acyclic Graphs), die komplexe Abhängigkeiten, parallele Tasks, Fehlerbehandlung und Wiederholungen abbilden. Airflow spricht nativ mit BigQuery, Cloud Storage, Pub/Sub und fast jedem Cloud-Service. Wer ernsthaft Workflows steuern will, kommt an Composer nicht vorbei.

- Cloud Functions & Pub/Sub: Mit Cloud Functions kannst du Event-getriebene BigQuery Workflows aufbauen – z.B. wenn ein neues File in der Cloud landet oder eine APIAPI – Schnittstellen, Macht und Missverständnisse im Web API steht für „Application Programming Interface“, zu Deutsch: Programmierschnittstelle. Eine API ist das unsichtbare Rückgrat moderner Softwareentwicklung und Online-Marketing-Technologien. Sie ermöglicht es verschiedenen Programmen, Systemen oder Diensten, miteinander zu kommunizieren – und zwar kontrolliert, standardisiert und (im Idealfall) sicher. APIs sind das, was das Web zusammenhält, auch wenn kein Nutzer je eine... einen Trigger schickt. Pub/Sub sorgt dabei für Messaging und Entkopplung deiner Komponenten. Perfekt für reaktive, mikroservice-basierte Workflows.

- BigQuery Scheduled Queries: Der Einstieg für simple, zeitgesteuerte Jobs direkt in BigQuery. Für einfache Szenarien okay – aber bei komplexen Abhängigkeiten, Fehlerbehandlung oder Skalierung schnell am Limit.

- Dataflow: Das Tool für Streaming- und Batch-Pipelines, wenn Transformationen zu komplex für SQL werden. Dataflow (basierend auf Apache Beam) integriert direkt mit BigQuery – aber Achtung: Hier steigt die Komplexität und die Lernkurve rapide.

- Third-Party Tools (z.B. dbt, Prefect, Dagster): Für Spezialfälle und größere Teams können externe Workflow-Engines sinnvoll sein. Sie bieten Versionierung, Code-First-Ansätze, Testing und bessere Integration in DevOps-Prozesse – sind aber nichts für Anfänger.

Die Wahl des Tools für deinen BigQuery WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... hängt ab von Datenvolumen, Komplexität, Team-Skills und Budget. Wer nur Scheduled Queries nutzt, verschenkt Möglichkeiten. Wer alles mit Airflow erschlägt, riskiert Overengineering. Die Kunst: Das richtige Maß finden – und dabei nie die Kontrolle verlieren.

APIs sind das Rückgrat der Automatisierung. Die BigQuery APIAPI – Schnittstellen, Macht und Missverständnisse im Web API steht für „Application Programming Interface“, zu Deutsch: Programmierschnittstelle. Eine API ist das unsichtbare Rückgrat moderner Softwareentwicklung und Online-Marketing-Technologien. Sie ermöglicht es verschiedenen Programmen, Systemen oder Diensten, miteinander zu kommunizieren – und zwar kontrolliert, standardisiert und (im Idealfall) sicher. APIs sind das, was das Web zusammenhält, auch wenn kein Nutzer je eine... erlaubt das Starten, Überwachen und Verwalten von Jobs programmatisch. Integriere sie in Python, Go, Node.js oder per Bash – und du steuerst deinen BigQuery WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... vollautomatisch. Trigger können dabei zeitgesteuert (Schedule), eventbasiert (Pub/Sub, Storage Events) oder API-gesteuert (HTTP Requests) erfolgen. Nur so entsteht ein echter, automatisierter BigQuery WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... – und nicht bloß ein glorifizierter Cronjob.

Step-by-Step: So baust du einen robusten BigQuery Workflow ohne Kopfschmerzen

Ein BigQuery WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... ist kein Zaubertrick, sondern eine Frage strukturierter Planung, sauberer Umsetzung und rigoroser Kontrolle. Wer sich kopflos durch die Cloud Console klickt, produziert Chaos – und wird von Bugs, Kostenexplosionen und Datenverlust bestraft. So gehst du vor:

- Anforderungsanalyse: Definiere, welche Datenquellen du brauchst, wie oft Daten aktualisiert werden sollen, welche Transformationen nötig sind und welche Abhängigkeiten bestehen. Ohne Klarheit hier wird jeder BigQuery WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... zur Zeitbombe.

- Architektur entwerfen: Entscheide, welche Tools (Composer, Functions, Dataflow, Scheduled Queries) du einsetzt und wie sie zusammenspielen. Skizziere deine Datenflüsse als DAG (Directed Acyclic Graph) – das zwingt dich zu Klarheit und verhindert Deadlocks.

- ETL/ELT-Pipelines bauen: Implementiere die Datenextraktion (z.B. via Cloud Storage, APIAPI – Schnittstellen, Macht und Missverständnisse im Web API steht für „Application Programming Interface“, zu Deutsch: Programmierschnittstelle. Eine API ist das unsichtbare Rückgrat moderner Softwareentwicklung und Online-Marketing-Technologien. Sie ermöglicht es verschiedenen Programmen, Systemen oder Diensten, miteinander zu kommunizieren – und zwar kontrolliert, standardisiert und (im Idealfall) sicher. APIs sind das, was das Web zusammenhält, auch wenn kein Nutzer je eine..., Pub/Sub), die Transformation (SQL, Dataflow, dbt) und das Laden nach BigQuery. Nutze Parameterisierung und Templates für Wiederverwendbarkeit.

- Orchestrierung und Scheduling: Baue Abhängigkeiten, Fehlerbehandlung und Wiederholungen sauber ein. Airflow-Operatoren für BigQuery, Branching, Trigger und Notifications sind hier Gold wert.

- Monitoring und Logging: Integriere Cloud Logging, Fehler-Alerts und Monitoring Dashboards. Jeder Schritt deines BigQuery WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... muss nachvollziehbar und auditierbar sein. Wer hier spart, zahlt bei der ersten Störung.

- Testing und Validierung: Schreibe Unit- und Integrationstests für deine Transformationen, checke Datenqualität mit Checksummen und Thresholds. Jeder BigQuery WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... ohne Tests ist ein Blindflug.

Die Schritte kurz und brutal ehrlich:

- Planen und skizzieren (Papier, Whiteboard, Miro – ganz egal, Hauptsache nicht “aus dem Bauch”)

- Tools und Architektur festlegen (kein Tool-Zoo, aber auch keine Monokultur)

- ETL/ELT-Skripte entwickeln (wiederverwendbar und robust, kein Copy-Paste-Müll)

- Orchestrierung mit Airflow/Composer oder Functions/Trigger aufsetzen

- Monitoring/Logging/Alerting einbauen (von Anfang an, nicht “später mal”)

- Testen, testen, testen und dann versionieren

- Regelmäßig überprüfen und optimieren (nichts ist für die Ewigkeit)

Wer diese Schritte ignoriert, baut keine BigQuery Workflows – sondern tickende Datenbomben.

Typische Fehler in BigQuery Workflows – und wie du sie brutal vermeidest

Die Liste der Fehler in BigQuery Workflows ist länger als die Release Notes von Apache Airflow. Die häufigsten Stolperfallen? Fehlende Fehlerbehandlung, unkontrollierte Kosten, mangelnde Security und eine fatale Ignoranz gegenüber Monitoring. Wer hier patzt, zahlt – und zwar oft mit Datenverlust, Compliance-Problemen oder massiven Cloud-Rechnungen.

Fehler 1: Kein zentrales Monitoring. Wer sich auf BigQuery-Job-Status allein verlässt, hat im Fehlerfall keine Ahnung, wo der WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... eigentlich abgebrochen ist. Die Lösung: Zentralisiertes Logging (Cloud Logging), strukturierte Error-Handling-Branches in Airflow, automatisierte Alerts via Stackdriver.

Fehler 2: Ungeprüfte Schedules. Ein falsch getakteter Scheduled Query oder ein überlappender DAG kann Jobs doppelt ausführen oder Daten überschreiben. Lösung: Klare Abhängigkeitsdefinitionen, Locks, Idempotenz in den Pipelines und Versionierung der Transformations-Skripte.

Fehler 3: Kostenexplosion durch unkontrollierte Datenmengen. Wer Daten wild nach BigQuery lädt, zahlt für Storage und Query-Kosten – auch für Müll. Lösung: Partitionierung, Sharding, Time-based Tables, Kostenlimits und Query-Optimierung (z.B. nur benötigte Spalten abfragen).

Fehler 4: Security by Obscurity. Fehlende IAM-Policies oder offene Service Accounts sind ein gefundenes Fressen für Angreifer. Lösung: Prinzip der geringsten Rechte (Least Privilege), Audit Logs regelmäßig prüfen, Service Accounts hart limitieren, Secrets in Secret Manager speichern.

Fehler 5: Keine Wiederholbarkeit. Wenn ein Job wegen eines API-Ausfalls crasht und nicht sauber wiederholt werden kann, ist der WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... tot. Lösung: Retry-Policies, Dead Letter Queues, State Management und saubere Transaktionslogik.

Security, Kosten und Skalierung: Die BigQuery Workflow Tabus

Es wird Zeit, über die drei Elefanten im Raum zu sprechen, die in jedem BigQuery WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... stecken, aber in kaum einem Cloud-Whitepaper offen diskutiert werden: Security, Kosten und Skalierbarkeit. Wer hier naiv ist, wird von der Realität schneller überrollt als ein schlecht gecachter ETL-Job.

Security ist in BigQuery Workflows nicht optional. Jede Datenpipeline braucht klare IAM-Rollen, Service Accounts mit minimalen Rechten und ein Audit-Logging, das jede Aktion nachvollziehbar macht. Unverschlüsselte Daten, offene Buckets oder fehlende Zugriffskontrollen sind kein Kavaliersdelikt, sondern ein Compliance-GAU. Nutze den Google Secret Manager für Passwörter, halte Service Accounts strikt getrennt und prüfe Audit-Logs regelmäßig – oder rechne mit bösen Erwachen.

Kostenkontrolle ist der unterschätzte Killer. BigQuery kostet pro gespeicherte und abgefragte Datenmenge. Wer Partitionierung, Clustering oder Query-Optimierung verschläft, zahlt für Daten, die niemand braucht. Monitoring von Query-Kosten, Table-Expiration und Storage-Limits sind Pflicht. Setze Kostengrenzen (Budgets), nutze Previews statt Full Table Scans und räume regelmäßig auf.

Skalierung ist kein Buzzword, sondern Überlebensnotwendigkeit. Jeder BigQuery WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... muss so gebaut sein, dass er auch bei Datenexplosion, neuen Quellen oder Lastspitzen funktioniert. Das bedeutet: Keine Hardcodings, sondern Parameterisierung. Keine Monolithen, sondern modulare Pipelines. Kein Blindflug, sondern automatisiertes Scaling und Monitoring – sonst geht dir der WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... beim ersten Traffic-Peak gnadenlos baden.

Fazit: BigQuery Workflow – Datenflüsse steuern, nicht hoffen

BigQuery Workflows sind kein Luxus für Data Engineers, sondern der Unterschied zwischen planbarer Datenarchitektur und blindem Cloud-Chaos. Wer noch glaubt, Datenflüsse mit Cronjobs und Glück zu steuern, sollte schnell umdenken. Moderne BigQuery Workflows automatisieren, orchestrieren und kontrollieren Daten – mit klaren Prozessen, robusten Tools und rigorosem Monitoring.

Wer dabei auf die richtigen Komponenten setzt, Fehlerquellen gnadenlos eliminiert und Security, Kosten und Skalierung im Griff behält, gewinnt. Wer AutomationAutomation: Der wahre Gamechanger im digitalen Zeitalter Automation ist das Zauberwort, das seit Jahren durch die Flure jeder halbwegs digitalen Company hallt – und trotzdem bleibt es oft ein Buzzword, das kaum jemand wirklich versteht. In der Realität bedeutet Automation weit mehr als nur ein paar Makros oder „Automatisierungstools“: Es ist die gezielte, systematische Übertragung wiederkehrender Aufgaben auf Software oder... verschläft oder Workflows dilettantisch baut, zahlt – mit Datenverlust, Cloud-Kosten und Wettbewerbsnachteilen. Der BigQuery WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... ist kein Nice-to-have. Er ist das Fundament moderner Datenstrategie. Wer ihn im Griff hat, kontrolliert seine Daten. Und wer seine Daten kontrolliert, kontrolliert sein Geschäft.