Data Engineering Modell: Clever Datenströme meistern lernen

Du glaubst, Daten fließen einfach so durch dein Unternehmen, wie Wasser durch ein Rohr? Falsch gedacht. Wer 2025 noch an Datensilos, chaotische Excel-Orgien oder „Data Swamps“ glaubt, ist schon jetzt digital abgehängt. In diesem Artikel zerlegen wir das Data Engineering Modell bis auf den letzten Bit – und zeigen dir, wie du Datenströme endlich clever, skalierbar und zukunftsfest orchestrierst. Spoiler: Es wird technisch, es wird schonungslos, und es wird klar, warum der Kampf um Datenkompetenz längst entschieden wird, bevor das erste DashboardDashboard: Die Kommandozentrale für Daten, KPIs und digitale Kontrolle Ein Dashboard ist weit mehr als ein hübsches Interface mit bunten Diagrammen – es ist das digitale Cockpit, das dir in Echtzeit den Puls deines Geschäfts, deiner Website oder deines Marketings zeigt. Dashboards visualisieren komplexe Datenströme aus unterschiedlichsten Quellen und machen sie sofort verständlich, steuerbar und nutzbar. Egal ob Webanalyse, Online-Marketing,... auch nur geladen ist.

- Was ein modernes Data Engineering Modell wirklich ist – und warum es mehr als „Datenpipeline“ bedeutet

- Die wichtigsten Komponenten und Architekturprinzipien im Data Engineering 2025

- Von ETL bis ELT: Wie Datenströme heute orchestriert werden – und wo die Fallen lauern

- Warum Automatisierung, DataOps und Monitoring keine Kür, sondern Pflicht sind

- Wie du mit Data Engineering Skalierbarkeit, Kostenkontrolle und Compliance in den Griff bekommst

- Die besten Tools, Technologien und Frameworks für Data Engineering – von Airflow bis dbt

- Schritt-für-Schritt: So baust du eine robuste, zukunftsfähige Datenarchitektur auf

- Was viele Unternehmen beim Data Engineering Modell falsch machen (und wie du es besser machst)

- Ein knackiges Fazit und ein Weckruf: Ohne Data Engineering bleibt dein Unternehmen im Blindflug

Wer im digitalen MarketingMarketing: Das Spiel mit Bedürfnissen, Aufmerksamkeit und Profit Marketing ist weit mehr als bunte Bilder, Social-Media-Posts und nervige Werbespots. Marketing ist die strategische Kunst, Bedürfnisse zu erkennen, sie gezielt zu wecken – und aus Aufmerksamkeit Profit zu schlagen. Es ist der Motor, der Unternehmen antreibt, Marken formt und Kundenverhalten manipuliert, ob subtil oder mit der Brechstange. Dieser Artikel entlarvt das... oder in der Produktentwicklung erfolgreich sein will, braucht eines vor allem: saubere, nutzbare und vor allem verlässliche Daten. Das klingt trivial, ist aber die absolute Ausnahme. Die meisten Unternehmen hantieren 2025 immer noch mit Flickwerk, Excel-Insellösungen und einem gefährlichen Mix aus Legacy-Systemen, schlecht dokumentierten APIs und unüberblickbaren Datenflüssen. Das Data Engineering Modell ist die Antwort auf dieses Chaos – und der Schlüssel, um aus Daten echten Mehrwert zu generieren. Es geht dabei nicht um ein weiteres Buzzword, sondern um ein hochkomplexes, technisches Framework, das Datenströme automatisiert, skaliert und absichert. Wer das nicht beherrscht, verliert – an Effizienz, an Innovationskraft und letztlich an Wettbewerbsfähigkeit.

Im Kern geht es beim Data Engineering Modell um die Beherrschung und Optimierung von Datenpipelines – von der Datenakquise über die Transformation bis hin zur Bereitstellung für AnalyticsAnalytics: Die Kunst, Daten in digitale Macht zu verwandeln Analytics – das klingt nach Zahlen, Diagrammen und vielleicht nach einer Prise Langeweile. Falsch gedacht! Analytics ist der Kern jeder erfolgreichen Online-Marketing-Strategie. Wer nicht misst, der irrt. Es geht um das systematische Sammeln, Auswerten und Interpretieren von Daten, um digitale Prozesse, Nutzerverhalten und Marketingmaßnahmen zu verstehen, zu optimieren und zu skalieren...., Machine LearningMachine Learning: Algorithmische Revolution oder Buzzword-Bingo? Machine Learning (auf Deutsch: Maschinelles Lernen) ist der Teilbereich der künstlichen Intelligenz (KI), bei dem Algorithmen und Modelle entwickelt werden, die aus Daten selbstständig lernen und sich verbessern können – ohne dass sie explizit programmiert werden. Klingt nach Science-Fiction, ist aber längst Alltag: Von Spamfiltern über Gesichtserkennung bis zu Produktempfehlungen basiert mehr digitale Realität... oder operative Prozesse. Doch das Modell ist weit mehr als eine Pipeline. Es ist ein durchdachtes Zusammenspiel aus Architektur, Governance, Automatisierung und Monitoring. Und jeder, der glaubt, man könne das mal eben “mit einem Data Warehouse” erschlagen, hat von moderner Datenarchitektur genauso viel verstanden wie ein Fisch vom Fahrradfahren.

Der Hauptkeyword “Data Engineering Modell” ist nicht nur ein technisches Must-have, sondern mittlerweile ein strategischer Gamechanger. Unternehmen, die ihre Datenströme nicht intelligent steuern, verbrennen Geld, Zeit und Vertrauen. Dieser Artikel liefert dir den kompletten Deep Dive: Von den wichtigsten Architekturprinzipien, über die Auswahl der richtigen Technologien bis hin zu den Fallen, an denen heute noch 80 Prozent aller Data-Initiativen grandios scheitern.

Was ist ein Data Engineering Modell? – Architektur und Kernprinzipien im Überblick

Das Data Engineering Modell ist weit mehr als ein einfaches Set an Tools oder eine hübsche PowerPoint-Folie. Es ist die technische und organisatorische Blaupause, wie Unternehmen den gesamten Datenlebenszyklus – von der Rohdatenerfassung bis zur Bereitstellung für AnalyticsAnalytics: Die Kunst, Daten in digitale Macht zu verwandeln Analytics – das klingt nach Zahlen, Diagrammen und vielleicht nach einer Prise Langeweile. Falsch gedacht! Analytics ist der Kern jeder erfolgreichen Online-Marketing-Strategie. Wer nicht misst, der irrt. Es geht um das systematische Sammeln, Auswerten und Interpretieren von Daten, um digitale Prozesse, Nutzerverhalten und Marketingmaßnahmen zu verstehen, zu optimieren und zu skalieren.... und KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... – beherrschen. Und dabei geht es nicht um Bauchgefühl, sondern um harte, technische Fakten.

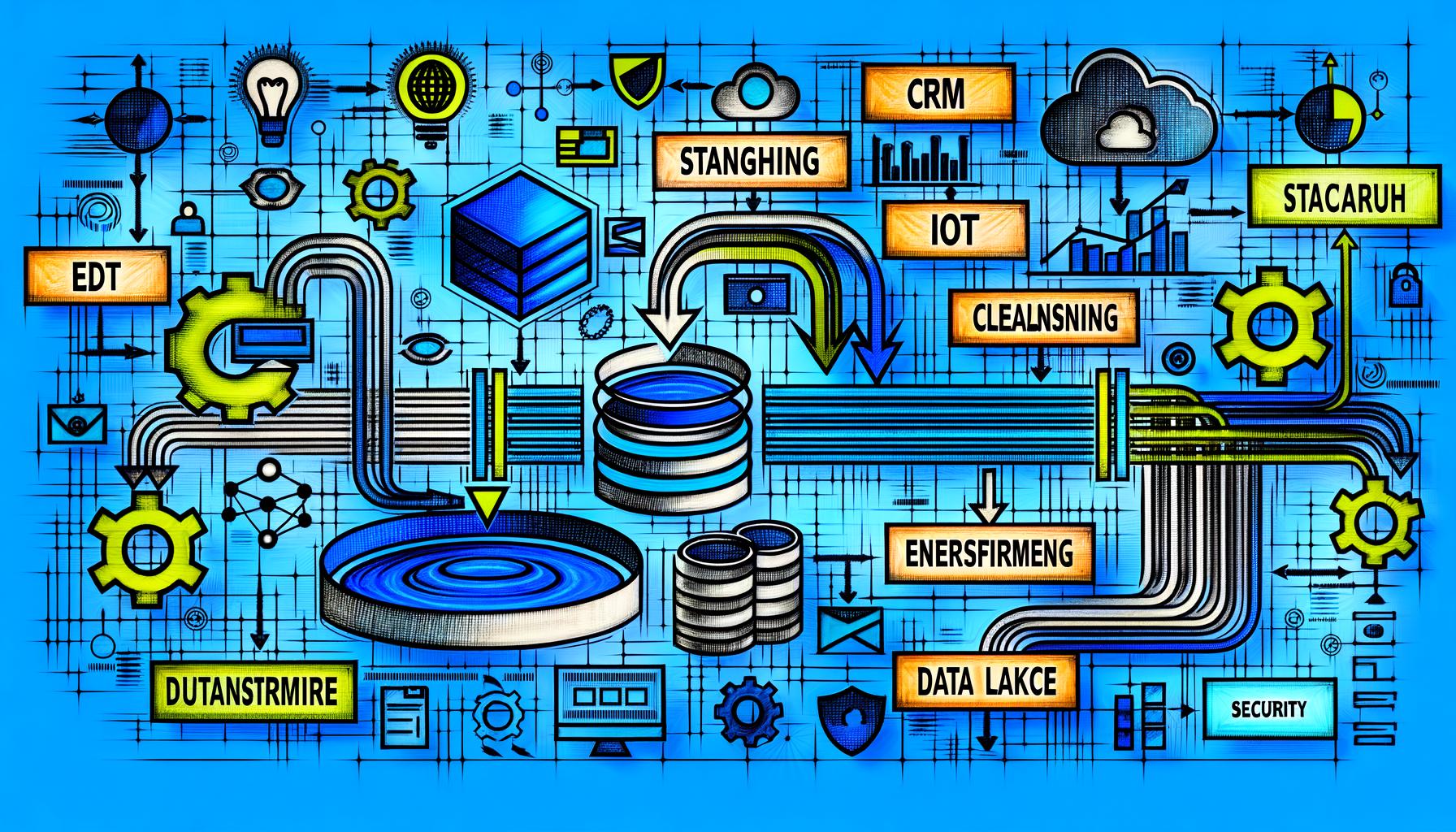

Im Zentrum steht immer die Orchestrierung von Datenströmen. Ein Data Engineering Modell definiert, wie Datenquellen angebunden, wie Daten extrahiert, bereinigt, transformiert und gespeichert werden. Dabei spielen Komponenten wie ETL (Extract, Transform, Load), ELT (Extract, Load, Transform), Data Lakes, Data Warehouses und Streaming-Architekturen zentrale Rollen. Klingt nach Buzzword-Bingo? Nicht ganz: Wer die Begriffe nicht versteht, kann keinen einzigen Prozess sauber bauen.

Wichtige Architekturprinzipien sind dabei: Skalierbarkeit (horizontal wie vertikal), Modularität, Wiederverwendbarkeit von Pipelines, Automatisierung durch Workflow-Orchestrierung (z. B. Apache Airflow), Fehlerresilienz durch klare Logging- und Monitoring-Konzepte sowie Security und Compliance by Design. Noch Fragen, warum die meisten Unternehmen hier bereits an der ersten Hürde scheitern?

Das Data Engineering Modell verlangt eine klare Trennung zwischen Rohdatenhaltung (Raw Zone), Veredelung (Staging, Cleansing, Enrichment) und Bereitstellung (Serving Layer). Jede Stufe braucht eigene Tools, Prozesse und Verantwortlichkeiten. Nur so wird aus einem Datensumpf eine produktive Datenplattform.

Data Engineering Modell: Komponenten, Tools und Technologien, die wirklich zählen

Das Data Engineering Modell lebt und stirbt mit seinen Komponenten und der Auswahl der passenden Tools. Wer hier auf das erstbeste Open-Source-Projekt springt oder sich von hippen Cloud-Providern blenden lässt, landet schnell im nächsten Datenchaos. Es geht um technische Exzellenz – und die beginnt bei der Architektur.

Die Basis jeder Datenplattform ist die Datenintegration: Daten werden aus unterschiedlichsten Quellen (CRMCRM (Customer Relationship Management): Die Königsdisziplin der Kundenbindung und Datenmacht CRM steht für Customer Relationship Management, also das Management der Kundenbeziehungen. Im digitalen Zeitalter bedeutet CRM weit mehr als bloß eine Adressdatenbank. Es ist ein strategischer Ansatz und ein ganzes Software-Ökosystem, das Vertrieb, Marketing und Service miteinander verzahnt, mit dem Ziel: maximale Wertschöpfung aus jedem Kundenkontakt. Wer CRM auf „Newsletter..., ERP, IoT, Webtracking, Third-Party-APIs) in ein zentrales System überführt. Hier kommen klassische ETL-Tools wie Talend, Informatica oder moderne Cloud-Lösungen wie Fivetran und Stitch ins Spiel. Für Streaming-Data sind Apache Kafka, AWS Kinesis oder Google Pub/Sub State of the Art. Wer die Datenintegration nicht beherrscht, braucht gar nicht erst mit AnalyticsAnalytics: Die Kunst, Daten in digitale Macht zu verwandeln Analytics – das klingt nach Zahlen, Diagrammen und vielleicht nach einer Prise Langeweile. Falsch gedacht! Analytics ist der Kern jeder erfolgreichen Online-Marketing-Strategie. Wer nicht misst, der irrt. Es geht um das systematische Sammeln, Auswerten und Interpretieren von Daten, um digitale Prozesse, Nutzerverhalten und Marketingmaßnahmen zu verstehen, zu optimieren und zu skalieren.... anzufangen.

Im nächsten Schritt folgt die Datenverarbeitung. Hier dominieren Frameworks wie Apache Spark, dbt (data build tool) oder Databricks. Sie bieten skalierbare Transformationen, Data Quality Checks und ermöglichen es, komplexe Business-Logik automatisiert und versioniert abzubilden. Besonders dbt setzt sich 2025 als Standard für analytische Transformationen durch – mit klarer Versionierung, Testing und Orchestrierung via Airflow oder Prefect.

Die Datenspeicherung ist das nächste Minenfeld: Data Lakes (z. B. AWS S3, Azure Data Lake Storage, Google Cloud Storage) bieten günstige, flexible Speicherung für Rohdaten. Data Warehouses (BigQuery, Snowflake, Redshift, Synapse) sind für performante Analysen optimiert. Die Kunst besteht darin, Data Lake und Warehouse sauber zu verzahnen und Datendopplungen zu vermeiden. Wer glaubt, ein Data Lake löst alle Probleme, erzeugt nur einen neuen Data Swamp.

Abschließend sind Monitoring, Orchestrierung und DataOps unerlässlich. Tools wie Apache Airflow, Prefect oder Dagster steuern Datenpipelines, automatisieren Workflows und sorgen für Transparenz. Ohne Logging, Alerting und automatisierte Tests ist jede Datenplattform eine Blackbox – und das ist 2025 ein No-Go.

ETL, ELT & Data Pipelines: Wie moderne Datenströme im Data Engineering Modell funktionieren

Die Begriffe ETL und ELT sind das Rückgrat jedes Data Engineering Modells – und werden doch ständig verwechselt oder missbraucht. Zeit für eine klare, technische Einordnung: ETL (Extract, Transform, Load) bedeutet, dass Daten vor dem Laden in das Zielsystem bereits transformiert werden. ELT (Extract, Load, Transform) lädt die Rohdaten erst einmal “as is” ins Zielsystem (meist ein Data Warehouse oder Lake), bevor Transformationen stattfinden. Klingt nach einem kleinen Unterschied? Ist es nicht. Performance, Skalierbarkeit und Datenqualität hängen daran.

Der Trend 2025 geht klar zu ELT-Architekturen: Rohdaten werden schnell und unverändert gespeichert, Transformationen laufen dann zentralisiert, versioniert und automatisiert ab – häufig mit dbt, Spark oder cloudbasierten Engines. Das ermöglicht Rollbacks, Auditing und eine vollständige Nachvollziehbarkeit der Datenhistorie. Wer noch mit klassischen ETL-Prozessen auf Legacy-Datenbanken herumdoktert, verschenkt Innovationspotenzial und legt sich selbst Steine in den Weg.

Eine moderne Data Pipeline im Data Engineering Modell folgt immer bestimmten Prinzipien:

- Automatisierte Extraktion aus Quellsystemen (Batch oder Streaming)

- Datenvalidierung und -qualitätschecks auf jeder Stufe

- Transformationen, Cleansing und Enrichment über versionierte Skripte

- Persistenz im Data Lake oder Warehouse

- Monitoring, Logging und automatisierte Fehlerbehandlung

- Automatisierte Bereitstellung für AnalyticsAnalytics: Die Kunst, Daten in digitale Macht zu verwandeln Analytics – das klingt nach Zahlen, Diagrammen und vielleicht nach einer Prise Langeweile. Falsch gedacht! Analytics ist der Kern jeder erfolgreichen Online-Marketing-Strategie. Wer nicht misst, der irrt. Es geht um das systematische Sammeln, Auswerten und Interpretieren von Daten, um digitale Prozesse, Nutzerverhalten und Marketingmaßnahmen zu verstehen, zu optimieren und zu skalieren...., BI, Machine LearningMachine Learning: Algorithmische Revolution oder Buzzword-Bingo? Machine Learning (auf Deutsch: Maschinelles Lernen) ist der Teilbereich der künstlichen Intelligenz (KI), bei dem Algorithmen und Modelle entwickelt werden, die aus Daten selbstständig lernen und sich verbessern können – ohne dass sie explizit programmiert werden. Klingt nach Science-Fiction, ist aber längst Alltag: Von Spamfiltern über Gesichtserkennung bis zu Produktempfehlungen basiert mehr digitale Realität... oder operative Systeme

Wer diese Pipeline nicht vollautomatisiert und modular aufsetzt, erstickt früher oder später an manuellen Workarounds, Dateninkonsistenzen und fehlender Transparenz. Das Data Engineering Modell ist kein statisches Konstrukt – es lebt von kontinuierlicher Verbesserung und Automatisierung.

Automatisierung, DataOps & Monitoring: Das Data Engineering Modell als Dauerbaustelle

Wer glaubt, mit dem Aufbau einer Datenpipeline sei es getan, hat den Schuss nicht gehört. Das Data Engineering Modell ist ein Prozess – kein Projekt auf Zeit. Die technische Realität 2025 ist, dass Datenvolumen, Quellen und Anforderungen permanent wachsen. Ohne Automatisierung, DataOps und kontinuierliches Monitoring läuft jede Datenarchitektur früher oder später gegen die Wand.

DataOps ist das technische Bindeglied zwischen klassischem Data Engineering und agiler Softwareentwicklung. Es steht für automatisiertes Testing, Versionierung, kontinuierliche Integration und Deployment von Datenpipelines. Tools wie dbt, Airflow und GitHub Actions sind hier Pflicht, nicht Kür. Wer DataOps ignoriert, baut technische Schulden in Lichtgeschwindigkeit auf – und kann am Ende nichts mehr nachvollziehen oder reproduzieren.

Monitoring ist der Rettungsanker jeder Datenplattform. Ohne vollautomatisiertes Logging, Alerting und Fehlererkennung ist jede Datenpipeline ein Blindflug. Moderne Monitoring-Tools wie Prometheus, Grafana oder ELK-Stacks sorgen für Echtzeit-Transparenz – und sind die einzige Chance, Fehler zu erkennen, bevor der CFO auf das falsche Reporting schaut.

Automatisierung ist der Turbo im Data Engineering Modell: Jede Pipeline, jeder WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz..., jeder Test muss “as code” abgebildet und versioniert werden. Das minimiert Fehler, schafft Klarheit und sorgt dafür, dass die Plattform auch nach fünf Jahren noch wartbar ist – und nicht zur digitalen Geisterstadt mutiert.

Schritt-für-Schritt: So implementierst du ein skalierbares Data Engineering Modell

Die Theorie ist schön, aber die Praxis ist gnadenlos. Hier kommt der brutale Realitätscheck für alle, die ein Data Engineering Modell nicht nur verstehen, sondern auch umsetzen wollen. Die folgende Schritt-für-Schritt-Anleitung bringt dich systematisch von der Datensuppe zur Datenplattform mit echtem Mehrwert:

- 1. Datenstrategie und Ziele klären

- Definiere, welche Daten für welche Use Cases benötigt werden.

- Lege Verantwortlichkeiten und Governance-Regeln fest.

- 2. Quellsysteme und Datenflüsse analysieren

- Erstelle ein vollständiges Mapping aller Datenquellen und -senken.

- Identifiziere Schwachstellen und Engpässe.

- 3. Architektur-Blueprint entwerfen

- Wähle passende Storage-Layer (Lake, Warehouse) und Integrations-Tools.

- Definiere Transformations- und Serving Layer.

- 4. Datenintegration automatisieren

- Setze ETL/ELT-Prozesse mit Airflow, Fivetran oder eigenen Skripten auf.

- Sorge für Monitoring und Alerting von Anfang an.

- 5. Transformation und Qualitätssicherung

- Nutzt dbt oder Spark für Transformationen und Data Quality Checks.

- Automatisiere Tests und Versionierung.

- 6. Bereitstellung und Self-Service etablieren

- Richte APIs, Data Marts oder Dashboards ein.

- Schaffe Self-Service-Zugänge für Analysten und Data Scientists.

- 7. DataOps und Monitoring implementieren

- Integriere CI/CD für Datenpipelines.

- Setze Monitoring, Logging und Alerting mit Prometheus, Grafana, ELK ein.

- 8. Skalierung und Optimierung

- Automatisiere das Ressourcen-Management für wachsende Datenvolumina.

- Optimiere Kosten und Performance kontinuierlich.

- 9. Dokumentation und Compliance sicherstellen

- Stelle Data Lineage, Zugriffsrechte und Audit-Trails sicher.

- 10. Kontinuierliche Verbesserung und Review

- Führe regelmäßige Architektur- und Security-Reviews durch.

- Passe die Plattform an neue Use Cases und Technologien an.

Fazit: Ohne Data Engineering Modell bleibt dein Unternehmen im Blindflug

Das Data Engineering Modell ist kein Hype, sondern die absolute Grundvoraussetzung für datengetriebene Unternehmen. Wer 2025 noch glaubt, mit ein paar ETL-Skripten, einem Data Warehouse und etwas Glück auszukommen, spielt mit seiner digitalen Existenz. Es geht um Kontrolle, Automatisierung, Skalierbarkeit – und vor allem um die Fähigkeit, aus Daten echten Wert zu generieren. Ohne ein durchdachtes, automatisiertes Data Engineering Modell bleibt Innovation ein Zufallsprodukt – und jede neue Data-Initiative endet im nächsten Datenchaos.

Wer die beschriebenen Prinzipien, Tools und Best Practices ignoriert, verbrennt Geld, Zeit und Nerven – und liefert sich im digitalen Wettbewerb der Konkurrenz aus. Es ist Zeit, die Datenströme endlich clever zu meistern. Nicht mit PowerPoint, sondern mit echter technischer Kompetenz, Automatisierung und gnadenloser Transparenz. Das Data Engineering Modell ist das Rückgrat jeder modernen Organisation. Wer das nicht begreift, bleibt im Blindflug – und wird abgehängt. Willkommen bei der Wahrheit. Willkommen bei 404.