Data Pipeline Architektur: Clever, Skalierbar, Zukunftssicher

Jeder spricht von Künstlicher Intelligenz, Big DataBig Data: Datenflut, Analyse und die Zukunft digitaler Entscheidungen Big Data bezeichnet nicht einfach nur „viele Daten“. Es ist das Buzzword für eine technologische Revolution, die Unternehmen, Märkte und gesellschaftliche Prozesse bis ins Mark verändert. Gemeint ist die Verarbeitung, Analyse und Nutzung riesiger, komplexer und oft unstrukturierter Datenmengen, die mit klassischen Methoden schlicht nicht mehr zu bändigen sind. Big Data... und AnalyticsAnalytics: Die Kunst, Daten in digitale Macht zu verwandeln Analytics – das klingt nach Zahlen, Diagrammen und vielleicht nach einer Prise Langeweile. Falsch gedacht! Analytics ist der Kern jeder erfolgreichen Online-Marketing-Strategie. Wer nicht misst, der irrt. Es geht um das systematische Sammeln, Auswerten und Interpretieren von Daten, um digitale Prozesse, Nutzerverhalten und Marketingmaßnahmen zu verstehen, zu optimieren und zu skalieren.... – aber die Wahrheit ist: Ohne eine saubere, skalierbare Data Pipeline Architektur bleibt dein ganzes Datenprojekt ein Luftschloss. Datenberge wachsen schneller als deine To-Do-Liste, und wer seine Pipeline nicht im Griff hat, läuft direkt in die Sackgasse aus Chaos, Kosten und Komplexität. In diesem Artikel bekommst du den schonungslos ehrlichen Deep Dive in alles, was 2024 und darüber hinaus eine wirklich zukunftssichere Data Pipeline Architektur ausmacht. Spoiler: Hier gibt’s keine Buzzwords, sondern echten technischen Durchblick. Zeit, die rosarote Brille abzulegen – und die Datenflut in den Griff zu bekommen.

- Was eine Data Pipeline Architektur wirklich ist – und warum jeder sie falsch versteht

- Die wichtigsten Komponenten und Patterns für eine skalierbare Datenarchitektur

- Batch vs. Stream Processing: Welche Data Pipeline Strategie wann gewinnt

- Typische Fehler in der Data Pipeline Architektur – und wie du sie vermeidest

- Wichtige Tools, Frameworks und Cloud-Dienste für Data Pipelines in 2024

- Wie du Data Quality, Monitoring und Fehlerbehandlung zukunftssicher umsetzt

- Security, Compliance und Governance – die ungeliebten, aber entscheidenden Faktoren

- Schritt-für-Schritt-Anleitung für eine moderne Data Pipeline Architektur

- Warum Data Engineers und Marketing-Teams nie die gleiche Sprache sprechen (aber müssen)

- Fazit: Was eine clevere, skalierbare, zukunftssichere Data Pipeline Architektur wirklich ausmacht

Data Pipeline Architektur – klingt nach Raketenwissenschaft, ist aber das Fundament jeder datengetriebenen Organisation. Wer 2024 immer noch glaubt, man könne einfach ein paar Datenbanken zusammenstöpseln, hat das Spiel nicht verstanden. Die Hauptprobleme sind immer gleich: Datenvolumen explodiert, Anforderungen wandeln sich, und die Infrastruktur muss liefern, bevor der nächste Hype schon wieder den Stecker zieht. Die clevere, skalierbare, zukunftssichere Data Pipeline Architektur ist kein nettes Extra, sondern der Unterschied zwischen Daten-ROI und digitalem Burnout. In diesem Artikel erfährst du, was wirklich zählt – und warum 90% aller Data-Projekte an ihrer Pipeline scheitern.

Was ist eine Data Pipeline Architektur wirklich? Hauptkeyword, Fehlerquellen und Missverständnisse

Bevor wir uns in Buzzwords wie “Serverless”, “Event-Driven” oder “Data Lakehouse” verlieren: Was bedeutet Data Pipeline Architektur überhaupt? Kurz gesagt: Es ist das technische Grundgerüst, das dafür sorgt, dass Daten von A nach B gelangen – zuverlässig, skalierbar und nachvollziehbar. Klingt simpel? Die Realität sieht anders aus. Eine Data Pipeline Architektur umfasst alle Prozesse, Komponenten und Schnittstellen, die notwendig sind, um Rohdaten aus Quellsystemen zu extrahieren, zu transformieren, zu laden und für Analysen bereitzustellen. Das Kürzel ETL (Extract, Transform, Load) ist dabei nur der Anfang. Moderne Architekturen gehen längst darüber hinaus.

Die Hauptkeyword Data Pipeline Architektur wird heute in fast jedem Unternehmen missverstanden. Viele meinen damit einen simplen ETL-Job, der nachts Daten aus einer SQL-Datenbank in ein Data Warehouse schaufelt. Aber Skalierbarkeit? Fehlanzeige. Zukunftssicherheit? Nur auf dem Papier. Die Data Pipeline Architektur muss heute in der Lage sein, mit explodierenden Datenmengen, verteilten Systemen, verschiedenen Datenformaten (strukturiert, semi-strukturiert, unstrukturiert) und immer neuen Anforderungen aus Business und Compliance klarzukommen. Wer hier mit veralteten Batch-Jobs hantiert, kann die Uhr zurückdrehen – und beim nächsten Daten-Desaster zusehen.

Typische Fehlerquellen in der Data Pipeline Architektur sind Redundanzen, fehlende Modularität, mangelnde Überwachung und fehlende Automatisierung. Eine schlecht designte Data Pipeline ist wie ein maroder Wasserrohr: Sie leckt, stottert und macht irgendwann alles kaputt. Die Folge: Datenverluste, Inkonsistenzen, Frust bei Analysten und Entwicklern – und am Ende ein teurer Neuaufbau. Deshalb: Wer Data Pipeline Architektur clever, skalierbar und zukunftssicher aufziehen will, muss die Prinzipien moderner Systemarchitektur verstehen. Und bereit sein, alte Zöpfe abzuschneiden.

Die Data Pipeline Architektur ist viel mehr als die Summe ihrer Teile. Sie ist das Rückgrat jeder Analytics-, Machine Learning- oder AI-Initiative. Ohne sie bleibt alles andere Marketing-Blabla. Und wer glaubt, mit ein bisschen Cloud und einem schicken DashboardDashboard: Die Kommandozentrale für Daten, KPIs und digitale Kontrolle Ein Dashboard ist weit mehr als ein hübsches Interface mit bunten Diagrammen – es ist das digitale Cockpit, das dir in Echtzeit den Puls deines Geschäfts, deiner Website oder deines Marketings zeigt. Dashboards visualisieren komplexe Datenströme aus unterschiedlichsten Quellen und machen sie sofort verständlich, steuerbar und nutzbar. Egal ob Webanalyse, Online-Marketing,... sei es getan, sollte sich besser auf eine böse Überraschung gefasst machen. Der einzige Weg zu einer cleveren, skalierbaren und zukunftssicheren Data Pipeline Architektur führt über knallharte Technik, ehrliche Analyse und konsequente Automatisierung.

Komponenten und Patterns für skalierbare Data Pipeline Architekturen: Von ETL bis Event-Streaming

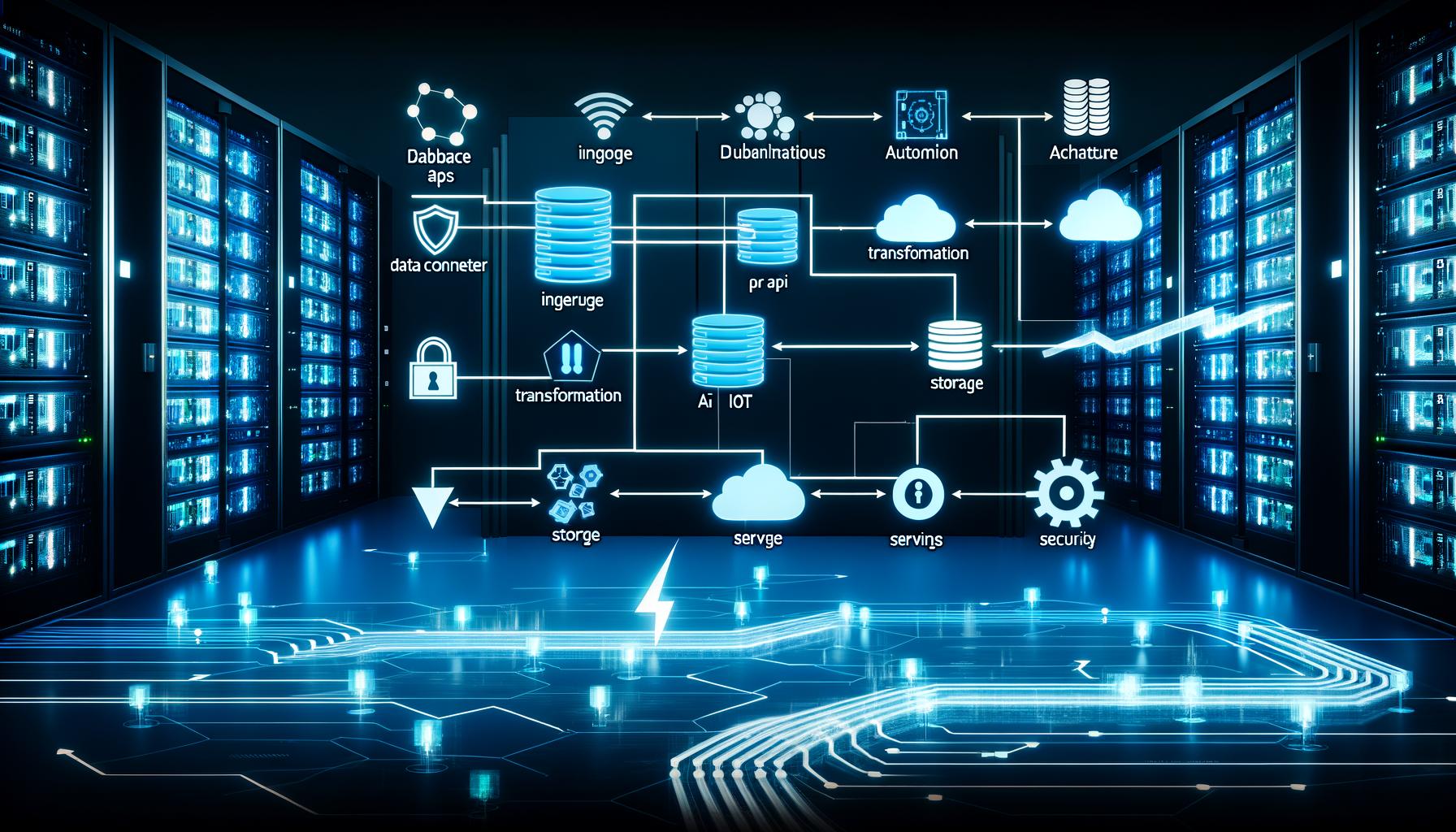

Eine solide Data Pipeline Architektur besteht aus klar definierten Komponenten. Wer glaubt, ein paar Python-Skripte reichten aus, wird schnell Opfer der eigenen Naivität. Die Kernkomponenten sind:

- Source Connectors: Adapter, die Daten aus verschiedenen Quellsystemen extrahieren – von relationalen Datenbanken über REST-APIs bis zu IoT-Streams.

- Ingestion Layer: Der Eintrittspunkt für Daten. Hier entscheidet sich, ob per Batch, Micro-Batch oder Stream (Stichwort: Apache Kafka, AWS Kinesis) gearbeitet wird.

- Transformation Layer: Ort der Datenbereinigung, Anreicherung und Standardisierung. Klassische ETL-Tools (Talend, Informatica) konkurrieren mit modernen Frameworks wie dbt oder Apache Beam.

- Storage Layer: Hier landen die Daten – oft redundant – in Data Warehouses (Snowflake, BigQuery), Data Lakes (S3, Azure Data Lake), oder Lakehouses (Databricks Delta Lake).

- Orchestration Layer: Steuerzentrale der Pipeline. Workflows werden per Apache Airflow, Prefect oder Managed Services automatisiert, überwacht und getriggert.

- Serving Layer: Schnittstelle zu AnalyticsAnalytics: Die Kunst, Daten in digitale Macht zu verwandeln Analytics – das klingt nach Zahlen, Diagrammen und vielleicht nach einer Prise Langeweile. Falsch gedacht! Analytics ist der Kern jeder erfolgreichen Online-Marketing-Strategie. Wer nicht misst, der irrt. Es geht um das systematische Sammeln, Auswerten und Interpretieren von Daten, um digitale Prozesse, Nutzerverhalten und Marketingmaßnahmen zu verstehen, zu optimieren und zu skalieren...., Machine LearningMachine Learning: Algorithmische Revolution oder Buzzword-Bingo? Machine Learning (auf Deutsch: Maschinelles Lernen) ist der Teilbereich der künstlichen Intelligenz (KI), bei dem Algorithmen und Modelle entwickelt werden, die aus Daten selbstständig lernen und sich verbessern können – ohne dass sie explizit programmiert werden. Klingt nach Science-Fiction, ist aber längst Alltag: Von Spamfiltern über Gesichtserkennung bis zu Produktempfehlungen basiert mehr digitale Realität... oder Daten-APIs. Hier werden Datenmodelle bereitgestellt, Queries ausgeführt und Dashboards befüllt.

Das Ganze funktioniert nur, wenn die Komponenten sauber getrennt sind – und über definierte Schnittstellen (APIs, Message Queues, Storage Buckets) miteinander kommunizieren. Monolithische Architekturen sind der Tod jeder Skalierung. Deshalb setzen moderne Data Pipeline Architekturen auf Microservices, Containerisierung (Docker, Kubernetes) und Infrastructure as Code (Terraform, CloudFormation).

Ein zukunftssicheres Pattern ist das Lambda Architecture Modell: Es kombiniert Batch- und Stream Processing, um sowohl historische als auch Echtzeitdaten effizient zu verarbeiten. Wer noch einen drauflegen will, schaut sich Kappa Architecture an – ein Pattern, das komplett auf Streaming setzt und Batch als Legacy betrachtet. Der Unterschied: Lambda ist flexibel, aber komplex; Kappa ist agil, aber nicht immer für alle Use Cases geeignet. Die Wahl des richtigen Patterns entscheidet über Erfolg oder Scheitern deiner Data Pipeline Architektur.

Fehlt eine Komponente oder ist sie zu eng mit anderen verknüpft? Dann wird aus Skalierung schnell Chaos. Deshalb: Baue deine Data Pipeline Architektur so modular wie möglich. Nur so kannst du einzelne Teile austauschen, Upgrades einspielen und neue Anforderungen ohne Komplettabriss integrieren.

Batch vs. Stream Processing: Die Data Pipeline Architektur im Realitätscheck

“Wir machen alles in Echtzeit!” – klingt gut im Pitch, ist aber in der Praxis oft eine Lüge. Die Wahrheit: Batch Processing ist immer noch der Standard in vielen Data Pipeline Architekturen. Warum? Weil es einfach, robust und für viele Reporting-Usecases völlig ausreichend ist. Jede Nacht ein ETL-Job, der die Datenbank füllt – fertig. Bis die Anforderungen wachsen und die Datenmengen explodieren. Dann fängt das Drama an: Latenz, Engpässe, Warteschlangen, Frust.

Stream Processing ist das Zauberwort in der modernen Data Pipeline Architektur. Hier werden Daten in Echtzeit verarbeitet – Events fließen kontinuierlich durch das System, werden transformiert und stehen sofort zur Verfügung. Technologien wie Apache Kafka, Flink oder Google Dataflow sind die Basis. Der Vorteil: Aktuelle Analysen, sofortige Reaktionsfähigkeit, perfekte Grundlage für Machine LearningMachine Learning: Algorithmische Revolution oder Buzzword-Bingo? Machine Learning (auf Deutsch: Maschinelles Lernen) ist der Teilbereich der künstlichen Intelligenz (KI), bei dem Algorithmen und Modelle entwickelt werden, die aus Daten selbstständig lernen und sich verbessern können – ohne dass sie explizit programmiert werden. Klingt nach Science-Fiction, ist aber längst Alltag: Von Spamfiltern über Gesichtserkennung bis zu Produktempfehlungen basiert mehr digitale Realität... und Personalisierung. Der Nachteil: Komplexität, Kosten, und ein deutlich höherer Anspruch an das Systemdesign.

Welcher Ansatz ist die richtige Data Pipeline Architektur für dein Projekt? Die Antwort ist (leider) wie immer: Es kommt darauf an. Batch ist stabil, günstig und erprobt – perfekt für klassische Reporting- und BI-Anwendungen. Stream Processing ist unverzichtbar für Echtzeit-Analytics, Fraud Detection, Recommendation Engines oder IoT. Wer clever ist, baut seine Data Pipeline Architektur hybrid: Batch für Backlog und Historie, Streaming für alles, was Geschwindigkeit braucht. Das ist nicht nur zukunftssicher, sondern auch effizient – vorausgesetzt, du beherrschst beide Welten technisch.

- Batch Processing: Periodische Datenverarbeitung, robust, günstige Infrastruktur, klassische ETL-Tools.

- Stream Processing: Kontinuierliche Datenflüsse, niedrige Latenz, Event-Driven Design, komplexeres Monitoring, höhere Anforderungen an Skalierung und Fehlerhandling.

- Hybrid: Kombination beider Welten, maximale Flexibilität, aber auch erhöhter Wartungsaufwand.

Am Ende entscheidet die Architektur, wie skalierbar, clever und zukunftssicher deine Data Pipeline wirklich ist. Und wer glaubt, mit einem Ansatz alles zu erschlagen, wird schnell von der Realität eingeholt.

Typische Fehler in der Data Pipeline Architektur – und wie du sie clever vermeidest

Die größte Schwäche moderner Data Pipeline Architekturen ist nicht die Technik – sondern der Mensch. Fehlendes Verständnis für Datenflüsse, Kopieren von “Best Practices” ohne Kontext, und das Ignorieren von Monitoring und Data Quality sind die klassischen Fehler. Hier kommen die häufigsten Stolperfallen und wie du sie vermeidest:

- Fehlende Modularität: Monolithische ETL-Jobs, die alles können (und nichts richtig). Lösung: Microservices und lose Kopplung per APIs und Message Queues.

- Kein zentrales Monitoring: Wer nicht sieht, was in seiner Pipeline passiert, merkt Fehler oft erst, wenn es zu spät ist. Lösung: Prometheus, Grafana, Stackdriver oder AWS CloudWatch zur Überwachung aller Komponenten einsetzen.

- Keine Fehlerbehandlung und Retry-Strategien: Daten gehen verloren, Jobs crashen – und niemand merkt’s. Lösung: Dead Letter Queues, Idempotenz-Prinzipien, und automatische Retries einbauen.

- Hardcodierte Konfigurationen: Jede Änderung im Source-System braucht einen Code-Deploy. Lösung: Konfigurationsmanagement mit YAML, JSON, oder zentralen Service-Registern.

- Fehlende Data Quality Checks: “Garbage in, garbage out” ist hier keine Floskel. Lösung: Automatisierte Tests und Validierungen (Great Expectations, Deequ) direkt in die Pipeline einbauen.

Die cleverste Data Pipeline Architektur ist die, die Fehler früh erkennt, Prozesse automatisch neu startet und Datenqualität von Anfang bis Ende sicherstellt. Wer hier spart, zahlt später doppelt – mit Datenverlust, Frust und steigenden Betriebskosten. Zukunftssicher wird deine Architektur erst, wenn Monitoring, Tests und Self-Healing nicht nachträglich, sondern von Anfang an konzipiert sind.

Ein weiteres Problem: Die völlige Ignoranz gegenüber Security und Compliance. Wer personenbezogene oder sensible Daten über offene Kanäle schickt, kann sich schon mal auf die nächste Datenschutzklage vorbereiten. Encryption at Rest, Encryption in Transit, Zugriffsmanagement, Audit Trails – alles Pflicht, nichts Kür. Und ja, auch das ist Teil einer wirklich zukunftssicheren Data Pipeline Architektur.

Tools, Frameworks und Cloud-Dienste: Das Rückgrat cleverer Data Pipeline Architekturen

Wer 2024 noch alles “on-premise” baut, hat entweder zu viel Geld oder zu wenig Fantasie. Die Realität: Cloud-basierte Data Pipeline Architekturen sind heute Standard. Sie bieten Skalierbarkeit, Flexibilität und eine riesige Auswahl an Tools. Aber: Wer einfach nur den “Lift & Shift” macht, bekommt nur die alten Probleme in der neuen Umgebung. Deshalb hier die wichtigsten Bausteine für eine zeitgemäße Data Pipeline Architektur:

- Ingestion & Streaming: Apache Kafka, AWS Kinesis, Google Pub/Sub, Azure Event Hubs

- ETL/ELT-Frameworks: Apache Airflow, Prefect, dbt, Talend, Informatica

- Transformations-Engines: Apache Beam, Spark, Databricks, Google Dataflow

- Data Storage: Snowflake, BigQuery, Redshift, S3, Azure Data Lake, Databricks Delta Lake

- Monitoring & Observability: Prometheus, Grafana, AWS CloudWatch, Stackdriver, DataDog

- Data Quality: Great Expectations, Deequ, Monte Carlo Data

- Orchestration: Apache Airflow, Prefect, Managed Workflows (AWS Step Functions, Google Cloud Composer)

Die Wahl der Tools entscheidet über Geschwindigkeit, Zuverlässigkeit und Zukunftssicherheit deiner Data Pipeline Architektur. Wer proprietäre Blackbox-Lösungen kauft, macht sich abhängig und verliert Flexibilität. Wer alles Open Source macht, muss Zeit für Wartung, Security und Upgrades einplanen. Die Kunst liegt im Mix: Managed Services für Skalierung und Wartung, Open Source für Flexibilität und Kontrolle. Und immer dran denken: Architektur schlägt Tool-Auswahl. Wenn das Grunddesign Mist ist, helfen auch die besten Tools nichts.

Ein Tipp aus der Praxis: Keine Data Pipeline Architektur ohne Infrastructure as Code. Terraform, CloudFormation oder Pulumi sorgen dafür, dass deine Infrastruktur versionierbar, reproduzierbar und automatisierbar bleibt. Nur so bist du wirklich skalierbar – und kannst bei Bedarf in Minuten neue Umgebungen hochziehen oder Änderungen ausrollen, ohne den nächsten Daten-GAU zu riskieren.

Schritt-für-Schritt-Anleitung: Clever, skalierbar, zukunftssicher – so baust du deine Data Pipeline Architektur auf

Technik und Theorie sind das eine – Umsetzung das andere. Hier kommt der Step-by-Step-Plan, wie du deine Data Pipeline Architektur von Anfang an clever, skalierbar und zukunftssicher konzipierst:

- Anforderungen sammeln: Welche Datenquellen, Datenvolumen, Latenzanforderungen, Compliance-Vorgaben?

- Architektur-Pattern wählen: Batch, Stream oder Hybrid? Lambda vs. Kappa? Entscheidung immer auf Basis des Use Cases treffen.

- Komponenten modular planen: Source Connector, Ingestion, Transformation, Storage, Serving. Klare Schnittstellen, keine harten Abhängigkeiten.

- Tool-Stack evaluieren: Cloud vs. On-Premise, Open Source vs. Managed Services. Infrastruktur als Code von Anfang an implementieren.

- Automatisierung einbauen: Orchestration-Tools für Jobs und Workflows, Self-Healing für kritische Komponenten, CI/CD für Deployments.

- Data Quality und Monitoring: Validierungs- und Test-Frameworks direkt in die Pipeline integrieren, Observability von Source bis DashboardDashboard: Die Kommandozentrale für Daten, KPIs und digitale Kontrolle Ein Dashboard ist weit mehr als ein hübsches Interface mit bunten Diagrammen – es ist das digitale Cockpit, das dir in Echtzeit den Puls deines Geschäfts, deiner Website oder deines Marketings zeigt. Dashboards visualisieren komplexe Datenströme aus unterschiedlichsten Quellen und machen sie sofort verständlich, steuerbar und nutzbar. Egal ob Webanalyse, Online-Marketing,....

- Sicherheit und Compliance: Verschlüsselung, Zugriffskontrolle, Audit Logs, DSGVO & Co. frühzeitig berücksichtigen.

- Iterativ ausbauen: Mit einem MVP starten, Datenflüsse nach und nach erweitern, Feedback-Schleifen einplanen, Architektur anpassen.

Jeder Schritt ist entscheidend. Wer eine Komponente überspringt, riskiert spätere Umbauten, Kostenexplosionen oder Totalausfälle. Clever ist, wer Fehler früh erkennt und Architektur als fortlaufenden Prozess – nicht als einmaliges Projekt – betrachtet. Skalierbar ist, wer modular, automatisiert und cloud-fähig baut. Und zukunftssicher ist, wer auf Monitoring, Data Quality und Security nicht erst am Ende, sondern von Anfang an setzt.

Am Ende zählt: Eine Data Pipeline Architektur ist immer nur so gut wie ihr schwächstes Glied. Und das ist meist nicht der Code, sondern die fehlende Planung, Überwachung und Fehlerbehandlung. Sei schlauer als dein Vorgänger – und baue deine Data Pipeline Architektur clever, skalierbar und zukunftssicher.

Fazit: Data Pipeline Architektur – der echte Gamechanger im datengetriebenen Unternehmen

Wer 2024 und darüber hinaus im datengetriebenen Geschäft vorne mitspielen will, muss eine Data Pipeline Architektur bauen, die nicht nur heute, sondern auch morgen und übermorgen funktioniert. Das heißt: Modularität, Automatisierung, Monitoring und Security sind keine netten Add-ons, sondern Pflichtprogramm. Alles andere ist Daten-Roulette – und endet garantiert in Frust, Kosten und dem nächsten Re-Design.

Die clevere, skalierbare, zukunftssichere Data Pipeline Architektur ist der Schlüssel zu echtem Daten-ROI. Sie macht aus rohen, chaotischen Daten wertvolle Assets, sorgt für Geschwindigkeit, Flexibilität und Compliance – und lässt sich an neue Anforderungen ohne Angst vor dem System-GAU anpassen. Wer das nicht versteht, bleibt im Datennebel stecken. Also: Architektur zuerst, Tools danach. Und niemals den Fehler machen, auf Monitoring, Data Quality oder Security zu verzichten. Willkommen in der Realität. Willkommen bei 404.