Data Pipeline Stack: Effiziente Datenströme für Profis

Du glaubst, ein paar ETL-Skripte und kostenlose Cloud-Tools machen aus deinem Datenchaos plötzlich einen performanten Data Lake? Denk nochmal nach. Der moderne Data Pipeline Stack ist längst kein Hobbyprojekt für gelangweilte Entwickler mehr, sondern die brutale Realität für alle, die im Daten-Dschungel 2025 nicht untergehen wollen. In diesem Artikel zerlegen wir sämtliche Mythen, erklären, was wirklich zählt, und liefern dir die schonungslose Anleitung für effiziente Datenströme auf Enterprise-Niveau – ohne Bullshit, aber mit maximaler technischer Tiefe.

- Was ein moderner Data Pipeline Stack wirklich ist – und warum ETL allein nicht mehr reicht

- Die wichtigsten Komponenten für effiziente Datenströme im Jahr 2025

- Batch, Streaming, Orchestration: Welche Architektur wann Sinn ergibt

- Warum Data Quality, Observability und Monitoring keine “nice-to-have” Features sind

- Die Auswahl zwischen Open Source, Cloud-Services und Hybrid-Stacks – mit Klartext zu Risiken und Kosten

- Schritt-für-Schritt-Anleitung: Aufbau eines skalierbaren Data Pipeline Stack für Profis

- Welche Tools wirklich performen – und welche du sofort vergessen kannst

- Wie du Compliance, DatenschutzDatenschutz: Die unterschätzte Macht über digitale Identitäten und Datenflüsse Datenschutz ist der Begriff, der im digitalen Zeitalter ständig beschworen, aber selten wirklich verstanden wird. Gemeint ist der Schutz personenbezogener Daten vor Missbrauch, Überwachung, Diebstahl und Manipulation – egal ob sie in der Cloud, auf Servern oder auf deinem Smartphone herumlungern. Datenschutz ist nicht bloß ein juristisches Feigenblatt für Unternehmen, sondern... und Security im Data Pipeline Stack nicht an die Wand fährst

- Ein kritischer Blick auf die größten Fehler – und wie du sie garantiert vermeidest

- Fazit: Warum ohne durchdachten Data Pipeline Stack auch dein AI-Hype nur Datenmüll produziert

Vergiss die fetten Buzzwords, die dir jeder zweite Berater um die Ohren haut: “Data-Driven”, “AI-ready”, “360° Data View”. Ohne einen sauberen, performanten und robusten Data Pipeline Stack bleibt dein ganzes Data Engineering ein Kartenhaus – und das fällt schneller zusammen, als du “Realtime AnalyticsAnalytics: Die Kunst, Daten in digitale Macht zu verwandeln Analytics – das klingt nach Zahlen, Diagrammen und vielleicht nach einer Prise Langeweile. Falsch gedacht! Analytics ist der Kern jeder erfolgreichen Online-Marketing-Strategie. Wer nicht misst, der irrt. Es geht um das systematische Sammeln, Auswerten und Interpretieren von Daten, um digitale Prozesse, Nutzerverhalten und Marketingmaßnahmen zu verstehen, zu optimieren und zu skalieren....” sagen kannst. Die Zeit, in der man mit ein paar Bash-Skripten, Airflow und einem halbherzigen S3-Bucket echte Businessprobleme lösen konnte, ist vorbei. Heute entscheidet die Qualität deines Data Pipeline Stack darüber, ob du aus Daten echten Mehrwert ziehst – oder nur Kosten und Kopfschmerzen produzierst.

In diesem Artikel zerlegen wir nicht nur den Begriff “Data Pipeline Stack” und alle seine technischen Facetten, sondern erklären dir auch, warum jedes einzelne Glied in der Kette – von Ingestion über Transformation bis Monitoring – kritisch ist. Wir reden nicht über die Basics, sondern über das, was heute wirklich zählt: Skalierbarkeit, Ausfallsicherheit, Automatisierung, Datenqualität, Security und Compliance. Denn im Jahr 2025 ist dein Data Pipeline Stack nicht nur das Rückgrat deiner Datenstrategie – er ist der Unterschied zwischen Datenkompetenz und digitaler Mittelmäßigkeit.

Wenn du nach Ausreden suchst, warum dein Data Lake voller Dubletten, Inkonsistenzen und Performance-Problemen ist – klick weiter. Wenn du wissen willst, wie du effiziente Datenströme für Profis aufbaust, die auch im Ernstfall nicht auseinanderfliegen, bist du hier richtig. Willkommen im Maschinenraum von 404.

Data Pipeline Stack: Definition, Architektur und die wichtigsten SEO-Keywords

Der Begriff Data Pipeline Stack wird gerne inflationär benutzt, doch in der Praxis haben die wenigsten Unternehmen einen wirklichen Plan, was dahintersteckt. Ein moderner Data Pipeline Stack ist mehr als nur “ETL” (Extract, Transform, Load) auf Steroiden. Er ist das technologische Fundament, das sämtliche Datenströme – von der Rohdaten-Ingestion bis zum analytisch nutzbaren Data Warehouse – zuverlässig, skalierbar und nachvollziehbar orchestriert. Die wichtigsten SEO-Schlüsselwörter in diesem Kontext: Data Pipeline Stack, Datenströme, ETL, Data Ingestion, Data Orchestration, Realtime Processing, Data Lake, Data Warehouse, Observability, Data Governance.

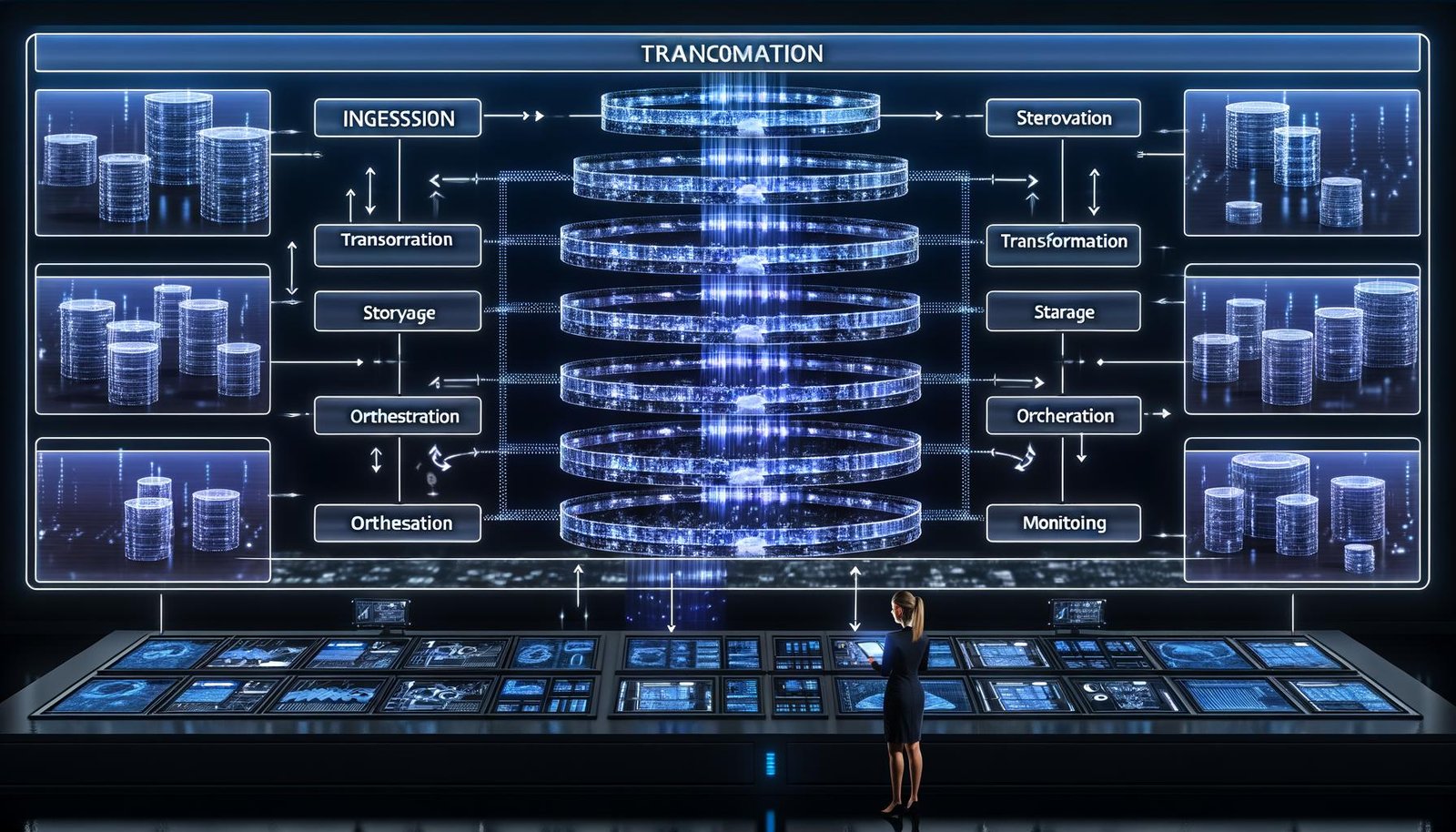

Ein typischer Data Pipeline Stack besteht aus mehreren Schichten, die jeweils spezifische Aufgaben erfüllen. Am Anfang steht die Data Ingestion – der Prozess, bei dem Daten aus unterschiedlichsten Quellen (APIs, Datenbanken, Sensoren, Drittanbieter-Feeds) eingesammelt werden. Darauf folgen die Transformationsschichten: Hier werden Daten bereinigt, normalisiert, angereichert und in ein einheitliches Schema gebracht. Erst danach landen sie im Storage – meist in Form von Data Warehouses, Data Lakes oder hybriden Speichern (Lakehouse). Was viele vergessen: Ohne saubere Orchestration – sprich, die Steuerung und das Monitoring aller beteiligten Prozesse – ist dein Stack nicht mehr als ein lose verkabeltes Experiment.

Data Pipeline Stack ist also kein Tool, sondern ein ganzes Ökosystem aus Technologien, Schnittstellen und Prozessen. Und genau das macht den Aufbau so anspruchsvoll. Wer glaubt, eine “Pipeline” in Apache NiFi oder eine Glue-Job-Chain in AWS reicht für Enterprise-Ansprüche, hat das Problem nicht verstanden. Im Jahr 2025 erwarten Stakeholder und Regulatoren nicht nur Geschwindigkeit und Flexibilität, sondern auch lückenlose Auditability, Security und Compliance auf höchstem Niveau.

Der Data Pipeline Stack ist damit der zentrale Hebel für alle, die aus Daten echten Business Value generieren wollen. Und das geht nur, wenn jede Ebene – von der Integration bis zur Observability – sauber, robust und skalierbar aufgebaut ist. Fangen wir an, die wichtigsten Komponenten auseinanderzunehmen.

Die Schlüsselkomponenten eines effizienten Data Pipeline Stack: Mehr als ETL und ein paar Cronjobs

Wer beim Data Pipeline Stack nur an klassische ETL-Tools denkt, hat schon verloren. Moderne Datenströme erfordern ein deutlich differenzierteres Setup. Die wichtigsten Komponenten im Data Pipeline Stack sind:

- Data Ingestion Layer: Hier erfolgt das Einsammeln von Rohdaten. Moderne Lösungen setzen auf CDC (Change Data Capture), Event-Streaming (z.B. Apache Kafka, AWS Kinesis) und API-Integration.

- Transformation Layer: In dieser Stufe werden Daten bereinigt, transformiert und angereichert – klassisch per ETL/ELT (z.B. dbt, Talend, Spark) oder mit Streaming-Frameworks wie Flink oder Kafka Streams.

- Storage Layer: Abgelegt wird im Data Warehouse (Snowflake, BigQuery, Redshift), Data Lake (S3, Azure Data Lake, HDFS) oder Lakehouse (Databricks Delta Lake, Apache Iceberg).

- Orchestration & Scheduling: Hier laufen Tools wie Apache Airflow, Prefect oder Dagster, die komplexe Pipelines automatisch steuern, überwachen und Fehler behandeln.

- Monitoring & Observability: Ohne Telemetrie, Logging und Alerting (Prometheus, Grafana, DataDog, OpenTelemetry) bist du im Blindflug unterwegs.

- Data Quality & Governance: Tools wie Great Expectations, Deequ oder Collibra sorgen für Validierung, Schema-Enforcement und Compliance.

- Security & Compliance: Zugriffskontrollen, Verschlüsselung, Auditing und DSGVO-Konformität sind Pflicht, keine Option.

Jede dieser Schichten ist kritisch. Die größten Bottlenecks entstehen fast immer an den Schnittstellen: Unsaubere Datenformate, inkonsistente Schemas, fehlende Idempotenz oder asynchrone Fehlerbehandlung killen jede noch so teure Pipeline. Profis setzen deshalb auf einheitliche Schnittstellen (z.B. Avro, Parquet, JSON Schema), versionierte Pipelines und automatisierte Tests – und zwar auf allen Ebenen.

Wer nur auf Tools schielt, verpasst das große Ganze: Ein Data Pipeline Stack ist erst dann effizient, wenn er nahtlos zwischen Batch und Streaming-Architektur wechseln kann, seine Datenflüsse sichtbar macht und im Fehlerfall automatisiert Gegenmaßnahmen ergreift. Alles andere ist Spielerei – und spätestens beim ersten größeren Incident der direkte Weg ins Datenchaos.

Zusammengefasst: Dein Data Pipeline Stack steht und fällt mit der sauberen Integration, Überwachung und Steuerung aller Komponenten. Die Zeiten, in denen man mit ein paar Cronjobs und manuellen Skripten auskommt, sind vorbei. Wer heute noch so arbeitet, kann den Begriff “Datenstrategie” gleich aus dem Pitch-Deck streichen.

Batch vs Streaming: Wann welche Architektur im Data Pipeline Stack Sinn ergibt

Ein häufiger Fehler: Alles über einen Kamm scheren. Batch-Verarbeitung und Streaming sind keine konkurrierenden Modelle, sondern komplementäre Ansätze im modernen Data Pipeline Stack. Wer das nicht versteht, baut entweder zu teure, zu starre Systeme – oder verpasst die Chancen, die in Echtzeitdaten liegen.

Batch Processing ist der Klassiker. Hier werden Daten in festen Intervallen (z.B. stündlich, täglich) gesammelt, gesammelt transformiert und weiterverarbeitet. Vorteile: Robustheit, Planbarkeit, einfache Fehlerbehandlung. Nachteile: Latenz, wenig Flexibilität bei Echtzeit-Anforderungen.

Streaming Processing dagegen verarbeitet Daten “on the fly”, also sofort bei Eingang. Frameworks wie Apache Kafka, Flink oder Spark Streaming ermöglichen die direkte Analyse und Transformation von Events, sobald sie eintreffen. Vorteile: Minimale Latenz, Realtime AnalyticsAnalytics: Die Kunst, Daten in digitale Macht zu verwandeln Analytics – das klingt nach Zahlen, Diagrammen und vielleicht nach einer Prise Langeweile. Falsch gedacht! Analytics ist der Kern jeder erfolgreichen Online-Marketing-Strategie. Wer nicht misst, der irrt. Es geht um das systematische Sammeln, Auswerten und Interpretieren von Daten, um digitale Prozesse, Nutzerverhalten und Marketingmaßnahmen zu verstehen, zu optimieren und zu skalieren...., Skalierbarkeit. Nachteile: Komplexität, schwereres Debugging, höhere Anforderungen an das Monitoring.

- Wähle Batch, wenn deine Geschäftsprozesse keine Echtzeitdaten benötigen und du Wert auf einfache Wartung legst.

- Setze auf Streaming, wenn du auf Live-Events reagieren musst, z.B. bei Betrugserkennung, IoT, AdTech oder Echtzeit-Personalisierung.

- Hybrid-Modelle (“Lambda Architecture” oder “Kappa Architecture”) kombinieren beide Welten – sind aber teuer und schwierig sauber zu implementieren.

Die Königsdisziplin: Nahtlose Umschaltung zwischen Batch und Streaming, mit zentralem Data Lake als “Single Source of Truth”. Profis bauen ihren Data Pipeline Stack so, dass sie flexibel auf Geschäftsanforderungen reagieren können – ohne monatelange Umbauten.

Fazit: Die Wahl des richtigen Verarbeitungsmodells ist keine Glaubensfrage, sondern ein knallharter Business-Trade-off. Wer das ignoriert, zahlt mit unnötiger Komplexität, verpassten Insights oder horrenden Cloud-Kosten. Willkommen in der Realität von Data Engineering 2025.

Data Quality, Observability und Monitoring: Die unterschätzten Killer im Data Pipeline Stack

Viele Pipelines laufen – bis sie es plötzlich nicht mehr tun. Und dann beginnt das große Rätselraten: Wo ist der Fehler? Welche Daten sind betroffen? Wie lange schon? Ohne Observability, Monitoring und systematische Data Quality Checks ist jeder Data Pipeline Stack ein Blindflug in den Datenabgrund.

Data Quality umfasst weit mehr als nur ein paar Regex-Validierungen. Es geht um Schema Enforcement, Anomalie-Erkennung, Dublettenprüfung, Konsistenzchecks und die automatische Quarantäne fehlerhafter Datensätze. Tools wie Great Expectations, Deequ oder Soda.io liefern hierfür Frameworks, mit denen du Qualitätsregeln als Code definieren, versionieren und automatisiert durchsetzen kannst. Wer glaubt, das kostet nur Zeit, hat noch nie einen Tag mit korrupten Daten im Produktionsteam verbracht.

Observability ist das Buzzword der Stunde – und zu Recht. Denn nur mit vollständigem Logging, Tracing und Metriken auf allen Ebenen erkennst du rechtzeitig, wo es in der Pipeline hakt. Prometheus, Grafana, OpenTelemetry und DataDog sind hier die Platzhirsche. Aber auch sie helfen dir nur, wenn du konsequent auf strukturierte Logs, distributed Tracing und sinnvolle Metriken setzt. “Error: Unknown” als Alert hilft keinem weiter.

Monitoring ist mehr als ein paar Health Checks. Es geht um automatisierte Alerts, Self-Healing-Mechanismen (z.B. Retry-Logik, Dead Letter Queues), Dashboards für Business-User und die Integration mit Incident-Management-Tools wie PagerDuty oder Opsgenie. Wer das alles für “zu viel Aufwand” hält, landet spätestens beim ersten Data Leak oder Compliance-Vorfall im Disaster-Mode.

Noch ein Killer-Argument: Data Quality und Observability sind kein Selbstzweck. Sie schützen nicht nur vor Datenchaos, sondern sind die Voraussetzung für Auditing, Compliance und regulatorische Anforderungen. Ohne sie ist jeder Data Pipeline Stack ein unkalkulierbares Risiko – und alles, was du darauf aufbaust, reines Wunschdenken.

Schritt-für-Schritt-Anleitung: Aufbau eines skalierbaren Data Pipeline Stack für Profis

Du willst einen Data Pipeline Stack, der nicht nur im Proof-of-Concept glänzt, sondern auch unter realer Last performt? Folge diesem Ablauf – und du vermeidest 90 % aller Fehler, die sonst in Projekten Millionen kosten:

- 1. Anforderungsanalyse und Datenquellen identifizieren

Erfasse alle relevanten Datenquellen (APIs, Datenbanken, IoT, Third-Party). Definiere, welche Daten wie oft und in welchem Format benötigt werden. - 2. Architekturdesign: Batch, Streaming oder Hybrid?

Entscheide, welches Verarbeitungsmodell zu deinen Geschäftsanforderungen passt. Skizziere den geplanten Stack – mit allen Schichten und Schnittstellen. - 3. Auswahl der Kern-Technologien und Tools

Vergleiche Open Source (Kafka, Airflow, dbt), Cloud-Services (AWS Glue, Azure Data Factory, Google Dataflow) und Hybrid-Modelle. Berücksichtige Kosten, Vendor-Lock-in, Skalierbarkeit und Security. - 4. Aufbau der Data Ingestion Layer

Implementiere robuste Ingestion-Mechanismen (CDC, Event-Streaming, Bulk Load). Baue Wiederholbarkeit und Idempotenz ein. - 5. Transformation und Data Quality einbauen

Entwickle Transformationen als Code (dbt, Spark, SQL). Integriere Data Quality Checks und automatisierte Tests auf Schema- und Werteebene. - 6. Storage Layer aufsetzen

Wähle den passenden Speicher (Data Lake, Warehouse, Lakehouse). Setze auf Partitionierung, Komprimierung und Lifecycle-Management. - 7. Orchestration und Scheduling automatisieren

Konfiguriere Pipelines mit Airflow, Dagster oder Prefect. Implementiere Retries, Fehlerbehandlung und Dependency Management. - 8. Monitoring, Logging und Observability integrieren

Baue Telemetrie von Anfang an ein. Richte Dashboards, Alerts und Incident-Management ein. - 9. Security & Compliance umsetzen

Verschlüsselung, Zugriffskontrollen, Audit-Logs und Rollenmanagement sind Pflicht. Denke früh an DSGVO, HIPAA und andere Regulierungen. - 10. Kontinuierliches Testing, Review und Optimierung

Automatisiere Tests, setze auf Peer Reviews und optimiere die Pipeline regelmäßig. Dokumentiere alle Änderungen – Versionierung ist Pflicht.

Wer diese Schritte ignoriert, baut ein Daten-Monster, das spätestens im Wachstum alles auffrisst – Budget, Nerven und Reputation inklusive. Profis wissen: Die initiale Planung entscheidet über Erfolg oder Scheitern. Rework ist teuer, und bei Datenarchitekturen fast immer ein Fass ohne Boden.

Tool-Auswahl, Cloud vs Open Source und die größten Fehler beim Data Pipeline Stack

Der Markt für Data Pipeline Tools ist ein Dschungel. Jeder Hersteller behauptet, mit zehn Klicks die perfekte Pipeline zu liefern. Die Wahrheit ist: Kein Tool löst das Architekturproblem für dich. Und die meisten Cloud-Angebote sind entweder zu teuer, zu unflexibel oder im schlimmsten Fall beides. Wer blind auf einen Stack setzt, den die eigene IT nicht versteht, läuft ins offene Messer.

Open Source ist kein Allheilmittel – aber oft der beste Startpunkt. Kafka, Airflow, Spark, dbt, Great Expectations und Prometheus bilden das Rückgrat vieler Enterprise-Pipelines. Aber: Wer den Betrieb, das Patching und die Security unterschätzt, erlebt böse Überraschungen. Cloud-Services wie AWS Glue, BigQuery Data Transfer, Azure Synapse oder Snowflake bieten Geschwindigkeit und Komfort – aber oft auf Kosten von Flexibilität, Transparenz und Budgetkontrolle.

Die größten Fehler beim Data Pipeline Stack:

- Blindes Vertrauen in “No Code”- oder “Low Code”-Tools – spätestens bei Custom Requirements stößt du an Grenzen.

- Fehlende Automatisierung und Testing: Manuelle Pipelines sind ein Garant für Fehler und Datenverlust.

- Unzureichende Security: Datenlecks, unverschlüsselte Speicher und zu breite Zugriffsrechte sind Einladung für Compliance-Super-GAUs.

- Monitoring und Observability werden stiefmütterlich behandelt – bis es kracht.

- Kein Plan für Skalierung und Kostenkontrolle: Cloud-Rechnungen explodieren schneller, als du “Data Governance” buchstabieren kannst.

Profis bauen ihren Stack so, dass sie jederzeit wechseln, skalieren und ihre Datenflüsse nachvollziehen können. Wer sich von Anbietern abhängig macht oder auf bunte Dashboards statt auf solide Architektur setzt, zahlt später doppelt und dreifach – und steht im Ernstfall allein da.

Fazit: Ohne durchdachten Data Pipeline Stack ist der ganze AI-Hype Datenmüll

Ein effizienter Data Pipeline Stack ist heute nicht mehr nice-to-have, sondern absolute Pflicht für jeden, der mit Daten ernsthaft arbeiten will. Er entscheidet darüber, ob du dein Unternehmen datengestützt steuerst – oder ob du in einem Ozean aus Datenmüll und Compliance-Risiken badest. Die richtigen Technologien, eine saubere Architektur und kompromisslose Automatisierung sind der einzige Weg zu effizienten, transparenten und skalierbaren Datenströmen.

Wer den Data Pipeline Stack unterschätzt, produziert am Ende nur neuen Datenmüll – egal, wie viel AI, Machine LearningMachine Learning: Algorithmische Revolution oder Buzzword-Bingo? Machine Learning (auf Deutsch: Maschinelles Lernen) ist der Teilbereich der künstlichen Intelligenz (KI), bei dem Algorithmen und Modelle entwickelt werden, die aus Daten selbstständig lernen und sich verbessern können – ohne dass sie explizit programmiert werden. Klingt nach Science-Fiction, ist aber längst Alltag: Von Spamfiltern über Gesichtserkennung bis zu Produktempfehlungen basiert mehr digitale Realität... oder fancy Analytics-Tools du oben drauf wirfst. SichtbarkeitSichtbarkeit: Die unbarmherzige Währung des digitalen Marketings Wenn es im Online-Marketing eine einzige Währung gibt, die wirklich zählt, dann ist es Sichtbarkeit. Sichtbarkeit – im Fachjargon gern als „Visibility“ bezeichnet – bedeutet schlicht: Wie präsent ist eine Website, ein Unternehmen oder eine Marke im digitalen Raum, insbesondere in Suchmaschinen wie Google? Wer nicht sichtbar ist, existiert nicht. Punkt. In diesem..., Kontrolle und Qualität sind keine Buzzwords, sondern die Grundpfeiler jeder erfolgreichen Datenstrategie. Die guten Nachrichten: Mit dem richtigen Stack bist du im Datenrennen ganz vorne dabei. Die schlechten: Alles andere ist 2025 nur noch digitaler Stillstand.