Eventstream Einsatz: Echtzeitdaten clever nutzen und steuern

Stell dir vor, du könntest auf Knopfdruck in Echtzeit wissen, was im Hintergrund deiner Webanwendung passiert – ohne dabei in den Code zu stochern oder auf veraltete Logfiles zu starren. Genau das macht Eventstream möglich. Es ist die unsichtbare Daten-Autobahn, auf der deine Systeme blitzschnell kommunizieren, um Entscheidungen zu treffen, Nutzererlebnisse zu optimieren und dein Business im digitalen Zeitalter zu dominieren. Doch wer hier nur an simple Event-Logs denkt, der hat das Potenzial längst unterschätzt. Willkommen bei der Revolution der Echtzeitdaten – laut, clever, manchmal nervig, aber immer essenziell.

- Was ist Eventstream und warum ist es der Schlüssel zu Echtzeitdaten

- Die wichtigsten Anwendungsfälle für Eventstream im Online-Marketing und Webtechnologien

- Technische Grundlagen: Von Message Broker bis Data Pipeline

- Vorteile und Herausforderungen bei der Implementierung von Eventstream-Architekturen

- Schritt-für-Schritt: So integrierst du Eventstream in deine Infrastruktur

- Tools, Frameworks und Plattformen für erfolgreiches Eventstream-Management

- Best Practices: Datenqualität, Sicherheit und Skalierung im Eventstream-Umfeld

- Fehler, die du vermeiden solltest, und warum dein Projekt sonst im Chaos versinkt

- Warum Eventstream in der Zukunft unverzichtbar ist – auch für Nicht-Developer

In der Welt des Online-Marketings und der Webentwicklung gilt: Daten sind das neue Gold. Doch was nützt dir der schönste FunnelFunnel: Der ultimative Trichter im Online-Marketing – Funktionsweise, Aufbau und Optimierung Der Begriff „Funnel“ ist eines dieser magischen Buzzwords, das jeder Online-Marketer mindestens dreimal pro Tag verwendet – meistens, ohne es wirklich zu begreifen. Ein Funnel (deutsch: Trichter) beschreibt die strategische Abfolge von Schritten, mit denen potenzielle Kunden systematisch vom ersten Kontakt bis zum Kauf (und darüber hinaus) geführt werden...., wenn du nicht in Echtzeit erfassen kannst, was deine Nutzer gerade machen? Hier kommt der Eventstream ins Spiel – eine Technologie, die dir ermöglicht, Ereignisse, Aktionen und Zustände sofort zu erfassen, zu verarbeiten und entsprechend zu steuern. Es ist die digitale Nervenbahn, die dein System mit Informationen flutet, noch bevor der Nutzer überhaupt merkt, dass hier etwas passiert. Wer heute noch auf Batch-Processing oder veraltete Logfiles setzt, der ist morgen schon abgehängt. Das ist kein Hype, sondern die Zukunft der datengetriebenen Entscheidung.

Eventstream ist kein Zauberwort. Es ist ein Konzept, das auf der kontinuierlichen Übertragung und Verarbeitung von Events basiert. Statt Daten nur nachträglich zu analysieren, kannst du hier sofort auf Aktionen reagieren – beispielsweise, indem du personalisierte Angebote in Echtzeit ausspielst oder Risiken frühzeitig erkennst. Für Online-Marketer, Entwickler und Business-Owner gleichermaßen bedeutet das: mehr Kontrolle, höhere Effizienz und eine nie dagewesene Flexibilität. Doch die Technik ist komplex, die Implementierung anspruchsvoll. Wer sich nicht gründlich vorbereitet, landet im Datenchaos – und das kostet Zeit, Geld und Reputation.

Was ist Eventstream und warum ist es der Gamechanger für Echtzeitdaten

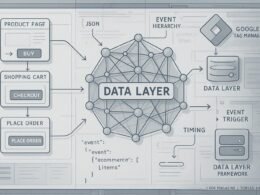

Eventstream ist eine Architektur, die auf der ununterbrochenen Übertragung von Events in Echtzeit basiert. Ein Event ist eine einzelne Aktion – etwa das Klicken eines Buttons, das Abschicken eines Formulars oder das Abspielen eines Videos. Diese Events werden in der Regel von Client-Apps, Servern oder IoT-Geräten generiert und an eine zentrale Plattform gesendet, die sie verarbeitet und weiterleitet. Das Herzstück eines Eventstream-Systems ist der Message Broker, der die Events zuverlässig, skalierbar und in der richtigen Reihenfolge verteilt.

Im Gegensatz zu klassischen Logdateien oder Batch-Prozessen arbeitet Eventstream kontinuierlich. Das bedeutet: Daten werden in Echtzeit erfasst, verarbeitet und für nachgelagerte Systeme verfügbar gemacht. Für Marketer heißt das: sofortige Erkenntnisse über NutzerverhaltenNutzerverhalten: Das unbekannte Betriebssystem deines digitalen Erfolgs Nutzerverhalten beschreibt, wie Menschen im digitalen Raum interagieren, klicken, scrollen, kaufen oder einfach wieder verschwinden. Es ist das unsichtbare Skript, nach dem Websites funktionieren – oder eben grandios scheitern. Wer Nutzerverhalten nicht versteht, optimiert ins Blaue, verschwendet Budgets und liefert Google und Co. die falschen Signale. In diesem Glossarartikel zerlegen wir das Thema..., für Entwickler: schnelle Reaktionsmöglichkeiten auf Systemereignisse. Dabei spielt der Datenfluss eine entscheidende Rolle: Es muss garantiert werden, dass keine Events verloren gehen, auch bei hohem Durchsatz. Technologien wie Apache Kafka, RabbitMQ oder Pulsar sind hier die Standard-Tools, um diese Anforderungen zu erfüllen.

Das Besondere an Eventstream ist die Fähigkeit, komplexe Datenströme zu orchestrieren. Es geht nicht nur um einzelne Events, sondern um die Korrelation von Ereignissen, Mustererkennung und das Auslösen automatisierter Aktionen. So entsteht eine Art “Living Data Environment”, das dein Business in Echtzeit steuert. Damit wird Eventstream zum Gamechanger, weil es die Grenzen zwischen Datenaufnahme, -verarbeitung und -nutzung aufhebt und alles nahtlos verbindet.

Die wichtigsten Anwendungsfälle für Eventstream im Online-Marketing und Webtechnologien

Die Einsatzmöglichkeiten für Eventstream sind so vielfältig wie die Daten selbst. Im Online-Marketing nutzen Firmen Eventstream, um NutzerverhaltenNutzerverhalten: Das unbekannte Betriebssystem deines digitalen Erfolgs Nutzerverhalten beschreibt, wie Menschen im digitalen Raum interagieren, klicken, scrollen, kaufen oder einfach wieder verschwinden. Es ist das unsichtbare Skript, nach dem Websites funktionieren – oder eben grandios scheitern. Wer Nutzerverhalten nicht versteht, optimiert ins Blaue, verschwendet Budgets und liefert Google und Co. die falschen Signale. In diesem Glossarartikel zerlegen wir das Thema... in Echtzeit zu tracken, Kampagnen dynamisch anzupassen oder Personalisierung auf einem neuen Level zu betreiben. Beispiel: Ein Nutzer klickt auf eine Anzeige, und sofort wird ihm ein passendes Angebot im Web angezeigt, basierend auf seinem vorherigen Verhalten. Das funktioniert nur, weil der Eventstream die Daten blitzschnell verarbeitet und die richtigen Aktionen auslöst.

Im E-CommerceE-Commerce: Definition, Technik und Strategien für den digitalen Handel E-Commerce steht für Electronic Commerce, also den elektronischen Handel. Damit ist jede Art von Kauf und Verkauf von Waren oder Dienstleistungen über das Internet gemeint. Was früher mit Fax und Katalog begann, ist heute ein hochkomplexes Ökosystem aus Onlineshops, Marktplätzen, Zahlungsdienstleistern, Logistik und digitalen Marketing-Strategien. Wer im digitalen Handel nicht mitspielt,... sorgt Eventstream für eine verbesserte Customer JourneyCustomer Journey: Die Reise des Kunden im digitalen Zeitalter Die Customer Journey ist das Rückgrat jeder ernstzunehmenden Online-Marketing-Strategie – und doch wird sie von vielen immer noch auf das banale „Kaufprozess“-Schaubild reduziert. Dabei beschreibt die Customer Journey alle Berührungspunkte (Touchpoints), die ein potenzieller Kunde mit einer Marke durchläuft – vom ersten Impuls bis weit nach dem Kauf. Wer heute digital.... Wenn ein Kunde Produkte in den Warenkorb legt, kann das System in Echtzeit Cross-Selling-Angebote ausspielen oder den Versandstatus aktualisieren. Auch im Bereich der Betrugsprävention spielt Eventstream eine zentrale Rolle: Verdächtige Aktivitäten werden sofort erkannt, sodass Angriffe abgewehrt werden können, bevor sie Schaden anrichten. Für Webtechnologien bedeutet das: dynamische Content-Delivery, bessere Personalisierung und eine höhere Conversion-Rate.

Auch im Bereich der Web-Performance-Optimierung ist Eventstream unverzichtbar. Hier kann man mit Monitoring-Events Fehler, Latenzen oder Ausfälle in Echtzeit erkennen und sofort reagieren. Das schafft nicht nur eine bessere Nutzererfahrung, sondern auch einen echten Wettbewerbsvorteil. Die zentrale Botschaft: Wer Eventstream richtig nutzt, verwandelt passive Daten in aktive Steuerung – und das in Millisekunden.

Technische Grundlagen: Von Message Broker bis Data Pipeline

Wer Eventstream wirklich versteht, muss die technischen Komponenten kennen. An erster Stelle steht der Message Broker. Das ist das Herzstück, das die Events empfängt, zwischenspeichert und an die jeweiligen Konsumenten verteilt. Wichtig sind dabei Eigenschaften wie Skalierbarkeit, Latenz und Zuverlässigkeit. Apache Kafka ist hier die Benchmark-Lösung, weil es horizontal skaliert, persistente Logs nutzt und eine robuste Replikation bietet.

Direkt verbunden ist die Data Pipeline – die Datenstraße, die Events vom Erzeuger bis zum Ziel leitet. Dabei kommen oft Stream-Processing-Frameworks wie Kafka Streams, Apache Flink oder Spark Streaming zum Einsatz. Sie filtern, aggregieren, bereinigen und transformieren die Events in Echtzeit. Ziel ist es, relevante Informationen zu extrahieren, die sofort in Dashboards, Automatisierungen oder Decision Engines einfließen.

Ein weiterer wichtiger Baustein sind Event-Consumer. Das können Microservices, Data Lakes oder Frontend-Apps sein, die auf die Events reagieren. Wichtig ist hier eine klare Trennung zwischen Erzeugung, Verarbeitung und Nutzung der Events. Um Datenverlust zu vermeiden, setzt man auf Replikation, Commit-Log-Systeme und genaues Event-Management. Ohne diese Komponenten läuft das Eventstream-System ins Chaos – und das ist teuer.

Vorteile und Herausforderungen bei der Implementierung von Eventstream-Architekturen

Die Vorteile liegen auf der Hand: Echtzeit-Insights, schnelle Reaktionsfähigkeit, bessere Personalisierung und eine höhere Systemeffizienz. Mit Eventstream kannst du auf Veränderungen sofort reagieren, Nutzererwartungen erfüllen und dein Business agil steuern. Allerdings ist die Implementierung nicht ohne Herausforderungen. Die Komplexität der Infrastruktur, die Anforderungen an Datenqualität und die Security sind nur einige Fallstricke.

Eine der größten Herausforderungen ist die Skalierung. Bei steigendem Datenaufkommen muss dein System wachsen können, ohne an Performance zu verlieren. Das bedeutet, horizontale Skalierung der Message Broker, verteilte Verarbeitung und eine robuste Infrastruktur. Zudem ist das Datenmanagement komplex: Du musst dafür sorgen, dass Events eindeutig, zeitlich korrekt und konsistent verarbeitet werden. Ansonsten droht Datenchaos und falsche Entscheidungen.

Security ist ebenfalls ein kritischer Punkt. Eventstream-Daten enthalten oft sensible Informationen, die vor unbefugtem Zugriff geschützt werden müssen. Verschlüsselung, Authentifizierung und Zugriffskontrollen sind hier Pflicht. Nicht zuletzt erfordert die Implementierung Know-how, Erfahrung und eine klare Strategie, um die Architektur langfristig stabil und wartbar zu machen. Wer hier nur auf Schnellschüsse setzt, landet im Data-Disaster.

Schritt-für-Schritt: So integrierst du Eventstream in deine Infrastruktur

Der Einstieg in Eventstream ist kein Hexenwerk, erfordert aber Planung und Know-how. Hier eine strukturierte Anleitung, um das Projekt erfolgreich umzusetzen:

- Bedarfsanalyse und Zieldefinition: Klare Zielsetzungen festlegen – Welche Events sind relevant? Welche Entscheidungen sollen in Echtzeit getroffen werden?

- Technologieauswahl: Entscheide dich für einen Message Broker (Kafka, RabbitMQ, Pulsar) und ein Processing-Framework (Flink, Spark Streaming).

- Architekturplanung: Lege fest, wie die Daten fließen sollen, wer die Producer (Event-Erzeuger) sind und wer die Consumer (Verarbeiter).

- Implementierung der Event-Produktion: Entwickle die Komponenten, die Events generieren – z.B. Frontend-Tracking, Backend-Trigger oder IoT-Geräte.

- Einrichtung des Message Brokers: Konfiguriere Cluster, Replikation, Partitionen und Sicherheit.

- Stream Processing & Data EnrichmentData Enrichment: Datenanreicherung als Turbo für digitale Intelligenz Data Enrichment, auf Deutsch „Datenanreicherung“, ist die Kunst, rohe, langweilige oder schlicht unvollständige Datensätze so zu veredeln, dass daraus echte Wettbewerbsvorteile entstehen. Es geht darum, bestehende Informationen mit zusätzlichen, externen oder internen Quellen zu verknüpfen, zu aktualisieren und zu erweitern. Das Ziel: Daten werden wertvoller, aussagekräftiger und vor allem: endlich nutzbar für...: Baue die Datenpipeline mit Filter- und Aggregationsregeln auf.

- Testing & Validierung: Führe Lasttests durch, prüfe Latenzen, Datenintegrität und Failover-Szenarien.

- Monitoring und Optimierung: Setze Dashboards, Alerts und automatisierte Checks auf, um die Performance zu überwachen.

- Skalierung & Weiterentwicklung: Passe die Infrastruktur bei wachsendem Datenaufkommen an, erweitere Datenquellen und erstelle Automatisierungen.

Tools, Frameworks und Plattformen für erfolgreiches Eventstream-Management

In der Praxis kommen heute eine Vielzahl von Tools zum Einsatz, um Eventstream effizient zu steuern. Apache Kafka ist der Standard, wenn es um skalierbare, zuverlässige Event-Queues geht. Für die Stream-Verarbeitung sind Apache Flink und Spark Streaming die meistgenutzten Frameworks, weil sie komplexe Ereignismuster erkennen und in Echtzeit reagieren können.

Für Data-Management und Monitoring eignen sich Plattformen wie Confluent Cloud, AWS Kinesis oder Google Pub/Sub. Diese bieten managed Services, die das Hosting, die Skalierung und die Sicherheit übernehmen – ideal für Unternehmen, die keine eigenen Infrastruktur-Teams haben. Für Entwickler gibt es APIs und SDKs in verschiedenen Programmiersprachen, um Events einfach zu erzeugen und zu konsumieren.

Zur Visualisierung und Analyse der Datenströme sind Dashboards wie Grafana oder Kibana unverzichtbar. Sie erlauben es, in Echtzeit die Systemgesundheit zu überwachen, Muster zu erkennen und schnell auf Störungen zu reagieren.

Best Practices: Datenqualität, Sicherheit und Skalierung im Eventstream-Umfeld

Wer mit Eventstream arbeitet, sollte die Datenqualität nie aus den Augen verlieren. Es gilt, Events eindeutig, vollständig und zeitlich korrekt zu erfassen. Dazu gehört auch, Duplikate zu vermeiden und Event-Sequenzen richtig zu ordnen. Hier kommen Idempotenz, Event-Versionierung und Timestamps ins Spiel.

Sicherheit ist im Eventstream unerlässlich. Verschlüsselung während der Übertragung (TLS), Zugriffskontrollen auf Topic-Levels und Authentifizierung via OAuth oder API-Keys sind Standard. Bei sensiblen Daten empfiehlt sich zusätzlich die Pseudonymisierung oder Anonymisierung.

Skalierung gelingt nur, wenn du dein System kontinuierlich überwachst und optimierst. Partitionierung, Load Balancing und automatische Failover-Mechanismen sorgen dafür, dass dein Eventstream auch bei hohem Durchsatz stabil bleibt. Regelmäßige Backups und Disaster-Recovery-Pläne sind Pflicht. Bei der Datenarchitektur gilt: Keep it simple. Komplexe Abhängigkeiten führen nur zu Chaos und erhöhten Wartungskosten.

Fehler, die du vermeiden solltest, und warum dein Projekt sonst im Chaos versinkt

Der größte Fehler ist die Annahme, dass Eventstream eine Plug-and-Play-Lösung ist. Ohne gründliche Planung, klare Datenmodelle und Verständnis der Anforderungen wird dein System schnell unübersichtlich. Auch das Ignorieren von Sicherheits- und Skalierungsfragen führt zu Problemen, die im Ernstfall teuer werden.

Ein weiterer klassischer Fehler ist die schlechte Datenqualität. Du kannst noch so viel in Tools investieren, wenn die Events unvollständig, inkonsistent oder falsch getimt sind, ist alles für die Katz. Ebenso fatal: fehlendes Monitoring. Ohne permanente Überwachung kannst du Probleme erst erkennen, wenn der Schaden bereits angerichtet ist.

Und last but not least: Technik-Overkill. Nicht jede Anwendung braucht Kafka, Flink und eine eigene Infrastruktur. Überlege genau, was dein Use Case wirklich erfordert – sonst verwandelst du dein Projekt in einen Daten-Monster, das keiner mehr versteht.

Warum Eventstream in der Zukunft unverzichtbar ist – auch für Nicht-Developer

Die Zukunft gehört den Echtzeitdaten. Wer heute noch denkt, er könne ohne Eventstream auskommen, der wird morgen im Daten-Nirvana versinken. Für Marketer, Business-Strategen und Entscheider ist es längst keine Nische mehr, sondern eine Überlebensfrage. Automatisierte Entscheidungen, personalisierte Nutzererlebnisse und proaktive Systemsteuerung basieren alle auf der Fähigkeit, Daten in Millisekunden zu erfassen und zu verarbeiten.

Auch wenn du kein Developer bist, solltest du die Grundprinzipien kennen. Denn die Steuerung von Event-Streams wird zunehmend durch No-Code-Tools und Plattformen erleichtert. Doch wer die technischen Hintergründe versteht, kann bessere Entscheidungen treffen, Projektziele klar definieren und die Integration in die Gesamtarchitektur optimieren. Die Zeit der passiven Datenhaltung ist vorbei. Wer in Echtzeit agiert, gewinnt.

Fazit: Eventstream ist kein technisches Spielzeug, sondern die digitale Lebensader für Unternehmen, die im Datenzeitalter bestehen wollen. Es ist eine Investition in Flexibilität, Geschwindigkeit und Innovationskraft – und wer hier zögert, gerät schnell ins Hintertreffen. Wer heute beginnt, die Datenautobahn zu bauen, hat morgen den entscheidenden Wettbewerbsvorteil in der Tasche.