Geschichte der Künstlichen Intelligenz: Meilensteine verstehen – Vom Hype zur Realität

Du glaubst, Künstliche Intelligenz ist ein Buzzword, das erst gestern aus dem Silicon Valley geplatzt ist? Falsch gedacht. Die Geschichte der Künstlichen Intelligenz ist ein epischer Ritt durch Jahrzehnte voller Größenwahn, Fehlschläge, Durchbrüche und Mythen. Wer wirklich versteht, wie KI entstanden ist, durch welche Meilensteine sie geprägt wurde und warum der aktuelle Hype anders – und gefährlicher – ist als je zuvor, hat nicht nur einen Wissensvorsprung. Sondern erkennt auch, wie man Künstliche Intelligenz im Marketing, in der Technologie und in der Gesellschaft sinnvoll (und kritisch) nutzt, statt blind einem Algorithmus hinterherzulaufen.

- Künstliche Intelligenz ist weder neu noch ein Zufallsprodukt: Die Ursprünge reichen zurück bis in die 1940er Jahre.

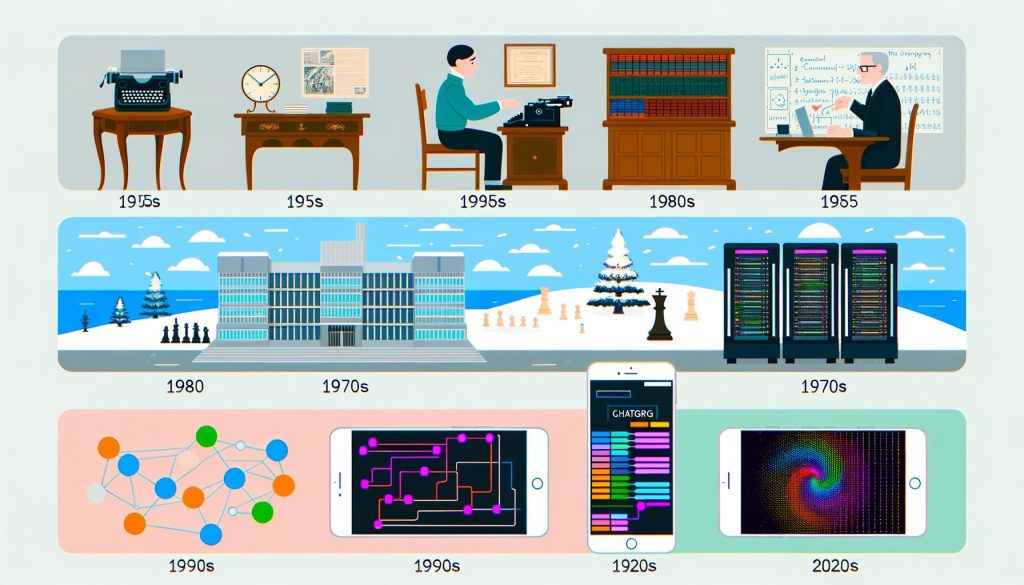

- Die wichtigsten KI-Meilensteine: Von Turing über Expertensysteme bis zu Deep Learning und ChatGPT.

- Warum AI-Winter unvermeidlich waren – und wie Tech-Mythen und Fehleinschätzungen ganze Branchen ruiniert haben.

- Die entscheidenden Technologien: Neuronale Netze, Machine Learning, Natural Language Processing und ihre echte Bedeutung.

- KI 2024: Was ist Hype, was ist real, was bleibt Staub im digitalen Wind?

- Wie Unternehmen KI heute sinnvoll nutzen – und welche Fehler garantiert zur digitalen Bauchlandung führen.

- Ethik, Black Boxes und Kontrollverlust: Warum KI nicht nur ein technisches, sondern ein gesellschaftliches Thema ist.

- Step-by-Step: Was du wirklich über die Geschichte und die Funktionsweise von KI wissen musst, um nicht in Marketing-Bullshit zu versinken.

- Die wichtigsten Begriffe und Technologien im Klartext erklärt – für alle, die KI nicht nur buzzworden wollen.

- Fazit: KI ist weder Magie noch Bedrohung – sondern ein Werkzeug, das nur der durchblickt, der seine Geschichte kennt.

Künstliche Intelligenz – oder wie Marketingabteilungen seit drei Jahren sagen: AI, Artificial Intelligence, Generative AI, Machine Learning, Deep Learning. Die Begriffe fliegen uns um die Ohren, aber die wenigsten kennen den Unterschied zwischen neuronalen Netzen, symbolischer KI, Expertensystemen oder Large Language Models. Die Geschichte der Künstlichen Intelligenz ist ein einziges Auf und Ab aus großspurigen Versprechen, ernüchternden Rückschlägen und echten Durchbrüchen. Wer heute im Online-Marketing, in der Softwareentwicklung oder im Business unterwegs ist, kommt an KI nicht vorbei. Aber: Wer die echten Meilensteine nicht kennt, bleibt auf der Oberfläche und fällt auf jeden neuen Hype rein, den ein CEO auf LinkedIn rausbläst.

In diesem Artikel bekommst du die ungeschönte, technisch fundierte Tour durch die Geschichte der Künstlichen Intelligenz. Wir klären, was die ersten Algorithmen wirklich konnten, warum KI zweimal totgesagt wurde und trotzdem immer wieder auferstanden ist. Wir zeigen, was ChatGPT mit Expertensystemen aus den 80ern zu tun hat, warum neuronale Netze eine Geschichte voller Missverständnisse sind und weshalb KI 2024 zwar alles verändert – aber garantiert nicht so, wie es die Marketing-Bros versprechen. Am Ende weißt du mehr als die meisten “AI-Consultants”, die sich gerade wie Pilze aus dem Boden schießen.

Die Anfänge der Künstlichen Intelligenz: Von Alan Turing bis zu den ersten KI-Algorithmen

Die Geschichte der Künstlichen Intelligenz beginnt nicht erst mit Google, IBM Watson oder ChatGPT – sondern Jahrzehnte früher. Schon 1950 stellt Alan Turing mit seinem berühmten Turing-Test eine Frage, die bis heute niemand eindeutig beantworten kann: “Können Maschinen denken?”. Mit dieser simplen, aber radikalen Überlegung legt Turing das theoretische Fundament für alles, was später unter Künstlicher Intelligenz firmiert. Der Turing-Test prüft, ob eine Maschine so kommunizieren kann, dass ein Mensch sie nicht mehr von einem anderen Menschen unterscheiden kann.

In den 1950er Jahren starten die ersten Versuche, Künstliche Intelligenz praktisch umzusetzen. 1956 wird auf der Dartmouth Conference der Begriff “Artificial Intelligence” geboren. Namen wie John McCarthy, Marvin Minsky und Allen Newell prägen das Feld. Die ersten Programme sind – aus heutiger Sicht – peinlich primitiv: Logikbasierte Systeme, die einfache mathematische oder spielerische Aufgaben (wie Schachzüge) lösen. Trotzdem: Für die damalige Zeit sind diese Algorithmen revolutionär, weil sie zeigen, dass Maschinen symbolische Regeln verarbeiten können.

Die frühen KI-Algorithmen basieren auf symbolischer KI: Wissen wird als explizite Regeln (wenn-dann) kodiert. Mit Programmen wie “Logic Theorist” (1956) oder “General Problem Solver” (1957) wird zum ersten Mal bewiesen, dass Computer logische Schlüsse ziehen können. Diese “Good Old-Fashioned AI” (GOFAI) dominiert die Forschung bis in die 1970er Jahre – und legt damit das Fundament für alles, was später mit Machine Learning und Deep Learning weitergedacht wird.

Die Künstliche Intelligenz ist zu diesem Zeitpunkt eine Mischung aus mathematischer Logik, Informatik und Größenwahn. Die ersten KI-Meilensteine sind vor allem Proof of Concepts. Die Forscher träumen davon, dass in 20 Jahren “denkenden Maschinen” alles möglich ist. Die Realität holt die Szene aber schon bald ein – und der erste große AI-Winter ist nicht mehr weit.

Die KI-Winter: Warum Künstliche Intelligenz immer wieder am eigenen Hype scheitert

Künstliche Intelligenz war schon immer ein Opfer ihrer eigenen Versprechen. In den 1970er und 1980er Jahren kommt die Ernüchterung: Die symbolische KI stößt an harte Grenzen. Die Probleme sind technischer, aber auch konzeptioneller Natur. Erstens: Die Welt ist zu komplex, um sie vollständig in Regeln zu fassen. Zweitens: Die Rechenleistung reicht bei weitem nicht aus, um realistische Anwendungen zu ermöglichen. Drittens: Die Erwartungen sind viel zu hoch, weil Politik und Wirtschaft den Forschern blind alles glauben.

Das Ergebnis: Der erste AI-Winter. Fördergelder werden gestrichen, Projekte eingestampft, Forscher umgeschult. Die KI-Technologie gilt plötzlich als Luftnummer. In den 1980ern wird mit sogenannten Expertensystemen (wie XCON) erneut Hoffnung geschürt. Diese Systeme können in sehr engen, klar definierten Feldern (z.B. medizinische Diagnosen oder Konfigurationen) erstaunliche Ergebnisse erzielen – aber sie scheitern grandios, sobald die Welt chaotisch, unvollständig oder dynamisch wird.

Der zweite AI-Winter folgt auf dem Fuße. Wieder sind es überzogene Erwartungen, fehlende Daten, limitierte Hardware und das Unvermögen, Wissen flexibel abzubilden. KI gilt erneut als “overhyped” und “dead end”. Wer damals auf Künstliche Intelligenz setzte, war entweder Visionär – oder Karriereruineur. Die Geschichte der KI zeigt: Jede neue Technologie, die total unterschätzt wird, wird irgendwann maßlos überschätzt. Und dann kommt der Absturz.

Was lernt man daraus? Die Geschichte der Künstlichen Intelligenz ist geprägt von Zyklen: Hype, Enttäuschung, Innovation, neuer Hype. Wer heute glaubt, dass KI alles kann, hat aus der Vergangenheit nichts verstanden. Die echten Meilensteine entstehen immer dann, wenn Erwartungen und technische Realität wieder aufeinanderprallen – und die Szene gezwungen ist, echte Probleme zu lösen statt nur zu träumen.

Die Wiedergeburt: Neuronale Netze, Machine Learning und der Siegeszug von Deep Learning

Ende der 1980er und vor allem in den 1990ern kommt neues Leben in die KI-Szene – und das verdankt die Branche einer alten Idee: künstlichen neuronalen Netzen. Bereits 1958 wird das Perzeptron von Frank Rosenblatt entwickelt. Aber erst mit wachsender Rechenleistung und neuen mathematischen Verfahren (wie dem Backpropagation-Algorithmus, 1986) werden künstliche neuronale Netze praktisch nutzbar. Die Idee: Statt Wissen als Regeln zu kodieren, lassen sich Maschinen trainieren, Muster in Daten zu erkennen.

Das Zeitalter des Machine Learning beginnt: Algorithmen wie Entscheidungsbäume, Support Vector Machines oder k-Nearest-Neighbours lösen viele Aufgaben besser als starre Expertensysteme. Plötzlich kann KI nicht nur Schach spielen, sondern Gesichter erkennen, Sprache verarbeiten, Texte klassifizieren. Die wahren Meilensteine entstehen aber erst mit dem Aufkommen von Deep Learning in den 2010er Jahren. Die Entwicklung leistungsfähiger GPUs, riesiger Datenmengen (Big Data) und ausgefeilter Frameworks wie TensorFlow und PyTorch katapultieren Deep Learning in den Mainstream.

Deep Learning nutzt mehrschichtige künstliche neuronale Netze, die komplexe Muster in riesigen Datensätzen erkennen. Meilensteine wie AlexNet (2012), das die Bildklassifikation revolutioniert, oder AlphaGo (2016), das erstmals einen menschlichen Weltmeister im Go schlägt, zeigen: KI kann Aufgaben lösen, an denen Menschen scheitern. Der Begriff “Künstliche Intelligenz” wird neu definiert – und das Marketing entdeckt die Technologie endgültig als Allzweckwaffe.

Doch die neue KI-Generation hat ihre eigenen Probleme: Black-Box-Modelle, mangelnde Erklärbarkeit, gigantischer Ressourcenverbrauch. Die Geschichte der Künstlichen Intelligenz ist damit keine Erfolgsgeschichte, sondern eine fortlaufende Debatte zwischen Machbarkeit, Verantwortung und Hype. Wer heute Deep Learning einsetzt, muss wissen, dass die Technologie zwar mächtig, aber alles andere als magisch ist.

Natural Language Processing, Generative AI und Large Language Models: Die neuen Meilensteine der KI

In den letzten fünf Jahren erlebt die Künstliche Intelligenz eine weitere Revolution: Natural Language Processing (NLP) und Generative AI katapultieren KI aus der Nische in den Alltag. Mit Modellen wie GPT-2, GPT-3 und spätestens ChatGPT (2022) zeigen Large Language Models (LLMs), dass Maschinen Texte, Code und sogar Bilder in einer Qualität erzeugen können, die menschliche Kreativität herausfordert – oder zumindest vortäuscht.

Natural Language Processing umfasst Technologien, mit denen Computer Sprache verstehen, generieren und analysieren. Von der maschinellen Übersetzung über Chatbots bis zu automatisierten Textzusammenfassungen – NLP ist heute überall. Der Clou: Während klassische KI auf explizitem Wissen basiert, lernen LLMs aus Milliarden von Texten, ohne dass ein Mensch jede Regel vorgeben muss. Die Architektur der Transformer-Modelle (seit 2017) ermöglicht es, Zusammenhänge in langen Kontexten zu erkennen und Texte kohärent zu generieren.

Generative AI geht noch weiter: KI-Modelle wie DALL-E oder Stable Diffusion erzeugen Bilder, Musik, Videos – auf Knopfdruck. Prompt Engineering, Fine-Tuning, Zero-Shot-Learning sind die neuen Schlagworte. Die technischen Herausforderungen bleiben: Training riesiger Modelle verschlingt Ressourcen, die Ergebnisse sind oft nicht nachvollziehbar, ethische Fragen werden gerne ausgeblendet. Trotzdem: Die neuen Meilensteine sind unbestreitbar – und zwingen jeden, der mit digitalen Inhalten arbeitet, sich mit KI auseinanderzusetzen.

Wichtig: Die Geschichte der Künstlichen Intelligenz ist kein linearer Fortschritt, sondern eine Sammlung von Sprüngen, Irrwegen und Korrekturen. Wer heute mit LLMs hantiert, sollte wissen, dass sie auf den Fehlern und Erfolgen von 70 Jahren KI-Forschung aufbauen – und dass jedes neue Modell alte Probleme in neuem Gewand zurückbringt.

Von der Theorie zur Praxis: Wie Unternehmen Künstliche Intelligenz sinnvoll (und sicher) nutzen

Wer glaubt, KI sei ein Plug-and-Play-Feature, hat die Geschichte der Künstlichen Intelligenz nicht verstanden. Die größten Fehler entstehen, wenn Firmen denken, ein bisschen Machine Learning im Marketing-Tool reicht, um “state of the art” zu sein. Fakt ist: Die Implementierung von KI erfordert Know-how, Daten, Ressourcen und vor allem ein kritisches Verständnis für die Grenzen der Technologie.

Unternehmen, die KI erfolgreich nutzen wollen, müssen die Meilensteine der KI-Geschichte kennen – und daraus lernen. Viele Projekte scheitern nicht an der Technik, sondern an unrealistischen Erwartungen, fehlender Datenqualität oder mangelnder Integration in bestehende Prozesse. Wer nicht versteht, warum Expertensysteme scheiterten oder Deep Learning Black-Boxes produziert, wird die gleichen Fehler wiederholen – nur mit teureren Tools und mehr verbranntem Budget.

Eine sinnvolle KI-Strategie sieht so aus:

- Ziele und Anwendungsfälle definieren: Was soll KI leisten? Wo bringt sie echten Mehrwert?

- Datenbasis prüfen: Sind ausreichend, qualitativ hochwertige Daten vorhanden?

- Technologie-Stack wählen: Welche KI-Modelle, Frameworks und Infrastrukturen passen zum Problem?

- Testen und iterieren: Kleine, kontrollierte Experimente statt “Big Bang”-Rollouts.

- Ethik und Transparenz: Black-Box-Modelle kritisch prüfen, Verantwortlichkeiten klären.

- Monitoring und Feedback: Kontinuierlich messen, evaluieren, nachsteuern.

Nur so wird Künstliche Intelligenz vom Buzzword zum echten Wettbewerbsvorteil. Und nur so verhindern Unternehmen, dass sie in den nächsten “KI-Winter” rauschen, weil sie blind dem neuesten Hype hinterherlaufen.

Step-by-Step: Was du über die Geschichte der KI wirklich wissen musst

Die Geschichte der Künstlichen Intelligenz ist gespickt mit Buzzwords, Halbwahrheiten und Mythen. Wer mitreden will, sollte die wichtigsten Begriffe und Technologien im Griff haben. Hier ein kompakter Überblick:

- Symbolische KI / GOFAI: Wissensrepräsentation durch Regeln und Logik. Basis der ersten KI-Programme.

- Expertensysteme: Programme mit fest kodiertem Expertenwissen für eng abgegrenzte Aufgaben.

- Neuronale Netze: Mathematische Modelle, die von biologischen Nervenzellen inspiriert sind. Lernen durch Mustererkennung.

- Machine Learning: Maschinen lernen aus Daten, statt explizite Regeln zu befolgen.

- Deep Learning: Mehrschichtige neuronale Netze, die komplexe Zusammenhänge in großen Datensätzen erkennen.

- Natural Language Processing (NLP): KI, die menschliche Sprache versteht und generiert.

- Generative AI / LLMs: Modelle wie GPT oder DALL-E, die Inhalte (Text, Bild, Code) auf Basis von Trainingsdaten erzeugen.

- AI-Winter: Phasen, in denen KI-Forschung als überbewertet und gescheitert gilt – und das Funding versiegt.

- Black Box: Undurchsichtige Modelle, deren Entscheidungswege nicht nachvollziehbar sind.

- Prompt Engineering: Die Kunst, KI-Modelle durch gezielte Eingaben zu steuern und bessere Ergebnisse zu erhalten.

Wer diese Begriffe versteht, erkennt: KI ist kein monolithisches System, sondern eine Sammlung von Technologien, Methoden und Denkweisen, die sich ständig weiterentwickeln – und immer wieder an den eigenen Grenzen scheitern oder wachsen.

KI, Ethik und Kontrollverlust: Warum Künstliche Intelligenz mehr als ein technisches Problem ist

Die Geschichte der Künstlichen Intelligenz ist nicht nur eine Abfolge technischer Meilensteine, sondern auch ein Lehrstück in Sachen Ethik, Kontrolle und Verantwortung. Je mächtiger KI-Systeme werden, desto größer werden die Fragen nach Transparenz, Fairness und gesellschaftlichen Auswirkungen. Deep Fakes, algorithmische Diskriminierung, Manipulation von Informationen – all das sind keine Science-Fiction-Probleme, sondern Realität.

Das größte Risiko: Black-Box-Modelle, die Entscheidungen treffen, die niemand mehr nachvollziehen kann. Unternehmen, Behörden und Gesellschaft stehen vor der Herausforderung, KI-Systeme so zu gestalten, dass sie erklärbar, fair und kontrollierbar bleiben. Das erfordert nicht nur technische Lösungen (wie Explainable AI), sondern auch eine neue Kultur der Verantwortung und kritischen Reflexion.

Wer die Geschichte der Künstlichen Intelligenz versteht, weiß: Jede neue Generation von KI bringt nicht nur Chancen, sondern auch neue Risiken. Wer blind vertraut, verliert. Wer kritisch bleibt und die Meilensteine (und Stolpersteine) kennt, kann KI sinnvoll nutzen – und wird nicht zum Spielball einer Black Box, die sich selbst nicht mehr versteht.

Fazit: Die Geschichte der Künstlichen Intelligenz – Zwischen Mythos, Meilenstein und Marketing-Bullshit

Künstliche Intelligenz ist kein Zauberstab, kein Untergangsszenario und kein Allheilmittel. Die Geschichte der KI zeigt, dass jede technologische Revolution von Mythen, Fehleinschätzungen und echten Durchbrüchen getrieben wird. Wer die Meilensteine der KI kennt – von Turing über Expertensysteme bis zu Large Language Models – erkennt, dass Fortschritt immer kritisch, iterativ und voller Rückschläge ist.

Wer heute KI nutzt oder implementiert, sollte wissen: Jeder Hype wird von der Realität eingeholt. Am Ende ist Künstliche Intelligenz ein Werkzeug. Nicht mehr, aber auch nicht weniger. Wer die Geschichte der Künstlichen Intelligenz versteht, ist einen Schritt voraus – und fällt garantiert nicht auf das nächste große Versprechen herein, das garantiert “alles verändert”. Willkommen bei der echten KI. Willkommen bei 404.