Geschichte Künstliche Intelligenz: Meilensteine und Wendepunkte

Vergiss die romantisierten Science-Fiction-Märchen: Die Geschichte der Künstlichen Intelligenz ist eine Achterbahnfahrt aus Größenwahn, gescheiterten Träumen und technologischen Quantensprüngen – und sie ist längst nicht vorbei. Wer glaubt, KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... sei erst seit ChatGPT und Midjourney ein Thema, hat die letzten siebzig Jahre im digitalen Winterschlaf verbracht. Dieser Artikel zeigt dir gnadenlos, wie Künstliche Intelligenz wirklich entstand, welche Wendepunkte alles veränderten und warum die Zukunft garantiert noch hässlicher, spannender und disruptiver wird. Willkommen im Maschinenzeitalter, in dem nichts so bleibt, wie es war.

- Künstliche Intelligenz: Definition, Abgrenzung und warum der Begriff ständig missbraucht wird

- Frühe Anfänge: Von Turing bis zu den ersten Schachprogrammen – was KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... wirklich bedeutete

- Erste KI-Winter: Warum Hypes regelmäßig kollabierten und die Geldgeber absprangen

- Machine LearningMachine Learning: Algorithmische Revolution oder Buzzword-Bingo? Machine Learning (auf Deutsch: Maschinelles Lernen) ist der Teilbereich der künstlichen Intelligenz (KI), bei dem Algorithmen und Modelle entwickelt werden, die aus Daten selbstständig lernen und sich verbessern können – ohne dass sie explizit programmiert werden. Klingt nach Science-Fiction, ist aber längst Alltag: Von Spamfiltern über Gesichtserkennung bis zu Produktempfehlungen basiert mehr digitale Realität... und Deep Learning: Die eigentlichen Gamechanger der KI-Geschichte

- Deep Blue, AlphaGo, ChatGPT: Die Wendepunkte, die alles neu definierten

- Technologische und gesellschaftliche Blockaden: Ethik, Daten, Blackbox-Problematik

- Warum KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... 2024 fundamental anders ist als alles davor – und niemand die Kontrolle hat

- Step-by-Step: Die wichtigsten Meilensteine der KI-Entwicklung in chronologischer Reihenfolge

- Fazit: KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... als Disruption – und warum die nächste Revolution garantiert kommt

Künstliche Intelligenz – das Schlagwort, das seit Jahrzehnten für Hysterie, Panik und Marketing-Overkill sorgt. Aber was steckt hinter dem Mythos? Wer die Geschichte der Künstlichen Intelligenz nur aus LinkedIn-Posts und Werbeprospekten kennt, läuft Gefahr, auf denselben Hype hereinzufallen wie ganze Generationen von Forschern, Investoren und Politikern. Die Wahrheit: KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... ist kein Tech-Buzzword von gestern, sondern ein Sammelbegriff für technologische Durchbrüche, Totalausfälle und Neuanfänge. In diesem Artikel bekommst du die komplette Breitseiten-Analyse der KI-Geschichte – mit allen Meilensteinen, Sackgassen und Wendepunkten, die dich garantiert aus der Filterblase holen. Wer verstehen will, warum KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... heute alles verändert, muss wissen, woher sie kommt. Und genau das liefern wir jetzt. Ohne Bullshit, ohne Märchen – sondern mit maximaler technischer Klarheit.

Künstliche Intelligenz: Begriff, Definition und die ewige Kontroverse

Bevor wir in die Timeline der KI-Meilensteine einsteigen, braucht es eines: eine nüchterne, technische Definition von Künstlicher Intelligenz. Das Problem: Der Begriff ist ein Minenfeld aus Übertreibung, MarketingMarketing: Das Spiel mit Bedürfnissen, Aufmerksamkeit und Profit Marketing ist weit mehr als bunte Bilder, Social-Media-Posts und nervige Werbespots. Marketing ist die strategische Kunst, Bedürfnisse zu erkennen, sie gezielt zu wecken – und aus Aufmerksamkeit Profit zu schlagen. Es ist der Motor, der Unternehmen antreibt, Marken formt und Kundenverhalten manipuliert, ob subtil oder mit der Brechstange. Dieser Artikel entlarvt das... und philosophischer Verwirrung. Künstliche Intelligenz (KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie...) bezeichnet Systeme, die in der Lage sind, Aufgaben auszuführen, für die normalerweise menschliche Intelligenz erforderlich wäre. Klingt simpel, ist aber ein Fass ohne Boden – denn was “Intelligenz” ist, streiten Philosophen, Informatiker und Psychologen bis heute.

Das eigentliche Drama beginnt bei der Abgrenzung: KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... ist nicht gleich KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie.... Es gibt “schwache KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie...” (Narrow AI), die klar definierte Aufgaben löst – etwa Spracherkennung, Bilderkennung oder Schachspielen. “Starke KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie...” (General AI) hingegen wäre ein System, das beliebige kognitive Aufgaben auf menschlichem Niveau bewältigen kann. Spoiler: Starke KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... gibt es bis heute nicht, auch wenn jeder zweite Startup-Pitch das Gegenteil behauptet.

Ein weiteres Problem: Der Begriff “Künstliche Intelligenz” wird inflationär auf alles geklebt, was irgendwie mit Algorithmen, Machine LearningMachine Learning: Algorithmische Revolution oder Buzzword-Bingo? Machine Learning (auf Deutsch: Maschinelles Lernen) ist der Teilbereich der künstlichen Intelligenz (KI), bei dem Algorithmen und Modelle entwickelt werden, die aus Daten selbstständig lernen und sich verbessern können – ohne dass sie explizit programmiert werden. Klingt nach Science-Fiction, ist aber längst Alltag: Von Spamfiltern über Gesichtserkennung bis zu Produktempfehlungen basiert mehr digitale Realität... oder Datenanalyse zu tun hat. Die Wahrheit ist: Die meiste “KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie...” im Alltag ist nichts weiter als raffinierte Statistik, Heuristiken oder regelbasierte Automatisierung. Wer also von KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... spricht, sollte wissen, dass semantische Präzision hier mehr wert ist als jede Marketingphrase.

Technisch betrachtet besteht KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... heute aus mehreren Disziplinen: Maschinelles Lernen (Machine LearningMachine Learning: Algorithmische Revolution oder Buzzword-Bingo? Machine Learning (auf Deutsch: Maschinelles Lernen) ist der Teilbereich der künstlichen Intelligenz (KI), bei dem Algorithmen und Modelle entwickelt werden, die aus Daten selbstständig lernen und sich verbessern können – ohne dass sie explizit programmiert werden. Klingt nach Science-Fiction, ist aber längst Alltag: Von Spamfiltern über Gesichtserkennung bis zu Produktempfehlungen basiert mehr digitale Realität...), Deep Learning, Natural Language Processing (NLP), Computer Vision und Robotik sind die wichtigsten Unterfelder. Jedes davon hat seine eigene Geschichte – und seine eigenen Hype-Zyklen. Der Oberbegriff “KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie...” bleibt ein Sammelbecken für alles, was irgendwie nach Zukunft klingt. Aber genau das macht die Historie so spannend und chaotisch.

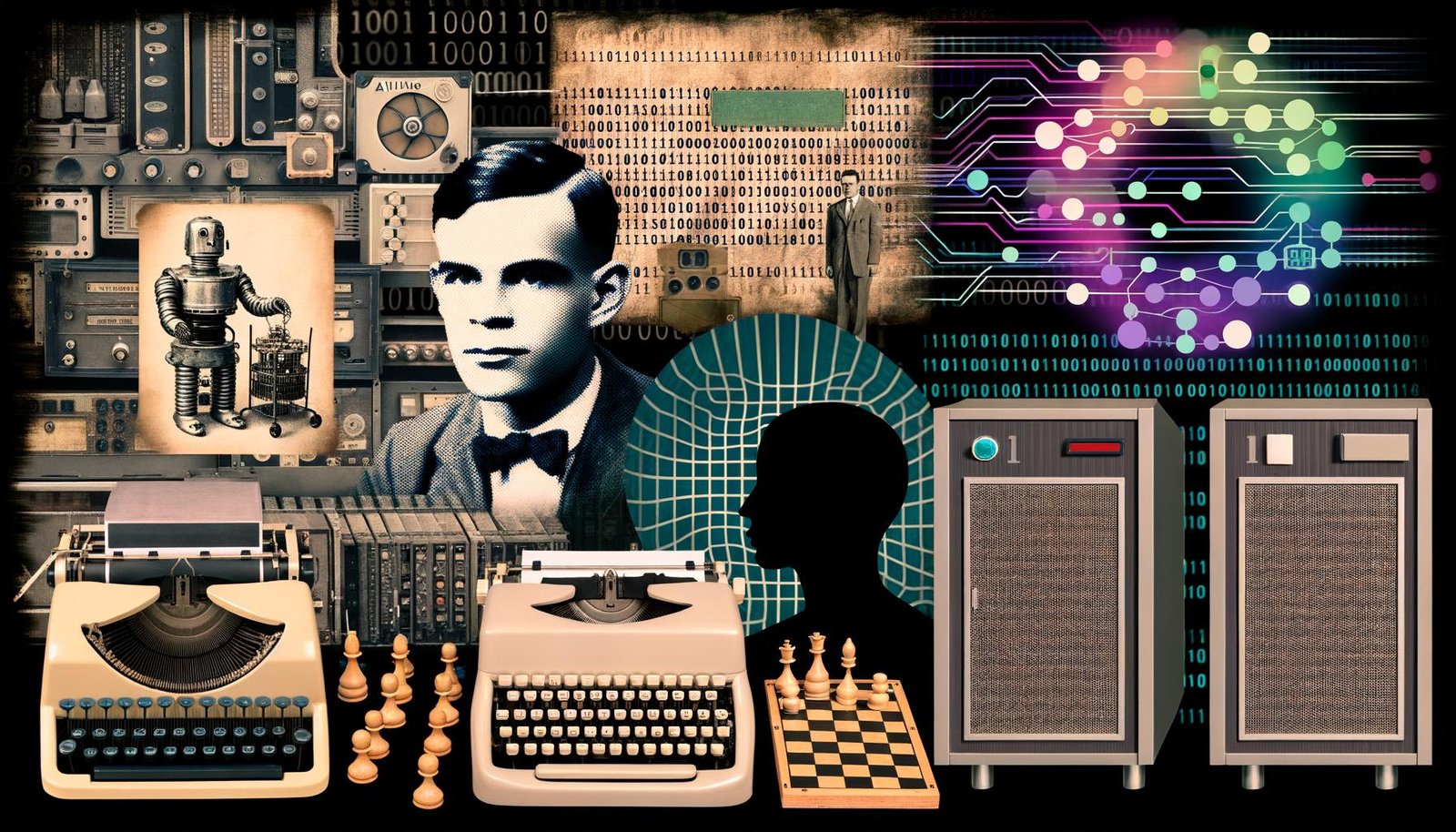

Die frühen Jahre der KI: Alan Turing, symbolische Systeme und erste Fehlschläge

Die Geschichte der Künstlichen Intelligenz beginnt nicht mit Deep Learning oder Chatbots, sondern in den 1940ern – lange bevor Computer überhaupt massentauglich waren. Alan Turing, britischer Mathematiker und Kryptoanalytiker, formulierte 1950 die Frage: “Können Maschinen denken?” Seine Antwort war der berühmte Turing-Test: Eine Maschine gilt dann als intelligent, wenn ein menschlicher Prüfer sie in einem Dialog nicht von einem Menschen unterscheiden kann. Der Turing-Test ist bis heute umstritten, aber er brachte das Konzept “Künstliche Intelligenz” erstmals auf die große Bühne.

In den 1950ern und 1960ern dominierten symbolische KI-Systeme (“Good Old-Fashioned AI”, kurz GOFAI) das Feld. Diese Ansätze arbeiteten mit expliziten Regeln, Logik und Wissensbasen. Programme wie das “Logic Theorist” (1956) oder “ELIZA” (1966) beeindruckten durch regelbasiertes Denken und einfache Dialogsimulation. Doch die Erfolge waren trügerisch: Sobald die Probleme komplexer wurden (z.B. Sprache, Vision), erwiesen sich symbolische Systeme als zu starr und unflexibel.

Die ersten Schachprogramme entstanden bereits in den 1950ern, etwa von Claude Shannon und später IBM. Doch echte Intelligenz? Fehlanzeige. Die Systeme waren auf Mini-Use-Cases beschränkt und scheiterten an jeder Form von “unscharfer” Realität. Trotzdem legten sie den Grundstein für alles, was KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... heute ausmacht – auch wenn die ersten Fehlschläge nicht lange auf sich warten ließen.

Die Ernüchterung kam schnell: Schon in den 1970ern stellte sich heraus, dass symbolische KI-Systeme mit unvollständigen oder widersprüchlichen Daten nicht zurechtkommen. Viele Projekte wurden eingestellt, das Geld versiegte. Willkommen im ersten KI-Winter – einem Vorgeschmack auf die Hype-Zyklen, die die KI-Entwicklung bis heute prägen.

KI-Winter, Machine Learning und das große Erwachen

Wer sich fragt, warum KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... in den 1980ern und 1990ern plötzlich in der Versenkung verschwand, muss die Ära der KI-Winter verstehen. Ein KI-Winter ist das Gegenteil eines Hypes: Überzogene Erwartungen, gefolgt von massiver Enttäuschung, Geldmangel und Abwanderung der Forscher in andere Felder. Die Gründe dafür waren simpel: Die Hardware war zu schwach, die Algorithmen zu ineffizient, die Probleme zu komplex. Die meisten KI-Systeme blieben Prototypen ohne praktischen Nutzen.

Die Wende kam erst mit den Fortschritten im Machine LearningMachine Learning: Algorithmische Revolution oder Buzzword-Bingo? Machine Learning (auf Deutsch: Maschinelles Lernen) ist der Teilbereich der künstlichen Intelligenz (KI), bei dem Algorithmen und Modelle entwickelt werden, die aus Daten selbstständig lernen und sich verbessern können – ohne dass sie explizit programmiert werden. Klingt nach Science-Fiction, ist aber längst Alltag: Von Spamfiltern über Gesichtserkennung bis zu Produktempfehlungen basiert mehr digitale Realität.... Anders als symbolische KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... setzt maschinelles Lernen auf statistische Methoden, die aus Daten Muster extrahieren – statt alles per Hand zu programmieren. Entscheidungsbäume, Neuronale Netze und Support Vector Machines wurden zu den neuen Hoffnungsträgern. In den 1990ern gelang es, erste Anwendungen für Handschrifterkennung und Spracherkennung produktiv einzusetzen – allerdings meist in engen, kontrollierten Umgebungen.

Doch auch hier galt: Die Hardware war der Flaschenhals. Viele Machine-Learning-Algorithmen waren rechnerisch so aufwendig, dass sie erst mit der Verfügbarkeit leistungsfähiger Prozessoren und GPUs in den 2000ern wirklich durchstarten konnten. Die nächste Welle des KI-Hypes stand bevor – und diesmal sollte sie alles überrollen, was vorher als unmöglich galt.

Der zentrale Wendepunkt: Die Wiederentdeckung und massive Skalierung von Neuronalen Netzen, insbesondere von Deep Learning. Das war der Beginn der modernen KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie..., die wir heute kennen – und der endgültige Todesstoß für die rein symbolischen Ansätze der ersten Generation.

Deep Learning, Big Data und die neuen KI-Meilensteine

Ab den 2010ern explodierte die Entwicklung Künstlicher Intelligenz – nicht zuletzt wegen der Kombination aus Big DataBig Data: Datenflut, Analyse und die Zukunft digitaler Entscheidungen Big Data bezeichnet nicht einfach nur „viele Daten“. Es ist das Buzzword für eine technologische Revolution, die Unternehmen, Märkte und gesellschaftliche Prozesse bis ins Mark verändert. Gemeint ist die Verarbeitung, Analyse und Nutzung riesiger, komplexer und oft unstrukturierter Datenmengen, die mit klassischen Methoden schlicht nicht mehr zu bändigen sind. Big Data..., günstiger Cloud-Infrastruktur und Deep-Learning-Algorithmen. Deep Learning nutzt mehrschichtige Künstliche Neuronale Netze zur automatischen Mustererkennung in riesigen Datenmengen. Plötzlich waren Aufgaben lösbar, an denen klassische Algorithmen jahrzehntelang gescheitert waren: Bildklassifikation, maschinelle Übersetzung, autonome Fahrzeuge, Sprachgenerierung.

Der ImageNet-Wettbewerb 2012 war ein Wendepunkt: Das Deep-Learning-Modell AlexNet deklassierte alle traditionellen Ansätze bei der Bildklassifikation. Die Top-Player der Branche – Google, Facebook, Microsoft – investierten Milliarden in KI-Forschung. Spracherkennung, Bilderkennung, Empfehlungssysteme – alles wurde “KI-basiert” und die Entwicklung beschleunigte sich exponentiell.

Weitere Meilensteine: 2016 besiegte AlphaGo, ein Deep-Learning-basiertes System von Google DeepMind, den weltbesten Go-Spieler. Bis dahin galt Go als zu komplex für Maschinen. 2022 läutete OpenAI mit ChatGPT eine neue Ära der generativen KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... ein: Large Language Models (LLM) erzeugen Texte, Codes, Bilder, Musik – und entziehen sich zunehmend der Kontrolle durch ihre Schöpfer.

Technisch entscheidend: Die Entstehung von Transformer-Architekturen (ab 2017, Google “Attention Is All You Need”), die LLMs wie GPT, BERT oder T5 überhaupt erst ermöglichten. Diese Architekturen revolutionierten Natural Language Processing und machten KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... so leistungsfähig, dass sie heute in jedem Smartphone, jeder Suchmaschine und fast jedem digitalen Produkt steckt – oft ohne dass der Nutzer es merkt.

Der Siegeszug von Machine LearningMachine Learning: Algorithmische Revolution oder Buzzword-Bingo? Machine Learning (auf Deutsch: Maschinelles Lernen) ist der Teilbereich der künstlichen Intelligenz (KI), bei dem Algorithmen und Modelle entwickelt werden, die aus Daten selbstständig lernen und sich verbessern können – ohne dass sie explizit programmiert werden. Klingt nach Science-Fiction, ist aber längst Alltag: Von Spamfiltern über Gesichtserkennung bis zu Produktempfehlungen basiert mehr digitale Realität... und Deep Learning hat die KI-Landschaft für immer verändert. Symbolische Systeme sind heute fast vollständig verdrängt. Die neuen Herausforderungen: Datenqualität, Blackbox-Problematik und ethische Risiken, die niemand mehr wirklich im Griff hat.

Die wichtigsten Wendepunkte der KI-Geschichte: Step-by-Step zu disruptiven Meilensteinen

- 1950: Alan Turing publiziert “Computing Machinery and Intelligence” – Geburtsstunde des Turing-Tests und der KI-Idee.

- 1956: Dartmouth-Konferenz – KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... wird offiziell zum Forschungsfeld, John McCarthy prägt den Begriff “Artificial Intelligence”.

- 1966: ELIZA simuliert als ChatbotChatbot: Digitale Dialogmaschinen im Zeitalter der Automatisierung Ein Chatbot ist ein softwarebasierter Dialogpartner, der über Text- oder Sprachschnittstellen automatisiert mit Menschen kommuniziert. Moderne Chatbots nutzen Künstliche Intelligenz (KI) und Natural Language Processing (NLP), um Anfragen zu verstehen, zu verarbeiten und passende Antworten zu liefern. Sie sind längst nicht mehr das Spielzeug aus den 90ern, sondern zentrale Tools für Kundenservice, Marketing,... menschliche Konversation – und wird zur ersten KI-Fehldeutung der Massenmedien.

- 1972-1976: Erster KI-Winter – Symbolische Systeme versagen, Gelder versiegen, Forscher springen ab.

- 1980: Expertensysteme erleben kurzzeitig ein Comeback, scheitern aber an Wartbarkeit und Flexibilität.

- 1997: Deep Blue schlägt Garri Kasparow im Schach – KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... feiert ein PR-Comeback, bleibt aber eng spezialisiert.

- 2012: AlexNet gewinnt ImageNet – Deep Learning wird zum Gamechanger für Computer Vision.

- 2016: AlphaGo besiegt Lee Sedol im Go – KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... meistert “intuitive” Aufgaben, die als menschliches Monopol galten.

- 2022: ChatGPT geht viral – Large Language Models und generative KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... werden Mainstream, Kontrollverlust inklusive.

Jeder dieser Meilensteine markiert einen Wendepunkt, an dem die KI-Entwicklung einen Gang höher schaltet – oder komplett gegen die Wand fährt. Die Geschichte der Künstlichen Intelligenz ist kein linearer Fortschritt, sondern ein ständiges Auf und Ab aus Euphorie, Scheitern und radikalen Neuanfängen.

Blockaden, Blackbox und Kontrollverlust: Die hässlichen Seiten der modernen KI

Wer glaubt, KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... sei heute “fertig” oder unter Kontrolle, lebt in einer Parallelwelt. Die Herausforderungen wachsen schneller als die Lösungen. Die Blackbox-Problematik – also die Unmöglichkeit, tief lernende Modelle vollständig nachvollziehbar zu machen – ist das größte ungelöste Problem der Branche. Kein Mensch kann heute erklären, warum ein LLM wie GPT-4 eine bestimmte Antwort gibt. Das ist technisch brisant und gesellschaftlich brandgefährlich.

Hinzu kommen ethische und gesellschaftliche Blockaden. Diskriminierende Trainingsdaten, algorithmische Vorurteile (“Bias”), Deepfakes, Desinformation, Jobverlust – KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... ist längst kein reines Technikthema mehr, sondern ein Pulverfass für Politik und Gesellschaft. DatenschutzDatenschutz: Die unterschätzte Macht über digitale Identitäten und Datenflüsse Datenschutz ist der Begriff, der im digitalen Zeitalter ständig beschworen, aber selten wirklich verstanden wird. Gemeint ist der Schutz personenbezogener Daten vor Missbrauch, Überwachung, Diebstahl und Manipulation – egal ob sie in der Cloud, auf Servern oder auf deinem Smartphone herumlungern. Datenschutz ist nicht bloß ein juristisches Feigenblatt für Unternehmen, sondern..., Urheberrecht, Transparenz und Haftung sind ungelöste Baustellen, die jeden Tag größer werden.

Die Datenbasis moderner KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... ist ein weiteres Problem: Wer keine riesigen, sauberen und aktuellen Datensätze hat, baut Luftschlösser. Gleichzeitig sind die Datenquellen oft undurchsichtig, rechtlich fragwürdig oder schlicht unethisch beschafft. Die Folge: KI-Modelle lernen, was sie nicht lernen sollten – und niemand weiß, wie man das nachhaltig verhindert.

Technisch gesehen sind skalierbare Hardware (GPUs, TPUs), effiziente Trainingsverfahren und spezialisierte Frameworks (TensorFlow, PyTorch) heute das Rückgrat jeder ernsthaften KI-Entwicklung. Doch selbst mit High-End-Infrastruktur bleibt die Kontrolle über die Ergebnisse eine Illusion. Die Geschwindigkeit, mit der KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... sich selbst weiterentwickelt, überfordert klassische Kontrollmechanismen – und das ist erst der Anfang.

Fazit: Künstliche Intelligenz als Dauer-Disruption – und warum das nächste Zeitalter schon beginnt

Künstliche Intelligenz ist kein Trend, kein Hype und schon gar keine abgeschlossene Technologie. Die Geschichte der KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... ist ein permanenter Zyklus aus Übertreibung, Ernüchterung und radikalen Durchbrüchen. Wer heute auf ChatGPT, Midjourney oder AlphaGo blickt, sieht nur die Spitze eines Eisbergs, unter dem Jahrzehnte voller gescheiterter Ansätze, zerplatzter Träume und technischer Revolutionen liegen. Die Meilensteine der KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... sind Wendepunkte – und jeder einzelne davon ist der Startschuss für neue, noch größere Disruptionen.

Die Wahrheit ist unbequem: Niemand hat Künstliche Intelligenz noch wirklich unter Kontrolle. Die Geschwindigkeit der Entwicklung überfordert Politik, Wirtschaft und Gesellschaft gleichermaßen. Und während das nächste große KI-Modell schon trainiert wird, bleibt eines sicher: Die Geschichte der Künstlichen Intelligenz ist noch lange nicht am Ende. Sie ist der Anfang einer Ära, in der Technologie nicht mehr fragt, sondern entscheidet. Willkommen im Maschinenzeitalter – und viel Spaß beim Versuch, mitzuhalten.