GPT Scheduler Strukturen: Clever planen mit KI-Architekturen

Hand aufs Herz: Du glaubst, ein GPT Scheduler ist einfach nur ein bisschen KI-Zauber, der Termine jongliert? Falsch gedacht. Wer 2024 ernsthaft noch manuell plant oder sich auf primitive Automatisierungen verlässt, verschenkt nicht nur Zeit, sondern auch Umsatz, Skalierung und Nerven. In diesem Artikel zerlegen wir die Mechanik moderner GPT Scheduler Strukturen – technisch, ehrlich, gnadenlos. Wer sein KI-Stack nicht versteht, bleibt im Mittelmaß hängen. Willkommen bei der neuen Königsdisziplin im Online-Marketing: smarter, automatisierter, KI-getriebener WorkflowWorkflow: Effizienz, Automatisierung und das Ende der Zettelwirtschaft Ein Workflow ist mehr als nur ein schickes Buzzword für Prozess-Junkies und Management-Gurus. Er ist das strukturelle Skelett, das jeden wiederholbaren Arbeitsablauf in Firmen, Agenturen und sogar in Ein-Mann-Betrieben zusammenhält. Im digitalen Zeitalter bedeutet Workflow: systematisierte, teils automatisierte Abfolge von Aufgaben, Zuständigkeiten, Tools und Daten – mit dem einen Ziel: maximale Effizienz... – oder kurz gesagt, das Ende von fauler Planung.

- Was ein GPT Scheduler wirklich ist – und warum „einfach nur KI“ nicht reicht

- Die wichtigsten Architektur-Prinzipien moderner GPT Scheduler

- Wie du GPT Scheduler Strukturen in dein Tech-Ökosystem integrierst

- Warum Prompt-Engineering und Kontextmanagement die versteckten Gamechanger sind

- Best Practices für Workflow-Automatisierung mit KI-Tools

- Skalierbarkeit, Security, API-Design – die unterschätzten Tretminen

- Schritt-für-Schritt: So implementierst du deinen eigenen GPT Scheduler

- Welche Fehler fast alle machen – und wie du dir monatelange Frustration sparst

GPT Scheduler Strukturen sind das Rückgrat jeder ernsthaften KI-gestützten Planung. Die Zeiten, in denen ein Scheduler einfach eine To-Do-Liste nach Uhrzeit abarbeitet, sind vorbei. Heute reden wir über hochdynamische, kontextbewusste Architekturen, die mit Natural Language Processing (NLP), Machine LearningMachine Learning: Algorithmische Revolution oder Buzzword-Bingo? Machine Learning (auf Deutsch: Maschinelles Lernen) ist der Teilbereich der künstlichen Intelligenz (KI), bei dem Algorithmen und Modelle entwickelt werden, die aus Daten selbstständig lernen und sich verbessern können – ohne dass sie explizit programmiert werden. Klingt nach Science-Fiction, ist aber längst Alltag: Von Spamfiltern über Gesichtserkennung bis zu Produktempfehlungen basiert mehr digitale Realität... und skalierbaren Backend-Systemen arbeiten. Wer glaubt, ein bisschen KI-API in Zapier reicht, spielt in der Kreisliga. Die Konkurrenz baut längst auf orchestrierten GPT Scheduler Strukturen, die Aufgaben, Ressourcen, Deadlines und sogar Kundenkommunikation intelligent koordinieren – und das alles quasi in Echtzeit.

Was die meisten dabei komplett unterschätzen: Ein GPT Scheduler ist kein magischer Automat, sondern ein komplexes Zusammenspiel aus Prompt-Engineering, Datenmodellierung, API-Integration und systematischer Kontextverwaltung. Ohne ein sauberes technisches Fundament wird aus der KI-Planung schnell ein fehleranfälliges Chaos. Und genau das ist der Grund, warum so viele Projekte grandios scheitern, während ein paar wenige – mit dem richtigen Setup – den Markt dominieren.

Wenn du verstehen willst, wie GPT Scheduler Strukturen wirklich funktionieren, wie du sie sauber aufbaust und welche Stolperfallen dich auf technischer Ebene erwarten, brauchst du mehr als ein paar bunte Tutorials. Du brauchst echte Architekturkompetenz, Erfahrung und die Bereitschaft, tief in die Materie einzutauchen – genau das bekommst du hier. Wir reden nicht über Plug-and-Play, sondern über das, was KI-Automatisierung wirklich ausmacht: Effizienz, Skalierbarkeit, Robustheit und ein verdammt gutes Verständnis für KI-Ökosysteme.

GPT Scheduler Strukturen: Definition, Architektur und Haupt-Keywords

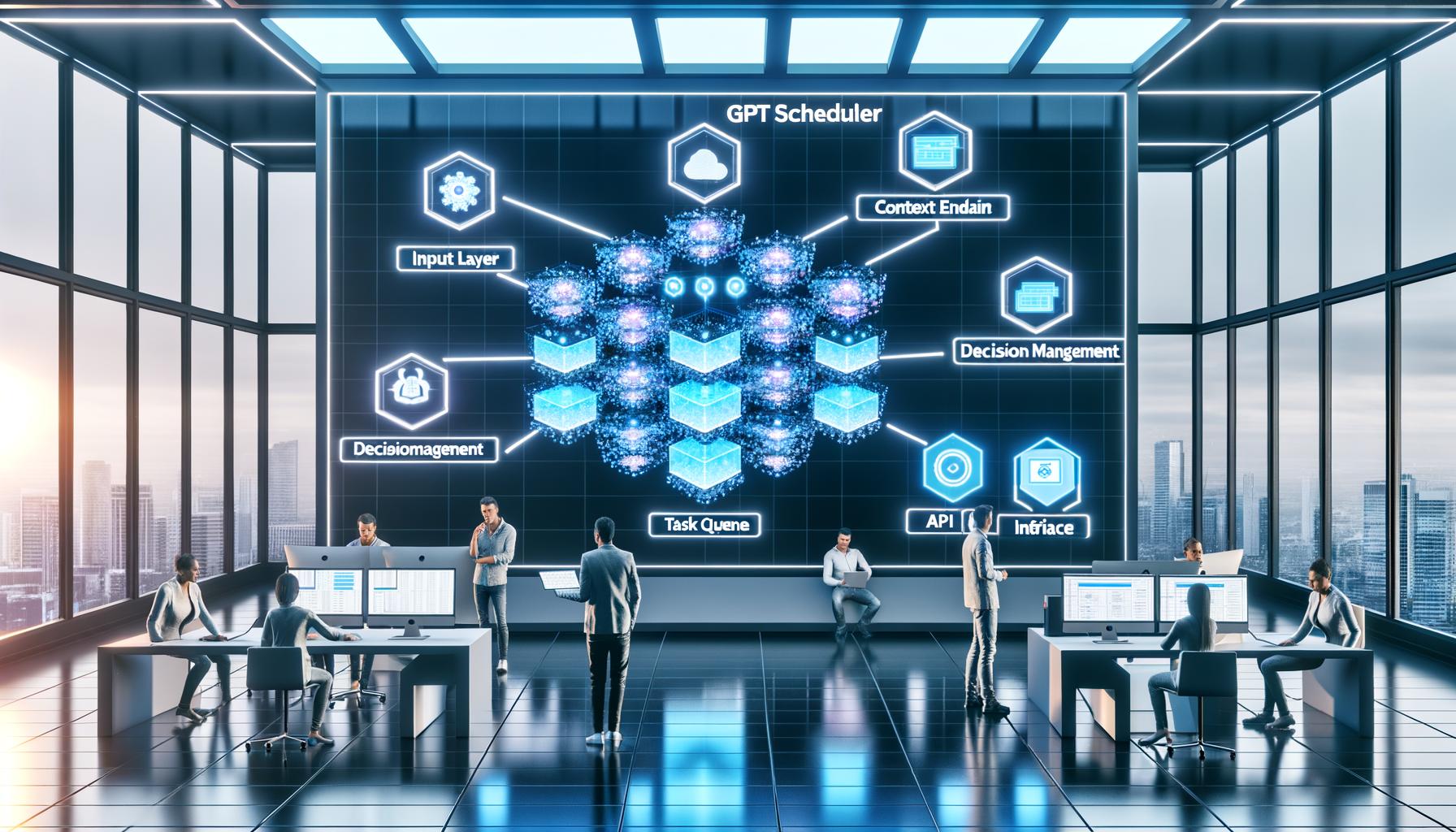

Der Begriff „GPT Scheduler“ klingt nach einem schicken KI-Feature, ist aber in der Praxis ein hochkomplexer, modularer Systembaustein. Im Kern geht es um die automatisierte zeitliche Koordination von Aufgaben, Ressourcen oder Kommunikationsprozessen – unter Einsatz von generativer KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie..., insbesondere GPT-Modellen (Generative Pre-trained Transformer). Typische GPT Scheduler Strukturen bestehen aus mehreren Schichten: einem Input-Layer (Prompt-Handler), Kontext-Management, Decision-Engine, Task-Queue und einer API-Schnittstelle zur Außenwelt. Klingt nach Overkill? Wer skaliert, weiß: Ohne dieses Fundament bist du Spielball der Systemgrenzen.

GPT Scheduler Strukturen setzen auf Natural Language Processing, um Scheduling-Requests zu verstehen, zu priorisieren und – hier liegt der Unterschied zur Oldschool-Logik – semantisch zu verarbeiten. Das bedeutet: Der Scheduler erkennt nicht nur, dass „Meeting morgen um 9“ ein Termin ist, sondern versteht Abhängigkeiten, Ressourcenknappheit, wiederkehrende Muster und sogar Absichten hinter den Anfragen. Genau hier wird aus banaler Task-Liste ein echtes KI-Framework.

Ein weiteres zentrales Element: Kontextmanagement. Moderne GPT Scheduler Strukturen verwalten Session-Kontexte persistent, erkennen User-Identitäten, Rollen und sogar historische Daten. Ohne diese Fähigkeit ist jede Planung ein Blindflug. Dazu kommt das Prompt-Engineering: Die Art, wie du die GPT-Modelle fütterst, entscheidet über Präzision, Effizienz und Fehlerquote. Wer hier schludert, bekommt Scheduling-Desaster statt Automatisierung.

Die wichtigsten SEO-Keywords für diese Architekturen sind: GPT Scheduler, KI-Planung, Prompt-Engineering, Kontextmanagement, Workflow-Automatisierung, API-Integration, Machine LearningMachine Learning: Algorithmische Revolution oder Buzzword-Bingo? Machine Learning (auf Deutsch: Maschinelles Lernen) ist der Teilbereich der künstlichen Intelligenz (KI), bei dem Algorithmen und Modelle entwickelt werden, die aus Daten selbstständig lernen und sich verbessern können – ohne dass sie explizit programmiert werden. Klingt nach Science-Fiction, ist aber längst Alltag: Von Spamfiltern über Gesichtserkennung bis zu Produktempfehlungen basiert mehr digitale Realität... Scheduling und KI-basierte Prozessoptimierung. In den ersten Abschnitten dieses Artikels wirst du daher den Begriff „GPT Scheduler“ mindestens fünfmal lesen – nicht nur, weil Google es mag, sondern weil es das Thema ist, das alles verändert.

Architektur-Prinzipien moderner GPT Scheduler: Von der Theorie zum Tech-Stack

Wer einen GPT Scheduler bauen oder professionell einsetzen will, muss die Architekturprinzipien verstehen. Ein echtes GPT Scheduler System besteht aus mehreren, klar getrennten Komponenten. Jede davon erfüllt eine präzise Aufgabe – vom intelligenten Input Parsing über Kontextmanagement bis zur Lastverteilung und Fehlerbehandlung. Dass das alles nicht in einem Monolithen endet, sondern als Microservice-Architektur oder in modularen Serverless-Stacks läuft, ist 2024 Pflicht, nicht Kür.

Der erste Baustein ist der Prompt-Handler. Hier werden sämtliche Anfragen aus E-Mail, Chat, APIAPI – Schnittstellen, Macht und Missverständnisse im Web API steht für „Application Programming Interface“, zu Deutsch: Programmierschnittstelle. Eine API ist das unsichtbare Rückgrat moderner Softwareentwicklung und Online-Marketing-Technologien. Sie ermöglicht es verschiedenen Programmen, Systemen oder Diensten, miteinander zu kommunizieren – und zwar kontrolliert, standardisiert und (im Idealfall) sicher. APIs sind das, was das Web zusammenhält, auch wenn kein Nutzer je eine... oder anderen Quellen gesammelt und vorverarbeitet. Wichtig: Einfache Keyword-Erkennung reicht nicht. Ein GPT Scheduler analysiert semantisch, versteht Absichten (IntentIntent: Die Grundlage für zielgerichtetes Online-Marketing und SEO Intent – oder auf Deutsch: Suchintention – ist das Herzstück jeder erfolgreichen Online-Marketing- und SEO-Strategie. Hinter jedem Klick, jeder Suchanfrage und jedem Content-Stück steht eine Absicht, die den Unterschied zwischen zufälligem Traffic und konvertierenden Nutzern macht. Wer den Intent nicht versteht, rennt blind durch das digitale Dunkel und produziert Content, der niemanden... Detection), erkennt Named Entities und extrahiert relevante Zeit-, Ressourcen- und Aufgabenparameter.

Danach übernimmt das Kontextmanagement. Hier werden Userdaten, Historie, Rollen und laufende Tasks persistent gespeichert und verwaltet – am besten in einer NoSQL-Datenbank wie MongoDB oder einem Redis-Store für schnelle Zugriffe. Diese Ebene entscheidet, ob dein GPT Scheduler Kontextverluste hat (und damit Fehler produziert) oder eben nicht.

Die Decision-Engine ist das Herzstück: Hier greifen GPT-Modelle (z.B. GPT-4 Turbo, Open Source Alternativen wie Llama oder spezialisierte Scheduling-Modelle) auf den Kontext zu, generieren Vorschläge, lösen Konflikte und priorisieren Aufgaben. Die Ergebnisse landen in der Task Queue (z.B. mit RabbitMQ, Celery oder AWS SQS) und werden schließlich über die API-Schicht an Frontends, Kalender oder Drittsysteme ausgeliefert.

Die wichtigsten Architektur-Prinzipien im Überblick:

- Modularisierung: Getrennte Services für Input, Kontext, Entscheidung und Output

- Asynchrone Verarbeitung: Task Queues für Skalierbarkeit und Fehlertoleranz

- API-First: Klare REST oder GraphQL-Schnittstellen für Integration

- Persistenter Kontext: State Management für Sessions und Userdaten

- Security by Design: Authentifizierung, Rate Limiting und Data Governance

Wer diese Prinzipien ignoriert, baut ein fragiles System – und bekommt spätestens bei Lastspitzen oder Fehlern die Quittung. Keine Ausreden mehr: GPT Scheduler Architektur ist nichts für Hobby-Clicker, sondern für echte Tech-Profis.

Prompt-Engineering und Kontextmanagement: Die unsichtbaren Erfolgsfaktoren von GPT Scheduler Strukturen

Prompt-Engineering klingt nach Buzzword, ist aber im Kontext von GPT Scheduler Strukturen der entscheidende Hebel für Präzision und Effizienz. Ein schlecht gebauter Prompt produziert Chaos: unklare Termine, falsche Ressourcenverteilung, inkonsistente Antworten. Wer die GPT-Modelle nicht gezielt mit Kontext und Constraints füttert, bekommt Scheduling-Entropie statt Automatisierung.

Im Bereich GPT Scheduler bedeutet gutes Prompt-Engineering, dass du nicht nur die eigentliche Anfrage („Plane Meeting mit Max morgen 9 Uhr“) sauber übergibst, sondern alle relevanten Metadaten (User, Priorität, Ressourcen, Deadlines, Abhängigkeiten) als strukturierte Zusatzinformationen einbindest. Je präziser und vollständiger der Prompt, desto besser das Scheduling-Ergebnis – und desto weniger musst du nachkorrigieren.

Kontextmanagement ist der zweite Gamechanger. Jeder GPT Scheduler, der ernst genommen werden will, muss Kontexte persistent und konsistent verwalten. Das heißt: Nicht nur innerhalb einer Session, sondern auch über Tage, Wochen oder mehrere Devices hinweg. Dazu braucht es State Management (z.B. JWT Tokens, Session Stores) und ein robustes Identity Management. Ohne das sind Deadlines, Ressourcen und Abhängigkeiten nach dem Logout sofort verloren – ein No-Go für jeden professionellen Einsatz.

Ein Beispiel für effizientes Prompt-Engineering im GPT Scheduler-Kontext:

- 1. Anfrage analysieren: Entitäten, Zeiten, Personen, Ressourcen extrahieren

- 2. Kontext erweitern: Historie, User-Präferenzen, laufende Tasks dazuspielen

- 3. Constraints definieren: Deadlines, Ressourcenlimits, Prioritäten als System-Message zufügen

- 4. Prompt strukturieren: Klare, maschinenlesbare Vorgaben (JSON, YAML oder klare Bullet-Points)

- 5. Output validieren: GPT-Antwort gegen Schema prüfen, Fehler abfangen

Wer diesen Ablauf nicht sauber implementiert, bekommt Scheduling-Fehler, die im Zweifel ganze Prozesse lahmlegen. Prompt-Engineering und Kontextmanagement sind keine Kür, sondern die Grundlage jeder erfolgreichen GPT Scheduler Struktur.

Integration von GPT Scheduler Strukturen in bestehende Systeme: APIs, Workflows und Security

Der größte Fehler beim Thema GPT Scheduler: Die Annahme, dass Integration ein Plug-and-Play-Thema ist. Falsch. Ohne saubere API-Architektur, klares Berechtigungskonzept und tiefes Verständnis für bestehende Workflows wird aus dem KI-Scheduler ein Sicherheitsrisiko oder ein Bottleneck. Die Integration moderner GPT Scheduler Strukturen folgt festen Prinzipien – und ist technisch anspruchsvoll.

Das fängt bei der APIAPI – Schnittstellen, Macht und Missverständnisse im Web API steht für „Application Programming Interface“, zu Deutsch: Programmierschnittstelle. Eine API ist das unsichtbare Rückgrat moderner Softwareentwicklung und Online-Marketing-Technologien. Sie ermöglicht es verschiedenen Programmen, Systemen oder Diensten, miteinander zu kommunizieren – und zwar kontrolliert, standardisiert und (im Idealfall) sicher. APIs sind das, was das Web zusammenhält, auch wenn kein Nutzer je eine... an: Ein GPT Scheduler braucht eine offene, dokumentierte REST- oder GraphQL-API, die sämtliche Scheduling-Operationen sauber kapselt. Dazu gehören Authentifizierungsmechanismen (OAuth2, APIAPI – Schnittstellen, Macht und Missverständnisse im Web API steht für „Application Programming Interface“, zu Deutsch: Programmierschnittstelle. Eine API ist das unsichtbare Rückgrat moderner Softwareentwicklung und Online-Marketing-Technologien. Sie ermöglicht es verschiedenen Programmen, Systemen oder Diensten, miteinander zu kommunizieren – und zwar kontrolliert, standardisiert und (im Idealfall) sicher. APIs sind das, was das Web zusammenhält, auch wenn kein Nutzer je eine... Keys, JWT), Rate Limiting und Logging. Wer seine APIAPI – Schnittstellen, Macht und Missverständnisse im Web API steht für „Application Programming Interface“, zu Deutsch: Programmierschnittstelle. Eine API ist das unsichtbare Rückgrat moderner Softwareentwicklung und Online-Marketing-Technologien. Sie ermöglicht es verschiedenen Programmen, Systemen oder Diensten, miteinander zu kommunizieren – und zwar kontrolliert, standardisiert und (im Idealfall) sicher. APIs sind das, was das Web zusammenhält, auch wenn kein Nutzer je eine... ohne Rate Limiting anbindet, öffnet den DDoS-Angriffen Tür und Tor – spätestens bei ersten Produktivlasten bricht das System dann zusammen.

Die Workflow-Integration bedeutet: Der GPT Scheduler muss in bestehende CRM-, ERP- oder Kommunikationssysteme andocken können. Das geht über Webhooks, Event Bus Systeme (z.B. Kafka, RabbitMQ) oder dedizierte Middleware. Jedes Integrationsthema bringt eigene Stolperfallen: Inkompatible Datenformate, fehlende Trigger, schlechte Fehlerbehandlung oder asynchrone Konflikte. Wer hier nicht sauber arbeitet, produziert Scheduling-Desaster, die mehr schaden als nützen.

Security ist der unterschätzte Elefant im Raum. Ein GPT Scheduler verarbeitet sensible Daten: Termine, User-Identitäten, Ressourcenpläne. Ohne Verschlüsselung (TLS), rollenbasierte Zugriffskontrolle (RBAC) und systematisches Monitoring (SIEM, Audit Logs) wird aus dem Scheduler schnell ein Sicherheits-Albtraum. Und: Jeder GPT Scheduler muss auf DatenschutzDatenschutz: Die unterschätzte Macht über digitale Identitäten und Datenflüsse Datenschutz ist der Begriff, der im digitalen Zeitalter ständig beschworen, aber selten wirklich verstanden wird. Gemeint ist der Schutz personenbezogener Daten vor Missbrauch, Überwachung, Diebstahl und Manipulation – egal ob sie in der Cloud, auf Servern oder auf deinem Smartphone herumlungern. Datenschutz ist nicht bloß ein juristisches Feigenblatt für Unternehmen, sondern... (DSGVO, GDPR) geprüft werden – inkl. Datenlöschung, Logging und Consent-Management. Sonst wird die KI-Planung zum Compliance-Risiko.

Die Integration von GPT Scheduler Strukturen ist ein Projekt für Profis – und kein Thema für Bastler oder “API-Connector”-Fans. Wer sich hier übernimmt, riskiert Produktivitätsausfälle und Datenschutz-Skandale.

Schritt-für-Schritt: So implementierst du eine robuste GPT Scheduler Struktur

Kein Bock auf Theorie? Hier kommt die Schritt-für-Schritt-Anleitung, wie du eine skalierbare, robuste GPT Scheduler Struktur von Grund auf aufbaust. Achtung: Wer hier abkürzt, bekommt die Quittung in Form von Bugs, Ausfällen oder Sicherheitslücken.

- 1. Requirements Engineering:

Definiere die genauen Anforderungen: Welche Aufgaben, Ressourcen, Userrollen und Integrationspunkte müssen abgedeckt werden? Ohne sauberes Lastenheft geht nichts. - 2. Architekturentwurf:

Skizziere die Systemarchitektur: Input-Layer, Kontextmanagement, Decision-Engine, Task-Queue, API-Gateway. Modularisierung ist Pflicht. - 3. Auswahl des GPT-Modells:

Entscheide, ob du OpenAI GPT-4 (APIAPI – Schnittstellen, Macht und Missverständnisse im Web API steht für „Application Programming Interface“, zu Deutsch: Programmierschnittstelle. Eine API ist das unsichtbare Rückgrat moderner Softwareentwicklung und Online-Marketing-Technologien. Sie ermöglicht es verschiedenen Programmen, Systemen oder Diensten, miteinander zu kommunizieren – und zwar kontrolliert, standardisiert und (im Idealfall) sicher. APIs sind das, was das Web zusammenhält, auch wenn kein Nutzer je eine...), eine Open Source Alternative oder ein Spezialmodell nutzt. Achte auf Latenz, Kosten und Customization-Optionen. - 4. Prompt-Engineering-Prozess etablieren:

Entwickle standardisierte Prompt-Templates, die alle relevanten Kontextdaten und Constraints einbinden. Teste verschiedene Varianten auf Präzision und Performance. - 5. Kontextmanagement implementieren:

Baue ein persistentes Kontextsystem (z.B. mit Redis, MongoDB). Implementiere User-Identifikation, Sessions und Historienverwaltung. - 6. Decision-Engine aufsetzen:

Kapsle die Logik, die GPT-Modelle ansteuert, Konflikte löst und Prioritäten vergibt. Implementiere Fallback-Mechanismen für Fehlerfälle. - 7. Task Queue und Output-Delivery:

Integriere eine asynchrone Task Queue für die Abarbeitung und Zustellung. Nutze Message Broker für Skalierbarkeit. - 8. API-Gateway und Security-Layer:

Implementiere Authentifizierung, Autorisierung, Rate Limiting, Monitoring und Logging. Dokumentiere die APIAPI – Schnittstellen, Macht und Missverständnisse im Web API steht für „Application Programming Interface“, zu Deutsch: Programmierschnittstelle. Eine API ist das unsichtbare Rückgrat moderner Softwareentwicklung und Online-Marketing-Technologien. Sie ermöglicht es verschiedenen Programmen, Systemen oder Diensten, miteinander zu kommunizieren – und zwar kontrolliert, standardisiert und (im Idealfall) sicher. APIs sind das, was das Web zusammenhält, auch wenn kein Nutzer je eine... sauber (OpenAPI/Swagger). - 9. Integrationstests und Monitoring:

Baue automatisierte Tests für alle Komponenten. Implementiere Monitoring (Prometheus, Grafana) und Alerting für Produktionsbetrieb. - 10. Rollout und Feedback-Loop:

Starte mit einem MVP, sammle Userfeedback, optimiere Prompts, Kontextmanagement und Integration laufend weiter.

Wer diese Schritte sauber abarbeitet, baut nicht nur irgendeinen GPT Scheduler, sondern ein echtes Power-Tool – und gewinnt den Automatisierungsvorsprung, von dem andere nur träumen.

Typische Fehler bei GPT Scheduler Strukturen – und wie du sie vermeidest

Die meisten, die mit GPT Scheduler Strukturen arbeiten, tappen in dieselben Fallen: Sie unterschätzen die Komplexität, sparen beim Kontextmanagement oder verzichten auf saubere API-Architektur. Das Ergebnis: Scheduling-Fehler, Datenverlust, unklare Prioritäten – und im schlimmsten Fall Security-Breaches.

Ein Klassiker: Prompt-Overload. Wer den GPT Scheduler mit zu viel, zu wenig oder unstrukturierten Daten füttert, produziert entweder unklare Antworten oder Systemausfälle. Hier hilft nur: Präzise Prompts, klare Constraints, konsistenter Datenfluss.

Der zweite Dauerbrenner: Kontextverlust. Wenn Sitzungen nicht sauber gespeichert werden, gehen Tasks, Deadlines und Userdaten verloren – der Scheduler wird unzuverlässig. Persistente Kontextverwaltung ist daher Pflicht, kein Nice-to-have.

Drittens: Fehlende Security. Unverschlüsselte APIs, fehlendes Rate Limiting oder keine Zugriffskontrolle machen den GPT Scheduler zur Einfallstür für Angreifer. Security muss von Anfang an mitgedacht werden – jeder Shortcut rächt sich.

Und schließlich: Ignoranz gegenüber Skalierbarkeit. Wer GPT Scheduler Strukturen nicht für Lastspitzen, Ausfälle und horizontale Erweiterung auslegt, produziert ein Bottleneck – und verliert im entscheidenden Moment die Kontrolle. Die Lösung: Microservices, asynchrone Verarbeitung und systematisches Monitoring.

Fazit: GPT Scheduler Strukturen als Gamechanger im Online-Marketing-Techstack

GPT Scheduler Strukturen sind der neue Goldstandard für Automatisierung, Effizienz und Skalierbarkeit im Online-Marketing. Wer sie richtig aufbaut, gewinnt Zeit, Übersicht und einen unschlagbaren Wettbewerbsvorteil. Aber: Die Technik dahinter ist kein Spielzeug, sondern ein hochkomplexes System, das nur mit sauberem Architekturverständnis, durchdachtem Prompt-Engineering und robuster API-Integration funktioniert.

Wer glaubt, GPT Scheduler seien Plug-and-Play-Tools, hat das Thema nicht verstanden – und wird von smarteren Konkurrenten überrollt. Die Zukunft gehört denen, die KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... nicht nur nutzen, sondern wirklich beherrschen. Baue deine GPT Scheduler Struktur wie ein Profi – sonst bist du morgen der nächste, der über ineffiziente Prozesse jammert, während andere längst automatisiert skalieren. Willkommen im Maschinenraum der Zukunft. Willkommen bei 404.