SEO bei GraphQL Integration: So klappt’s mit Ranking

Wenn du denkst, dass SEOSEO (Search Engine Optimization): Das Schlachtfeld der digitalen Sichtbarkeit SEO, kurz für Search Engine Optimization oder Suchmaschinenoptimierung, ist der Schlüsselbegriff für alle, die online überhaupt gefunden werden wollen. Es bezeichnet sämtliche Maßnahmen, mit denen Websites und deren Inhalte so optimiert werden, dass sie in den unbezahlten, organischen Suchergebnissen von Google, Bing und Co. möglichst weit oben erscheinen. SEO ist längst... nur noch was für klassische Server-Render-Websites ist, dann hast du die Rechnung ohne GraphQL gemacht. Denn moderne APIs und Single-Page-Applications (SPAs) mit GraphQL setzen alles daran, dein RankingRanking: Das kompromisslose Spiel um die Sichtbarkeit in Suchmaschinen Ranking bezeichnet im Online-Marketing die Platzierung einer Website oder einzelner URLs in den organischen Suchergebnissen einer Suchmaschine, typischerweise Google. Es ist der digitale Olymp, auf den jeder Website-Betreiber schielt – denn nur wer bei relevanten Suchanfragen weit oben rankt, existiert überhaupt im Kopf der Zielgruppe. Ranking ist keine Glückssache, sondern das... zu sabotieren – oder es eben zu retten, wenn du es richtig anstellst. Hier bekommst du den ultimativen Deep Dive, wie du deine GraphQL-Integration SEO-tauglich machst, damit Google dich nicht nur sieht, sondern auch rankt. Schnall dich an, es wird technisch, es wird tief, und es wird verdammt wichtig.

- Was GraphQL ist und warum es im SEO-Game eine zentrale Rolle spielt

- Die Herausforderungen bei der SEO-Optimierung von GraphQL-basierten Websites

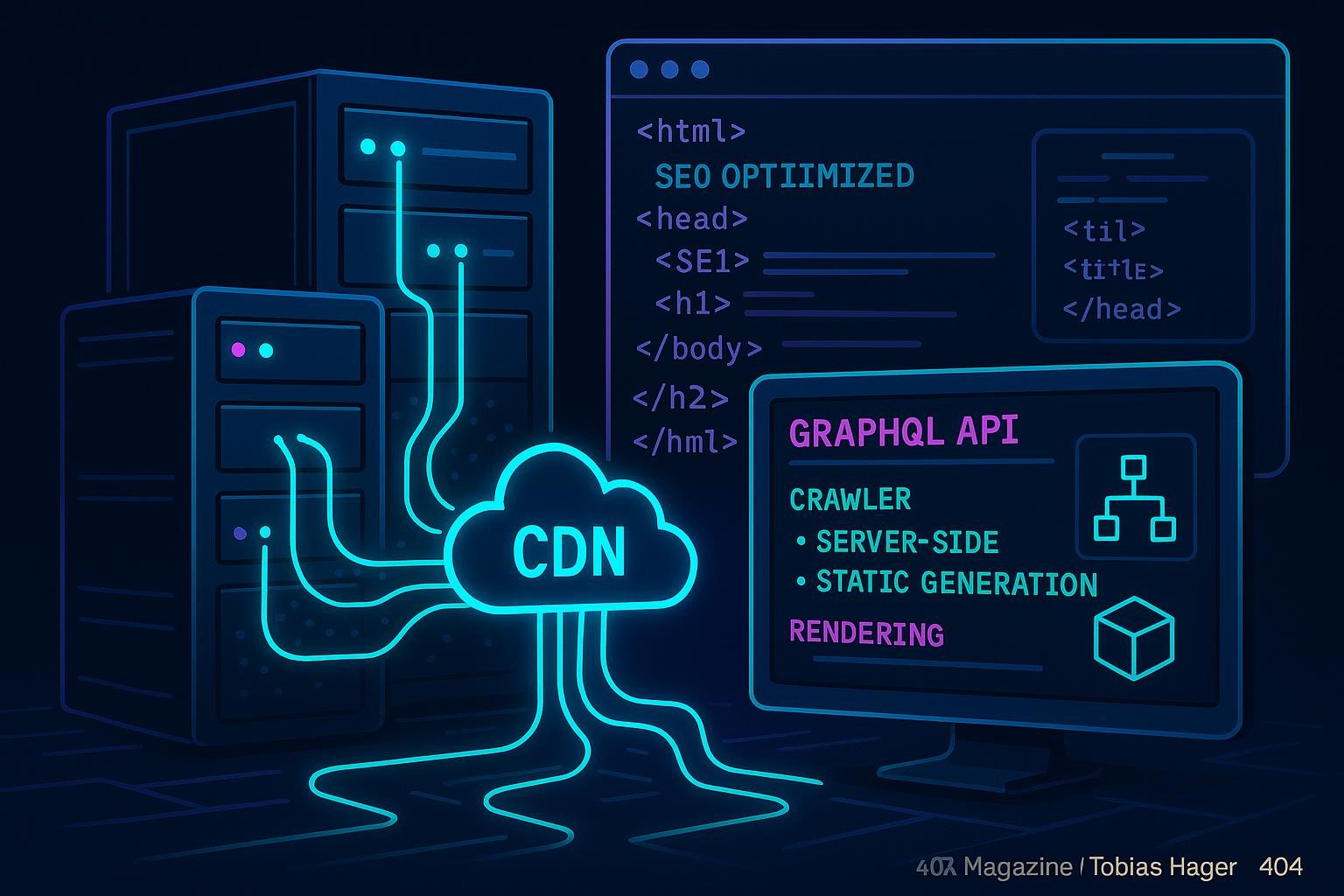

- Technische Voraussetzungen: CrawlerCrawler: Die unsichtbaren Arbeiter der digitalen Welt Crawler – auch bekannt als Spider, Bot oder Robot – sind automatisierte Programme, die das Fundament des modernen Internets bilden. Sie durchforsten systematisch Webseiten, erfassen Inhalte, analysieren Strukturen und übermitteln diese Daten an Suchmaschinen, Plattformen oder andere zentrale Dienste. Ohne Crawler wäre Google blind, SEO irrelevant und das World Wide Web ein chaotischer..., Rendering, Server-Setup

- Implementierung von serverseitigem Rendering (SSR) bei GraphQL

- Pre-Rendering und Static Site Generation (SSG) für SEO-Boosts

- JavaScript-Rendering, Hydration und clientseitiges Nachladen

- Tools und Techniken zur Analyse und Verbesserung der GraphQL-SEO-Performance

- Langfristige Strategie: Monitoring, Updates und Best Practices

- Fehlerquellen, die du unbedingt vermeiden solltest

- Fazit: Warum technisches SEOTechnisches SEO: Die unsichtbare Architektur für Top-Rankings Technisches SEO ist das ungeliebte Stiefkind der Suchmaschinenoptimierung – und gleichzeitig ihr Fundament. Ohne saubere Technik kann der beste Content, die coolste Marke und der teuerste Linkaufbau einpacken. Technisches SEO umfasst sämtliche Maßnahmen, die gewährleisten, dass Suchmaschinen Websites effizient crawlen, verstehen und indexieren können. Es geht um Geschwindigkeit, Struktur, Sicherheit und Zugänglichkeit –... bei GraphQL dein Schlüssel zum Erfolg ist

Der technische Fortschritt schreitet unaufhaltsam voran, und GraphQL ist dabei, die Art und Weise, wie wir APIs für Webanwendungen bauen, grundlegend zu verändern. Für SEOSEO (Search Engine Optimization): Das Schlachtfeld der digitalen Sichtbarkeit SEO, kurz für Search Engine Optimization oder Suchmaschinenoptimierung, ist der Schlüsselbegriff für alle, die online überhaupt gefunden werden wollen. Es bezeichnet sämtliche Maßnahmen, mit denen Websites und deren Inhalte so optimiert werden, dass sie in den unbezahlten, organischen Suchergebnissen von Google, Bing und Co. möglichst weit oben erscheinen. SEO ist längst... bedeutet das: Es ist nicht mehr nur eine Frage, ob deine Seite sichtbar ist, sondern wie effizient SuchmaschinenSuchmaschinen: Das Rückgrat des Internets – Definition, Funktionsweise und Bedeutung Suchmaschinen sind die unsichtbaren Dirigenten des digitalen Zeitalters. Sie filtern, sortieren und präsentieren Milliarden von Informationen tagtäglich – und entscheiden damit, was im Internet gesehen wird und was gnadenlos im Daten-Nirwana verschwindet. Von Google bis Bing, von DuckDuckGo bis Yandex – Suchmaschinen sind weit mehr als simple Datenbanken. Sie sind... deine dynamischen, API-gesteuerten Inhalte indexieren können. Und hier liegt die Crux: GraphQL ist hochflexibel, aber auch hochkomplex – gerade für CrawlerCrawler: Die unsichtbaren Arbeiter der digitalen Welt Crawler – auch bekannt als Spider, Bot oder Robot – sind automatisierte Programme, die das Fundament des modernen Internets bilden. Sie durchforsten systematisch Webseiten, erfassen Inhalte, analysieren Strukturen und übermitteln diese Daten an Suchmaschinen, Plattformen oder andere zentrale Dienste. Ohne Crawler wäre Google blind, SEO irrelevant und das World Wide Web ein chaotischer..., die auf klassischen HTML-Content ausgelegt sind. Wenn du nicht frühzeitig die richtigen Weichen stellst, läufst du Gefahr, im Google-Index komplett ignoriert zu werden.

Der Kern der Herausforderung ist: GraphQL liefert Inhalte hauptsächlich clientseitig, was für SEOSEO (Search Engine Optimization): Das Schlachtfeld der digitalen Sichtbarkeit SEO, kurz für Search Engine Optimization oder Suchmaschinenoptimierung, ist der Schlüsselbegriff für alle, die online überhaupt gefunden werden wollen. Es bezeichnet sämtliche Maßnahmen, mit denen Websites und deren Inhalte so optimiert werden, dass sie in den unbezahlten, organischen Suchergebnissen von Google, Bing und Co. möglichst weit oben erscheinen. SEO ist längst... eine Katastrophe sein kann. Googlebot und andere CrawlerCrawler: Die unsichtbaren Arbeiter der digitalen Welt Crawler – auch bekannt als Spider, Bot oder Robot – sind automatisierte Programme, die das Fundament des modernen Internets bilden. Sie durchforsten systematisch Webseiten, erfassen Inhalte, analysieren Strukturen und übermitteln diese Daten an Suchmaschinen, Plattformen oder andere zentrale Dienste. Ohne Crawler wäre Google blind, SEO irrelevant und das World Wide Web ein chaotischer... greifen zwar heute auch auf JavaScript-Inhalte zu, aber nur, wenn du es richtig machst. Hierbei geht es um mehr als nur Lazy Loading oder Code-Splitting. Es geht um die komplette Architektur deiner Seite, um serverseitiges Rendering, um statische Seiten und um eine saubere, crawlerfreundliche API-Implementierung. Wenn du diese Dinge nicht beherrschst, ist dein Ranking-Game sofort gefährdet.

Was GraphQL ist und warum es im SEO-Game eine zentrale Rolle spielt

GraphQL ist eine Abfragesprache für APIs, mit der Frontend-Entwickler genau die Daten anfragen können, die sie brauchen – nichts mehr, nichts weniger. Das klingt nach technischer Eleganz, ist aber im SEO-Kontext eine zweischneidige Waffe. Denn im Gegensatz zu klassischen REST-APIs, bei denen jede Ressource eine eigene URLURL: Mehr als nur eine Webadresse – Das Rückgrat des Internets entschlüsselt Die URL – Uniform Resource Locator – ist viel mehr als eine unscheinbare Zeile im Browser. Sie ist das Adresssystem des Internets, der unverzichtbare Wegweiser, der dafür sorgt, dass du und jeder Bot exakt dort landet, wo er hinwill. Ohne URLs gäbe es kein World Wide Web, keine... hat, arbeitet GraphQL meist über eine einzige Endpoint-URL, die alle Daten liefert. Das bedeutet: Für CrawlerCrawler: Die unsichtbaren Arbeiter der digitalen Welt Crawler – auch bekannt als Spider, Bot oder Robot – sind automatisierte Programme, die das Fundament des modernen Internets bilden. Sie durchforsten systematisch Webseiten, erfassen Inhalte, analysieren Strukturen und übermitteln diese Daten an Suchmaschinen, Plattformen oder andere zentrale Dienste. Ohne Crawler wäre Google blind, SEO irrelevant und das World Wide Web ein chaotischer... ist es schwieriger, einzelne Seiten oder Inhalte zu identifizieren und zu indexieren.

Diese Flexibilität hat jedoch auch ihre Vorteile. Wenn du es schaffst, deine GraphQL-API so zu gestalten, dass sie SEO-freundlich arbeitet, kannst du Inhalte effizient rendern, strukturieren und für SuchmaschinenSuchmaschinen: Das Rückgrat des Internets – Definition, Funktionsweise und Bedeutung Suchmaschinen sind die unsichtbaren Dirigenten des digitalen Zeitalters. Sie filtern, sortieren und präsentieren Milliarden von Informationen tagtäglich – und entscheiden damit, was im Internet gesehen wird und was gnadenlos im Daten-Nirwana verschwindet. Von Google bis Bing, von DuckDuckGo bis Yandex – Suchmaschinen sind weit mehr als simple Datenbanken. Sie sind... sichtbar machen. Wichtig ist dabei vor allem, dass deine APIAPI – Schnittstellen, Macht und Missverständnisse im Web API steht für „Application Programming Interface“, zu Deutsch: Programmierschnittstelle. Eine API ist das unsichtbare Rückgrat moderner Softwareentwicklung und Online-Marketing-Technologien. Sie ermöglicht es verschiedenen Programmen, Systemen oder Diensten, miteinander zu kommunizieren – und zwar kontrolliert, standardisiert und (im Idealfall) sicher. APIs sind das, was das Web zusammenhält, auch wenn kein Nutzer je eine... semantisch sinnvolle Daten liefert, die sich gut in HTML-Strukturen übersetzen lassen. Ansonsten bleibt dein ContentContent: Das Herzstück jedes Online-Marketings Content ist der zentrale Begriff jeder digitalen Marketingstrategie – und das aus gutem Grund. Ob Text, Bild, Video, Audio oder interaktive Elemente: Unter Content versteht man sämtliche Inhalte, die online publiziert werden, um eine Zielgruppe zu informieren, zu unterhalten, zu überzeugen oder zu binden. Content ist weit mehr als bloßer Füllstoff zwischen Werbebannern; er ist... im Unsichtbaren verborgen – und Google erkennt ihn nicht.

Ein weiterer Punkt: GraphQL bietet die Möglichkeit, Inhalte dynamisch zu laden, was bei klassischen Seiten durch serverseitiges Rendern oft nicht passiert. Das bedeutet, du kannst relativ leicht Single-Page-Applications bauen, die nahezu nahtlos wirken. Aber genau hier liegt die große Gefahr: Ohne spezielle Maßnahmen landen deine Inhalte im JS-Nirvana, sind für Google unsichtbar und zerstören dein RankingRanking: Das kompromisslose Spiel um die Sichtbarkeit in Suchmaschinen Ranking bezeichnet im Online-Marketing die Platzierung einer Website oder einzelner URLs in den organischen Suchergebnissen einer Suchmaschine, typischerweise Google. Es ist der digitale Olymp, auf den jeder Website-Betreiber schielt – denn nur wer bei relevanten Suchanfragen weit oben rankt, existiert überhaupt im Kopf der Zielgruppe. Ranking ist keine Glückssache, sondern das... – obwohl dein ContentContent: Das Herzstück jedes Online-Marketings Content ist der zentrale Begriff jeder digitalen Marketingstrategie – und das aus gutem Grund. Ob Text, Bild, Video, Audio oder interaktive Elemente: Unter Content versteht man sämtliche Inhalte, die online publiziert werden, um eine Zielgruppe zu informieren, zu unterhalten, zu überzeugen oder zu binden. Content ist weit mehr als bloßer Füllstoff zwischen Werbebannern; er ist... eigentlich top ist.

Die Herausforderungen bei der SEO-Optimierung von GraphQL-basierten Websites

Die größte Herausforderung bei der Optimierung von GraphQL-Seiten ist, die Trennung zwischen clientseitigem Content-Loading und serverseitiger SichtbarkeitSichtbarkeit: Die unbarmherzige Währung des digitalen Marketings Wenn es im Online-Marketing eine einzige Währung gibt, die wirklich zählt, dann ist es Sichtbarkeit. Sichtbarkeit – im Fachjargon gern als „Visibility“ bezeichnet – bedeutet schlicht: Wie präsent ist eine Website, ein Unternehmen oder eine Marke im digitalen Raum, insbesondere in Suchmaschinen wie Google? Wer nicht sichtbar ist, existiert nicht. Punkt. In diesem... zu meistern. Da GraphQL primär für flexible, datengetriebene Frontends entwickelt wurde, ist die Standard-SEO-Architektur oft nicht ausreichend. Das Resultat: Inhalte werden erst nach dem initialen Laden durch JavaScriptJavaScript: Das Rückgrat moderner Webentwicklung – und Fluch für schlechte Seiten JavaScript ist die universelle Programmiersprache des Webs. Ohne JavaScript wäre das Internet ein statisches Museum aus langweiligen HTML-Seiten. Mit JavaScript wird aus einer simplen Webseite eine interaktive Webanwendung, ein dynamisches Dashboard oder gleich ein kompletter Online-Shop. Doch so mächtig die Sprache ist, so gnadenlos ist sie auch bei schlechter... nachgeladen, was für Google zu spät kommt. Und Google liebt statisches HTMLHTML: Das Rückgrat des Webs erklärt HTML steht für Hypertext Markup Language und ist der unangefochtene Grundbaustein des World Wide Web. Ohne HTML gäbe es keine Webseiten, keine Online-Shops, keine Blogs und keine digitalen Marketingwelten – nur eine triste, textbasierte Datenwüste. HTML strukturiert Inhalte, macht sie für Browser interpretierbar und sorgt dafür, dass aus rohen Daten klickbare, visuell erfassbare und....

Ein weiteres Problem sind sogenannte „Crawling-Blockaden“. Wenn deine APIAPI – Schnittstellen, Macht und Missverständnisse im Web API steht für „Application Programming Interface“, zu Deutsch: Programmierschnittstelle. Eine API ist das unsichtbare Rückgrat moderner Softwareentwicklung und Online-Marketing-Technologien. Sie ermöglicht es verschiedenen Programmen, Systemen oder Diensten, miteinander zu kommunizieren – und zwar kontrolliert, standardisiert und (im Idealfall) sicher. APIs sind das, was das Web zusammenhält, auch wenn kein Nutzer je eine... nur auf clientseitigen Datenabruf setzt, haben CrawlerCrawler: Die unsichtbaren Arbeiter der digitalen Welt Crawler – auch bekannt als Spider, Bot oder Robot – sind automatisierte Programme, die das Fundament des modernen Internets bilden. Sie durchforsten systematisch Webseiten, erfassen Inhalte, analysieren Strukturen und übermitteln diese Daten an Suchmaschinen, Plattformen oder andere zentrale Dienste. Ohne Crawler wäre Google blind, SEO irrelevant und das World Wide Web ein chaotischer... keine Chance, die Inhalte zu erkennen. Das führt dazu, dass wichtige Seiten, Produkte oder Blogartikel niemals im Index landen. Hinzu kommt die Schwierigkeit, canonical URLs sauber zu setzen, hreflang-Tag-Implementierungen korrekt durchzuführen und Duplicate ContentDuplicate Content: Das SEO-Killer-Syndrom im Online-Marketing Duplicate Content, zu Deutsch „doppelter Inhalt“, ist einer der am meisten unterschätzten, aber folgenschwersten Fehler im SEO-Kosmos. Damit bezeichnet man identische oder sehr ähnliche Inhalte, die unter mehreren URLs im Internet auffindbar sind – entweder auf derselben Website (interner Duplicate Content) oder auf verschiedenen Domains (externer Duplicate Content). Google und andere Suchmaschinen mögen keine... zu vermeiden. Es ist ein Spagat, der ohne technische Expertise kaum zu meistern ist.

Hinzu kommt die Herausforderung, Performance-Probleme in den Griff zu bekommen. GraphQL-Anfragen können sehr komplex werden, wenn sie nicht richtig optimiert sind. Überlange Response-Zeiten, unnötige Datenabfragen und unoptimierte Caching-Strategien erhöhen die Ladezeiten und verschlechtern Core Web VitalsCore Web Vitals: Die Messlatte für echte Website-Performance Core Web Vitals sind Googles knallharte Antwort auf die Frage: „Wie schnell, stabil und nutzerfreundlich ist deine Website wirklich?“ Es handelt sich um eine Reihe von Metriken, die konkret messbar machen, wie Besucher die Ladezeit, Interaktivität und visuelle Stabilität einer Seite erleben. Damit sind die Core Web Vitals kein weiteres Buzzword, sondern... – allesamt Ranking-Faktoren, die im Jahr 2025 noch stärker gewichtet werden.

Technische Voraussetzungen: Crawler, Rendering, Server-Setup

Um GraphQL für SEOSEO (Search Engine Optimization): Das Schlachtfeld der digitalen Sichtbarkeit SEO, kurz für Search Engine Optimization oder Suchmaschinenoptimierung, ist der Schlüsselbegriff für alle, die online überhaupt gefunden werden wollen. Es bezeichnet sämtliche Maßnahmen, mit denen Websites und deren Inhalte so optimiert werden, dass sie in den unbezahlten, organischen Suchergebnissen von Google, Bing und Co. möglichst weit oben erscheinen. SEO ist längst... fit zu machen, brauchst du eine solide technische Basis. Das beginnt bei deinem Server-Setup: HTTP/2 oder HTTP/3 sind Pflicht, um schnelle Verbindungen zu gewährleisten. Ebenso ist Caching essenziell: Server-Cache, CDN-Cache und Browser-Cache. Nur so kannst du Response-Zeiten minimieren und die TTFB (Time to First Byte) auf ein Minimum reduzieren. Zudem solltest du auf eine saubere Konfiguration deiner CORS-Richtlinien achten, damit CrawlerCrawler: Die unsichtbaren Arbeiter der digitalen Welt Crawler – auch bekannt als Spider, Bot oder Robot – sind automatisierte Programme, die das Fundament des modernen Internets bilden. Sie durchforsten systematisch Webseiten, erfassen Inhalte, analysieren Strukturen und übermitteln diese Daten an Suchmaschinen, Plattformen oder andere zentrale Dienste. Ohne Crawler wäre Google blind, SEO irrelevant und das World Wide Web ein chaotischer... nicht durch Cross-Origin-Requests blockiert werden.

Der nächste Punkt betrifft das Rendering: Google kann mittlerweile JavaScriptJavaScript: Das Rückgrat moderner Webentwicklung – und Fluch für schlechte Seiten JavaScript ist die universelle Programmiersprache des Webs. Ohne JavaScript wäre das Internet ein statisches Museum aus langweiligen HTML-Seiten. Mit JavaScript wird aus einer simplen Webseite eine interaktive Webanwendung, ein dynamisches Dashboard oder gleich ein kompletter Online-Shop. Doch so mächtig die Sprache ist, so gnadenlos ist sie auch bei schlechter... rendern, aber nur, wenn du es richtig machst. Das bedeutet, du brauchst eine Strategie für serverseitiges Rendering (SSR), um initiale HTML-Inhalte direkt auszuliefern. Alternativ kannst du Static Site Generation (SSG) einsetzen, um vorgefertigte HTML-Seiten für alle URL-Varianten zu erstellen. Wichtig: Die APIAPI – Schnittstellen, Macht und Missverständnisse im Web API steht für „Application Programming Interface“, zu Deutsch: Programmierschnittstelle. Eine API ist das unsichtbare Rückgrat moderner Softwareentwicklung und Online-Marketing-Technologien. Sie ermöglicht es verschiedenen Programmen, Systemen oder Diensten, miteinander zu kommunizieren – und zwar kontrolliert, standardisiert und (im Idealfall) sicher. APIs sind das, was das Web zusammenhält, auch wenn kein Nutzer je eine... muss so aufgebaut sein, dass die vorgerenderten Seiten nicht nur statisch sind, sondern auch dynamisch aktualisiert werden können.

Bei der Einrichtung des Crawlings solltest du außerdem sicherstellen, dass deine robots.txt-Datei keine wichtigen Ressourcen blockiert. Besonders CSS- und JS-Dateien müssen erreichbar sein, damit Google deine Seiten rendern kann. Auch die SitemapSitemap: Das Rückgrat der Indexierung und SEO-Performance Die Sitemap ist das digitale Inhaltsverzeichnis deiner Website und ein essentielles Werkzeug für effiziente Suchmaschinenoptimierung (SEO). Sie zeigt Suchmaschinen-Crawlern, welche Seiten existieren, wie sie strukturiert sind und wie oft sie aktualisiert werden. Ohne Sitemap kann sich selbst die technisch sauberste Website schnell im Nebel der Unsichtbarkeit verlieren. In diesem Artikel erfährst du, warum... sollte alle wichtigen URLs enthalten und aktuell sein. Denn nur, wenn Google alle Inhalte kennt, kannst du auf Platz 1 landen.

Implementierung von serverseitigem Rendering (SSR) bei GraphQL

Wer im GraphQL-Umfeld SEOSEO (Search Engine Optimization): Das Schlachtfeld der digitalen Sichtbarkeit SEO, kurz für Search Engine Optimization oder Suchmaschinenoptimierung, ist der Schlüsselbegriff für alle, die online überhaupt gefunden werden wollen. Es bezeichnet sämtliche Maßnahmen, mit denen Websites und deren Inhalte so optimiert werden, dass sie in den unbezahlten, organischen Suchergebnissen von Google, Bing und Co. möglichst weit oben erscheinen. SEO ist längst... ernst nimmt, kommt an SSR nicht vorbei. Beim serverseitigen Rendering werden die Inhalte bereits auf dem Server generiert und als vollständiges HTMLHTML: Das Rückgrat des Webs erklärt HTML steht für Hypertext Markup Language und ist der unangefochtene Grundbaustein des World Wide Web. Ohne HTML gäbe es keine Webseiten, keine Online-Shops, keine Blogs und keine digitalen Marketingwelten – nur eine triste, textbasierte Datenwüste. HTML strukturiert Inhalte, macht sie für Browser interpretierbar und sorgt dafür, dass aus rohen Daten klickbare, visuell erfassbare und... ausgeliefert, bevor sie an den Browser gehen. Das hat den großen Vorteil, dass CrawlerCrawler: Die unsichtbaren Arbeiter der digitalen Welt Crawler – auch bekannt als Spider, Bot oder Robot – sind automatisierte Programme, die das Fundament des modernen Internets bilden. Sie durchforsten systematisch Webseiten, erfassen Inhalte, analysieren Strukturen und übermitteln diese Daten an Suchmaschinen, Plattformen oder andere zentrale Dienste. Ohne Crawler wäre Google blind, SEO irrelevant und das World Wide Web ein chaotischer... sofort alle Inhalte sehen, ohne auf JavaScript-Rendering angewiesen zu sein. Für React-Apps bedeutet das: Einsatz von Frameworks wie Next.js, Nuxt.js oder Gatsby, die eine nahtlose SSR-Integration bieten.

Der Schlüssel zum Erfolg liegt darin, deine GraphQL-Queries so zu gestalten, dass sie bereits beim Server-Rendern alle relevanten Daten liefern. Das bedeutet, du solltest für jede Seite eine konkrete Query definieren, die alle Inhalte enthält, die in den HTML-Output fließen. Zudem ist es wichtig, das Caching auf Server- und CDN-Ebene richtig zu konfigurieren, um Performance und Aktualität zu gewährleisten.

Ein häufiger Stolperstein ist die Hydration – die Verbindung zwischen serverseitigem HTMLHTML: Das Rückgrat des Webs erklärt HTML steht für Hypertext Markup Language und ist der unangefochtene Grundbaustein des World Wide Web. Ohne HTML gäbe es keine Webseiten, keine Online-Shops, keine Blogs und keine digitalen Marketingwelten – nur eine triste, textbasierte Datenwüste. HTML strukturiert Inhalte, macht sie für Browser interpretierbar und sorgt dafür, dass aus rohen Daten klickbare, visuell erfassbare und... und clientseitiger Interaktivität. Hierbei muss sichergestellt werden, dass die initial geladenen Inhalte identisch sind, um Duplicate-Inhalte oder Fehler im DOM zu vermeiden. Das erfordert eine enge Abstimmung zwischen Frontend-Framework und API-Design – eine Herausforderung, die technisch perfekt beherrscht werden muss.

Pre-Rendering und Static Site Generation (SSG) für SEO-Boosts

Neben SSR bietet sich die Möglichkeit des Pre-Renderings oder der Static Site Generation an. SSG-Tools wie Gatsby oder Gridsome erstellen vorab fertige HTML-Versionen deiner Seiten, die dann nur noch ausgeliefert werden. Das ist perfekt für Seiten mit relativ statischen Inhalten, bei denen keine häufigen Aktualisierungen notwendig sind.

Der Vorteil: Schnelle Ladezeiten, einfache IndexierungIndexierung: Wie Webseiten den Weg in die Suchmaschine finden (und warum sie dort bleiben wollen) Autor: Tobias Hager Was bedeutet Indexierung? Definition, Grundlagen und der technische Prozess Indexierung ist im SEO-Kosmos das Eintrittsticket ins Spiel. Ohne Indexierung kein Ranking, keine Sichtbarkeit, kein Traffic – schlicht: keine Relevanz. Kurz gesagt bezeichnet Indexierung den Prozess, durch den Suchmaschinen wie Google, Bing oder..., weniger Server-Last. Der Nachteil: Bei hochdynamischen Inhalten oder häufigen Änderungen ist dieses Modell weniger geeignet. Hier muss eine Lösung her, die den Kompromiss zwischen Aktualität und Performance findet – beispielsweise durch Incremental Static Regeneration (ISR) oder Hybrid-Ansätze.

Wichtig ist, dass beim Einsatz solcher Strategien die APIAPI – Schnittstellen, Macht und Missverständnisse im Web API steht für „Application Programming Interface“, zu Deutsch: Programmierschnittstelle. Eine API ist das unsichtbare Rückgrat moderner Softwareentwicklung und Online-Marketing-Technologien. Sie ermöglicht es verschiedenen Programmen, Systemen oder Diensten, miteinander zu kommunizieren – und zwar kontrolliert, standardisiert und (im Idealfall) sicher. APIs sind das, was das Web zusammenhält, auch wenn kein Nutzer je eine... so aufgebaut ist, dass sie alle Inhalte für die statischen Seitenbereitstellung liefert. Zudem sollten Caching-Mechanismen so konfiguriert sein, dass sie die Aktualität der Inhalte nicht gefährden.

JavaScript-Rendering, Hydration und clientseitiges Nachladen

Wenn du dich für clientseitiges Rendering entscheidest, musst du unbedingt auf saubere Hydration achten. Das bedeutet, dass die vom Server gelieferten HTML-Inhalte mit den clientseitigen React-, Vue- oder Angular-Komponenten synchronisiert werden. Nur so stellst du sicher, dass Google die Inhalte überhaupt erfassen kann – und nicht nur eine leere Seite.

Das Nachladen von Daten via JavaScriptJavaScript: Das Rückgrat moderner Webentwicklung – und Fluch für schlechte Seiten JavaScript ist die universelle Programmiersprache des Webs. Ohne JavaScript wäre das Internet ein statisches Museum aus langweiligen HTML-Seiten. Mit JavaScript wird aus einer simplen Webseite eine interaktive Webanwendung, ein dynamisches Dashboard oder gleich ein kompletter Online-Shop. Doch so mächtig die Sprache ist, so gnadenlos ist sie auch bei schlechter... ist eine schöne Sache für User ExperienceUser Experience (UX): Der wahre Hebel für digitale Dominanz User Experience, kurz UX, ist weit mehr als ein Buzzword aus der Digitalbranche. Es bezeichnet das ganzheitliche Nutzererlebnis beim Interagieren mit digitalen Produkten, insbesondere Websites, Apps und Software. UX umfasst sämtliche Eindrücke, Emotionen und Reaktionen, die ein Nutzer während der Nutzung sammelt – von der ersten Sekunde bis zum Absprung. Wer..., aber für SEOSEO (Search Engine Optimization): Das Schlachtfeld der digitalen Sichtbarkeit SEO, kurz für Search Engine Optimization oder Suchmaschinenoptimierung, ist der Schlüsselbegriff für alle, die online überhaupt gefunden werden wollen. Es bezeichnet sämtliche Maßnahmen, mit denen Websites und deren Inhalte so optimiert werden, dass sie in den unbezahlten, organischen Suchergebnissen von Google, Bing und Co. möglichst weit oben erscheinen. SEO ist längst... ein zweischneidiges Schwert. Wenn deine Inhalte erst nach dem initialen Laden durch API-Abfragen erscheinen, musst du dafür sorgen, dass Google sie schon beim ersten Crawling erkennt. Andernfalls landest du im Index mit leeren oder unvollständigen Seiten.

Hier hilft das sogenannte „Universal Rendering“: Die initialen Inhalte werden auf dem Server gerendert, während dann zusätzliche Daten dynamisch nachgeladen werden. Das erfordert eine enge Abstimmung zwischen APIAPI – Schnittstellen, Macht und Missverständnisse im Web API steht für „Application Programming Interface“, zu Deutsch: Programmierschnittstelle. Eine API ist das unsichtbare Rückgrat moderner Softwareentwicklung und Online-Marketing-Technologien. Sie ermöglicht es verschiedenen Programmen, Systemen oder Diensten, miteinander zu kommunizieren – und zwar kontrolliert, standardisiert und (im Idealfall) sicher. APIs sind das, was das Web zusammenhält, auch wenn kein Nutzer je eine..., Frontend-Framework und Rendering-Strategie. Nur so kannst du sicherstellen, dass Google deine Inhalte vollständig erfasst und rankt.

Tools und Techniken zur Analyse und Verbesserung der GraphQL-SEO-Performance

Um wirklich den Durchblick zu behalten, brauchst du die richtigen Tools. Google Search ConsoleGoogle Search Console: Dein Kontrollzentrum für SEO und Website-Performance Die Google Search Console (GSC) ist das offizielle, kostenlose Analyse- und Überwachungstool von Google für Website-Betreiber, SEOs und Online-Marketing-Profis. Sie liefert unverzichtbare Einblicke in Sichtbarkeit, technische Performance, Indexierung und Suchmaschinen-Rankings. Wer seine Website ernsthaft betreibt, kommt an der Google Search Console nicht vorbei – denn ohne Daten bist du im SEO... ist ein Standard, reicht aber nicht aus. Für tiefergehende Analysen sind Lighthouse, WebPageTest, Chrome DevTools und spezialisierte GraphQL-Analysetools unverzichtbar. Sie helfen dir, Response-Zeiten, Render-Qualität und IndexierungIndexierung: Wie Webseiten den Weg in die Suchmaschine finden (und warum sie dort bleiben wollen) Autor: Tobias Hager Was bedeutet Indexierung? Definition, Grundlagen und der technische Prozess Indexierung ist im SEO-Kosmos das Eintrittsticket ins Spiel. Ohne Indexierung kein Ranking, keine Sichtbarkeit, kein Traffic – schlicht: keine Relevanz. Kurz gesagt bezeichnet Indexierung den Prozess, durch den Suchmaschinen wie Google, Bing oder... zu überprüfen.

Logfile-Analysen sind ein Gamechanger: Sie zeigen dir genau, wie Googlebot deine Seiten crawlt, welche Inhalte er sieht und wo es Probleme gibt. Damit kannst du gezielt Optimierungen vornehmen, z. B. deine API-Anfragen kürzen, unnötige Daten vermeiden oder Caching verbessern. Automatisierte Monitoring-Tools helfen, langfristig den Überblick zu behalten und technische Fehler frühzeitig zu erkennen.

Ein weiterer Tipp: Nutze strukturierte DatenStrukturierte Daten: Das Power-Upgrade für SEO, Rich Snippets & Maschinenverständnis Strukturierte Daten sind der geheime Zaubertrank im SEO-Arsenal: Sie machen Inhalte maschinenlesbar und verhelfen Websites zu prominenteren Darstellungen in den Suchergebnissen – Stichwort Rich Snippets. Im Kern geht es darum, Informationen so zu kennzeichnen, dass Suchmaschinen wie Google, Bing oder Yandex exakt verstehen, worum es auf einer Seite geht. Keine..., um Google gezielt zu steuern. Mit JSON-LD kannst du Inhalte markieren, die in den Suchergebnissen hervorgehoben werden sollen – von FAQs bis zu Produktdaten. So hebst du dich vom Wettbewerb ab und steigerst deine SichtbarkeitSichtbarkeit: Die unbarmherzige Währung des digitalen Marketings Wenn es im Online-Marketing eine einzige Währung gibt, die wirklich zählt, dann ist es Sichtbarkeit. Sichtbarkeit – im Fachjargon gern als „Visibility“ bezeichnet – bedeutet schlicht: Wie präsent ist eine Website, ein Unternehmen oder eine Marke im digitalen Raum, insbesondere in Suchmaschinen wie Google? Wer nicht sichtbar ist, existiert nicht. Punkt. In diesem....

Langfristige Strategie: Monitoring, Updates und Best Practices

Technisches SEOTechnisches SEO: Die unsichtbare Architektur für Top-Rankings Technisches SEO ist das ungeliebte Stiefkind der Suchmaschinenoptimierung – und gleichzeitig ihr Fundament. Ohne saubere Technik kann der beste Content, die coolste Marke und der teuerste Linkaufbau einpacken. Technisches SEO umfasst sämtliche Maßnahmen, die gewährleisten, dass Suchmaschinen Websites effizient crawlen, verstehen und indexieren können. Es geht um Geschwindigkeit, Struktur, Sicherheit und Zugänglichkeit –... bei GraphQL ist kein einmaliges Projekt, sondern ein kontinuierlicher Prozess. Google ändert ständig seine Algorithmen, Frameworks entwickeln sich weiter, und deine Seite muss Schritt halten. Deshalb ist ein regelmäßiges Monitoring unerlässlich. Automatisierte Crawls, Performance-Checks und Logfile-Analysen sollten Standard sein.

Zudem solltest du bei jedem Update deiner APIAPI – Schnittstellen, Macht und Missverständnisse im Web API steht für „Application Programming Interface“, zu Deutsch: Programmierschnittstelle. Eine API ist das unsichtbare Rückgrat moderner Softwareentwicklung und Online-Marketing-Technologien. Sie ermöglicht es verschiedenen Programmen, Systemen oder Diensten, miteinander zu kommunizieren – und zwar kontrolliert, standardisiert und (im Idealfall) sicher. APIs sind das, was das Web zusammenhält, auch wenn kein Nutzer je eine... oder deiner Frontend-Architektur systematisch prüfen, ob alles noch SEO-konform läuft. Hierfür eignen sich Tools wie Lighthouse, Screaming Frog oder Sitebulb. Wichtig ist auch, immer wieder die Core Web VitalsCore Web Vitals: Die Messlatte für echte Website-Performance Core Web Vitals sind Googles knallharte Antwort auf die Frage: „Wie schnell, stabil und nutzerfreundlich ist deine Website wirklich?“ Es handelt sich um eine Reihe von Metriken, die konkret messbar machen, wie Besucher die Ladezeit, Interaktivität und visuelle Stabilität einer Seite erleben. Damit sind die Core Web Vitals kein weiteres Buzzword, sondern... im Blick zu behalten, um Ladezeiten, Interaktivität und Stabilität zu optimieren.

Langfristig gilt: Je mehr du in eine saubere technische Infrastruktur investierst, desto weniger Probleme wirst du in der Suche bekommen. Und das bedeutet: weniger Zeit für Notfallmaßnahmen, mehr SichtbarkeitSichtbarkeit: Die unbarmherzige Währung des digitalen Marketings Wenn es im Online-Marketing eine einzige Währung gibt, die wirklich zählt, dann ist es Sichtbarkeit. Sichtbarkeit – im Fachjargon gern als „Visibility“ bezeichnet – bedeutet schlicht: Wie präsent ist eine Website, ein Unternehmen oder eine Marke im digitalen Raum, insbesondere in Suchmaschinen wie Google? Wer nicht sichtbar ist, existiert nicht. Punkt. In diesem... und letztlich besseres RankingRanking: Das kompromisslose Spiel um die Sichtbarkeit in Suchmaschinen Ranking bezeichnet im Online-Marketing die Platzierung einer Website oder einzelner URLs in den organischen Suchergebnissen einer Suchmaschine, typischerweise Google. Es ist der digitale Olymp, auf den jeder Website-Betreiber schielt – denn nur wer bei relevanten Suchanfragen weit oben rankt, existiert überhaupt im Kopf der Zielgruppe. Ranking ist keine Glückssache, sondern das....

Fehlerquellen, die du unbedingt vermeiden solltest

Die häufigsten Fehler bei der SEO-Integration von GraphQL sind: unzureichendes serverseitiges Rendering, blockierte Ressourcen in der robots.txtRobots.txt: Das Bollwerk zwischen Crawlern und deinen Daten Die robots.txt ist das vielleicht meistunterschätzte, aber mächtigste Textfile im Arsenal eines jeden Website-Betreibers – und der Gatekeeper beim Thema Crawling. Sie entscheidet, welche Bereiche deiner Website von Suchmaschinen-Crawlern betreten werden dürfen und welche nicht. Ohne robots.txt bist du digital nackt – und der Googlebot tanzt, wo er will. In diesem Artikel..., schlechte API-Performance, fehlende oder fehlerhafte canonical- und hreflang-Tags, sowie vernachlässigte Caching-Strategien. Diese Fehler kosten dich Rankings, TrafficTraffic: Die wahre Währung des digitalen Marketings Traffic – der Begriff klingt harmlos, fast banal. Tatsächlich ist Traffic das Lebenselixier jeder Website, der Pulsschlag des Online-Marketings und der ultimative Gradmesser für digitale Sichtbarkeit. Ohne Traffic bleibt jede noch so geniale Seite ein Geisterschiff im Ozean des Internets. Dieser Glossar-Artikel zerlegt das Thema Traffic in seine Einzelteile, von Definition bis Technologie,... und letztlich Umsatz.

Ein weiterer Klassiker ist die Verwendung von clientseitigem Nachladen ohne passende SEO-Strategie. Wenn Google nur die leere Shell erkennt, hast du verloren. Auch ungenaue oder fehlende strukturierte DatenStrukturierte Daten: Das Power-Upgrade für SEO, Rich Snippets & Maschinenverständnis Strukturierte Daten sind der geheime Zaubertrank im SEO-Arsenal: Sie machen Inhalte maschinenlesbar und verhelfen Websites zu prominenteren Darstellungen in den Suchergebnissen – Stichwort Rich Snippets. Im Kern geht es darum, Informationen so zu kennzeichnen, dass Suchmaschinen wie Google, Bing oder Yandex exakt verstehen, worum es auf einer Seite geht. Keine... führen dazu, dass Google deine Inhalte nicht richtig versteht und somit nicht optimal in den SERPs platziert.

Vermeide außerdem unnötige Redirect-Ketten, fehlerhafte Response-Codes (z. B. 404 oder 500), sowie das Blockieren wichtiger CSS- und JS-Dateien. All das sind typische Stolpersteine, die dir im SEO-Wettbewerb das Genick brechen können.

Fazit: Warum technisches SEO bei GraphQL dein Schlüssel zum Erfolg ist

GraphQL ist mächtig – aber nur, wenn du es richtig nutzt. Im Jahr 2025 entscheidet die technische Infrastruktur maßgeblich über dein RankingRanking: Das kompromisslose Spiel um die Sichtbarkeit in Suchmaschinen Ranking bezeichnet im Online-Marketing die Platzierung einer Website oder einzelner URLs in den organischen Suchergebnissen einer Suchmaschine, typischerweise Google. Es ist der digitale Olymp, auf den jeder Website-Betreiber schielt – denn nur wer bei relevanten Suchanfragen weit oben rankt, existiert überhaupt im Kopf der Zielgruppe. Ranking ist keine Glückssache, sondern das.... Ohne serverseitiges Rendering, saubere API-Implementierung und kontinuierliches Monitoring wird dein ContentContent: Das Herzstück jedes Online-Marketings Content ist der zentrale Begriff jeder digitalen Marketingstrategie – und das aus gutem Grund. Ob Text, Bild, Video, Audio oder interaktive Elemente: Unter Content versteht man sämtliche Inhalte, die online publiziert werden, um eine Zielgruppe zu informieren, zu unterhalten, zu überzeugen oder zu binden. Content ist weit mehr als bloßer Füllstoff zwischen Werbebannern; er ist... im digitalen Nirwana versinken, während deine Mitbewerber ganz oben landen.

Wer seine GraphQL-Seite nicht technisch absichert, spielt russisches Roulette. Es reicht nicht, nur schöne APIs zu bauen; du musst auch dafür sorgen, dass Google sie sehen, verstehen und bewerten kann. Das erfordert technisches Know-how, strategisches Denken und eine konsequente Umsetzung. Nur so bleibst du im SEO-Rennen vorne – alles andere ist Zeitverschwendung.