SEO für Webcrawler Netzwerke: Clevere Strategien für Top-Rankings

Wenn du glaubst, dass dein Content allein ausreicht, um oben zu landen, hast du noch nicht die harte Realität des SEO-Netzwerkes verstanden. In der Welt der Webcrawler-Netzwerke entscheidet die technische Raffinesse darüber, wer wirklich vorne mitspielt – und wer gnadenlos abgehängt wird. Es ist Zeit, die Spielregeln zu kennen, die hinter den Kulissen für deine Rankings sorgen. Denn ohne eine smarte Strategie für Webcrawler-Netzwerke wirst du im digitalen Dschungel nur noch Staub aufwirbeln – oder noch schlimmer: unsichtbar bleiben.

- Was sind Webcrawler Netzwerke und warum sie im SEO eine zentrale Rolle spielen

- Die wichtigsten technischen Faktoren, die bei Webcrawler Netzwerken den Unterschied machen

- Wie Google und andere Suchmaschinen Webcrawler-Netzwerke bewerten

- Strategien zur Optimierung der Crawl- und Indexierungsperformance in Netzwerken

- Technische Tools und Frameworks, die dir den Weg an die Spitze ebnen

- Vermeidung von Fallen und Fehlerquellen bei der Arbeit mit Webcrawler Netzwerken

- Schritt-für-Schritt: So baust du dein eigenes effektives Crawler-Netzwerk

- Langfristige Monitoring- und Wartungsstrategien für nachhaltigen Erfolg

- Was viele Agenturen verschweigen: Die dunkle Seite der Webcrawler Netzwerke

- Fazit: Warum technisches Know-how in 2025 unverzichtbar ist

Stell dir vor, du hast die besten Inhalte, die schönste User Experience – und trotzdem landet dein Angebot im digitalen Nirwana. Warum? Weil du den entscheidenden Faktor ignorierst: das Netzwerk der Webcrawler. Diese unsichtbaren Helfer sind das Rückgrat jeder erfolgreichen SEO-Strategie, denn sie entscheiden, was Google überhaupt sieht, versteht und bewertet. In einer Welt, in der Algorithmen immer komplexer werden und die Konkurrenz nicht schläft, reicht es nicht mehr, nur für den Nutzer zu optimieren. Du musst das Spiel der Webcrawler beherrschen – sonst bist du nur ein Schatten im Ranking-Dickicht.

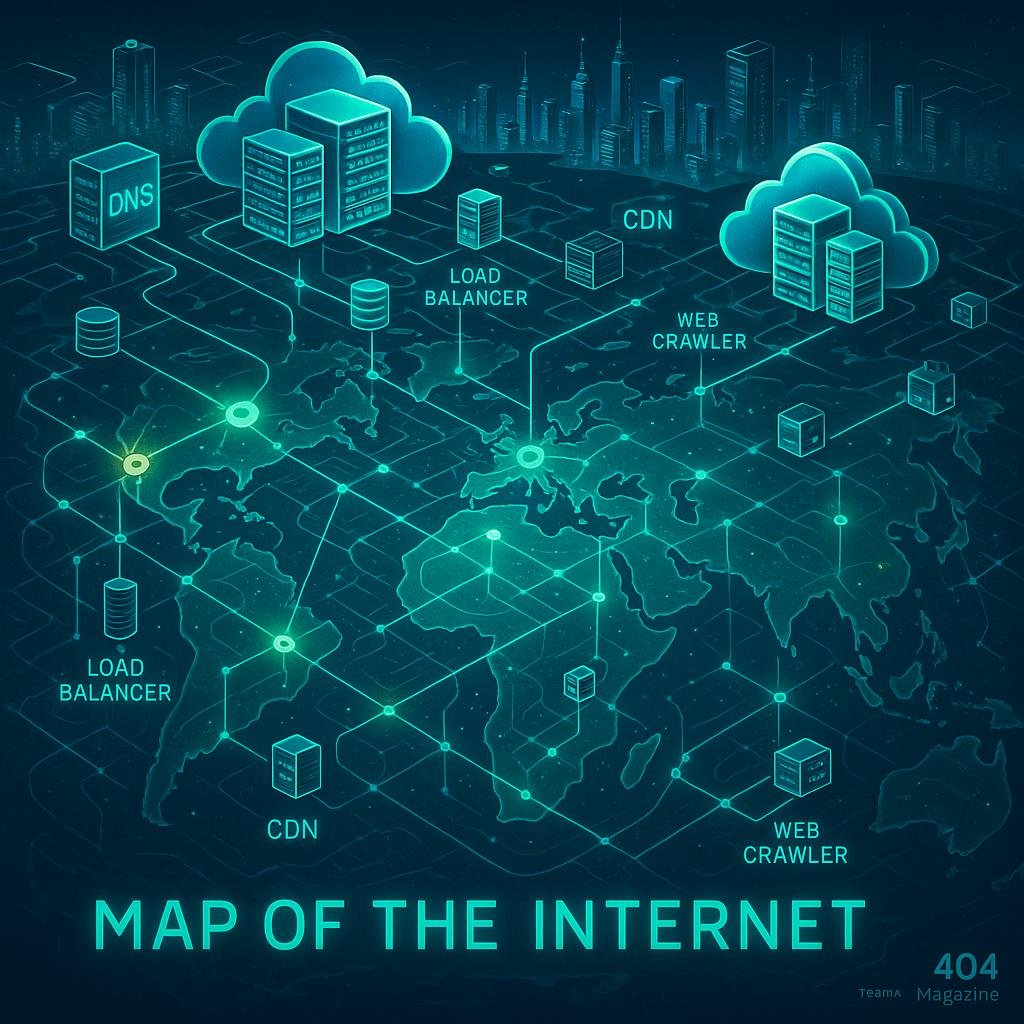

Webcrawler Netzwerke sind keine einzelne Entität, sondern ein komplexes Geflecht aus Verbindungen, Protokollen und Datenströmen, die darüber entscheiden, wie dein Content im digitalen Raum verteilt und bewertet wird. Sie sind das Netzwerk, das Google, Bing, Baidu und Co. nutzt, um das Internet zu kartografieren, zu klassifizieren und in den SERPs anzuzeigen. Und obwohl sie für den Laien meist unsichtbar bleiben, sind sie die stille Macht hinter jedem Top-Ranking.

Was heute zählt, ist eine tiefgehende technische Optimierung dieser Netzwerke. Es reicht nicht mehr, eine Seite schön zu bauen – du musst sie auch so vorbereiten, dass sie von den Crawlern optimal erfasst wird. Das bedeutet, technische Feinheiten zu beherrschen: vom Crawling-Budget über die Crawl-Delay-Regeln bis hin zu komplexen Netzwerkarchitekturen. Denn nur, wer die Sprache der Webcrawler spricht, kann sie dazu bringen, deine Inhalte zu lieben und hoch zu ranken – selbst in hochkomplexen Netzwerken.

Was sind Webcrawler Netzwerke und warum sie für SEO entscheidend sind

Webcrawler Netzwerke sind die Infrastruktur, die es Suchmaschinen ermöglicht, das Internet systematisch zu durchforsten. Sie bestehen aus einer Vielzahl von Crawler-Instanzen, die in koordinierter Manier Webseiten aufrufen, Daten sammeln und in einer zentralen Datenbank speichern. Diese Netzwerke sind hochgradig optimiert, skalierbar und auf Effizienz getrimmt, um möglichst viele Seiten in kürzester Zeit zu erfassen. Für SEO bedeutet das: Je besser dein technisches Setup mit diesen Netzwerken harmoniert, desto wahrscheinlicher ist es, dass dein Content überhaupt in die Bewertungskette gelangt.

Im Kern sind Webcrawler Netzwerke eine Mischung aus verteilten Systemen, Cloud-Servern, Netzwerkprotokollen und intelligentem Caching. Sie nutzen adaptive Algorithmen, um Prioritäten zu setzen, Ressourcen zu verwalten und Crawl-Fehler zu minimieren. Dabei kommen Technologien wie DNS-Routing, Load Balancing, Parallelisierung und Traffic-Management zum Einsatz. Für dich heißt das: Wenn dein Content in diesem komplexen System nicht optimal repräsentiert wird, ist alles andere nur Kosmetik.

Ein entscheidender Punkt: Diese Netzwerke sind keine statischen Gebilde. Sie entwickeln sich ständig weiter, passen sich den aktuellen Bedingungen an, optimieren ihre Crawl-Strategien und reagieren auf technische Veränderungen deiner Website. Wer hier nicht Schritt hält, verliert wertvolle Crawl-Resourcen – und damit die Chance auf Top-Rankings. Das Verständnis dieser Dynamik ist der erste Schritt, um die Kontrolle zu gewinnen.

Technische Faktoren, die in Webcrawler Netzwerken den Unterschied machen

Die wichtigsten technischen Faktoren, die das Verhalten der Webcrawler Netzwerke beeinflussen, sind die Ladegeschwindigkeit, die Server-Performance, die Netzwerkarchitektur und die Crawl-Optimierung. Diese Faktoren bestimmen, wie effizient dein Content im Netzwerk verteilt und verarbeitet wird. Sie sind die eigentlichen Hebel, mit denen du deine Sichtbarkeit pushen kannst.

Erstens: die Server-Performance und die Netzwerk-Infrastruktur. Schnelle Server mit minimaler TTFB (Time to First Byte), moderne HTTP/2- oder HTTP/3-Protokolle, Gzip- oder Brotli-Kompression sowie ein globales CDN sind Pflicht. Diese Technologien sorgen dafür, dass dein Content schnell beim Crawler ankommt und nahtlos verarbeitet wird. Bei langsamen Servern oder veralteten Protokollen ist jede Crawler-Session eine Qual – und Google verschwendet Ressourcen, um deine Seiten zu erfassen.

Zweitens: Crawl-Budget und Crawl-Delay. Diese Parameter steuern, wie oft und wie intensiv dein Content gecrawlt wird. Eine zu hohe Crawl-Rate bei einer schlecht optimierten Seite führt zu Serverüberlastung und Crawling-Fehler, während zu wenig Crawl-Resourcen dazu führen, dass wichtige Seiten nie entdeckt werden. Hier gilt: Feintuning durch robots.txt, sitemap.xml und Crawl-Delay-Einstellungen ist essenziell, um das richtige Gleichgewicht zu finden.

Drittens: Netzwerkarchitektur und DNS-Management. Eine saubere, redundante DNS-Konfiguration sorgt dafür, dass deine Server schnell und zuverlässig erreichbar sind. Geo-optimierte DNS-Server verteilen die Anfragen optimal, reduzieren Latenzzeiten und sichern eine gleichmäßige Erfassung in allen Regionen. Damit schickst du die Crawler auf die richtige Route und vermeidest unnötige Verzögerungen.

Strategien für die Optimierung der Crawl- und Indexierungsperformance im Webcrawler-Netzwerk

Um das volle Potenzial deiner Webcrawler-Netzwerke auszuschöpfen, solltest du eine klare Strategie entwickeln. Hier sind die wichtigsten Bausteine für eine effektive Optimierung:

- Strukturierte URL-Architektur: Klare, sprechende URLs, die den Crawl-Flow unterstützen und Hierarchien deutlich machen.

- Sitemap-Management: Aktualisierte, fehlerfreie XML-Sitemaps, die alle relevanten Seiten enthalten und in der Search Console eingereicht sind.

- Robots.txt und Meta-Tags: Präzise Steuerung, welche Ressourcen gecrawlt werden sollen, und Vermeidung von Blockaden wichtiger Ressourcen wie CSS, JS oder Canonicals.

- Redirect- und Canonical-Optimierung: Vermeidung von Redirect-Ketten, Duplicate Content und inkonsistenten Canonical-Tags.

- Server- und Netzwerk-Optimierung: Einsatz moderner Protokolle, CDN, Caching und Komprimierung, um die Antwortzeiten zu minimieren.

- Monitoring und Fehlerbehebung: Regelmäßige Analyse der Server-Logs, Erkennen von Crawl-Fehlern und schnelle Behebung.

Jede dieser Strategien trägt dazu bei, die Effizienz deiner Webcrawler-Netzwerke zu steigern und sicherzustellen, dass dein Content die volle Aufmerksamkeit der Suchmaschinen erhält. Denn nur so kannst du in der zunehmend komplexen Welt des SEO wirklich vorne mitspielen.

Tools und Frameworks: Der technische Werkzeugkasten für Webcrawler Netzwerke

Ohne die richtigen Werkzeuge wird jede technische Optimierung zur Lotterie. Glücklicherweise gibt es eine Vielzahl von Tools, die dir helfen, dein Webcrawler-Netzwerk optimal zu steuern und zu überwachen. Hier eine Auswahl, die du kennen solltest:

- Google Search Console: Für erste Einblicke in Crawling-Fehler, Indexierung und Performance.

- Screaming Frog SEO Spider: Für tiefgehende Crawl-Analysen, Fehlererkennung und Seitenstruktur-Checks.

- Sitebulb: Für visuelle Crawl-Analysen, Fehlerberichte und Empfehlungen.

- WebPageTest.org: Für detaillierte Ladezeit- und Netzwerktests aus verschiedenen Regionen.

- Logfile-Analysetools (z.B. Screaming Frog Log File Analyser): Für die Analyse der tatsächlichen Crawler-Besuche und Crawl-Fehler.

- Pingdom, GTmetrix: Für Performance-Checks und Optimierungspotenziale.

- DNS-Tools (z.B. DNSChecker, NSLookup): Für das DNS-Management und die Netzwerk-Optimierung.

Der Schlüssel liegt in der Kombination dieser Tools, um eine ganzheitliche Sicht auf dein Netzwerk zu bekommen. Nur so kannst du technische Schwachstellen frühzeitig erkennen und beheben.

Die dunkle Seite: Was viele verschweigen und warum du es besser weißt

Nicht alle Strategien, die im SEO-Bereich propagiert werden, sind ehrlich oder transparent. Viele Agenturen verschweigen die Komplexität, verschleiern die technischen Fallen oder verkaufen dir vermeintliche „Easy Wins“, die in der Realität nur kurzfristig funktionieren. Die Wahrheit ist: Ohne tiefgehendes technisches Verständnis wirst du niemals dauerhaft an der Spitze stehen.

Einige Anbieter setzen auf Black-Hat-Methoden, versteckte Redirects oder manipulierte Backlink-Netzwerke, um Rankings künstlich hochzuhalten. Das mag kurzfristig funktionieren, führt aber langfristig zu Abstrafungen und schweren Reputationsverlusten. Der nachhaltige Erfolg basiert auf sauberen, technischen Grundlagen und einem klaren Verständnis der Netzwerk-Struktur.

Darüber hinaus ist die Arbeit mit Webcrawler Netzwerken kein Projekt, das man einmal abschließt. Es ist ein kontinuierlicher Prozess, der ständiges Monitoring, Anpassung und technische Weiterbildung erfordert. Wer hier nach Abkürzungen sucht, verliert früher oder später das Rennen – im schlimmsten Fall mit saftigen Google-Penaltys.

Fazit: Warum technisches Know-how in 2025 unverzichtbar ist

Wer im Jahr 2025 im SEO noch auf Oberflächenoptimierung setzt, wird schnell ins Hintertreffen geraten. Die technischen Hintergründe, die Webcrawler Netzwerke steuern, sind das Fundament, auf dem alles andere aufbaut. Ohne tiefgehendes Verständnis für Crawl-Optimierung, Serverarchitektur und Netzwerkprotokolle wirst du keinen nachhaltigen Erfolg mehr haben. Es geht nicht nur um Rankings – es geht um Kontrolle, Effizienz und die Fähigkeit, mit den sich ständig verändernden Anforderungen Schritt zu halten.

Die Zeiten, in denen eine einfache Content-Strategie ausgereicht hat, sind vorbei. Jetzt zählt technisches Know-how, das in der Lage ist, das unsichtbare Netzwerk hinter den Kulissen zu steuern und zu optimieren. Wer diese Herausforderung annimmt, hat die besten Chancen, in der digitalen Arena dauerhaft vorne mitzuspielen. Alles andere ist Zeitverschwendung – oder nur noch ein Spiel auf Zeit.