Facebook Scraping Setup: Profi-Strategien für smarte Datenextraktion

Wer heute im Online-Marketing wettbewerbsfähig bleiben will, kommt um das Thema Datenextraktion nicht herum. Besonders Facebook, als riesiges soziales Daten-Reservoir, ist für smarte Marketer und Data-Scientisten ein Goldgrube. Doch wer glaubt, einfach nur ein paar Tools laufen zu lassen, hat die Rechnung ohne die technische Komplexität gemacht. Es geht um mehr als nur geklaute Profile und öffentlich zugängliche Daten – es geht um eine strategisch durchdachte, technisch saubere Setup-Architektur, die legal, effizient und nachhaltig ist. Wer hier schludert, landet schnell in der Datenlawine, in Rechtssprechungen oder im technischen Chaos. Willkommen bei der ultimativen Anleitung für Facebook ScrapingScraping: Daten abgreifen wie die Profis – und warum das Netz davor Angst hat Scraping bezeichnet das automatisierte Extrahieren von Daten aus Webseiten oder digitalen Schnittstellen. Wer glaubt, dass das nur was für Hacker im dunklen Hoodie ist, liegt daneben: Scraping ist eine zentrale Technik im digitalen Zeitalter – für SEOs, Marketer, Analysten, Journalisten und sogar für die Konkurrenzbeobachtung. Aber... Setup auf Profi-Niveau – tief, technisch, kompromisslos.

- Was Facebook ScrapingScraping: Daten abgreifen wie die Profis – und warum das Netz davor Angst hat Scraping bezeichnet das automatisierte Extrahieren von Daten aus Webseiten oder digitalen Schnittstellen. Wer glaubt, dass das nur was für Hacker im dunklen Hoodie ist, liegt daneben: Scraping ist eine zentrale Technik im digitalen Zeitalter – für SEOs, Marketer, Analysten, Journalisten und sogar für die Konkurrenzbeobachtung. Aber... wirklich bedeutet – und warum es kein simpler Daten-Download ist

- Rechtliche Rahmenbedingungen: Was erlaubt ist und was nicht

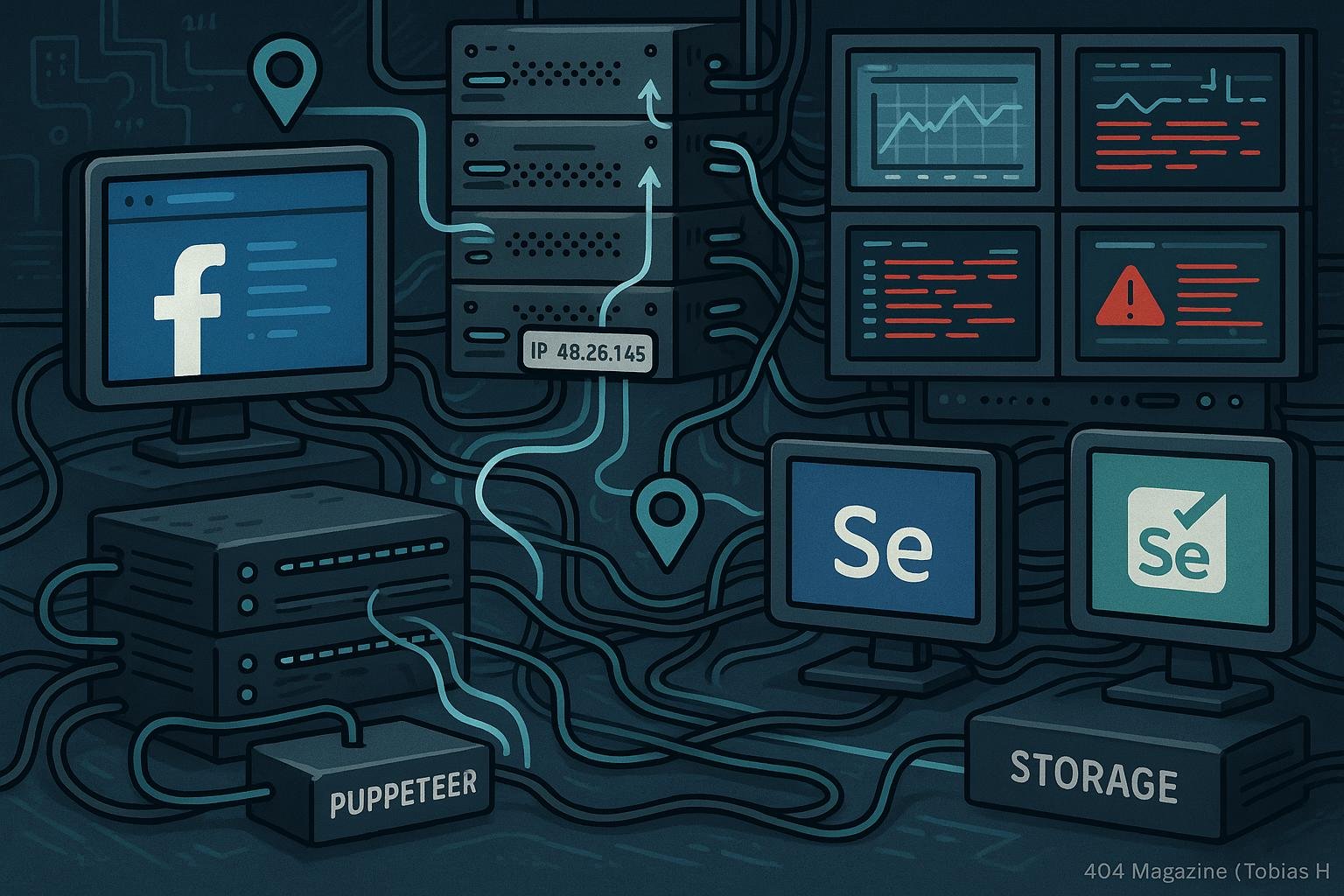

- Technische Grundlagen: APIs, Headless Browser, Proxy-Server & Co.

- Der Aufbau eines skalierbaren und nachhaltigen Scraping-Setups

- Authentifizierung, Session-Management und Anti-Blocking-Strategien

- Proxy-Infrastruktur: Rotierende Proxys, IP-Management und Geolocation

- Captcha-Umgehung: Methoden und Risiken

- Data-Parsing, Speicherung und Qualitätskontrolle

- Monitoring, Fehlerbehandlung und Skalierung

- Tools, Frameworks und Best Practices für Profi-Scraper

Facebook ist nicht mehr nur eine Plattform zum Posten, sondern ein gigantisches Datenlabor, das alles sammelt, was Nutzer tun. Für Marketer, Data-Junkies und Hacker gleichermaßen ist es der Ort, an dem man die versteckten Insights finden kann – wenn man nur wüsste, wie man den AlgorithmusAlgorithmus: Das unsichtbare Rückgrat der digitalen Welt Algorithmus – das Wort klingt nach Science-Fiction, ist aber längst Alltag. Ohne Algorithmen läuft heute nichts mehr: Sie steuern Suchmaschinen, Social Media, Navigation, Börsenhandel, Werbung, Maschinen und sogar das, was du in deinem Lieblingsshop zu sehen bekommst. Doch was ist ein Algorithmus eigentlich, wie funktioniert er und warum ist er das ultimative Werkzeug... austrickst. Doch wer sich nur auf einfache Tools verlässt, landet schnell in der Sackgasse: Facebook hat seine Schutzmechanismen, IP-Blocking, CAPTCHAs und Ratenbegrenzungen, die es zu überwinden gilt. Und genau hier beginnt der technische Spießrutenlauf, bei dem nur die Profis gewinnen.

In diesem Artikel geht es um alles, was du brauchst, um Facebook-Daten auf Profi-Niveau zu extrahieren – legal, effizient und nachhaltig. Es geht um die richtige Infrastruktur, um die richtige Taktik und um das tiefgehende Verständnis der technischen Limits. Denn wer nur mit oberflächlichem Wissen an das Thema herangeht, wird schnell von Facebook ausgebremst oder rechtlich in die Zange genommen. Hier lernst du alles: von der API-Strategie, über Proxy-Management bis hin zu Fehlerbehandlung und Skalierung. Bereit für die harte Wahrheit? Dann los.

Was Facebook Scraping wirklich bedeutet – und warum es kein simpler Daten-Download ist

Facebook ScrapingScraping: Daten abgreifen wie die Profis – und warum das Netz davor Angst hat Scraping bezeichnet das automatisierte Extrahieren von Daten aus Webseiten oder digitalen Schnittstellen. Wer glaubt, dass das nur was für Hacker im dunklen Hoodie ist, liegt daneben: Scraping ist eine zentrale Technik im digitalen Zeitalter – für SEOs, Marketer, Analysten, Journalisten und sogar für die Konkurrenzbeobachtung. Aber... ist kein Kindergeburtstag. Es ist eine hochkomplexe, technisch anspruchsvolle Disziplin, bei der es um mehr als nur das Auslesen von öffentlichen Profilen geht. Es ist eine orchestrierte Aktion, bei der API-Calls, Headless Browser, Proxy-Netzwerke und intelligente Parsing-Algorithmen nahtlos zusammenarbeiten müssen. Ziel ist es, möglichst viele Daten zu extrahieren, ohne dabei aufzufallen oder die Plattform zu blockieren. Die Herausforderung: Facebook hat seine Schutzmechanismen massiv verstärkt, Ratenbegrenzungen eingeführt und den Scraping-Einsatz durch technische und rechtliche Barrieren erschwert.

Ein einfacher Daten-Download reicht heutzutage nicht mehr aus. Es geht um eine robuste Infrastruktur, die auf mehrere Ebenen agiert: API-Authentifizierung, dynamische IP-Rotation, CAPTCHAs-Umgehung und intelligente Timeout-Strategien. Zudem muss die Datenqualität hoch bleiben, um sie für Analysen, Lead-Generierung oder Wettbewerbsbeobachtung nutzbar zu machen. Das erfordert tiefgehendes technisches Verständnis, automatisierte Monitoring-Tools und eine kontinuierliche Optimierung der Abläufe. Nur so bleibt dein Setup langfristig funktionsfähig und legal.

Der Unterschied zwischen einem Hobby-Scraper und einem Profi-Setup ist die Systematik. Während Einsteiger oft mit einfachen Python-Skripten und unrotierenden IPs arbeiten, setzen Profis auf skalierbare Infrastruktur, eine ausgeklügelte Proxy-Architektur und automatisierte Fehlerbehandlung. Das Ziel: maximale Datenmenge bei minimalem Risiko, ohne dass Facebook den Zugriff dauerhaft sperrt. Das ist kein Zufall, sondern das Ergebnis einer durchdachten Strategie, die auf technische Tiefe setzt.

Rechtliche Rahmenbedingungen: Was erlaubt ist und was nicht

Bevor du dich in technische Details stürzt, solltest du die rechtliche Seite klären. Facebook ist – wie alle Plattformen – durch Nutzungsbedingungen, Urheberrecht und Datenschutzgesetze geschützt. Das bedeutet: Nicht alles, was technisch möglich ist, ist auch legal. Das Sammeln von öffentlich zugänglichen Daten ist grundsätzlich erlaubt, solange keine automatisierten Mittel gegen die Nutzungsbedingungen verstoßen. Doch bei automatisiertem ScrapingScraping: Daten abgreifen wie die Profis – und warum das Netz davor Angst hat Scraping bezeichnet das automatisierte Extrahieren von Daten aus Webseiten oder digitalen Schnittstellen. Wer glaubt, dass das nur was für Hacker im dunklen Hoodie ist, liegt daneben: Scraping ist eine zentrale Technik im digitalen Zeitalter – für SEOs, Marketer, Analysten, Journalisten und sogar für die Konkurrenzbeobachtung. Aber..., IP-Blocking-Umgehung oder Captchas-Bypass wird es schnell brenzlig.

In Deutschland und der EU gilt die DSGVO, die strenge Regeln für die Verarbeitung persönlicher Daten aufstellt. Das bedeutet: Selbst öffentlich zugängliche Profile dürfen nicht ohne Weiteres massenhaft gespeichert und ausgewertet werden. Es ist essenziell, stets die rechtlichen Grenzen zu kennen und eine transparenten Umgang mit den Daten zu pflegen. Verstöße können empfindliche Abmahnungen, Bußgelder und Schadensersatzforderungen nach sich ziehen.

Gleichzeitig ist es sinnvoll, den Fokus auf öffentlich zugängliche Datenquellen zu legen – beispielsweise öffentliche Gruppen, Seiten-Feeds oder offene Profile. Das Umgehen von CAPTCHAs oder das automatisierte Umgehen von Sicherheitsschranken ist rechtlich riskant und kann als Angriff auf die Plattform gewertet werden. Daher ist eine klare Strategie unabdingbar: Was legal ist, sollte genutzt werden – alles andere ist Risiko, das du dir kaum leisten kannst.

Technische Grundlagen: APIs, Headless Browser, Proxy-Server & Co.

Das Fundament eines Profi-Setups ist das Verständnis der technischen Tools, die du brauchst. Facebook bietet eine offizielle APIAPI – Schnittstellen, Macht und Missverständnisse im Web API steht für „Application Programming Interface“, zu Deutsch: Programmierschnittstelle. Eine API ist das unsichtbare Rückgrat moderner Softwareentwicklung und Online-Marketing-Technologien. Sie ermöglicht es verschiedenen Programmen, Systemen oder Diensten, miteinander zu kommunizieren – und zwar kontrolliert, standardisiert und (im Idealfall) sicher. APIs sind das, was das Web zusammenhält, auch wenn kein Nutzer je eine..., die allerdings nur für bestimmte Anwendungsfälle und mit strengen Limitierungen nutzbar ist. Für umfangreiches ScrapingScraping: Daten abgreifen wie die Profis – und warum das Netz davor Angst hat Scraping bezeichnet das automatisierte Extrahieren von Daten aus Webseiten oder digitalen Schnittstellen. Wer glaubt, dass das nur was für Hacker im dunklen Hoodie ist, liegt daneben: Scraping ist eine zentrale Technik im digitalen Zeitalter – für SEOs, Marketer, Analysten, Journalisten und sogar für die Konkurrenzbeobachtung. Aber... ist sie meist nicht ausreichend, weshalb viele auf alternative Methoden ausweichen. Hier kommen Headless Browser ins Spiel: Werkzeuge wie Puppeteer, Playwright oder Selenium simulieren das NutzerverhaltenNutzerverhalten: Das unbekannte Betriebssystem deines digitalen Erfolgs Nutzerverhalten beschreibt, wie Menschen im digitalen Raum interagieren, klicken, scrollen, kaufen oder einfach wieder verschwinden. Es ist das unsichtbare Skript, nach dem Websites funktionieren – oder eben grandios scheitern. Wer Nutzerverhalten nicht versteht, optimiert ins Blaue, verschwendet Budgets und liefert Google und Co. die falschen Signale. In diesem Glossarartikel zerlegen wir das Thema... in einem echten Browser, laden Seiten, führen JavaScriptJavaScript: Das Rückgrat moderner Webentwicklung – und Fluch für schlechte Seiten JavaScript ist die universelle Programmiersprache des Webs. Ohne JavaScript wäre das Internet ein statisches Museum aus langweiligen HTML-Seiten. Mit JavaScript wird aus einer simplen Webseite eine interaktive Webanwendung, ein dynamisches Dashboard oder gleich ein kompletter Online-Shop. Doch so mächtig die Sprache ist, so gnadenlos ist sie auch bei schlechter... aus und liefern realistische Daten.

Headless Browser sind das Herzstück, um dynamische Inhalte zu erfassen, die nur beim Laden im Browser sichtbar werden. Sie sind aber ressourcenintensiv, weshalb sie nur in Kombination mit Proxy-Management effizient funktionieren. Proxy-Server, vor allem rotierende Proxys, sind essenziell, um IP-Blockaden zu umgehen, Geolocation-Targeting zu ermöglichen und Crawl-Bates zu strecken. Hierbei ist es wichtig, Proxys mit hohem Anonymitätslevel zu verwenden, um nicht aufzufallen.

Ein weiterer Baustein ist das Session-Management: CookiesCookies: Die Wahrheit über die kleinen Datenkrümel im Web Cookies sind kleine Textdateien, die Websites im Browser eines Nutzers speichern, um Informationen über dessen Aktivitäten, Präferenzen oder Identität zu speichern. Sie gehören zum technischen Rückgrat des modernen Internets – oft gelobt, oft verteufelt, meistens missverstanden. Ob personalisierte Werbung, bequeme Logins oder penetrante Cookie-Banner: Ohne Cookies läuft im Online-Marketing fast gar..., Header-Management und Authentifizierung. Facebook setzt auf Session-IDs, Login-Tokens und spezielle HeaderHeader: Definition, Bedeutung und technischer Tiefgang für SEO & Webentwicklung Der Begriff Header ist ein Paradebeispiel für ein vielschichtiges Buzzword im Online-Marketing, Webdevelopment und SEO. Wer das Thema nur auf Überschriften reduziert, macht denselben Fehler wie ein Hobbykoch, der Salz für die einzige Zutat hält. „Header“ bezeichnet in der digitalen Welt mehrere, teils grundlegende Bausteine – von HTTP-Headern über HTML-Header..., um den Zugriff zu kontrollieren. Profi-Setups automatisieren das Session-Handling, um kontinuierlich authentifiziert zu bleiben und das Risiko von IP- oder Account-Blockaden zu minimieren. Zudem müssen Timeout-Strategien, Retry-Mechanismen und Fehler-Handling integriert werden, um den Betrieb stabil zu halten.

Authentifizierung, Session-Management und Anti-Blocking-Strategien

Authentifizierung ist in vielen Fällen unerlässlich – vor allem, wenn private oder geschützte Gruppen analysiert werden sollen. Hier kommen OAuth, CookiesCookies: Die Wahrheit über die kleinen Datenkrümel im Web Cookies sind kleine Textdateien, die Websites im Browser eines Nutzers speichern, um Informationen über dessen Aktivitäten, Präferenzen oder Identität zu speichern. Sie gehören zum technischen Rückgrat des modernen Internets – oft gelobt, oft verteufelt, meistens missverstanden. Ob personalisierte Werbung, bequeme Logins oder penetrante Cookie-Banner: Ohne Cookies läuft im Online-Marketing fast gar... oder Login-Token ins Spiel. Das automatisierte Login ist technisch anspruchsvoll: Session-Cookies müssen gespeichert, regelmäßig erneuert und bei jedem Request mitgesendet werden. Das Ziel ist es, den Anschein eines echten Nutzers zu erwecken, um Login-Blockaden zu vermeiden.

Anti-Blocking-Strategien sind der Schlüssel, um nicht permanent ausgesperrt zu werden. Dazu zählen IP-Rotation, User-Agent-Randomisierung, Zeitverzögerungen zwischen Requests, Header-Emulationen und das Umgehen von CAPTCHAs. Das Einsetzen von CAPTCHA-Bypass-Services ist riskant, da Facebook diese aktiv bekämpft. Alternativen sind Machine-Learning-basierte Lösungen, die auf Mustererkennung setzen, oder das gezielte Ausnutzen von Schwachstellen in der Plattform-Implementierung.

Wichtig ist, den TrafficTraffic: Die wahre Währung des digitalen Marketings Traffic – der Begriff klingt harmlos, fast banal. Tatsächlich ist Traffic das Lebenselixier jeder Website, der Pulsschlag des Online-Marketings und der ultimative Gradmesser für digitale Sichtbarkeit. Ohne Traffic bleibt jede noch so geniale Seite ein Geisterschiff im Ozean des Internets. Dieser Glossar-Artikel zerlegt das Thema Traffic in seine Einzelteile, von Definition bis Technologie,... so zu maskieren, dass er wie menschliches Verhalten wirkt. Das bedeutet: Variabilität in Request-Intervallen, unterschiedliche User-Agents, Browser-Fingerprints und zufällige Pausen. Eine saubere Proxy-Infrastruktur, die IPs aus verschiedenen Geos verwendet, sorgt zudem für eine unauffällige Tarnung. Ohne diese Strategien wirst du schnell von Facebook ausgesperrt – und das ist das Ende eines jeden automatisierten Setups.

Proxy-Infrastruktur: Rotierende Proxys, IP-Management und Geolocation

Proxys sind das Rückgrat eines jeden Profi-Setups. Egal ob datenschutzrechtlich, technischer oder strategischer Natur: Ohne eine smarte Proxy-Architektur kannst du schnell in der Sackgasse landen. Rotierende Proxys, die bei jedem Request eine neue IP-Adresse liefern, sind essenziell, um Blockaden zu vermeiden und Geolocation-Targeting zu ermöglichen. Hierbei gilt: Je vielfältiger das Proxy-Portfolio, desto schwerer erkennt Facebook dein Muster.

Das Management der Proxy-IPs erfolgt meist automatisiert: IP-Listen werden regelmäßig aktualisiert, Proxies auf ihre Verfügbarkeit geprüft und in Load Balancer integriert. Die Wahl der Proxy-Anbieter ist entscheidend: Hochwertige, schnelle und anonyme Proxys kosten mehr, bieten aber den Vorteil, dass sie länger funktionieren und seltener blockiert werden. Zudem sollte die Infrastruktur die Möglichkeit bieten, einzelne Proxys gezielt zu pausieren oder zu erneuern.

Geolocation ist für Targeting-Strategien und das Umgehen von Ländersperren notwendig. Mit Proxy-Netzwerken kannst du gezielt aus verschiedenen Ländern crawlen, um länderspezifische Inhalte zu extrahieren. Das erfordert eine gut durchdachte Infrastruktur, die IPs aus verschiedenen Regionen bereitstellt, und eine dynamische Steuerung, um die Requests intelligent zu verteilen. Bei der Einrichtung gilt: Mehrere Layer, redundante Systeme und kontinuierliches Monitoring sind Pflicht.

Captcha-Umgehung: Methoden und Risiken

CAPTCHAs sind die letzte Verteidigungslinie gegen automatisiertes ScrapingScraping: Daten abgreifen wie die Profis – und warum das Netz davor Angst hat Scraping bezeichnet das automatisierte Extrahieren von Daten aus Webseiten oder digitalen Schnittstellen. Wer glaubt, dass das nur was für Hacker im dunklen Hoodie ist, liegt daneben: Scraping ist eine zentrale Technik im digitalen Zeitalter – für SEOs, Marketer, Analysten, Journalisten und sogar für die Konkurrenzbeobachtung. Aber.... Sie sind eine echte Herausforderung, weil Facebook ständig neue CAPTCHAs einführt, um Scraper zu stoppen. Das Umgehen ist technisch möglich, aber mit erheblichen Risiken verbunden. Automatisierte CAPTCHA-Bypass-Services wie 2Captcha, Anti-Captcha oder DeathByCaptcha setzen auf menschliche Worker oder Machine-Learning-Algorithmen, um CAPTCHAs in Echtzeit zu lösen.

Doch diese Methoden sind nicht nur teuer, sondern auch riskant. Facebook kann das Erkennungsmuster von CAPTCHA-Lösungen leicht erkennen und Accounts oder IPs sperren. Zudem besteht die Gefahr, dass bei Missbrauch rechtliche Konsequenzen drohen. Profi-Setups setzen daher auf Strategien, die CAPTCHAs so gut wie möglich vermeiden: IP-Management, Session-Handling und gezielte Nutzung von APIs, die ohne CAPTCHA auskommen.

Wenn du dennoch CAPTCHAs umgehst, solltest du unbedingt auf eine robuste Fehlerbehandlung setzen, um bei Erkennung schnell zu reagieren. Das bedeutet: automatische IP-Wechsel, Proxy-Refresh und temporäres Pausieren der Requests. Alles zusammen ergibt eine riskante, aber potenziell erfolgreiche Taktik – wenn du es richtig machst.

Data-Parsing, Speicherung und Qualitätskontrolle

Die gesammelten Daten müssen nach der Extraktion sauber geparst, gespeichert und regelmäßig kontrolliert werden. Das Parsing erfolgt meist in Echtzeit mittels Regex, XPath oder CSS-Selektoren, abhängig vom Datenformat. Ziel ist es, die Rohdaten in eine strukturierte Datenbank zu überführen, die für Analysen, Machine LearningMachine Learning: Algorithmische Revolution oder Buzzword-Bingo? Machine Learning (auf Deutsch: Maschinelles Lernen) ist der Teilbereich der künstlichen Intelligenz (KI), bei dem Algorithmen und Modelle entwickelt werden, die aus Daten selbstständig lernen und sich verbessern können – ohne dass sie explizit programmiert werden. Klingt nach Science-Fiction, ist aber längst Alltag: Von Spamfiltern über Gesichtserkennung bis zu Produktempfehlungen basiert mehr digitale Realität... oder Reporting nutzbar ist.

Wichtig ist eine flexible Datenarchitektur: NoSQL-Datenbanken wie MongoDB oder Elasticsearch eignen sich gut für unstrukturierte Daten, relationale Datenbanken für strukturierte Infos. Die Speicherung sollte skalierbar sein, um große Datenmengen effizient zu verwalten. Zudem sind Backup-Strategien und Datenintegritätschecks Pflicht, um Datenverlust zu vermeiden.

Qualitätskontrolle bedeutet, fehlerhafte, doppelte oder unvollständige Daten zu identifizieren und zu bereinigen. Automatisierte Checks auf Duplikate, Inkonsistenzen und fehlende Felder sind notwendig. Zudem sollte das System in der Lage sein, bei Erkennung von Fehlern automatisch Korrekturen vorzunehmen oder Alerts auszulösen, damit du keine wertvollen Insights verlierst.

Monitoring, Fehlerbehandlung und Skalierung

Ein professionelles Facebook ScrapingScraping: Daten abgreifen wie die Profis – und warum das Netz davor Angst hat Scraping bezeichnet das automatisierte Extrahieren von Daten aus Webseiten oder digitalen Schnittstellen. Wer glaubt, dass das nur was für Hacker im dunklen Hoodie ist, liegt daneben: Scraping ist eine zentrale Technik im digitalen Zeitalter – für SEOs, Marketer, Analysten, Journalisten und sogar für die Konkurrenzbeobachtung. Aber... Setup lebt von kontinuierlichem Monitoring. Dazu gehören Logs, Dashboards und automatische Alerts für Blockaden, Failures oder Performance-Engpässe. Tools wie Grafana, Prometheus oder eigene Dashboards helfen, den Überblick zu behalten und schnell auf Probleme zu reagieren.

Fehlerbehandlung ist essenziell: Wenn eine IP blockiert wird, muss das System automatisch eine neue IP aus dem Proxy-Pool ziehen. Bei CAPTCHAs-Fehlern ist eine automatische Re-Request-Strategie gefragt. Zudem sollten Wiederholungs- und Timeout-Mechanismen integriert sein, damit der Scraper nicht in Endlosschleifen verfällt.

Skalierung bedeutet, die Infrastruktur so auszulegen, dass bei steigendem Datenvolumen keine Engpässe entstehen. Cloud-Services, Load Balancer, horizontale Skalierung der Proxy-Server und eine modulare Architektur sind hier die Schlagwörter. Nur so kannst du in Echtzeit große Datenmengen sammeln, ohne die Plattform zu überlasten oder den Zugriff zu gefährden.

Tools, Frameworks und Best Practices für Profi-Scraper

Profi-Scraper setzen auf eine Kombination aus bewährten Frameworks und individuellen Modulen. Für Headless Browser ist Puppeteer in Kombination mit Node.js der Standard, bei Proxy-Management kommen Tools wie ProxyRack, Bright Data oder eigene Proxy-Server zum Einsatz. Für Datenparsing und Speicherung eignen sich Python-Frameworks wie Scrapy, BeautifulSoup oder Pandas.

Best Practices umfassen: Modularisierung des Codes, automatisiertes Error-Handling, kontinuierliches Monitoring, regelmäßige Proxy-Wechsel, dynamisches Timeout-Management und das Einhalten der rechtlichen Rahmenbedingungen. Zudem ist eine gute Dokumentation und Versionierung der Scripts Pflicht, um bei Updates schnell reagieren zu können.

Schlussendlich gilt: Nur wer tief in die Technik eintaucht, kann dauerhaft erfolgreich scrapen. Das ist kein Hobby, sondern eine Wissenschaft für sich – eine Disziplin, die ständiger Weiterentwicklung bedarf, um auf der sicheren Seite zu bleiben.

Fazit: Das Profi-Setup für Facebook Scraping – tief, technisch, nachhaltig

Facebook ScrapingScraping: Daten abgreifen wie die Profis – und warum das Netz davor Angst hat Scraping bezeichnet das automatisierte Extrahieren von Daten aus Webseiten oder digitalen Schnittstellen. Wer glaubt, dass das nur was für Hacker im dunklen Hoodie ist, liegt daneben: Scraping ist eine zentrale Technik im digitalen Zeitalter – für SEOs, Marketer, Analysten, Journalisten und sogar für die Konkurrenzbeobachtung. Aber... auf Profi-Niveau ist kein Hexenwerk, aber eine Herausforderung für jeden, der nicht nur schnell Daten sammeln, sondern auch dauerhaft, legal und effizient arbeiten will. Es erfordert eine solide technische Infrastruktur, ein tiefgehendes Verständnis der Plattform-Architektur und eine klare Strategie für Fehler- und Blockadenmanagement. Wer hier schludert, landet schnell im Daten-Blackout oder riskiert rechtliche Konsequenzen.

Der Schlüssel zum Erfolg liegt in der Kombination aus technischer Tiefe, systematischer Planung und kontinuierlicher Optimierung. Nur so kannst du große Datenmengen zuverlässig, schnell und vor allem unauffällig extrahieren. Wer das beherrscht, hat einen entscheidenden Vorteil im digitalen Wettbewerb – und ist der Plattform immer einen Schritt voraus. Ohne diese Expertise bleibt Facebook ScrapingScraping: Daten abgreifen wie die Profis – und warum das Netz davor Angst hat Scraping bezeichnet das automatisierte Extrahieren von Daten aus Webseiten oder digitalen Schnittstellen. Wer glaubt, dass das nur was für Hacker im dunklen Hoodie ist, liegt daneben: Scraping ist eine zentrale Technik im digitalen Zeitalter – für SEOs, Marketer, Analysten, Journalisten und sogar für die Konkurrenzbeobachtung. Aber... nur ein Spiel mit hohem Risiko und geringer Ausbeute. Wer Profi ist, der setzt auf nachhaltige, technisch saubere Lösungen – genau das ist der Weg zu echten Insights und langfristigem Erfolg.