SEO Routing Fehler vermeiden: Clevere Strategien für nachhaltigen Erfolg

Wenn deine Website im SEO-Labyrinth verloren geht, liegt das oft an Routing-Fehlern, die Google und Co. heimlich killen – ohne dass du es merkst. Es ist Zeit, den Code-Dschungel zu lichten, die richtigen Routing-Strategien zu implementieren und endlich wieder sichtbar zu werden. Denn wer bei der URL-Architektur und Serverkonfiguration schludert, spielt SEO-Roulette – mit katastrophalem Ergebnis.

- Was sind Routing-Fehler im SEO-Kontext und warum sind sie so gefährlich?

- Die wichtigsten SEO-Routing-Fehler, die du kennen und vermeiden musst

- Wie URL-Struktur, Redirects und Serverkonfiguration dein Ranking beeinflussen

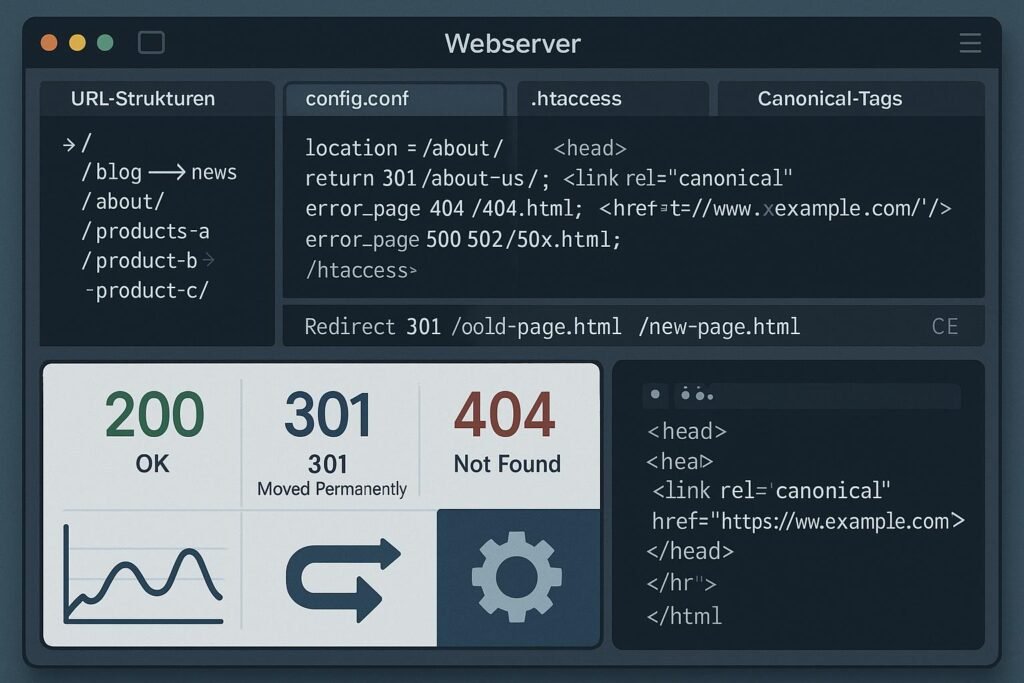

- Technische Grundlagen: HTTP-Statuscodes, Canonicals und Duplicate Content

- Strategien für nachhaltiges Routing: Best Practices für saubere URLs und Redirects

- Tools und Techniken zur Fehlerdiagnose und -behebung bei Routing-Problemen

- Fallstricke bei JavaScript, SPA und dynamischen URLs: Warum Routing hier besonders tricky ist

- Langfristige Monitoring-Strategien: So bleibt dein Routing fehlerfrei

- Was viele Provider verschweigen: Servereinstellungen, die dein SEO ruinieren

- Fazit: Warum Routing-Strategie das Fundament für nachhaltigen SEO-Erfolg ist

Was sind Routing-Fehler im SEO-Kontext und warum sind sie so gefährlich?

Routing-Fehler sind die heimlichen Saboteure deiner SEO-Strategie. Sie entstehen, wenn URLs falsch konfiguriert, Redirect-Ketten unübersichtlich oder Server-Responses nicht korrekt gesetzt sind. Diese Fehler lassen Google im Regen stehen, verhindern eine saubere Indexierung oder führen zu Duplicate Content. Das Ergebnis: Deine Rankings leiden, Traffic schmilzt und die Sichtbarkeit gerät ins Abseits.

Im Kern geht es beim Routing darum, wie URLs im Backend auf die Inhalte deiner Seite abgebildet werden. Eine fehlerhafte Routing-Strategie sorgt dafür, dass Google nicht weiß, welche URL welche Inhalte liefert, oder dass es durch Redirect-Schleifen und Duplicate Content verwirrt wird. Das sind keine kleinen Fehler – das sind Killer, die deine SEO-Performance sofort in den Keller schicken, lange bevor der Content überhaupt richtig bewertet wurde.

Die Gefahr liegt darin, dass solche Fehler oft unbemerkt bleiben – bis der Traffic weg ist. Google crawlt, indexiert und rankt nur das, was technisch sauber ist. Alles, was im Routing versagt, landet im digitalen Nirwana. Und je komplexer dein Setup ist – etwa mit dynamischen URLs, SPA-Frameworks oder mehrsprachigem Content –, desto anfälliger wirst du für Routing-Fallen.

Die wichtigsten SEO-Routing-Fehler, die du kennen und vermeiden musst

Es gibt eine Reihe von klassischen Routing-Fehlern, die im SEO-Alltag immer wieder für Probleme sorgen. Manche sind offensichtlich, andere verstecken sich im Backend, im Server-Setup oder in der URL-Architektur. Hier die häufigsten:

- Duplicate Content durch inkonsistente Canonical-Tags: Wenn mehrere URLs denselben Inhalt anzeigen und kein klares Canonical-Tag gesetzt ist, weiß Google nicht, welche Version zu bevorzugen ist – Rankingverlust inklusive.

- Redirect-Ketten und Redirect-Loops: Längere Weiterleitungsketten oder endlose Schleifen führen zu Crawling-Timeouts und verhindern, dass Google deine Seiten vollständig indexiert.

- Fehlerhafte Statuscodes: 404, 301, 302 – das richtige Setzen ist essenziell. Ein 404 bei wichtigen Seiten oder 302-Redirects bei Permanent-Content-Veränderungen sind Killer für SEO.

- Unsaubere URL-Struktur: Unleserliche, zu lange oder dynamische URLs mit unpassenden Parametern verwirren Google und schaden der Crawl-Effizienz.

- Blockierte Ressourcen: In der robots.txt oder serverseitig blockierte CSS-, JS- oder Bilddateien verhindern korrektes Rendering und beeinflussen Core Web Vitals negativ.

- Fehler bei dynamischen URLs: Wenn dein Framework URLs generiert, die Google nicht versteht oder nur schwer crawlen kann, ist das eine große Baustelle.

Wie URL-Struktur, Redirects und Serverkonfiguration dein Ranking beeinflussen

Eine saubere URL-Struktur ist das Rückgrat jeder nachhaltigen SEO-Strategie. Sie erleichtert nicht nur Google das Crawlen, sondern macht auch den Nutzern das Leben leichter. Klare, sprechende URLs mit Hierarchie und Keywords sind Gold wert. Aber auch bei Redirects und Servereinstellungen darf man keinen Unsinn machen, sonst wird aus der besten URL das SEO-Desaster.

Redirects sind notwendig, wenn Inhalte umgezogen oder gelöscht werden. Hier gilt: Keine Ketten, keine Loops. Jede Redirect-Kette sollte maximal zwei Schritte umfassen. Optimal ist eine direkte 301-Weiterleitung vom alten zum neuen Ziel. Bei 302-Redirects ist Vorsicht geboten – sie signalisieren temporäre Änderungen, die Google manchmal falsch interpretiert.

Die Serverkonfiguration ist ebenso entscheidend. HTTP-Statuscodes müssen korrekt gesetzt sein. Ein 200-OK bei funktionierenden Seiten, 404 bei nicht gefundenen Inhalten und 410 bei dauerhaft gelöschten Ressourcen sind Standard. Fehlerhafte Serverantworten verwirren Google, schlagen auf die Crawl-Rate und schaden der Indexierung. Ebenso wichtig sind Server-Response-Header, Caching-Strategien und die Verwendung moderner Protokolle wie HTTP/2 oder HTTP/3, um Ladezeiten zu minimieren.

Technische Grundlagen: HTTP-Statuscodes, Canonicals und Duplicate Content

HTTP-Statuscodes sind das Kommunikationsprotokoll zwischen Server und Crawler. Ein 200-Status signalisiert, dass die Ressource erfolgreich geladen wurde. 301-Redirects sind permanent und übertragen das Link-Equity. 404 zeigt an, dass die Seite nicht gefunden wurde. Fehlerhafte oder fehlende Statuscodes führen zu Crawling-Fehlern und Indexierungsverlusten.

Canonical-Tags sind die Rettungsboje bei Duplicate Content. Sie weisen Google darauf hin, welche URL die bevorzugte Version ist. Ohne ordnungsgemäß gesetzte Canonicals riskierst du, dass Google deine Inhalte auf mehrere URLs verteilt, was die SEO-Wirkung schwächt. Besonders bei dynamischen URLs, Filterparametern und Content-Replikaten ist das unumgänglich.

Duplicate Content ist der Feind schlechthin. Er entsteht durch mehrere URLs, die denselben Inhalt zeigen, oder durch unklare Weiterleitungen. Das kostet Crawl-Bonbons und kann dazu führen, dass Google nur eine Version rankt, während die anderen ausgeblendet werden. Hier gilt: Klare Canonical-Strategien, saubere URL-Parameter-Management und Redirect-Regeln sind Pflicht statt Kür.

Strategien für nachhaltiges Routing: Best Practices für saubere URLs und Redirects

Wer nachhaltig erfolgreich sein will, braucht eine klare Routing-Strategie. Hier die wichtigsten Best Practices:

- Klare URL-Hierarchien: Strukturierte URLs mit logischer Hierarchie, z.B. /kategorie/produkt/ oder /blog/artikel/, erleichtern Google das Crawlen und Nutzern das Verständnis.

- Keyword-optimierte URLs: Kurze, prägnante Keywords im URL-Pfad, die den Inhalt widerspiegeln, verbessern die Relevanz und Klickrate.

- Vermeidung dynamischer Parameter: Nutze URL-Parameter nur, wenn notwendig. Optimiere sie mit der URL-Parameter-Tool in der Google Search Console.

- Redirect-Management: Bei Content-Umzügen immer 301-Redirects verwenden, Ketten vermeiden, Redirect-Loops sofort beheben.

- Canonical-Tag setzen: Für doppelte Inhalte immer das richtige Canonical angeben, um Google die richtige Version zu zeigen.

- Server-Response-Header: Korrekte Statuscodes, Caching und GZIP/Brotli-Kompression für schnelle Response-Zeiten.

Tools und Techniken zur Fehlerdiagnose und -behebung bei Routing-Problemen

Um Routing-Fehler zu erkennen und zu beheben, brauchst du die richtigen Werkzeuge. Hier eine Auswahl der wichtigsten:

- Screaming Frog SEO Spider: Crawl-Analyse, Fehler bei Redirects, Statuscodes, Canonicals und Duplicate Content aufspüren.

- Google Search Console: Indexierungsstatus, Crawling-Fehler, URL-Inspektion und Redirect-Reports.

- Redirect-Checker: Tools wie Redirect-Path oder HTTP Status Code Tester, um Redirect-Ketten und Loops zu identifizieren.

- WebPageTest & Lighthouse: Ladezeiten, Response-Header, HTTP/2-Status und Performance-Optimierung.

- Server-Logfile-Analyse: Echtzeit-Tracking, wie Googlebot deine URLs besucht, Fehler bei Crawling und Response-Status.

Fallstricke bei JavaScript, SPA und dynamischen URLs: Warum Routing hier besonders tricky ist

Moderne Web-Apps basieren auf JavaScript-Frameworks wie React, Angular oder Vue. Sie generieren dynamisch Inhalte, was das Routing kompliziert macht. Google ist zwar in der Lage, JavaScript zu rendern, aber der Prozess ist aufwendig, ressourcenintensiv und nicht immer zuverlässig. Das Problem: Google crawlt oft nur die initiale HTML-Version, bevor JavaScript ausgeführt wird – was bei Single-Page-Apps (SPA) problematisch ist.

Hier helfen serverseitiges Rendering (SSR) oder statisches Pre-Rendering, um Google die vollständigen Inhalte direkt zu liefern. Ohne diese Maßnahmen riskierst du, dass Google nur eine leere Hülle indexiert, während der Nutzer die App voll funktionsfähig sieht. Das führt zu erheblichen Ranking-Einbußen, weil Google deine Inhalte nicht richtig erkennt.

Ein weiterer Trick: Das sogenannte Hydration-Konzept, bei dem die initial gerenderte HTML-Seite durch JavaScript interaktiv gemacht wird. Wichtig ist, dass alle für SEO relevanten Inhalte auch im serverseitigen HTML vorhanden sind. Andernfalls droht die Gefahr, dass Google deine Seiten als irrelevant abstempelt.

Langfristige Monitoring-Strategien: So bleibt dein Routing fehlerfrei

Routing-Fehler sind kein einmaliger Fehler, sondern eine dauerhafte Baustelle. Deshalb solltest du kontinuierlich überwachen, ob alles noch funktioniert. Hier die wichtigsten Maßnahmen:

- Regelmäßige Crawls: Nutze SEO-Tools wie Screaming Frog oder Sitebulb, um regelmäßig deine URL-Struktur zu prüfen.

- Automatisierte Checks: Setze Monitoring-Tools mit Alerts bei 404-Fehlern, Redirect-Fehlern oder Indexierungsproblemen.

- Logfile-Analyse: Überwache, wie Google deine URLs besucht, und erkenne Probleme beim Crawling frühzeitig.

- Core Web Vitals & Performance Monitoring: Überprüfe regelmäßig Ladezeiten, Response-Header und Server-Performance.

- CMS- und Server-Updates: Halte alle Systeme aktuell, um Routing-Fehler durch veraltete Plugins oder Server-Konfigurationen zu vermeiden.

Was viele Provider verschweigen: Servereinstellungen, die dein SEO ruinieren

Viele Hosting-Provider liefern Standard-Servereinstellungen, die SEO-Fehler verursachen. Gängige Probleme sind:

- Fehlerhafte Caching-Konfiguration: Zu aggressive oder fehlende Caching-Strategien bremsen die Ladezeiten oder liefern veraltete Inhalte.

- Unzureichende Server-Response-Header: Fehlende GZIP- oder Brotli-Kompression, falsche Cache-Control-Header.

- Veraltete Protokolle: HTTP/1.1 statt HTTP/2 oder HTTP/3 – das kostet Performance.

- Langsame TTFB (Time to First Byte): Oft durch schlecht konfigurierte Server oder langsame Hosting-Umgebungen verursacht.

- Blockierte Ressourcen: Standard-robots.txt blockiert wichtige CSS- oder JS-Dateien – Fatal für Rendering und Core Web Vitals.

Fazit: Warum Routing-Strategie das Fundament für nachhaltigen SEO-Erfolg ist

Technisches Routing ist kein sexy Thema, aber ein absolutes Muss. Ohne eine saubere URL-Architektur, fehlerfreie Redirects und korrekt konfigurierte Server verliert deine Website im SEO-Kampf wertvolle Punkte. Es ist die Grundlage, auf der alles andere aufbaut: Content, Backlinks, Usability. Wer hier schludert, spielt SEO-Roulette – mit dauerhaft schlechten Rankings, Trafficverlust und geschwächter Wettbewerbsfähigkeit.

Langfristig betrachtet, ist eine durchdachte Routing-Strategie der Schlüssel zu nachhaltigem Erfolg. Es geht nicht nur um kurzfristige Rankings, sondern um eine stabile, performante und suchmaschinengerechte Infrastruktur. Wenn du dich regelmäßig um deine Routing-Fehler kümmerst, schützt du deine Website vor den Fallen der Suchmaschinen-Algorithmen und stellst sicher, dass dein Content immer den Weg nach oben findet.