Crawler Zugriff über Tokens: Sicher steuern und optimieren

Wenn du glaubst, dein Web-Server ist nur für unwichtige API-Calls oder Datenbanken da, hast du vom digitalen Krieg um SichtbarkeitSichtbarkeit: Die unbarmherzige Währung des digitalen Marketings Wenn es im Online-Marketing eine einzige Währung gibt, die wirklich zählt, dann ist es Sichtbarkeit. Sichtbarkeit – im Fachjargon gern als „Visibility“ bezeichnet – bedeutet schlicht: Wie präsent ist eine Website, ein Unternehmen oder eine Marke im digitalen Raum, insbesondere in Suchmaschinen wie Google? Wer nicht sichtbar ist, existiert nicht. Punkt. In diesem... und Kontrolle noch nicht viel mitbekommen. Token-basierte Zugriffskontrolle ist das neue Schwarz im Kampf um sichere, performante und suchmaschinenfreundliche Websites. Doch nur, wer die technischen Feinheiten versteht und richtig anwendet, kann seine CrawlerCrawler: Die unsichtbaren Arbeiter der digitalen Welt Crawler – auch bekannt als Spider, Bot oder Robot – sind automatisierte Programme, die das Fundament des modernen Internets bilden. Sie durchforsten systematisch Webseiten, erfassen Inhalte, analysieren Strukturen und übermitteln diese Daten an Suchmaschinen, Plattformen oder andere zentrale Dienste. Ohne Crawler wäre Google blind, SEO irrelevant und das World Wide Web ein chaotischer... wirklich steuern – und zwar so, dass sie dir nützen, nicht schaden. Bereit, das Spiel zu gewinnen? Dann schnall dich an, wir gehen tief rein.

- Was sind Tokens im Kontext von Crawling und Zugriffskontrolle?

- Warum Token-basierte Zugriffskontrolle im SEO-Umfeld eine Rolle spielt

- Die wichtigsten Token-Varianten für Crawling-Strategien

- Risiken und Fallen bei der Steuerung von Crawlern mit Tokens

- Praktische Umsetzung: Wie du Token-gestützten Zugriff richtig einrichtest

- Tools und Techniken zur Analyse und Optimierung des Crawler-Zugriffs

- Best Practices für sichere, performante und SEO-freundliche Token-Strategien

- Häufige Fehler und wie du sie vermeidest

- Zukunftsausblick: Neue Entwicklungen im Token-basierten Zugriff

Was sind Tokens im Kontext von Crawling und Zugriffskontrolle?

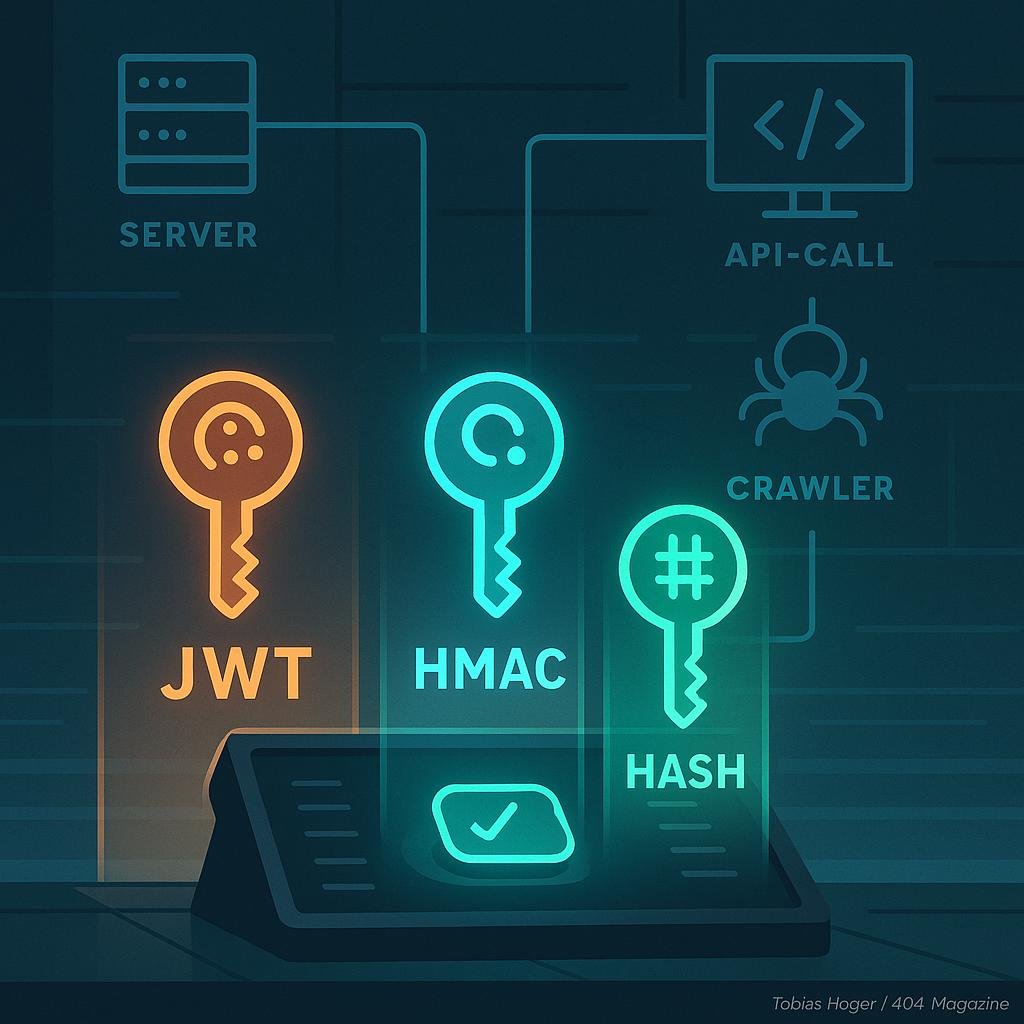

Tokens sind im Grunde genommen zufällig generierte Zeichenketten, die als digitale Schlüssel dienen, um den Zugriff auf bestimmte Ressourcen zu gewähren oder zu beschränken. Im Web-Umfeld werden sie häufig in Authentifizierungsprozessen, API-Calls oder auch bei der Steuerung, welche CrawlerCrawler: Die unsichtbaren Arbeiter der digitalen Welt Crawler – auch bekannt als Spider, Bot oder Robot – sind automatisierte Programme, die das Fundament des modernen Internets bilden. Sie durchforsten systematisch Webseiten, erfassen Inhalte, analysieren Strukturen und übermitteln diese Daten an Suchmaschinen, Plattformen oder andere zentrale Dienste. Ohne Crawler wäre Google blind, SEO irrelevant und das World Wide Web ein chaotischer... welche Bereiche deiner Website indexieren dürfen, eingesetzt. Technisch gesehen basieren Tokens auf kryptographischen Verfahren wie HMAC (Hash-based Message Authentication Code), JWT (JSON Web Tokens) oder simplen Session-Cookies, die eine Art digitaler Schlüsselbund darstellen.

Der Einsatz von Tokens im Crawling-Umfeld ist kein Zufall. Es geht darum, den Zugriff auf sensible oder unerwünschte Bereiche abzusichern, gleichzeitig aber selektiv und granular zu steuern, welche CrawlerCrawler: Die unsichtbaren Arbeiter der digitalen Welt Crawler – auch bekannt als Spider, Bot oder Robot – sind automatisierte Programme, die das Fundament des modernen Internets bilden. Sie durchforsten systematisch Webseiten, erfassen Inhalte, analysieren Strukturen und übermitteln diese Daten an Suchmaschinen, Plattformen oder andere zentrale Dienste. Ohne Crawler wäre Google blind, SEO irrelevant und das World Wide Web ein chaotischer... welche Inhalte sehen dürfen. Die Herausforderung besteht darin, diese Tokens so zu implementieren, dass sie sowohl sicher gegen Manipulationen sind als auch performante Crawling-Prozesse nicht behindern. Dabei kommt es auf die richtige Balance zwischen Sicherheit, Flexibilität und Performance an.

In der Praxis bedeutet das: Du kannst mit Tokens z. B. verhindern, dass Duplicate ContentDuplicate Content: Das SEO-Killer-Syndrom im Online-Marketing Duplicate Content, zu Deutsch „doppelter Inhalt“, ist einer der am meisten unterschätzten, aber folgenschwersten Fehler im SEO-Kosmos. Damit bezeichnet man identische oder sehr ähnliche Inhalte, die unter mehreren URLs im Internet auffindbar sind – entweder auf derselben Website (interner Duplicate Content) oder auf verschiedenen Domains (externer Duplicate Content). Google und andere Suchmaschinen mögen keine... durch unkontrolliertes Crawling entsteht, bestimmte Seiten nur für ausgewählte Bots freischalten oder den Zugriff auf technische Ressourcen nur autorisierten Crawlern erlauben. Wichtig dabei: Die Tokens dürfen niemals leicht zu erraten sein, sonst verlieren sie ihre Schutzfunktion. Gleichzeitig sollen sie die SEO-Arbeit nicht unnötig erschweren, weil Google oder andere CrawlerCrawler: Die unsichtbaren Arbeiter der digitalen Welt Crawler – auch bekannt als Spider, Bot oder Robot – sind automatisierte Programme, die das Fundament des modernen Internets bilden. Sie durchforsten systematisch Webseiten, erfassen Inhalte, analysieren Strukturen und übermitteln diese Daten an Suchmaschinen, Plattformen oder andere zentrale Dienste. Ohne Crawler wäre Google blind, SEO irrelevant und das World Wide Web ein chaotischer... keinen Zugriff mehr haben.

Warum Token-basierte Zugriffskontrolle im SEO-Umfeld eine Rolle spielt

Token-Control ist im SEO-Kontext ein zweischneidiges Schwert. Einerseits bietet sie die Möglichkeit, den Crawl-Budget effizient zu steuern, indem nur relevante Bereiche sichtbar sind. Andererseits kann sie, wenn falsch umgesetzt, auch zur SEO-Falle werden. Gerade bei großen, dynamischen Websites mit viel ContentContent: Das Herzstück jedes Online-Marketings Content ist der zentrale Begriff jeder digitalen Marketingstrategie – und das aus gutem Grund. Ob Text, Bild, Video, Audio oder interaktive Elemente: Unter Content versteht man sämtliche Inhalte, die online publiziert werden, um eine Zielgruppe zu informieren, zu unterhalten, zu überzeugen oder zu binden. Content ist weit mehr als bloßer Füllstoff zwischen Werbebannern; er ist... ist die richtige Steuerung entscheidend, um Crawling- und Indexierungs-Fehler zu vermeiden.

Wenn du Tokens so einsetzt, dass Suchmaschinen-Crawler keinen Zugriff auf wichtige Ressourcen bekommen, riskierst du, dass dein ContentContent: Das Herzstück jedes Online-Marketings Content ist der zentrale Begriff jeder digitalen Marketingstrategie – und das aus gutem Grund. Ob Text, Bild, Video, Audio oder interaktive Elemente: Unter Content versteht man sämtliche Inhalte, die online publiziert werden, um eine Zielgruppe zu informieren, zu unterhalten, zu überzeugen oder zu binden. Content ist weit mehr als bloßer Füllstoff zwischen Werbebannern; er ist... nicht richtig gerendert oder indexiert wird. Das führt zu Ranking-Verlusten, weil Google die Seiten nicht richtig versteht. Andererseits kannst du durch gezielten Einsatz von Tokens verhindern, dass unerwünschte Bots oder Scraper deine Seiten übermäßig belasten oder dein wertvolles Content-Asset stehlen.

Ein weiterer Punkt: Im Zeitalter der API-First-Architekturen und Headless-Content-Management-Systeme (CMSCMS (Content Management System): Das Betriebssystem für das Web CMS steht für Content Management System und ist das digitale Rückgrat moderner Websites, Blogs, Shops und Portale. Ein CMS ist eine Software, die es ermöglicht, Inhalte wie Texte, Bilder, Videos und Strukturelemente ohne Programmierkenntnisse zu erstellen, zu verwalten und zu veröffentlichen. Ob WordPress, TYPO3, Drupal oder ein Headless CMS – das...) sind Tokens integraler Bestandteil der Zugriffskontrolle. Hier steuert man, wer, wann und wie auf bestimmte Inhalte zugreifen darf – auch für die CrawlerCrawler: Die unsichtbaren Arbeiter der digitalen Welt Crawler – auch bekannt als Spider, Bot oder Robot – sind automatisierte Programme, die das Fundament des modernen Internets bilden. Sie durchforsten systematisch Webseiten, erfassen Inhalte, analysieren Strukturen und übermitteln diese Daten an Suchmaschinen, Plattformen oder andere zentrale Dienste. Ohne Crawler wäre Google blind, SEO irrelevant und das World Wide Web ein chaotischer.... Wer das nicht versteht, läuft Gefahr, wichtige Inhalte nicht optimal zu indexieren oder sogar ganz zu verlieren. Es ist ein Balanceakt zwischen Sicherheit, Performance und SichtbarkeitSichtbarkeit: Die unbarmherzige Währung des digitalen Marketings Wenn es im Online-Marketing eine einzige Währung gibt, die wirklich zählt, dann ist es Sichtbarkeit. Sichtbarkeit – im Fachjargon gern als „Visibility“ bezeichnet – bedeutet schlicht: Wie präsent ist eine Website, ein Unternehmen oder eine Marke im digitalen Raum, insbesondere in Suchmaschinen wie Google? Wer nicht sichtbar ist, existiert nicht. Punkt. In diesem....

Die wichtigsten Token-Varianten für Crawling-Strategien

Es gibt mehrere technische Ansätze, um Token-basierte Zugriffskontrolle umzusetzen, die sich im SEO-Kontext bewährt haben. Hier eine kurze Übersicht:

- JWT (JSON Web Tokens): Sehr beliebt bei API-gestütztem Zugriff. Sie sind kryptographisch signiert und enthalten Claims, also Informationen über den Nutzer oder den Zugriff. Für CrawlerCrawler: Die unsichtbaren Arbeiter der digitalen Welt Crawler – auch bekannt als Spider, Bot oder Robot – sind automatisierte Programme, die das Fundament des modernen Internets bilden. Sie durchforsten systematisch Webseiten, erfassen Inhalte, analysieren Strukturen und übermitteln diese Daten an Suchmaschinen, Plattformen oder andere zentrale Dienste. Ohne Crawler wäre Google blind, SEO irrelevant und das World Wide Web ein chaotischer... eignet sich vor allem die Nutzung, um temporäre, dynamisch generierte URLs zu steuern, z. B. für Content-Delivery- und Personalization-Strategien.

- Session-Cookies: Werden meist bei Nutzer-Authentifizierung eingesetzt, können aber auch für crawler-spezifische Sessions genutzt werden. Problematisch ist hier die Handhabung, weil CookiesCookies: Die Wahrheit über die kleinen Datenkrümel im Web Cookies sind kleine Textdateien, die Websites im Browser eines Nutzers speichern, um Informationen über dessen Aktivitäten, Präferenzen oder Identität zu speichern. Sie gehören zum technischen Rückgrat des modernen Internets – oft gelobt, oft verteufelt, meistens missverstanden. Ob personalisierte Werbung, bequeme Logins oder penetrante Cookie-Banner: Ohne Cookies läuft im Online-Marketing fast gar... browserabhängig sind und bei Crawlern oft nicht zuverlässig übertragen werden.

- Hash-basierte Tokens: Einfache, statische Schlüssel, die in URL-Parametern oder Headern übertragen werden. Sie sind leicht zu implementieren, aber auch anfällig für Reverse Engineering, wenn sie nicht gut geschützt sind.

- Pre-Shared Keys (PSK): Gemeinsame, festgelegte Schlüssel, die in Headern oder URLs übergeben werden. Sehr simpel, aber nur für statische Szenarien geeignet, weil sie leicht zu kopieren sind.

Wichtig bei allen Varianten: Die Tokens sollten regelmäßig erneuert werden, um Sicherheitsrisiken zu minimieren. Zudem ist eine klare Trennung zwischen öffentlich zugänglichen und geschützten Ressourcen unerlässlich, um nicht unbeabsichtigt wichtige Inhalte zu blockieren.

Risiken und Fallen bei der Steuerung von Crawlern mit Tokens

Token-basierte Zugriffskontrolle ist mächtig, aber auch gefährlich, wenn sie nicht richtig gehandhabt wird. Die größte Gefahr: Fehlkonfigurationen, die Google oder andere CrawlerCrawler: Die unsichtbaren Arbeiter der digitalen Welt Crawler – auch bekannt als Spider, Bot oder Robot – sind automatisierte Programme, die das Fundament des modernen Internets bilden. Sie durchforsten systematisch Webseiten, erfassen Inhalte, analysieren Strukturen und übermitteln diese Daten an Suchmaschinen, Plattformen oder andere zentrale Dienste. Ohne Crawler wäre Google blind, SEO irrelevant und das World Wide Web ein chaotischer... ausschließen oder den Zugriff auf wichtige Ressourcen blockieren. Das Ergebnis: Crawling-Fehler, Indexierungsprobleme oder sogar komplette Ausschlüsse von relevanten Inhaltsseiten.

Ein häufiges Szenario ist die versehentliche Blockade von CSS- oder JS-Dateien durch falschen Einsatz von Tokens. Das führt dazu, dass Google die Seite nicht richtig rendern kann und somit wichtige Inhalte nicht indexiert. Ebenso problematisch ist die Verwendung von Tokens, die leicht erraten werden können, was Angreifer ausnutzen könnten, um unautorisierten Zugriff zu erlangen oder die Website zu manipulieren.

Ein anderes Risiko: Die Performance leidet, weil bei jedem Request eine zusätzliche Token-Validierung notwendig ist. Wenn diese nicht optimal umgesetzt ist, erhöht sich die Serverlast und die Ladezeiten steigen – was sich negativ auf Core Web VitalsCore Web Vitals: Die Messlatte für echte Website-Performance Core Web Vitals sind Googles knallharte Antwort auf die Frage: „Wie schnell, stabil und nutzerfreundlich ist deine Website wirklich?“ Es handelt sich um eine Reihe von Metriken, die konkret messbar machen, wie Besucher die Ladezeit, Interaktivität und visuelle Stabilität einer Seite erleben. Damit sind die Core Web Vitals kein weiteres Buzzword, sondern... und Rankings auswirkt. Zudem können Inkonsistenzen bei der Token-Implementierung dazu führen, dass legitime CrawlerCrawler: Die unsichtbaren Arbeiter der digitalen Welt Crawler – auch bekannt als Spider, Bot oder Robot – sind automatisierte Programme, die das Fundament des modernen Internets bilden. Sie durchforsten systematisch Webseiten, erfassen Inhalte, analysieren Strukturen und übermitteln diese Daten an Suchmaschinen, Plattformen oder andere zentrale Dienste. Ohne Crawler wäre Google blind, SEO irrelevant und das World Wide Web ein chaotischer... ausgesperrt werden, was die SichtbarkeitSichtbarkeit: Die unbarmherzige Währung des digitalen Marketings Wenn es im Online-Marketing eine einzige Währung gibt, die wirklich zählt, dann ist es Sichtbarkeit. Sichtbarkeit – im Fachjargon gern als „Visibility“ bezeichnet – bedeutet schlicht: Wie präsent ist eine Website, ein Unternehmen oder eine Marke im digitalen Raum, insbesondere in Suchmaschinen wie Google? Wer nicht sichtbar ist, existiert nicht. Punkt. In diesem... massiv einschränkt.

Um diese Risiken zu vermeiden, ist eine klare, saubere Implementierung essenziell. Automatisierte Tests, Monitoring-Tools und regelmäßige Audits sind Pflicht. Fehlkonfigurationen müssen frühzeitig erkannt und korrigiert werden, um den technischen SEO-Status quo nicht zu gefährden.

Praktische Umsetzung: Wie du Token-gestützten Zugriff richtig einrichtest

Der Einstieg in die technische Umsetzung beginnt mit einer klaren Anforderungsanalyse: Was soll geschützt werden? Wer soll Zugriff haben? Wie lange soll der Token gültig sein? Diese Fragen bestimmen die technische Architektur. Hier die wichtigsten Schritte in der Praxis:

- Token-Generierung: Erstelle sichere, kryptographisch starke Tokens. Nutze Libraries wie JWT.io, OpenSSL oder eigene HMAC-Implementierungen. Stelle sicher, dass Tokens nur einmalig gültig sind oder eine kurze Lebensdauer haben.

- Token-Distribution: Übertrage die Tokens nur in sicheren Kanälen, z. B. via HTTPS-Header oder abhörsichere URL-Parameter. Vermeide URLs, die öffentlich zugänglich sind, ohne Schutzmechanismen.

- Server-seitige Validierung: Implementiere auf deinem Server eine robuste Validierung der Tokens. Prüfe Signatur, Ablaufdatum und Claims. Bei JWTs kannst du standardisierte Libraries nutzen, um die Validierung zu automatisieren.

- Zugriffssteuerung: Definiere, welche Ressourcen durch welche Tokens zugänglich sind. Nutze z. B. API-Gateways oder Reverse Proxies, um Zugriffsregeln zentral zu steuern.

- Fehlerbehandlung: Bei ungültigen oder abgelaufenen Tokens liefere klare HTTP-Statuscodes (z. B. 401 Unauthorized) und vermeide, sensible Informationen im Fehler-Response zu verraten.

- Monitoring & Logging: Überwache alle Token-Validierungen, protokolliere Zugriffe und Fehler. Nutze Log-Analyse-Tools, um ungewöhnliche Muster frühzeitig zu erkennen.

- Automatisierte Tests & Audits: Teste regelmäßig deine Token-Implementierung, insbesondere bei Änderungen an APIAPI – Schnittstellen, Macht und Missverständnisse im Web API steht für „Application Programming Interface“, zu Deutsch: Programmierschnittstelle. Eine API ist das unsichtbare Rückgrat moderner Softwareentwicklung und Online-Marketing-Technologien. Sie ermöglicht es verschiedenen Programmen, Systemen oder Diensten, miteinander zu kommunizieren – und zwar kontrolliert, standardisiert und (im Idealfall) sicher. APIs sind das, was das Web zusammenhält, auch wenn kein Nutzer je eine... oder Website-Struktur. Audit-Tools wie Burp Suite, OWASP ZAP oder eigene Scripts helfen, Sicherheitslücken zu schließen.

Wichtig: Die Integration sollte nahtlos sein. CrawlerCrawler: Die unsichtbaren Arbeiter der digitalen Welt Crawler – auch bekannt als Spider, Bot oder Robot – sind automatisierte Programme, die das Fundament des modernen Internets bilden. Sie durchforsten systematisch Webseiten, erfassen Inhalte, analysieren Strukturen und übermitteln diese Daten an Suchmaschinen, Plattformen oder andere zentrale Dienste. Ohne Crawler wäre Google blind, SEO irrelevant und das World Wide Web ein chaotischer... dürfen nur dann auf Ressourcen zugreifen, wenn es wirklich notwendig ist. Ansonsten riskierst du, dass Google oder andere SuchmaschinenSuchmaschinen: Das Rückgrat des Internets – Definition, Funktionsweise und Bedeutung Suchmaschinen sind die unsichtbaren Dirigenten des digitalen Zeitalters. Sie filtern, sortieren und präsentieren Milliarden von Informationen tagtäglich – und entscheiden damit, was im Internet gesehen wird und was gnadenlos im Daten-Nirwana verschwindet. Von Google bis Bing, von DuckDuckGo bis Yandex – Suchmaschinen sind weit mehr als simple Datenbanken. Sie sind... dein ContentContent: Das Herzstück jedes Online-Marketings Content ist der zentrale Begriff jeder digitalen Marketingstrategie – und das aus gutem Grund. Ob Text, Bild, Video, Audio oder interaktive Elemente: Unter Content versteht man sämtliche Inhalte, die online publiziert werden, um eine Zielgruppe zu informieren, zu unterhalten, zu überzeugen oder zu binden. Content ist weit mehr als bloßer Füllstoff zwischen Werbebannern; er ist... nicht richtig erfassen können.

Tools und Techniken zur Analyse und Optimierung des Crawler-Zugriffs

Die Kontrolle über den Crawler-Zugriff mittels Tokens ist nur der erste Schritt. Um sicherzugehen, dass alles reibungslos läuft, brauchst du geeignete Tools. Diese helfen, Fehler zu erkennen, die Performance zu messen und die Zugriffskontrolle zu optimieren:

- Google Search ConsoleGoogle Search Console: Dein Kontrollzentrum für SEO und Website-Performance Die Google Search Console (GSC) ist das offizielle, kostenlose Analyse- und Überwachungstool von Google für Website-Betreiber, SEOs und Online-Marketing-Profis. Sie liefert unverzichtbare Einblicke in Sichtbarkeit, technische Performance, Indexierung und Suchmaschinen-Rankings. Wer seine Website ernsthaft betreibt, kommt an der Google Search Console nicht vorbei – denn ohne Daten bist du im SEO...: Zeigt, ob Google Probleme beim Crawling hat. Prüfe dort Crawl-Fehler, blockierte Ressourcen und Indexierungsstatus.

- Screaming Frog SEOSEO (Search Engine Optimization): Das Schlachtfeld der digitalen Sichtbarkeit SEO, kurz für Search Engine Optimization oder Suchmaschinenoptimierung, ist der Schlüsselbegriff für alle, die online überhaupt gefunden werden wollen. Es bezeichnet sämtliche Maßnahmen, mit denen Websites und deren Inhalte so optimiert werden, dass sie in den unbezahlten, organischen Suchergebnissen von Google, Bing und Co. möglichst weit oben erscheinen. SEO ist längst... Spider: Ermöglicht die Analyse von internen Links, Statuscodes, Canonicals und Crawl-Fehlern. Mit Custom Extraction kannst du auch Tokens und Header-Infos prüfen.

- WebPageTest.org und Lighthouse: Messen Ladezeiten, Render-Blocking, Netzwerk-Performance und Core Web VitalsCore Web Vitals: Die Messlatte für echte Website-Performance Core Web Vitals sind Googles knallharte Antwort auf die Frage: „Wie schnell, stabil und nutzerfreundlich ist deine Website wirklich?“ Es handelt sich um eine Reihe von Metriken, die konkret messbar machen, wie Besucher die Ladezeit, Interaktivität und visuelle Stabilität einer Seite erleben. Damit sind die Core Web Vitals kein weiteres Buzzword, sondern.... Hervorragend, um die Auswirkungen von Token-Implementierungen auf die Performance zu verstehen.

- Server-Logs / Logfile-Analyse: Unverzichtbar, um das tatsächliche Crawling-Verhalten zu erkennen. Mit Tools wie ELK-Stack, Screaming Frog Log Analyzer oder Loggly kannst du herausfinden, welche URLs gecrawlt werden und wo es Probleme gibt.

- Security-Tools: Nutze Penetration-Testing-Tools wie OWASP ZAP, Burp Suite oder eigene Scripts, um Sicherheitslücken in der Token-Implementierung zu identifizieren.

Regelmäßige Checks, Monitoring und Performance-Analysen sind Pflicht, um eine stabile, sichere und SEO-freundliche Token-Strategie zu gewährleisten. Nur so kannst du den technischen Spielraum im Griff behalten und dein Crawling optimal steuern.

Best Practices für sichere, performante und SEO-freundliche Token-Strategien

Wer es richtig machen will, folgt einigen bewährten Prinzipien:

- Sicherheit geht vor: Nutze kryptographisch starke, kurze Tokens, die regelmäßig erneuert werden. Vermeide statische, leicht erratbare Schlüssel.

- Minimale Zugriffsrechte: Gewähre nur den Zugriff auf notwendige Ressourcen. Reduziere die Angriffsfläche.

- HTTPSHTTPS: Das Rückgrat der sicheren Datenübertragung im Web HTTPS steht für „Hypertext Transfer Protocol Secure“ und ist der Standard für die verschlüsselte Übertragung von Daten zwischen Browser und Webserver. Anders als das unsichere HTTP bietet HTTPS einen kryptografisch abgesicherten Kommunikationskanal. Ohne HTTPS bist du im Internet nackt – und das nicht mal im positiven Sinne. In Zeiten von Cybercrime, Datenschutz-Grundverordnung... als Standard: Übertrage alle Tokens nur verschlüsselt, um Abhörangriffe zu vermeiden.

- Performanz im Blick behalten: Implementiere die Token-Validierung effizient, nutze Caching und Edge-Computing, um Server-Load zu minimieren.

- Klare Trennung der Ressourcen: Unterscheide zwischen öffentlich, geschützt und vertraulich. Nutze unterschiedliche Tokens oder Zugriffsmechanismen.

- Regelmäßige Erneuerung und Rotation: Ändere Tokens regelmäßig, um Sicherheitsrisiken zu minimieren.

- Transparente Dokumentation: Dokumentiere deine Zugriffskonzepte, damit auch Team oder externe Auditoren den Überblick behalten.

Nur mit diesen Prinzipien kannst du eine robuste, effektive und sichere Token-Strategie entwickeln, die Crawl- und Indexierungsprozesse optimal steuert und gleichzeitig Sicherheitsrisiken minimiert.

Häufige Fehler und wie du sie vermeidest

Fehler bei der Implementierung oder Nutzung von Token-basierten Zugriffskontrollen sind häufig und teuer. Hier die Top-Fehler, die du unbedingt vermeiden solltest:

- Statische Tokens: Einfach zu erraten, kaum sicher. Nutze immer kryptographisch starke, kurze Tokens mit kurzer Gültigkeitsdauer.

- Falsche Platzierung: Tokens in URLs, die öffentlich sichtbar sind, oder unverschlüsselt im HTTP-Header. Immer nur über HTTPSHTTPS: Das Rückgrat der sicheren Datenübertragung im Web HTTPS steht für „Hypertext Transfer Protocol Secure“ und ist der Standard für die verschlüsselte Übertragung von Daten zwischen Browser und Webserver. Anders als das unsichere HTTP bietet HTTPS einen kryptografisch abgesicherten Kommunikationskanal. Ohne HTTPS bist du im Internet nackt – und das nicht mal im positiven Sinne. In Zeiten von Cybercrime, Datenschutz-Grundverordnung... und in geschützten Kanälen übertragen.

- Blockierung wichtiger Ressourcen: CSSCSS (Cascading Style Sheets): Die Sprache des Webdesigns entschlüsselt CSS steht für Cascading Style Sheets und ist die Sprache, mit der das Web schön gemacht wird. Ohne CSS wäre das Internet ein monochromes, typografisches Trauerspiel. CSS trennt die inhaltliche Struktur von HTML sauber von der Präsentation und sorgt für Layout, Farben, Schriftarten, Animationen und sogar komplexe Responsive Designs. Kurz gesagt:..., JS, Bilder oder API-Endpunkte versehentlich durch Token-Restrictions blockieren. Teste alle Ressourcen sorgfältig.

- Fehlende Überwachung: Keine Logs, keine Monitoring-Tools. Fehler und Angriffe bleiben unentdeckt – das ist fatal.

- Unzureichende Token-Validierung: Ignorieren der Signaturprüfung, Ablaufzeiten oder Claims. Das macht die Kontrolle nutzlos.

- Vergessen, Tokens zu erneuern: Dauerhafte, nicht rotierende Tokens sind eine Sicherheitslücke. Regelmäßige Rotation ist Pflicht.

Vermeide diese Fallen mit klaren Prozessen, automatisierten Tests und kontinuierlichem Monitoring. Nur so bleibst du im Spiel.

Zukunftsausblick: Neue Entwicklungen im Token-basierten Zugriff

Die Welt der Zugriffskontrolle entwickelt sich rasant weiter. Mit dem Aufstieg der Zero Trust-Architekturen wird das Prinzip, dass kein Zugriff ohne explizite Validierung gewährt wird, immer wichtiger. Neue Standards wie OAuth 2.0, OpenID Connect und entstehende Protokolle für serverlose Umgebungen setzen auf noch dynamischere, granularere und sicherere Token-Modelle.

Auch die Integration von Machine LearningMachine Learning: Algorithmische Revolution oder Buzzword-Bingo? Machine Learning (auf Deutsch: Maschinelles Lernen) ist der Teilbereich der künstlichen Intelligenz (KI), bei dem Algorithmen und Modelle entwickelt werden, die aus Daten selbstständig lernen und sich verbessern können – ohne dass sie explizit programmiert werden. Klingt nach Science-Fiction, ist aber längst Alltag: Von Spamfiltern über Gesichtserkennung bis zu Produktempfehlungen basiert mehr digitale Realität... in die Zugriffskontrolle wird zunehmen. KI-basierte Systeme können anomalisches Verhalten erkennen, Tokens automatisch erneuern oder widerrufen, und so die Sicherheit auf ein neues Level heben. Für SEO-Experten bedeutet das: Wer heute schon die Grundlagen beherrscht, ist bestens vorbereitet für die kommenden Herausforderungen – und kann die Kontrolle über CrawlerCrawler: Die unsichtbaren Arbeiter der digitalen Welt Crawler – auch bekannt als Spider, Bot oder Robot – sind automatisierte Programme, die das Fundament des modernen Internets bilden. Sie durchforsten systematisch Webseiten, erfassen Inhalte, analysieren Strukturen und übermitteln diese Daten an Suchmaschinen, Plattformen oder andere zentrale Dienste. Ohne Crawler wäre Google blind, SEO irrelevant und das World Wide Web ein chaotischer... und Inhalte dauerhaft sichern.

In der Praxis wird man künftig noch stärker auf adaptive, kontextabhängige Zugriffssysteme setzen, die sich automatisch an Veränderungen anpassen. Das bedeutet weniger manuelle Konfiguration, mehr Sicherheit und bessere Performance – vorausgesetzt, du kennst dich mit den technischen Feinheiten aus. Wer das nicht schafft, läuft Gefahr, den Anschluss zu verpassen und in der digitalen Bedeutungslosigkeit zu versinken.

Fazit: Kontrolle ist der Schlüssel – auch bei Crawler Zugriff über Tokens

Wer im digitalen Zeitalter erfolgreich sein will, darf den technischen Zugriff auf seine Website nicht dem Zufall überlassen. Token-basierte Zugriffskontrolle ist das Werkzeug, um den Crawler-Zugriff granular, sicher und performant zu steuern. Doch nur wer die technischen Details versteht, richtig implementiert und kontinuierlich überwacht, kann die volle Kontrolle behalten.

Das Zusammenspiel aus Sicherheit, Performance und SichtbarkeitSichtbarkeit: Die unbarmherzige Währung des digitalen Marketings Wenn es im Online-Marketing eine einzige Währung gibt, die wirklich zählt, dann ist es Sichtbarkeit. Sichtbarkeit – im Fachjargon gern als „Visibility“ bezeichnet – bedeutet schlicht: Wie präsent ist eine Website, ein Unternehmen oder eine Marke im digitalen Raum, insbesondere in Suchmaschinen wie Google? Wer nicht sichtbar ist, existiert nicht. Punkt. In diesem... entscheidet darüber, ob deine Inhalte im Google-Index landen oder im digitalen Nirwana verschwinden. Mit den richtigen Strategien, Tools und einem tiefen technischen Verständnis kannst du den Crawl-Flow lenken, Risiken minimieren und langfristig Erfolg sichern. Die Zukunft gehört denen, die Kontrolle haben – und die Kontrolle beginnt bei der richtigen Token-Strategie.