Was versteht man unter KI wirklich? Klar erklärt!

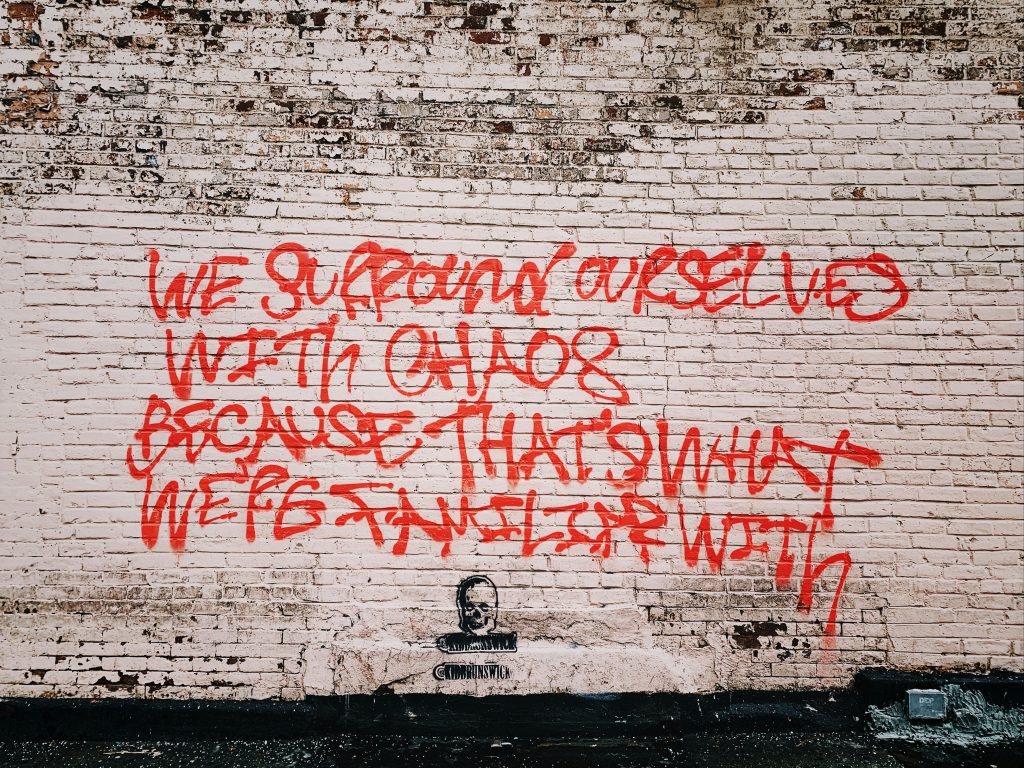

KI ist das Buzzword der Stunde – gefeiert, verdammt, um sich geworfen wie Konfetti auf einer Tech-Konferenz. Aber was steckt eigentlich hinter “Künstlicher Intelligenz”? Spoiler: Es ist weder Magie noch Science-Fiction – sondern knallharte Mathematik, Algorithmen und die Gnadenlosigkeit von Big Data. Wer heute noch glaubt, KI sei ein allwissender Roboter, hat den Anschluss längst verloren. Hier kommt die schonungslos ehrliche, technisch fundierte und garantiert hypefreie Definition von KI – und warum 99% aller Marketing-Versprechen schlichtweg Quatsch sind.

- Künstliche Intelligenz (KI): Was bedeutet der Begriff wirklich und warum wird er ständig missbraucht?

- Die wichtigsten Arten von KI: Von schwacher KI bis zu generativen Modellen

- Wie funktionieren KI-Systeme technisch? Algorithmen, maschinelles Lernen und neuronale Netze erklärt

- Machine Learning vs. Deep Learning: Wo ist der Unterschied und warum ist das relevant?

- Was können KI-Systeme heute wirklich – und was bleibt Science-Fiction?

- Risiken, Mythen und die größten Missverständnisse rund um KI im Marketing

- Praktische Einsatzmöglichkeiten: Wann lohnt sich KI und wo ist sie kompletter Overkill?

- Welche Technologien, Tools und Frameworks treiben den KI-Hype an?

- Ein realistischer Ausblick: Was erwartet uns in den nächsten Jahren wirklich?

- Fazit: KI – Chance, Gefahr oder einfach nur ein weiteres Werkzeug?

Künstliche Intelligenz, kurz KI, ist ein Begriff, der seit Jahren inflationär durch die Schlagzeilen geistert. Von allwissenden Chatbots bis hin zu mystischen Prognosemaschinen ist alles dabei. Doch was versteht man unter KI wirklich? Die nüchterne Wahrheit ist: KI beschreibt Systeme, die Aufgaben erledigen, für die menschliche Intelligenz benötigt wird – zumindest im Ansatz. Das reicht von simplen Entscheidungsbäumen bis zu komplexen, selbstlernenden neuronalen Netzen. Wer hinter KI aber eine Art digitales Gehirn vermutet, das denkt und fühlt, wie es Hollywood gern verkauft, hat zu viele Blockbuster gesehen und zu wenig Papers gelesen. Zeit, Licht ins Dunkel zu bringen – technisch, ehrlich, auf den Punkt.

Künstliche Intelligenz: Definition, Ursprung und warum der Begriff so oft falsch verstanden wird

Der Begriff “Künstliche Intelligenz” (KI) wurde 1956 auf der legendären Dartmouth Conference geprägt. Damals waren Computer so leistungsfähig wie ein Taschenrechner von 1993, aber die Vision war klar: Maschinen sollen Aufgaben übernehmen, die bislang menschlicher Intelligenz vorbehalten waren. Die Definition ist dabei bis heute schwammig geblieben – und genau das ist das Problem. KI ist kein exakt abgestecktes Feld, sondern ein Sammelbegriff für ganz verschiedene Technologien, Methoden und Ansätze.

Im Kern versteht man unter KI Systeme, die in der Lage sind, Daten zu analysieren, daraus Muster zu erkennen, Schlussfolgerungen zu ziehen und auf Basis dieser “Erkenntnisse” eigenständig zu handeln. Das klingt spektakulär, ist aber technisch meistens ziemlich banal: Ob ein Spamfilter, der aus Mails “lernt”, oder ein Chatbot, der aus vorgefertigten Antworten auswählt – beides fällt unter KI. Die Marketing-Abteilungen haben daraus ein Monster gemacht, das angeblich alles kann. Tatsache ist: Die meisten sogenannten KI-Lösungen sind nicht mehr als automatisierte Entscheidungsbäume, einfache Statistik oder bestenfalls Machine Learning-Modelle – von echter “Intelligenz” ist das meist so weit entfernt wie ein Taschenrechner vom Nobelpreis.

Die Unschärfe der Definition öffnet Missverständnissen Tür und Tor. Während Informatiker unter KI streng zwischen schwacher (narrow AI) und starker KI (artificial general intelligence) unterscheiden, werfen Marketing und Medien alles in einen Topf und würzen mit einer Prise Science-Fiction. Die Folge: Erwartungen, die nie erfüllt werden, und eine Skepsis, die der Technologie schadet. Wer von KI redet, sollte besser wissen, wovon er spricht – sonst landet er im Bullshit-Bingo der Tech-Branche.

Ein weiterer Grund für die Verwirrung sind die vielen Buzzwords, die im Fahrwasser der KI mitgeschleppt werden: Machine Learning, Deep Learning, neuronale Netze, Natural Language Processing, Generative AI – alles wird als KI verkauft, obwohl die Unterschiede gewaltig sind. Deshalb gilt: Wer Künstliche Intelligenz verstehen will, muss die einzelnen Technologien und ihre Grenzen kennen. Nur so trennt man Hype von Substanz.

Die wichtigsten Arten von KI: Schwache KI, starke KI und generative Modelle

Wer über KI spricht, muss die grundlegenden Kategorien kennen. Denn nicht jede KI ist gleich KI – und die Unterschiede sind technisch wie praktisch dramatisch. Im Zentrum steht die Unterscheidung zwischen sogenannter schwacher KI (narrow AI) und starker KI (artificial general intelligence, AGI). Die Realität: 100% aller heute eingesetzten KI-Systeme sind schwache KI. Starke KI ist und bleibt ein theoretisches Gedankenspiel – und wird es auf absehbare Zeit auch bleiben.

Schwache KI bezeichnet Systeme, die für eine ganz bestimmte Aufgabe optimiert sind: Bilderkennung, Spracherkennung, Textanalyse, Vorhersage von Nutzerverhalten. Das sind smarte Algorithmen, die ein eng abgegrenztes Problem lösen – aber nichts anderes können. Ein Schachcomputer schlägt dich im Schach, aber nicht beim Kartenspielen. Ein Sprachmodell wie GPT kann Texte generieren, ist aber im logischen Denken oft ein Totalausfall. Diese Spezialisierung ist der Grund, warum KI in der Praxis so erfolgreich ist – aber eben keine “echte” Intelligenz besitzt.

Starke KI wäre ein System, das flexibel denkt, lernt, Schlussfolgerungen zieht und sich in beliebige Aufgaben einarbeitet – so wie ein Mensch. Das klingt nett, ist aber selbst in den wildesten Forschungslabors Science-Fiction. Kein existierendes System ist auch nur annähernd in der Lage, diesen Grad an Generalität zu erreichen. Die meisten “KI-Ängste” basieren genau auf diesem Missverständnis: KI-Systeme sind hoch spezialisiert und weit davon entfernt, menschliche Intelligenz zu simulieren.

Eine Sonderstellung nehmen generative KI-Modelle (Generative AI) ein. Sie erzeugen neue Inhalte – Texte, Bilder, Musik – auf Basis riesiger Datenmengen und ausgeklügelter Algorithmen. Systeme wie GPT-4 oder Stable Diffusion sind Paradebeispiele. Sie wirken oft magisch, sind aber im Kern Mustererkenner und Statistikmaschinen, keine kreativen Künstler. Die Fähigkeit, scheinbar Neues zu schaffen, basiert auf Wahrscheinlichkeiten und Trainingsdaten – und nicht auf Kreativität oder Bewusstsein.

Wie funktionieren KI-Systeme technisch? Algorithmen, Machine Learning und neuronale Netze

Technisch betrachtet ist Künstliche Intelligenz ein Überbegriff für ganz verschiedene Methoden. Die wichtigsten Bausteine sind Algorithmen, Machine Learning (ML) und neuronale Netze (Artificial Neural Networks, ANN). Ohne diese Technologien bleibt jede KI ein leeres Versprechen.

Ein Algorithmus ist nichts anderes als eine klar definierte Handlungsanweisung – ein Rezept für die Maschine. In der KI kommt meistens ein ganzes Arsenal davon zum Einsatz: Entscheidungsbäume, Regressionsmodelle, Klassifikatoren, Clustering-Verfahren. Die Aufgabe: Muster in Daten erkennen, Wahrscheinlichkeiten berechnen und darauf basierend Entscheidungen treffen. Im Marketing-Sprech klingt das wie Hexerei, in der Praxis ist es knallharte Mathematik, Statistik und lineare Algebra.

Machine Learning geht einen Schritt weiter: Hier “lernt” das System aus Beispieldaten (Trainingsdaten), indem es Zusammenhänge erkennt und diese auf neue, unbekannte Daten anwendet. Das funktioniert über Trainingsphasen, in denen Modelle optimiert werden, bis sie bestimmte Fehlerwerte unterschreiten. Es gibt überwachte Lernverfahren (Supervised Learning), unüberwachtes Lernen (Unsupervised Learning) und halbüberwachtes Lernen (Semi-Supervised Learning). In der Praxis bedeutet das: Das Modell bekommt Datenpaare (Eingabe/Ausgabe), sucht nach Mustern und versucht, diese Muster zu verallgemeinern.

Neuronale Netze sind die technische Grundlage für Deep Learning. Sie bestehen aus künstlichen “Neuronen”, die in Schichten (Layer) organisiert sind. Die Eingabeschicht nimmt Daten auf, die versteckten Schichten (Hidden Layers) verarbeiten sie, und die Ausgabeschicht spuckt das Ergebnis aus. Tiefe neuronale Netze (Deep Neural Networks) mit vielen Layern ermöglichen es, extrem komplexe Muster zu erkennen – etwa in Bildern, Sprache oder Texten. Das Training solcher Netze ist rechenintensiv, benötigt riesige Datenmengen und spezialisierte Hardware (GPUs, TPUs).

Das Zusammenspiel dieser Technologien ist der Grund, warum KI heute so leistungsfähig erscheint: Algorithmen strukturieren die Aufgaben, Machine Learning optimiert die Modelle, neuronale Netze erkennen Muster, die für Menschen unsichtbar bleiben. Aber: Kein System “versteht” die Welt wie ein Mensch – es erkennt Korrelationen, keine Kausalitäten.

Machine Learning vs. Deep Learning: Der feine Unterschied und warum er entscheidend ist

Machine Learning (ML) und Deep Learning (DL) werden oft synonym verwendet – ein Fehler, der zu Missverständnissen führt. ML ist der Oberbegriff für alle Methoden, bei denen Maschinen aus Daten lernen. Dazu gehören einfache Algorithmen wie Entscheidungsbäume, Random Forests, Support Vector Machines oder K-Means-Clustering. Deep Learning ist eine spezielle Form des Machine Learning, bei der tiefe neuronale Netze eingesetzt werden – oft mit Dutzenden, Hunderten oder sogar Tausenden von Layern.

Der Unterschied ist mehr als akademisch: Während klassisches ML oft mit strukturierten Daten (Tabellen, Listen) arbeitet und vergleichsweise wenig Rechenleistung benötigt, ist Deep Learning auf unstrukturierte Daten (Bilder, Sprache, Videos) und immense Hardware angewiesen. Ohne massive GPU-Cluster, Big Data und ausgefeilte Trainingspipelines gibt es keine Deep-Learning-Wunder.

Im Marketingland werden beide Begriffe munter vermischt. Die Folge: Anbieter, die mit “Deep Learning” werben, liefern in Wahrheit simples Logistic Regression; Tools, die Machine Learning versprechen, machen im Hintergrund eine primitive Wenn-Dann-Abfrage. Wer als Entscheider nicht zwischen ML und DL unterscheiden kann, kauft am Ende das falsche Produkt – oder zahlt für KI, wo keine drinsteckt.

Relevanz hat der Unterschied auch bei der Skalierung: Klassisches ML ist oft erklärbarer, wartbarer und ressourcenschonender. Deep Learning ist leistungsfähiger, aber eine Blackbox und schwer zu kontrollieren. Wer auf KI setzt, sollte wissen, welche Technologie dahintersteckt – und warum sie (nicht) funktioniert.

Fazit: KI – Chance, Gefahr oder einfach nur ein weiteres Werkzeug?

Künstliche Intelligenz ist weder Heilsbringer noch Untergangsprophet. Sie ist eine Technologie – mächtig, wenn sie richtig eingesetzt wird, nutzlos oder sogar gefährlich, wenn sie missverstanden wird. Wer KI als Werkzeug betrachtet, das konkrete Probleme löst, wird profitieren. Wer auf Marketing-Versprechen hereinfällt, landet schnell im Tal der enttäuschten Erwartungen.

Die Zukunft der KI ist alles andere als vorhersehbar – aber eines ist sicher: Echte Intelligenz bleibt auf absehbare Zeit ein menschliches Privileg. KI ist Statistik, Mathematik, Algorithmik – nicht mehr, nicht weniger. Wer den Hype entlarvt und die Technologie versteht, verschafft sich einen echten Wettbewerbsvorteil. Für alle anderen gilt: KI ist kein Ersatz für Nachdenken. Aber ein verdammt gutes Werkzeug – wenn man weiß, wie es funktioniert.