Was war die erste KI? Geschichte und Meilensteine erklärt

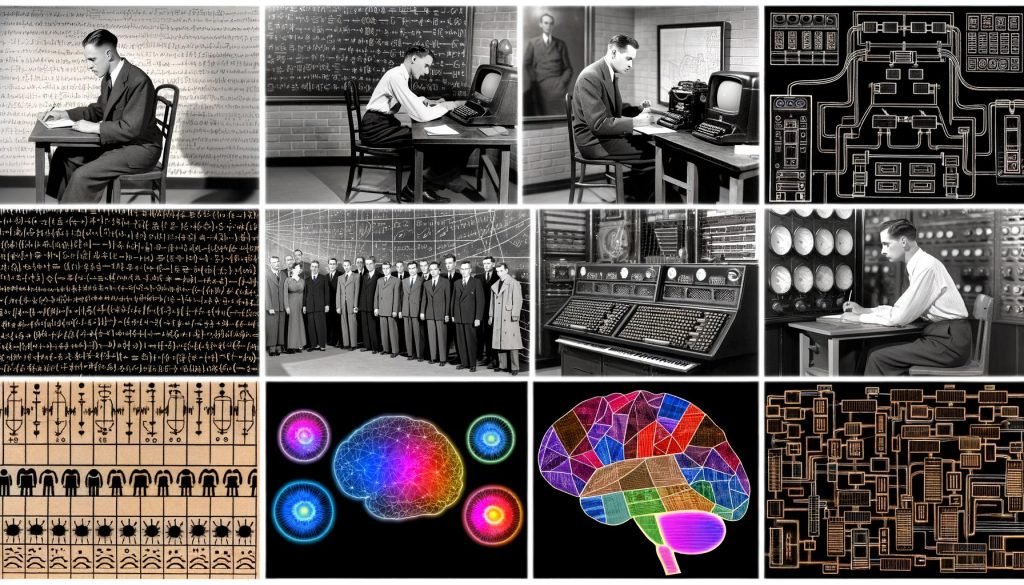

Du willst wissen, was die erste KI war, und hoffst auf eine hübsche Jahreszahl, ein hübsches Laborfoto und einen hübschen Forscher in Kittel? Schön wär’s. Die Wahrheit ist deutlich unordentlicher, technischer und ehrlicher: “erste KI” hängt von deiner Definition ab, von deinen Kriterien und von deinem Mut, Marketing-Märchen von realer Rechenhistorie zu trennen. In diesem Artikel zerlegen wir die Frage “Was war die erste KI?” systematisch, rekonstruieren die Technikgeschichte ohne Nostalgie-Filter und liefern dir belegbare Meilensteine. Keine Mythen, kein Hype, nur harte Bits, kühle Logik und die Erkenntnis, dass die “erste KI” eher eine Linie ist als ein Punkt. Und ja, du wirst nachher klüger und leicht ernüchtert sein.

- “Erste KI” ist kein einzelner Moment, sondern ein Set aus Definition, Kriterien und Kontext.

- Frühe Grundlagen: Turing, McCulloch-Pitts, Hebb und die formale Logik legten das Fundament.

- Kandidaten: SNARC, Logic Theorist, Samuel’s Checkers, ELIZA und SHRDLU – alle “KI”, aber mit unterschiedlichen Ansprüchen.

- Symbolische KI (GOFAI) vs. Connectionism: zwei Denkschulen, die die erste KI je anders definieren würden.

- KI-Winter waren keine Pausen, sondern harte Refaktorings der gesamten Disziplin.

- Deep Learning, GPUs und Daten machten ab 2012 aus Fragmente wieder ein System.

- Transformer, LLMs, Diffusionsmodelle und RAG: aktuelle Architekturtrends ohne Mythenbeilage.

- Für die Praxis: Wie du historische Lektionen in heutige KI-Stacks, SEO und Content-Workflows übersetzt.

Was war die erste KI? Definition, Kriterien und die nervige Wahrheit

Die Frage “Was war die erste KI?” klingt simpel und ist ein Minenfeld aus Definitionen. Wer “erste KI” sagt, muss zuerst klären, was “Intelligenz” in Maschinen überhaupt meint. Geht es um Symbolmanipulation, also formale Logik, oder um Lernen aus Daten, also statistische Generalisierung. Willst du eine Maschine, die nach festen Regeln plant, oder eine, die unter Unsicherheit handeln kann und Feedback nutzt. Die erste KI lässt sich je nach Kriterium anders identifizieren, und genau da scheitern die meisten Shortcuts. Ohne Kriterien bleibt “erste KI” Kaffeesatzlesen, mit Kriterien wird es eine belastbare Tech-Historie.

Für eine seriöse Antwort brauchst du vier harte Prüfsteine. Erstens: Repräsentation, also wie Wissen intern codiert wird, etwa als Logiksätze, Graphen, Gewichte in Netzen oder Vektoren. Zweitens: Inferenz, also welche Verfahren über diese Repräsentation schlussfolgern, zum Beispiel Resolution, A*-Suche, Backpropagation oder Bayes’sche Aktualisierung. Drittens: Lernen, also ob das System sein Verhalten datengetrieben anpasst, zum Beispiel mit Verstärkungslernen oder Gradientenabstieg. Viertens: Zielgerichtetes Verhalten, also ob das System in einer Umgebung Aufgaben löst, statt nur zu simulieren. Legst du diese Kriterien an, wird “erste KI” plötzlich unterscheidbar von “erstem Programm mit cleverer Idee”.

Jetzt kommt die unangenehme Konsequenz: Die erste KI könnte je nach Gewichtung entweder ein symbolisches System der 1950er sein, ein neuroinspiriertes Gerät der frühen 1950er oder ein Lernsystem um 1955 bis 1959. Wer “erste KI” als erstes System mit expliziter Wissensrepräsentation und Problemlösung definiert, landet meist beim Logic Theorist von Newell und Simon. Wer “erste KI” als erstes lernendes, neuroartiges Artefakt versteht, zeigt auf SNARC von Minsky oder frühe Perzeptron-Prototypen von Rosenblatt. Und wer “erste KI” als erstes Programm mit adaptiver Leistung in einem Spiel nimmt, verweist auf Arthur Samuels Dame-Programm. So wird klar: Die Frage “Was war die erste KI?” hat mehrere korrekte Antworten, wenn man die Kriterien transparent macht.

- Schritt 1: Definiere “Intelligenz” maschinell: Regeln, Lernen, Planung, Unsicherheit oder Kombination.

- Schritt 2: Lege die Repräsentationsform fest: Symbole, neuronale Gewichte, Wahrscheinlichkeiten, Vektoren.

- Schritt 3: Wähle die Hauptdisziplin: Problemlösen, Sprachverstehen, Spielen, Wahrnehmung oder Steuerung.

- Schritt 4: Entscheide, ob Lernen Pflicht ist oder ob auch “nur” Schlussfolgern zählt.

- Schritt 5: Prüfe Kandidaten gegen diese Matrix und akzeptiere mehr als eine plausible “erste KI”.

Die ersten Vorläufer: Turing, Automaten, McCulloch-Pitts und Hebb

Bevor irgendein Labor “erste KI” rufen durfte, brauchte es zwei Dinge: Rechenmodelle und Lernhypothesen. Alan Turing lieferte mit der Turing-Maschine das abstrakte Modell für berechenbare Prozesse und mit dem Imitation Game einen frühen Test für maschinelle Sprachkompetenz. Wichtig ist, dass Turing noch keine konkrete KI gebaut hat, aber den Raum der Möglichkeiten abgesteckt hat. Parallel entstanden endliche Automaten, Entscheidungsprobleme und Suchverfahren, die später in Planern und Heuristiken mündeten. Ohne diese theoretische Unterfütterung wären spätere Systeme nur Bastelprojekte geblieben. Theorie macht aus Ad-hoc-Logik eine Disziplin.

1943 formulierten McCulloch und Pitts ein formales Neuronmodell, das mit logischen Gattern Ähnlichkeiten zeigte. Dieses Modell war simpel und doch folgenreich, weil es Rechenlogik und Biologie in einer abstrakten Maschine verknüpfte. Hebb setzte 1949 mit seinem Lernpostulat nach: “Cells that fire together, wire together.” Damit gab es eine Hypothese, wie Synapsengewichte aus Erfahrung entstehen könnten. Zwar war damals weder Daten noch Hardware reichlich vorhanden, aber der methodische Keim war gelegt. Zwischen Logik und Lernen entstand eine produktive Spannung. Genau diese Spannung prägt bis heute die Debatten um “erste KI”.

In den frühen 1950ern tauchten die ersten physischen Apparate auf, die man mit gutem Grund KI-nah nennen kann. Wichtig ist SNARC, ein stochastisches neuronales Netzwerk von Marvin Minsky und Dean Edmonds, das 1951 mit 3.000 Vakuumröhren modellhafte Lernprozesse demonstrierte. Ebenfalls relevant sind frühe Spielprogramme wie Turing’s Turochamp und Prinz’ Schachprogramm für den Ferranti Mark I. Diese Systeme verbanden Suche, Heuristiken und rudimentäre Evaluation. Plattformen wie die Manchester- und die IBM-Maschinen verwandelten Theorien in laufende Software. Auf dieser Startbahn hob die spätere “erste KI” tatsächlich ab.

Kandidaten für die erste KI: SNARC, Logic Theorist, Samuel, ELIZA und SHRDLU

Wenn du “erste KI” als erstes funktionierendes System mit expliziter Problemlösekompetenz definierst, ist der Logic Theorist ein starker Kandidat. Newell, Shaw und Simon bewiesen 1956 Theoreme aus Whiteheads und Russells Principia Mathematica, und das nicht durch brute force, sondern mittels Heuristics and Means-Ends Analysis. Das Programm besaß eine Wissensrepräsentation, führte Inferenzschritte aus und hatte ein klares Ziel. Es kombinierte Suche, Heuristiken und symbolische Regeln, also genau das, was GOFAI später groß machte. Dass die Dartmouth Conference im selben Jahr den Begriff Artificial Intelligence prägte, zementierte die symbolische Deutung. Wer “erste KI” primär als Denken in Symbolen versteht, landet hier.

Nimmst du stattdessen Lernen als konstituierendes Merkmal, rückt Arthur Samuels Dame-Programm nach vorn. Ab 1952 begann Samuel, Bewertungsfunktionen über selbst gespielte Partien zu optimieren und nutzte damit eine frühe Form von Reinforcement Learning und parametrischem Tuning. Das System verbesserte sich messbar, schlug bald solide menschliche Gegner und demonstrierte Datengetriebenheit. Es war nicht nur eine Suchmaschine mit Heuristik, sondern ein System, das seine Heuristik aus Erfahrung anpasste. Genau diese Lernschleife hebt es über viele Zeitgenossen. In dieser Logik ist Samuels Checkers eine plausible “erste KI”.

Und dann sind da SNARC und ELIZA, zwei Systeme, die wegen ihres kulturellen Echos oft falsch eingeordnet werden. SNARC war 1951 ein hardwarebasierter, stochastisch verstärkender Vorläufer neuronaler Lernmaschinen, also ein “erste KI”-Kandidat für die Verbindung aus Physik, Rauschen und Anpassung. ELIZA von Weizenbaum (1966) wurde populär, weil es Gesprächssimulationen lieferte, aber es lernte nicht und repräsentierte nichts über die Welt, außer Pattern-Matching-Regeln. Spannender als ELIZA ist SHRDLU (1970), das in einer Blocks-Welt natürliche Sprache mit Planung, Semantik und Weltmodell verknüpfte. Je nachdem, ob du Dialog, Lernen oder Problemlösen gewichtet, verschieben sich die Kandidaten. Genau darum ist “erste KI” eine definitorische, nicht nur historische Entscheidung.

Meilensteine, KI-Winter und Comebacks: Perceptron, Expertensysteme, Backprop und Bayes

Rosenblatts Perzeptron (ab 1957) brachte Lernbarkeit in die Hardware, aber Minsky und Papert zeigten 1969 Grenzen einzelner Schichten. Diese Kritik war kein Todesstoß, sondern eine Einladung zu mehr Tiefe, fehlte nur die Rechenpower und die Differenzierbarkeit. In der Zwischenzeit blühte die symbolische KI auf: Planer, semantische Netze, Frames und Suchverfahren dominierten. DENDRAL und MYCIN zeigten, dass Expertensysteme in schmalen Domänen echten Mehrwert liefern. Doch Wissensakquise und Wartung waren Hölle, und brittle Systems brachen in offenen Situationen. Das Ergebnis: erste Frustrationen, abkühlende Erwartungen, echter Realitätscheck.

Der erste KI-Winter war weniger Winter als technische Schuld, die fällig wurde. Regelwerke skalierten schlecht, Unschärfe und Unsicherheit wurden ignoriert, und Hardware bremste Lernverfahren aus. Parallel machte die Statistik still Fortschritte: Bayes-Netze, versteckte Markow-Modelle und frühe probabilistische Graphen legten ein Fundament für Unsicherheitsinferenz. In den 1980ern tauchte Backpropagation erneut auf, diesmal sauber hergeleitet, unterstützt durch Differenzierbarkeit und Vektorrechnen. Plötzlich war Multilayer-Lernen wieder auf dem Tisch. Connectionism begann, GOFAI ernsthaft herauszufordern.

Die 1990er lieferten zwei Botschaften: Spezialisierung schlägt Generalisierung im Wettbewerb, und Daten plus Rechenleistung sind eine Währung. IBMs Deep Blue gewann 1997 Schach durch massive Suche, Bewertungsfunktionen und Spezialhardware, nicht durch “Denken”. Zur gleichen Zeit etablierten sich SVMs, Boosting und probabilistische Modelle in der Praxis. Reinforcement Learning bekam mit Temporal-Difference-Lernen und Q-Learning seine formale Schärfe. Vision blieb schwierig, Sprache blieb brüchig, und Semantik blieb zäh. Doch die Pipeline aus Daten, Features und Modellen wurde industriell. Der nächste Schub wartete nur auf drei Zutaten: Daten, GPUs und gute Initialisierung.

Von Deep Learning zu Generativer KI: ImageNet, Transformer, LLMs und Diffusion

2012 zündete mit AlexNet der ImageNet-Moment: CNNs plus GPUs plus ReLUs skalierten plötzlich, und Fehlerquoten fielen radikal. End-to-End-Lernen verdrängte Feature-Engineering, und die Skalengesetze wurden zur Strategie. In Sprache eroberte das Seq2Seq-Paradigma die Übersetzung, aber LSTMs stießen hardwareseitig an Grenzen. 2017 erschien der Transformer: Attention statt Rekurrenz, paralleles Training, Kontextfenster statt Gedächtnisfessel. Der Rest ist bekannter Fortschritt. BERT machte Verständnis, GPT machte Generierung, und beide machten Parameter zur neuen Machtmetrik.

Mit GPT-3 wurde Few-Shot-Lernen massentauglich, mit RLHF bekamen Modelle ein brauchbares Interface, und mit Instruct-Tuning wurden sie endlich nützlich. Foundation Models lösten Aufgaben durch Skalierung, nicht durch händische Regeln, und brachten das alte Ziel der Generalität in greifbare Nähe. Diffusionsmodelle zerlegten das Bildgenerieren in Rauschentfernung und zeigten, dass Likelihood-Training plus Guidance zu verblüffender Qualität führt. Multimodale Architekturen verbanden Text, Bild, Audio und bald Video in einem gemeinsamen Vektorraum. Damit wurde KI nicht nur klüger, sondern manipulierbarer, integrierbarer und operationalisierbarer. Die Pipeline wanderte von Forschung in Produktion.

Heute reden wir über Vektorindizes, Embeddings, RAG, Toolformer, Agenten und langes Kontextfenster. Die Tech-Stacks sind klarer: Tokenizer, Transformer-Backbone, Adapter oder LoRA, RLHF oder DPO, Guardrails, Observability. Hardware wurde zum Engpass und zum Enabler zugleich: GPUs, TPUs, Speicherbandbreite, KV-Cache und Quantisierung bestimmen die Kostenkurve. Inference-Optimierung ist kein Nice-to-have, sondern betriebswirtschaftlich zwingend. Und die “erste KI”-Frage wirkt plötzlich weniger fern, weil aktuelle Systeme endlich viele der vier Kriterien gleichzeitig erfüllen. Lernen, Planen, Repräsentieren und Handeln wachsen zusammen.

Was lernen wir daraus? Praxis-Impact, RAG, Vektordatenbanken und die nächsten Schritte

Die Geschichte der “ersten KI” lehrt Demut, Methodik und Systemdenken. Demut, weil jedes Paradigma Grenzen hat und kein Hype ewig trägt. Methodik, weil klare Kriterien bessere Antworten liefern als laute Claims. Systemdenken, weil Repräsentation, Inferenz, Lernen und Zielsetzung zusammenhängen. Für die Praxis heißt das: Baue KI-Stacks, die modular, messbar und ersetzbar sind. Verheirate LLMs mit Wissensspeichern, nicht mit Bauchgefühl. Und akzeptiere, dass Datenqualität mehr zählt als Lieblingsmodelle.

Operativ ist Retrieval-Augmented Generation derzeit die nützlichste Brücke zwischen generativer Power und unternehmensspezifischem Wissen. Du brauchst robuste Embeddings, einen Vektorstore, sinnvolle Chunking-Strategien, Query-Rewriting und Re-Ranking. Guardrails schützen vor Halluzinationen, und Evaluationsmetriken wie Faithfulness, Groundedness und Answer Relevancy ersetzen Demo-Magie durch Evidenz. Tool-Use erweitert Modelle um Aktionen, nicht nur Antworten, und macht aus Chatbots produktive Agenten. Logging, Tracing und Prompt-Repositories sind Pflicht, nicht Kür. Nur so wird KI wiederholbar statt zufällig.

Strategisch ist das alte D-A-C-Trilemma entscheidend: Data, Algorithms, Compute. Wer zwei davon optimiert und das dritte ignoriert, verliert. Sicherheitsmethoden wie RLHF, RLAIF, Red-Teaming und Content-Filter sind nicht Dekoration, sondern Betriebserlaubnis. Rechtliche und ethische Leitplanken machen Systeme stabil, nicht langsam. Und neurosymbolische Ansätze erinnern daran, dass die Ehe aus Logik und Lernen mehr kann als die Einzelteile. Wer das verstanden hat, stellt keine naive Frage nach “der” ersten KI mehr, sondern baut die nächste nützliche.

Zusammengefasst: Was war die erste KI? Sinnvollerweise eine von drei Antworten, abhängig von deinen Kriterien. Willst du symbolische Problemlösung, nimm Logic Theorist. Willst du frühes Lernen in Aktion, nimm Samuels Dame-Programm. Willst du neuroinspiriertes, stochastisches Lernen in Hardware, nimm SNARC. Alle drei sind technisch vertretbar. Und alle drei wirken bis heute fort: in Suchstrategien, in Reinforcement Learning, in neuronalen Architekturen. Die Gegenwart ist ein Aggregat ihrer Ideen.

Für Marketing und SEO bedeutet das: Vertraue nicht auf wohlklingende Erzählungen, vertraue auf Architekturen, Messwerte und Integration. KI ist kein Feature, sondern ein System aus Repräsentation, Inferenz, Lernen und Zielen. RAG schlägt Gelaber, Evals schlagen Bauchgefühl, und Infrastruktur schlägt schöne Slides. Wer heute KI sauber betreibt, schreibt nicht den nächsten Hype-Artikel, sondern den nächsten stabilen Release. Genau das ist der Unterschied zwischen Buzz und Business. Und genau darum lohnt sich die harte, historische Wahrheit.