Funktionsweise KI: Wie intelligente Systeme wirklich denken

Wenn du denkst, KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... sei nur ein Haufen Code, der irgendwelche Muster erkennt, dann hast du die Komplexität des maschinellen Lernens noch nicht verstanden. Diese Systeme „denken“ nicht wie Menschen, sie kalkulieren, optimieren und simulieren auf eine Art und Weise, die so elegant ist, dass es fast schon unheimlich wirkt – aber im Kern ist es nur Mathematik auf Steroiden. Hier kommt die Wahrheit: Künstliche Intelligenz ist kein Zauber, sondern ein hochkomplexer, technischer Tanz aus Daten, Algorithmen und neuronalen Netzen, die auf eine Weise zusammenarbeiten, die du so noch nie gesehen hast. Und ja, das bedeutet: Es ist tief, es ist technisch, und es ist verdammt spannend.

- Grundlagen der KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie...: Was bedeutet „denken“ bei intelligenten Systemen wirklich?

- Neurale Netze und Deep Learning: Wie Maschinen lernen, komplexe Muster zu erkennen

- Der Unterschied zwischen schwacher und starker KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... – und warum das relevant ist

- Wie KI-Modelle trainiert werden: Daten, Labels und die Bedeutung von Qualität

- Algorithmische Optimierung: Von Gradientenabstieg bis Backpropagation

- KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... in der Praxis: Anwendungen, die dein Business revolutionieren können

- Grenzen der KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie...: Was sie nicht kann – und warum sie niemals alles ersetzen wird

- Technische Infrastruktur für KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie...: Hardware, Frameworks und Datenmanagement

- Ethik, Bias und Verantwortung: Warum KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... kein Freifahrtschein für Dummheit ist

- Der Blick nach vorn: Trends, Herausforderungen und die Zukunft der KI-Technologien

Was bedeutet „denken“ bei KI wirklich – und warum ist das eine große Lüge?

Wer heute über Künstliche Intelligenz spricht, tut so, als ob Systeme wie ChatGPT oder DeepMind eine Art Bewusstsein oder echtes Verständnis hätten. Das ist nicht nur falsch, sondern auch gefährlich, weil es die technische Realität verzerrt. KI-Systeme sind hochspezialisierte Rechenmaschinen, die auf neuronalen Netzen basieren – Strukturen, die dem menschlichen Gehirn nachempfunden sind, aber in Wirklichkeit nur sehr komplexe mathematische Modelle sind. Sie „denken“ nicht, im klassischen Sinne. Sie führen Mustererkennung durch, optimieren anhand von Feedback-Schleifen und generieren Wahrscheinlichkeiten, die sie für die wahrscheinlichsten Ausgaben halten.

Ein neuronales Netz ist im Grunde eine Reihe von mathematischen Funktionen, die auf Eingabedaten angewendet werden, um eine Ausgabe zu erzeugen. Dabei lernt es durch eine iterative Anpassung der Gewichtungen in den Verbindungen zwischen den Neuronen. Das ist kein echtes Nachdenken, sondern eine statistische Optimierung. Es ist vergleichbar mit einem sehr klugen Raten, basierend auf vorher gelernten Mustern. Kein Bewusstsein, kein Verstehen, keine intrinsische Motivation – nur pure Datenverarbeitung auf einem Niveau, das so beeindruckend ist, dass es den Anschein erweckt, die Maschine würde denken.

Hier liegt die große Falle: Viele denken, KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... habe eine Art Eigenleben. Die Wahrheit ist, dass sie nur auf die Daten reagiert, die sie bekommt. Und genau hier wird es technisch spannend: Die Qualität der Daten bestimmt die Qualität der Ergebnisse. Schlechte Daten führen zu schlechten Ergebnissen. Es ist, als würde man einem blinden Passagier vertrauen, der nur eine begrenzte Sicht hat. Das Ergebnis: Verzerrungen, Fehlinformationen und im schlimmsten Fall katastrophale Fehlentscheidungen.

Neuronale Netze, Deep Learning und die Magie der Mustererkennung

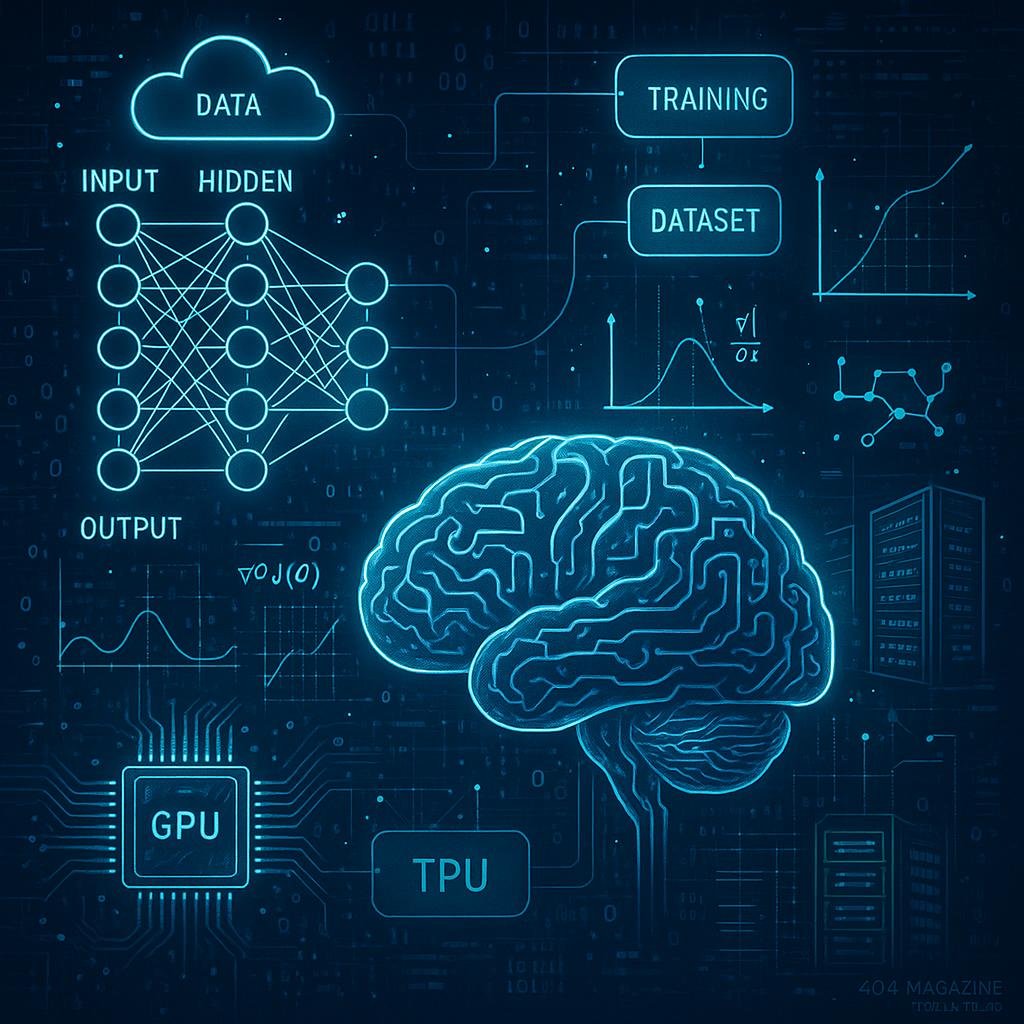

Neurale Netze sind das Herzstück moderner KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie.... Sie bestehen aus Schichten (Layers), die Eingabedaten durch eine Reihe von mathematischen Transformationen schicken, wobei jede Schicht die Daten auf eine immer abstraktere Ebene hebt. Das Ziel: Muster, Korrelationen und Zusammenhänge zu erkennen, die für Menschen meist unsichtbar bleiben. Deep Learning beschreibt den Einsatz sehr tiefer (deep) neuronaler Netze, die mehrere Schichten besitzen und dadurch komplexe Aufgaben bewältigen können – von Bild- und Spracherkennung bis hin zu Spielstrategien.

Der Lernprozess basiert auf Backpropagation: einem AlgorithmusAlgorithmus: Das unsichtbare Rückgrat der digitalen Welt Algorithmus – das Wort klingt nach Science-Fiction, ist aber längst Alltag. Ohne Algorithmen läuft heute nichts mehr: Sie steuern Suchmaschinen, Social Media, Navigation, Börsenhandel, Werbung, Maschinen und sogar das, was du in deinem Lieblingsshop zu sehen bekommst. Doch was ist ein Algorithmus eigentlich, wie funktioniert er und warum ist er das ultimative Werkzeug..., der die Fehler in der Ausgabe misst, diese Fehler rückwärts durch das Netzwerk propagiert und dann die Gewichte so anpasst, dass der Fehler in zukünftigen Durchläufen minimiert wird. Dieser Vorgang ist extrem rechenintensiv, erfordert massive Datenmengen und eine entsprechende Hardware-Infrastruktur – vorzugsweise GPU-Cluster oder TPUs. Ohne diese technische Basis ist modernes Deep Learning kaum machbar.

Ein weiterer wichtiger Punkt: Die Optimierung der Hyperparameter – Lernrate, Batch-Größe, Schichtanzahl und Aktivierungsfunktionen – entscheidet maßgeblich über die Leistungsfähigkeit des Modells. Hier wird die Kunst zum Wissenschaftlichen: Nur wer diese Parameter kennt und feinjustiert, erhält robuste Modelle, die in der Praxis funktionieren. Und ja, das ist kein Hobby, sondern Technik auf dem Level eines echten Hightech-Engineerings.

Der Unterschied zwischen schwacher und starker KI – und warum das relevant ist

In der Welt der Künstlichen Intelligenz spricht man gerne von schwacher KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... (Narrow AI) und starker KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... (Artificial General Intelligence, AGI). Die schwache KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... ist das, was wir heute vor allem kennen: Sprachmodelle, Bildklassifikatoren, Empfehlungssysteme. Sie sind hochspezialisiert, erledigen einzelne Aufgaben extrem gut, aber haben kein echtes Verständnis. Starke KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... hingegen würde bedeuten, eine Maschine, die in der Lage ist, auf einem menschlichen Niveau zu denken, zu lernen und sich in völlig neuen Kontexten zurechtzufinden.

Bis dato existiert keine echte AGI. Das bedeutet, alle aktuellen Systeme sind auf eng umrissene Aufgaben beschränkt. Das ist ein entscheidender Punkt, weil es die Grenzen der heutigen Technik aufzeigt. Es ist zwar beeindruckend, wenn ein AlgorithmusAlgorithmus: Das unsichtbare Rückgrat der digitalen Welt Algorithmus – das Wort klingt nach Science-Fiction, ist aber längst Alltag. Ohne Algorithmen läuft heute nichts mehr: Sie steuern Suchmaschinen, Social Media, Navigation, Börsenhandel, Werbung, Maschinen und sogar das, was du in deinem Lieblingsshop zu sehen bekommst. Doch was ist ein Algorithmus eigentlich, wie funktioniert er und warum ist er das ultimative Werkzeug... Schach gewinnt oder medizinische Bilder erkennt, aber er versteht nicht, was er tut. Er folgt nur den mathematischen Regeln, die ihm einprogrammiert wurden, oder die er selbst gelernt hat.

Für die Anwendung in der Wirtschaft bedeutet das: KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... ist ein mächtiges Tool, aber kein Ersatz für menschliche Kreativität, Urteilsvermögen oder ethische Verantwortung. Das sollte man niemals vergessen, wenn man die Technik in der Praxis einsetzt.

Training, Daten und die Kunst des maschinellen Lernens

Der Kern jeder KI-Implementierung ist das Training. Hierbei werden große Mengen an Daten verwendet, um das Modell auf Muster zu trimmen. Die Qualität der Daten ist entscheidend. Schlechte, verzerrte oder unausgewogene Daten führen zu fehlerhaften oder unfairen Modellen. Deshalb ist Datenmanagement eine der wichtigsten Disziplinen im maschinellen Lernen. Es reicht nicht, nur große Datenmengen zu sammeln – sie müssen auch sauber, relevant und gut annotiert sein.

Labels (Kennzeichnungen) sind dabei das A und O. Beim überwachten Lernen – der häufigsten Form – werden Daten mit Labels versehen, um das Modell auf konkrete Aufgaben zu trainieren. Dabei ist die Balance zwischen Bias und Variance entscheidend: Zu stark auf die Trainingsdaten angepasst, leidet die Generalisierung. Zu wenig Anpassung führt zu underfitting, einem schwachen Modell, das kaum brauchbar ist.

Hier kommen Techniken wie Cross-Validation, Dropout, Batch-Normalization und Data Augmentation ins Spiel, um die Modelle robuster zu machen. Der Trainingsprozess kostet immense Rechenresourcen, und das Resultat ist nur so gut wie die Datenbasis. Deshalb investieren führende Tech-Konzerne in massive Data Lakes, Cloud-Infrastrukturen und spezialisierte Hardware, um den Lernprozess zu beschleunigen.

Optimierung der Algorithmen: Von Gradient Descent bis Regularisierung

Die mathematische Grundlage der KI-Modelle ist die Optimierung. Gradient Descent ist der Standard-Algorithmus, um die Gewichte im neuronalen Netz so anzupassen, dass der Fehler minimiert wird. Dabei berechnet der AlgorithmusAlgorithmus: Das unsichtbare Rückgrat der digitalen Welt Algorithmus – das Wort klingt nach Science-Fiction, ist aber längst Alltag. Ohne Algorithmen läuft heute nichts mehr: Sie steuern Suchmaschinen, Social Media, Navigation, Börsenhandel, Werbung, Maschinen und sogar das, was du in deinem Lieblingsshop zu sehen bekommst. Doch was ist ein Algorithmus eigentlich, wie funktioniert er und warum ist er das ultimative Werkzeug... die Ableitungen (Gradienten) der Fehlerfunktion und schiebt die Gewichte in die Richtung des steilsten Abstiegs.

Doch allein das reicht nicht. Um Überanpassung zu vermeiden, kommen Regularisierungstechniken wie L2- oder L1-Strafen, Dropout oder Batch Normalization zum Einsatz. Diese Methoden sorgen dafür, dass das Modell nicht nur auf die Trainingsdaten passt, sondern auch auf unbekannte Daten gut generalisiert. Es ist die Kunst, den richtigen Mix aus Komplexität und Simplizität zu finden – eine Herausforderung, die nur erfahrene Data Scientists meistern.

Weiterhin spielen Lernratenanpassung, Early Stopping und Optimierer wie Adam, RMSProp oder Nadam eine zentrale Rolle. Nur wer diese Feinheiten beherrscht, kann Modelle trainieren, die auch in der Praxis funktionieren – schnell, zuverlässig und effizient.

KI in der Praxis: Anwendungen, die dein Business revolutionieren

Im Business-Kontext ist KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... längst kein Spielzeug mehr. Sie steuert Chatbots, personalisierte Empfehlungen, Predictive AnalyticsAnalytics: Die Kunst, Daten in digitale Macht zu verwandeln Analytics – das klingt nach Zahlen, Diagrammen und vielleicht nach einer Prise Langeweile. Falsch gedacht! Analytics ist der Kern jeder erfolgreichen Online-Marketing-Strategie. Wer nicht misst, der irrt. Es geht um das systematische Sammeln, Auswerten und Interpretieren von Daten, um digitale Prozesse, Nutzerverhalten und Marketingmaßnahmen zu verstehen, zu optimieren und zu skalieren...., automatisierte Content-Erstellung, Bilderkennung, Spracherkennung und vieles mehr. Unternehmen, die diese Technologien einsetzen, gewinnen einen entscheidenden Wettbewerbsvorteil, weil sie Daten in handfeste Entscheidungen verwandeln können – in Echtzeit.

Ein Beispiel: Predictive Maintenance in der Industrie. Hier analysiert KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... Sensor- und Maschinendaten, erkennt Muster, die auf einen bevorstehenden Ausfall hindeuten, und sorgt so für minimale Stillstandzeiten. Oder im E-CommerceE-Commerce: Definition, Technik und Strategien für den digitalen Handel E-Commerce steht für Electronic Commerce, also den elektronischen Handel. Damit ist jede Art von Kauf und Verkauf von Waren oder Dienstleistungen über das Internet gemeint. Was früher mit Fax und Katalog begann, ist heute ein hochkomplexes Ökosystem aus Onlineshops, Marktplätzen, Zahlungsdienstleistern, Logistik und digitalen Marketing-Strategien. Wer im digitalen Handel nicht mitspielt,...: Personalisierte Produktvorschläge, die auf NutzerverhaltenNutzerverhalten: Das unbekannte Betriebssystem deines digitalen Erfolgs Nutzerverhalten beschreibt, wie Menschen im digitalen Raum interagieren, klicken, scrollen, kaufen oder einfach wieder verschwinden. Es ist das unsichtbare Skript, nach dem Websites funktionieren – oder eben grandios scheitern. Wer Nutzerverhalten nicht versteht, optimiert ins Blaue, verschwendet Budgets und liefert Google und Co. die falschen Signale. In diesem Glossarartikel zerlegen wir das Thema... basieren, erhöhen Conversion-Raten dramatisch. Das alles basiert auf tiefen neuronalen Netzen, die in der Lage sind, komplexe Zusammenhänge in riesigen Datenmengen zu erkennen.

Auch im Gesundheitswesen revolutionieren KI-Modelle die Diagnostik, indem sie medizinische Bilder mit bisher unerreichter Genauigkeit klassifizieren. Doch hier zeigt sich auch die Kehrseite: Datenqualität, Ethik und Bias sind kritische Themen, die in der Praxis nicht vernachlässigt werden dürfen.

Grenzen und Herausforderungen: Warum KI niemals alles kann

Obwohl KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... beeindruckend ist, hat sie auch klare Grenzen. Sie ist nur so gut wie die Daten, mit denen sie trainiert wurde. Bias in den Trainingsdaten führt zu diskriminierenden oder fehlerhaften Ergebnissen. Sie kann keine echten menschlichen Fähigkeiten wie Empathie, Kreativität oder moralisches Urteilsvermögen ersetzen. Und sie ist anfällig für adversariale Angriffe: Manipulationen an den Eingabedaten, die das Modell in die Irre führen.

Technisch gesehen scheitert KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... oft an Skalierbarkeit, Interpretierbarkeit und Robustheit. Deep-Learning-Modelle sind „Black Boxes“ – es ist schwer nachzuvollziehen, warum sie eine bestimmte Entscheidung treffen. Das ist problematisch in sensiblen Anwendungsfeldern wie Medizin oder Recht. Daher ist verantwortungsvolle KI-Entwicklung unerlässlich, damit der technologische Fortschritt nicht zum Risiko wird.

Technische Infrastruktur für KI: Hardware, Frameworks und Datenmanagement

Unter der Haube braucht es für KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... eine robuste technische Infrastruktur. Hochleistungsfähige Hardware – GPUs und TPUs – sind Pflicht, um Trainingszeiten zu verkürzen. Frameworks wie TensorFlow, PyTorch oder JAX bilden die Basis für die Entwicklung komplexer Modelle. Sie bieten APIs, Optimierer und Tools, um neuronale Netze effizient zu bauen und zu trainieren.

Das Datenmanagement ist ebenso entscheidend: Data Lakes, ETL-Prozesse, Datenqualitätssicherung und Versionierung. Ohne saubere Daten ist kein Modell stabil, keine Aussage zuverlässig. Cloud-Services wie Google Cloud, AWS oder Azure bieten die nötige Skalierbarkeit, um enorme Datenmengen zu verarbeiten und Modelle in Produktion zu bringen.

Abgerundet wird das Ganze durch Monitoring-Tools, Logging und Continuous-Integration-Frameworks, um Modelle regelmäßig zu evaluieren und zu aktualisieren – denn KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... ist kein Projekt, sondern ein fortlaufender Prozess.

Der moralische Kompass: Bias, Verantwortung und Ethik in KI

Hier wird es ernst: KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... ist keine neutrale Technologie. Sie spiegelt die Vorurteile, Bias und Werte ihrer Entwickler wider. Ohne gezielte Maßnahmen entstehen diskriminierende Modelle, die etwa bei Personalauswahl, Kreditvergabe oder Gesichtserkennung Ungerechtigkeiten verstärken. Deshalb ist Responsible AI ein Muss: Transparenz, Fairness und DatenschutzDatenschutz: Die unterschätzte Macht über digitale Identitäten und Datenflüsse Datenschutz ist der Begriff, der im digitalen Zeitalter ständig beschworen, aber selten wirklich verstanden wird. Gemeint ist der Schutz personenbezogener Daten vor Missbrauch, Überwachung, Diebstahl und Manipulation – egal ob sie in der Cloud, auf Servern oder auf deinem Smartphone herumlungern. Datenschutz ist nicht bloß ein juristisches Feigenblatt für Unternehmen, sondern... müssen integraler Bestandteil jeder KI-Entwicklung sein.

Regulierungen und Standards entwickeln sich rasant, und Unternehmen, die hier nicht mitziehen, riskieren Klagen, Reputationsverluste und regulatorische Maßnahmen. Es ist keine technische Frage mehr, sondern eine gesellschaftliche Verantwortung, die KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... in eine positive Richtung zu lenken.

Ausblick: Die Zukunft der KI – was kommt als Nächstes?

Die Entwicklung schreitet rasant voran. Zukunftstrends wie multimodale Modelle, die Text, Bild und Ton kombinieren, werden Standard. Few-Shot und Zero-Shot Learning ermöglichen es, mit minimalen Daten erstaunliche Ergebnisse zu erzielen. Und die Integration von KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... in Edge Devices sorgt dafür, dass intelligente Systeme noch decentraler und datenschutzfreundlicher werden.

Gleichzeitig steigen die Herausforderungen: Erklärbarkeit, Bias-Vermeidung, Energieverbrauch und Compliance. Die nächste Generation von KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... wird noch intelligenter, aber auch noch verantwortungsvoller sein müssen. Nur wer die technische Tiefe versteht, kann diese Zukunft aktiv mitgestalten – und nicht nur passiv zusehen, wie die Maschine übernimmt.

Wer also im digitalen Wettstreit noch vorne mitspielen will, muss die Funktionsweise der KIKI (Künstliche Intelligenz): Mythos, Marketing-Buzzword oder echte Disruption? KI steht für Künstliche Intelligenz – ein Begriff, der seit Jahrzehnten zwischen Science-Fiction, Hype und handfester Technologie pendelt. Im Kern beschreibt KI die Entwicklung von Algorithmen und Systemen, die Aufgaben lösen können, für die traditionell menschliche Intelligenz notwendig war: Verstehen, Lernen, Schlussfolgern, Problemlösen, Wahrnehmen. KI ist längst mehr als ein Buzzword. Sie... verstehen. Nur so kannst du die Chancen nutzen, Risiken minimieren und den echten Mehrwert aus diesen Technologien ziehen. Und eins ist klar: Ohne technisches Grundwissen wird das in Zukunft kaum noch gehen.

Willkommen in der Welt der Künstlichen Intelligenz – tief, technisch, revolutionär.