SEO Bots für Integration testen: Expertenstrategien erklärt

Wenn du denkst, dass deine Website nur gut aussehen und packende Inhalte haben muss, um bei Google zu landen, hast du den Schuss noch nicht gehört. Die Wahrheit ist: Ohne eine saubere, technische Integration deiner SEO-Bots läuft alles ins Leere – und du kannst noch so viel ContentContent: Das Herzstück jedes Online-Marketings Content ist der zentrale Begriff jeder digitalen Marketingstrategie – und das aus gutem Grund. Ob Text, Bild, Video, Audio oder interaktive Elemente: Unter Content versteht man sämtliche Inhalte, die online publiziert werden, um eine Zielgruppe zu informieren, zu unterhalten, zu überzeugen oder zu binden. Content ist weit mehr als bloßer Füllstoff zwischen Werbebannern; er ist... produzieren, der AlgorithmusAlgorithmus: Das unsichtbare Rückgrat der digitalen Welt Algorithmus – das Wort klingt nach Science-Fiction, ist aber längst Alltag. Ohne Algorithmen läuft heute nichts mehr: Sie steuern Suchmaschinen, Social Media, Navigation, Börsenhandel, Werbung, Maschinen und sogar das, was du in deinem Lieblingsshop zu sehen bekommst. Doch was ist ein Algorithmus eigentlich, wie funktioniert er und warum ist er das ultimative Werkzeug... wird dich ignorieren. Es ist Zeit, die Schrauben anzuziehen, die Bot-Integration zu perfektionieren – sonst bleibst du im digitalen Niemandsland hängen.

- Warum die richtige Bot-Integration für SEOSEO (Search Engine Optimization): Das Schlachtfeld der digitalen Sichtbarkeit SEO, kurz für Search Engine Optimization oder Suchmaschinenoptimierung, ist der Schlüsselbegriff für alle, die online überhaupt gefunden werden wollen. Es bezeichnet sämtliche Maßnahmen, mit denen Websites und deren Inhalte so optimiert werden, dass sie in den unbezahlten, organischen Suchergebnissen von Google, Bing und Co. möglichst weit oben erscheinen. SEO ist längst... unerlässlich ist

- Die wichtigsten SEO-Bots und ihre Funktionalität

- Schritte zur effektiven Testung deiner Bot-Integration

- Tools und Techniken für tiefgehende Bot-Analysen

- Häufige Fehler bei Bot-Implementierungen und wie du sie vermeidest

- Langfristige Strategien für Bot-Management und Monitoring

- Warum deine SEO-Performance ohne Bot-Tests auf der Strecke bleibt

Warum die richtige Bot-Integration für SEO unerlässlich ist

In der Welt des SEOSEO (Search Engine Optimization): Das Schlachtfeld der digitalen Sichtbarkeit SEO, kurz für Search Engine Optimization oder Suchmaschinenoptimierung, ist der Schlüsselbegriff für alle, die online überhaupt gefunden werden wollen. Es bezeichnet sämtliche Maßnahmen, mit denen Websites und deren Inhalte so optimiert werden, dass sie in den unbezahlten, organischen Suchergebnissen von Google, Bing und Co. möglichst weit oben erscheinen. SEO ist längst... sind Bots die unsichtbaren Helfer, die deine Website überhaupt erst in den Index bringen. Ohne sie läuft nichts – keine Rankings, kein TrafficTraffic: Die wahre Währung des digitalen Marketings Traffic – der Begriff klingt harmlos, fast banal. Tatsächlich ist Traffic das Lebenselixier jeder Website, der Pulsschlag des Online-Marketings und der ultimative Gradmesser für digitale Sichtbarkeit. Ohne Traffic bleibt jede noch so geniale Seite ein Geisterschiff im Ozean des Internets. Dieser Glossar-Artikel zerlegt das Thema Traffic in seine Einzelteile, von Definition bis Technologie,..., keine SichtbarkeitSichtbarkeit: Die unbarmherzige Währung des digitalen Marketings Wenn es im Online-Marketing eine einzige Währung gibt, die wirklich zählt, dann ist es Sichtbarkeit. Sichtbarkeit – im Fachjargon gern als „Visibility“ bezeichnet – bedeutet schlicht: Wie präsent ist eine Website, ein Unternehmen oder eine Marke im digitalen Raum, insbesondere in Suchmaschinen wie Google? Wer nicht sichtbar ist, existiert nicht. Punkt. In diesem.... Doch was viele nicht wissen: Die Art und Weise, wie du deine Bots integrierst, entscheidet maßgeblich darüber, ob dein ContentContent: Das Herzstück jedes Online-Marketings Content ist der zentrale Begriff jeder digitalen Marketingstrategie – und das aus gutem Grund. Ob Text, Bild, Video, Audio oder interaktive Elemente: Unter Content versteht man sämtliche Inhalte, die online publiziert werden, um eine Zielgruppe zu informieren, zu unterhalten, zu überzeugen oder zu binden. Content ist weit mehr als bloßer Füllstoff zwischen Werbebannern; er ist... überhaupt durchgelassen wird. Eine fehlerhafte oder unvollständige Bot-Implementierung führt dazu, dass Google wichtige Seiten ignoriert, während andere unnötig gecrawlt werden – was dein Crawl-Budget verschwendet und deine Rankings zerstört.

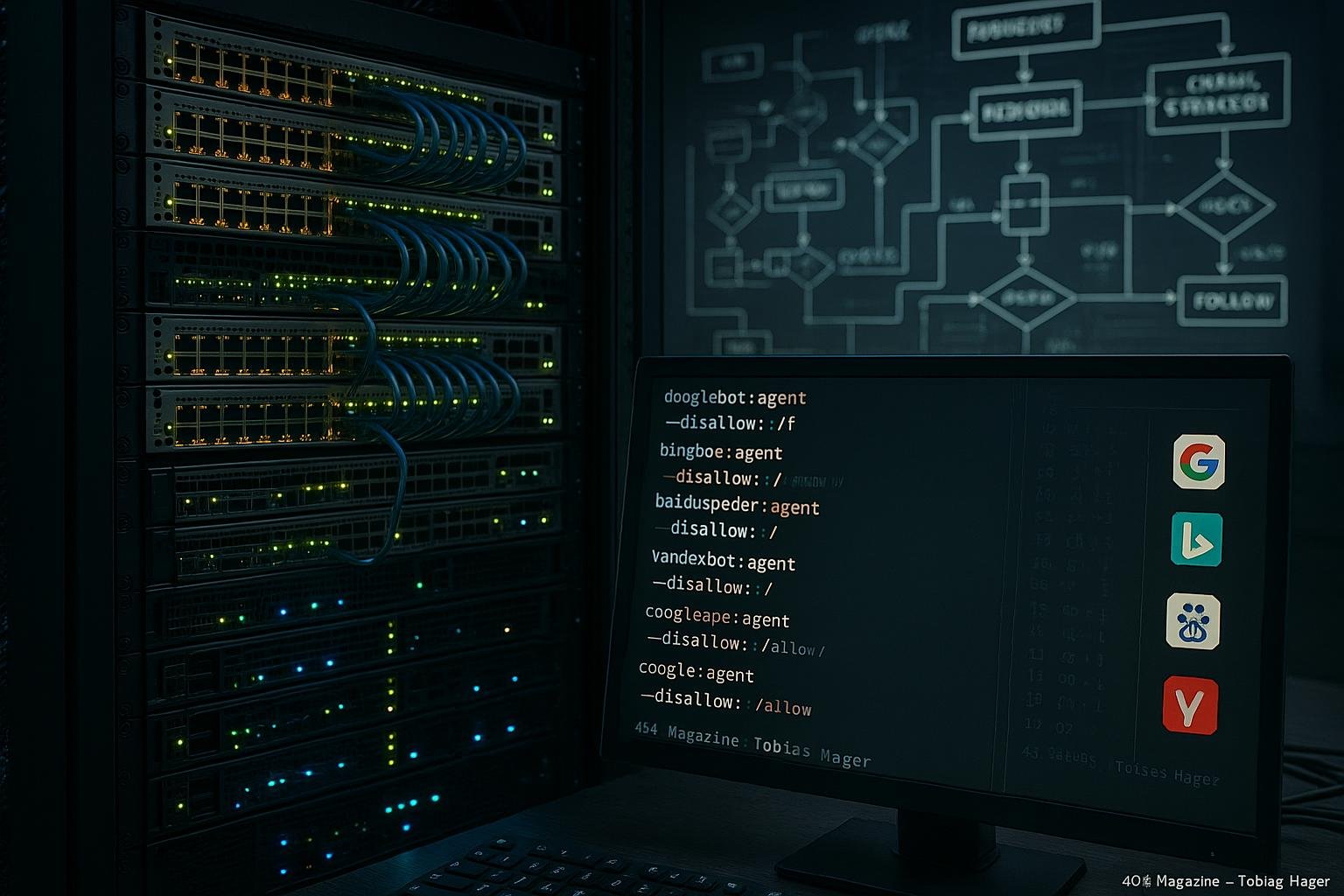

Die Herausforderung liegt darin, die verschiedenen Bots korrekt zu konfigurieren. Googlebot, Bingbot, Baiduspider, Yandex – jedes dieser Programme hat eigene Eigenheiten und Anforderungen. Wenn du sie nicht richtig steuerst, riskierst du, dass wertvolle Seiten gar nicht erst in den Index gelangen oder dass du mit unnötigem Datenaufwand dein Crawl-Budget sprengst. Daher ist eine gezielte, technische Steuerung der Bots – inklusive Robots.txtRobots.txt: Das Bollwerk zwischen Crawlern und deinen Daten Die robots.txt ist das vielleicht meistunterschätzte, aber mächtigste Textfile im Arsenal eines jeden Website-Betreibers – und der Gatekeeper beim Thema Crawling. Sie entscheidet, welche Bereiche deiner Website von Suchmaschinen-Crawlern betreten werden dürfen und welche nicht. Ohne robots.txt bist du digital nackt – und der Googlebot tanzt, wo er will. In diesem Artikel..., Meta-Tags und hreflang-Implementierungen – das Fundament für eine erfolgreiche SEO-Strategie.

Doch es reicht nicht, nur die richtige Konfiguration zu haben. Du musst wissen, ob deine Maßnahmen auch funktionieren. Genau hier kommen Bot-Tests ins Spiel: Sie sind der Schlüssel, um sicherzustellen, dass deine Bots alles erfassen, was du willst – und nichts, was du nicht willst. Ohne diese Tests riskierst du, blind durch die Gegend zu navigieren, während dein SEOSEO (Search Engine Optimization): Das Schlachtfeld der digitalen Sichtbarkeit SEO, kurz für Search Engine Optimization oder Suchmaschinenoptimierung, ist der Schlüsselbegriff für alle, die online überhaupt gefunden werden wollen. Es bezeichnet sämtliche Maßnahmen, mit denen Websites und deren Inhalte so optimiert werden, dass sie in den unbezahlten, organischen Suchergebnissen von Google, Bing und Co. möglichst weit oben erscheinen. SEO ist längst... im Blindflug versinkt.

Die wichtigsten SEO-Bots und ihre Funktionalität verstehen

Bevor du mit Tests anfängst, solltest du die wichtigsten Bots kennen – und ihre Eigenheiten verstehen. Googlebot beispielsweise ist in der Lage, JavaScriptJavaScript: Das Rückgrat moderner Webentwicklung – und Fluch für schlechte Seiten JavaScript ist die universelle Programmiersprache des Webs. Ohne JavaScript wäre das Internet ein statisches Museum aus langweiligen HTML-Seiten. Mit JavaScript wird aus einer simplen Webseite eine interaktive Webanwendung, ein dynamisches Dashboard oder gleich ein kompletter Online-Shop. Doch so mächtig die Sprache ist, so gnadenlos ist sie auch bei schlechter... zu rendern, was bei anderen Bots noch immer ein Problem ist. Bingbot ist oft konservativer, was das Crawling komplexer Seiten betrifft. Baiduspider und Yandex haben eigene Prioritäten und Crawl-Algorithmen, die du kennen solltest, um deine Tests effektiv zu gestalten.

Jeder Bot folgt bestimmten Regeln, die du in der robots.txtRobots.txt: Das Bollwerk zwischen Crawlern und deinen Daten Die robots.txt ist das vielleicht meistunterschätzte, aber mächtigste Textfile im Arsenal eines jeden Website-Betreibers – und der Gatekeeper beim Thema Crawling. Sie entscheidet, welche Bereiche deiner Website von Suchmaschinen-Crawlern betreten werden dürfen und welche nicht. Ohne robots.txt bist du digital nackt – und der Googlebot tanzt, wo er will. In diesem Artikel..., den Meta-Tags, dem hreflang-Attribut und in der SitemapSitemap: Das Rückgrat der Indexierung und SEO-Performance Die Sitemap ist das digitale Inhaltsverzeichnis deiner Website und ein essentielles Werkzeug für effiziente Suchmaschinenoptimierung (SEO). Sie zeigt Suchmaschinen-Crawlern, welche Seiten existieren, wie sie strukturiert sind und wie oft sie aktualisiert werden. Ohne Sitemap kann sich selbst die technisch sauberste Website schnell im Nebel der Unsichtbarkeit verlieren. In diesem Artikel erfährst du, warum... steuern kannst. Googlebot beispielsweise respektiert Noindex, NofollowNofollow: Das kontroverse Attribut für Links im SEO-Kosmos Nofollow ist ein Attribut, das Links im HTML-Code markiert und sie für Suchmaschinen wie Google, Bing oder Yandex als „nicht zu folgen“ kennzeichnet. Genauer: Mit rel="nofollow" signalisierst du dem Crawler, dass er dem jeweiligen Link nicht folgen und vor allem keinen „Linkjuice“ (Rankingkraft) weitergeben soll. Ursprünglich als Waffe gegen Kommentarspam eingeführt, ist... und canonical-Tags – aber nur, wenn sie korrekt gesetzt sind. Ein Fehler hier kann dazu führen, dass dein ContentContent: Das Herzstück jedes Online-Marketings Content ist der zentrale Begriff jeder digitalen Marketingstrategie – und das aus gutem Grund. Ob Text, Bild, Video, Audio oder interaktive Elemente: Unter Content versteht man sämtliche Inhalte, die online publiziert werden, um eine Zielgruppe zu informieren, zu unterhalten, zu überzeugen oder zu binden. Content ist weit mehr als bloßer Füllstoff zwischen Werbebannern; er ist... entweder gar nicht gecrawlt oder doppelt indexiert wird. Das Verstehen dieser Unterschiede ist essenziell, um gezielte Tests durchzuführen und die richtigen Schlüsse zu ziehen.

Zudem unterscheiden sich die Bots im Verhalten bei Ressourcen wie CSSCSS (Cascading Style Sheets): Die Sprache des Webdesigns entschlüsselt CSS steht für Cascading Style Sheets und ist die Sprache, mit der das Web schön gemacht wird. Ohne CSS wäre das Internet ein monochromes, typografisches Trauerspiel. CSS trennt die inhaltliche Struktur von HTML sauber von der Präsentation und sorgt für Layout, Farben, Schriftarten, Animationen und sogar komplexe Responsive Designs. Kurz gesagt:..., JavaScriptJavaScript: Das Rückgrat moderner Webentwicklung – und Fluch für schlechte Seiten JavaScript ist die universelle Programmiersprache des Webs. Ohne JavaScript wäre das Internet ein statisches Museum aus langweiligen HTML-Seiten. Mit JavaScript wird aus einer simplen Webseite eine interaktive Webanwendung, ein dynamisches Dashboard oder gleich ein kompletter Online-Shop. Doch so mächtig die Sprache ist, so gnadenlos ist sie auch bei schlechter..., Bildern und Fonts. Wenn du diese Ressourcen blockierst oder falsch konfigurierst, erkennt Google deine Seite nicht richtig – was zu fehlerhaftem Rendern und IndexierungIndexierung: Wie Webseiten den Weg in die Suchmaschine finden (und warum sie dort bleiben wollen) Autor: Tobias Hager Was bedeutet Indexierung? Definition, Grundlagen und der technische Prozess Indexierung ist im SEO-Kosmos das Eintrittsticket ins Spiel. Ohne Indexierung kein Ranking, keine Sichtbarkeit, kein Traffic – schlicht: keine Relevanz. Kurz gesagt bezeichnet Indexierung den Prozess, durch den Suchmaschinen wie Google, Bing oder... führt. Deshalb ist es wichtig, die spezifischen Crawl- und Render-Profile der jeweiligen Bots zu kennen, um ihre Funktionalität richtig zu testen.

Schritte zur effektiven Testung deiner Bot-Integration

Der Weg zu einer fehlerfreien Bot-Integration ist kein Hexenwerk – aber er ist systematisch. Hier eine Schritt-für-Schritt-Anleitung, um sicherzustellen, dass deine Bots alles richtig machen:

- Bestandsaufnahme der aktuellen Konfiguration: Überprüfe die aktuelle robots.txtRobots.txt: Das Bollwerk zwischen Crawlern und deinen Daten Die robots.txt ist das vielleicht meistunterschätzte, aber mächtigste Textfile im Arsenal eines jeden Website-Betreibers – und der Gatekeeper beim Thema Crawling. Sie entscheidet, welche Bereiche deiner Website von Suchmaschinen-Crawlern betreten werden dürfen und welche nicht. Ohne robots.txt bist du digital nackt – und der Googlebot tanzt, wo er will. In diesem Artikel..., Meta-Tags, Sitemaps und hreflang-Einstellungen. Nutze dafür Tools wie Screaming Frog, Sitebulb oder die Google Search ConsoleGoogle Search Console: Dein Kontrollzentrum für SEO und Website-Performance Die Google Search Console (GSC) ist das offizielle, kostenlose Analyse- und Überwachungstool von Google für Website-Betreiber, SEOs und Online-Marketing-Profis. Sie liefert unverzichtbare Einblicke in Sichtbarkeit, technische Performance, Indexierung und Suchmaschinen-Rankings. Wer seine Website ernsthaft betreibt, kommt an der Google Search Console nicht vorbei – denn ohne Daten bist du im SEO..., um erste Fehler zu identifizieren.

- Simuliere den Crawl mit Google Search ConsoleGoogle Search Console: Dein Kontrollzentrum für SEO und Website-Performance Die Google Search Console (GSC) ist das offizielle, kostenlose Analyse- und Überwachungstool von Google für Website-Betreiber, SEOs und Online-Marketing-Profis. Sie liefert unverzichtbare Einblicke in Sichtbarkeit, technische Performance, Indexierung und Suchmaschinen-Rankings. Wer seine Website ernsthaft betreibt, kommt an der Google Search Console nicht vorbei – denn ohne Daten bist du im SEO...: Nutze den URL-Inspektor, um zu sehen, wie Google deine Seite rendert und welche Ressourcen es crawlt. Erkennst du hier Blockaden oder Fehler, ist Handlungsbedarf vorhanden.

- Verwende spezielle Bot-Testing-Tools: Tools wie Screaming Frog in der erweiterten Ansicht oder DeepCrawl erlauben es, den Crawl-Prozess einzelner Bots zu simulieren. Überprüfe, ob alle wichtigen Ressourcen geladen werden und ob es Blockaden gibt.

- Render-Tests durchführen: Mit den Chrome DevTools kannst du im „Network“-Tab simulieren, wie Googlebot deine Seite sieht. Nutze die Funktion “Abruf wie durch Google” in der Search ConsoleSearch Console: Das unverzichtbare SEO-Tool für Website-Betreiber Die Search Console – oft noch als „Google Search Console“ bezeichnet – ist das zentrale Analyse- und Diagnose-Tool für alle, die ernsthaft an der Sichtbarkeit ihrer Website in Suchmaschinen arbeiten. Sie liefert tiefe Einblicke in die Performance deiner Seiten bei Google, deckt technische Probleme auf und ist damit das Schweizer Taschenmesser für Suchmaschinenoptimierung...., um die vollständige Rendering-Qualität zu prüfen.

- Logfile-Analyse: Lade deine Server-Logs herunter und analysiere, welche Bots welche URLs besuchen. Tools wie Screaming Frog Log Analyzer oder ELK-Stack helfen dir, Crawl-Muster zu erkennen und Fehler zu identifizieren.

- Langzeit-Monitoring etablieren: Automatisiere regelmäßige Bot-Tests und überwache die Crawling-Performance. Nutze Alerts für unerwartete Crawl-Fehler oder abnehmende Crawl-Raten, um frühzeitig gegenzusteuern.

Tools und Techniken für tiefgehende Bot-Analysen

Nur mit den richtigen Werkzeugen kannst du die komplexen Zusammenhänge deiner Bot-Integration durchdringen. Hier eine Übersicht der wichtigsten Tools, die dir beim Testen und Optimieren helfen:

- Screaming Frog SEOSEO (Search Engine Optimization): Das Schlachtfeld der digitalen Sichtbarkeit SEO, kurz für Search Engine Optimization oder Suchmaschinenoptimierung, ist der Schlüsselbegriff für alle, die online überhaupt gefunden werden wollen. Es bezeichnet sämtliche Maßnahmen, mit denen Websites und deren Inhalte so optimiert werden, dass sie in den unbezahlten, organischen Suchergebnissen von Google, Bing und Co. möglichst weit oben erscheinen. SEO ist längst... Spider: Das Standard-Tool für umfassende Crawling-Analysen. Mit erweiterten Einstellungen kannst du gezielt einzelne Bots simulieren, Ressourcen blockieren oder User-Agent-Strings anpassen.

- Google Search ConsoleGoogle Search Console: Dein Kontrollzentrum für SEO und Website-Performance Die Google Search Console (GSC) ist das offizielle, kostenlose Analyse- und Überwachungstool von Google für Website-Betreiber, SEOs und Online-Marketing-Profis. Sie liefert unverzichtbare Einblicke in Sichtbarkeit, technische Performance, Indexierung und Suchmaschinen-Rankings. Wer seine Website ernsthaft betreibt, kommt an der Google Search Console nicht vorbei – denn ohne Daten bist du im SEO...: Das erste DashboardDashboard: Die Kommandozentrale für Daten, KPIs und digitale Kontrolle Ein Dashboard ist weit mehr als ein hübsches Interface mit bunten Diagrammen – es ist das digitale Cockpit, das dir in Echtzeit den Puls deines Geschäfts, deiner Website oder deines Marketings zeigt. Dashboards visualisieren komplexe Datenströme aus unterschiedlichsten Quellen und machen sie sofort verständlich, steuerbar und nutzbar. Egal ob Webanalyse, Online-Marketing,... für Bot-Fehler, Indexierungsprobleme und Render-Tests. Nutze den URL-Inspektor, um die Googlebot-Rendering-Qualität zu überprüfen.

- DeepCrawl: Für größere Projekte geeignet, mit detaillierten Crawl-Reports, Bot-Profile und Fehleranalysen. Besonders hilfreich bei komplexen Seitenstrukturen.

- WebPageTest.org: Um die Ladezeiten und das Rendering-Verhalten verschiedener Bots aus unterschiedlichen Regionen zu testen. Ideal, um Bot-spezifische Performance-Probleme zu erkennen.

- Skripting mit Puppeteer oder Playwright: Für individuelle Tests, automatisierte Crawls und Render-Überprüfungen. Damit kannst du genau simulieren, wie Googlebot deine Seite sieht.

- Server-Logfile-Analyse: Mit Tools wie Loggly, Logstash oder ELK kannst du Crawl-Muster, Blockierungen und Ressourcen-Fehler sichtbar machen. Essentiell für tiefgehende Optimierungen.

Häufige Fehler bei Bot-Implementierungen und wie du sie vermeidest

Viele Webmaster begehen typische Fehler, die die Effektivität ihrer Bot-Strategien massiv einschränken. Hier die wichtigsten Fallstricke – und wie du sie umgehst:

- Falsche robots.txt-Konfiguration: Das Blockieren wichtiger Ressourcen oder das Verhindern des Crawlings der eigenen SitemapSitemap: Das Rückgrat der Indexierung und SEO-Performance Die Sitemap ist das digitale Inhaltsverzeichnis deiner Website und ein essentielles Werkzeug für effiziente Suchmaschinenoptimierung (SEO). Sie zeigt Suchmaschinen-Crawlern, welche Seiten existieren, wie sie strukturiert sind und wie oft sie aktualisiert werden. Ohne Sitemap kann sich selbst die technisch sauberste Website schnell im Nebel der Unsichtbarkeit verlieren. In diesem Artikel erfährst du, warum.... Lösung: Sorgfältige Prüfung und Test mit den oben genannten Tools.

- Unklare Meta-Tags und Canonicals: Fehlerhafte Setzungen führen zu Duplicate ContentDuplicate Content: Das SEO-Killer-Syndrom im Online-Marketing Duplicate Content, zu Deutsch „doppelter Inhalt“, ist einer der am meisten unterschätzten, aber folgenschwersten Fehler im SEO-Kosmos. Damit bezeichnet man identische oder sehr ähnliche Inhalte, die unter mehreren URLs im Internet auffindbar sind – entweder auf derselben Website (interner Duplicate Content) oder auf verschiedenen Domains (externer Duplicate Content). Google und andere Suchmaschinen mögen keine... oder Indexierungsverweigerung. Lösung: Klare Regeln, regelmäßige Checks und Nutzung der Search ConsoleSearch Console: Das unverzichtbare SEO-Tool für Website-Betreiber Die Search Console – oft noch als „Google Search Console“ bezeichnet – ist das zentrale Analyse- und Diagnose-Tool für alle, die ernsthaft an der Sichtbarkeit ihrer Website in Suchmaschinen arbeiten. Sie liefert tiefe Einblicke in die Performance deiner Seiten bei Google, deckt technische Probleme auf und ist damit das Schweizer Taschenmesser für Suchmaschinenoptimierung.....

- Blockade durch unnötige Noindex oder NofollowNofollow: Das kontroverse Attribut für Links im SEO-Kosmos Nofollow ist ein Attribut, das Links im HTML-Code markiert und sie für Suchmaschinen wie Google, Bing oder Yandex als „nicht zu folgen“ kennzeichnet. Genauer: Mit rel="nofollow" signalisierst du dem Crawler, dass er dem jeweiligen Link nicht folgen und vor allem keinen „Linkjuice“ (Rankingkraft) weitergeben soll. Ursprünglich als Waffe gegen Kommentarspam eingeführt, ist...: Besonders bei dynamischen Seiten. Lösung: Nur dort einsetzen, wo wirklich gewollt, und regelmäßig prüfen.

- Missverständnisse bei hreflang-Implementierungen: Falsche hreflang-Tags können zu Indexierungskonflikten führen. Lösung: Validieren mit Tools wie hreflang-validator.com.

- Unzureichendes Monitoring: Ohne kontinuierliche Kontrolle laufen viele Fehler unbemerkt. Lösung: Automatisierte Tests, Alerts und Logfile-Analysen.

Langfristige Strategien für Bot-Management und Monitoring

Die Arbeit mit SEO-Bots endet nicht mit der einmaligen Konfiguration. Es ist eine kontinuierliche Aufgabe, die ständiges Monitoring, Anpassungen und Optimierungen erfordert. Hier einige bewährte Strategien:

- Regelmäßige Crawling-Überprüfungen: Mindestens monatlich, um technische Fehler frühzeitig zu erkennen und zu beheben.

- Automatisierte Alerts: Bei plötzlichen Crawl-Rückgängen, Blockaden oder Fehlern in der Logfile-Analyse.

- Updates der robots.txtRobots.txt: Das Bollwerk zwischen Crawlern und deinen Daten Die robots.txt ist das vielleicht meistunterschätzte, aber mächtigste Textfile im Arsenal eines jeden Website-Betreibers – und der Gatekeeper beim Thema Crawling. Sie entscheidet, welche Bereiche deiner Website von Suchmaschinen-Crawlern betreten werden dürfen und welche nicht. Ohne robots.txt bist du digital nackt – und der Googlebot tanzt, wo er will. In diesem Artikel... und Sitemaps: Bei Website-Änderungen sofort anpassen und neu testen.

- Testen bei Änderungen: Vor jedem größeren RelaunchRelaunch: Der radikale Neustart deiner Website – Risiken, Chancen und SEO-Fallen Ein Relaunch bezeichnet den umfassenden Neustart einer bestehenden Website – nicht zu verwechseln mit einem simplen Redesign. Beim Relaunch wird die gesamte Webpräsenz technisch, strukturell und inhaltlich überarbeitet, mit dem Ziel, die User Experience, Sichtbarkeit und Performance auf ein neues Level zu heben. Klingt nach Frischzellenkur, kann aber auch... oder neuen Features die Bot-Integration prüfen.

- Schulungen und Dokumentation: Für das Team, um technische Fehler frühzeitig zu vermeiden und Best Practices zu etablieren.

Nur wer die Kontrolle über seine Bot-Strategie behält, kann nachhaltigen SEO-Erfolg sicherstellen. Bot-Management ist kein einmaliges Projekt, sondern eine dauerhafte Aufgabe, die Disziplin und technisches Know-how erfordert.

Fazit: Ohne Bot-Tests bleibt SEO im Blindflug

Wenn du wirklich konkurrenzfähig bleiben willst, kommst du um gezielte Bot-Tests kaum herum. Diese unsichtbaren Helfer entscheiden maßgeblich darüber, ob dein ContentContent: Das Herzstück jedes Online-Marketings Content ist der zentrale Begriff jeder digitalen Marketingstrategie – und das aus gutem Grund. Ob Text, Bild, Video, Audio oder interaktive Elemente: Unter Content versteht man sämtliche Inhalte, die online publiziert werden, um eine Zielgruppe zu informieren, zu unterhalten, zu überzeugen oder zu binden. Content ist weit mehr als bloßer Füllstoff zwischen Werbebannern; er ist... überhaupt in den Index gelangt und wie gut deine Seite rankt. Technisch sauber aufgestellt, mit kontinuierlichem Monitoring und tiefgehender Analyse – nur so kannst du sicherstellen, dass dein SEO-Setup keinen Schwachpunkt offenbart.

Denn am Ende des Tages ist die Bot-Integration das Fundament, auf dem alles andere aufbaut. Ohne sie riskierst du, im digitalen Dschungel verloren zu gehen – während die Konkurrenz mit perfekt getunten Bot-Strategien an dir vorbeizieht. Also, mach dich schlau, teste systematisch und bleibe dauerhaft am Ball – nur so wirst du im Jahr 2025 ganz oben mitspielen.