Event Driven Stack Explained: Klar, Knackig, Kompetent

Du meinst, du kennst dich mit modernen Webarchitekturen aus? Dann erklär mal eben deinem Chef, wie ein Event Driven Stack funktioniert – ohne ins Stottern zu geraten. Viel Glück! Denn die meisten, die darüber reden, meinen eigentlich nur “irgendwas mit Events”. Aber was steckt wirklich dahinter? In diesem Artikel bekommst du nicht nur die Buzzwords, sondern die knallharte, technische Wahrheit: Was ein Event Driven Stack ist, warum er die Zukunft von skalierbaren Systemen bestimmt und wie du ihn richtig aufsetzt. Kein Marketing-Geschwafel, kein Developer-Bingo – nur Fakten, Klartext und Kompetenz.

- Was ein Event Driven Stack wirklich ist – und warum klassische Architekturen dagegen alt aussehen

- Die wichtigsten Bausteine eines Event Driven Stacks: Event Sourcing, Message Broker, Event Bus, Microservices

- Wie Events, Producer, Consumer und Topics zusammenspielen – technisch und strategisch

- Warum Event Driven Architekturen für Skalierbarkeit, Fehlerresilienz und Echtzeitfähigkeit unverzichtbar sind

- Die größten Missverständnisse rund um Event Driven Stacks – und wie du sie vermeidest

- Best Practices für die Implementierung – von der Planung bis zum Betrieb

- Die wichtigsten Tools & Frameworks: Kafka, RabbitMQ, NATS, EventStore & Co.

- Welche Fehler dich die Performance und Integrität kosten – und wie du sie technisch sauber umgehst

- Eine Schritt-für-Schritt-Anleitung für dein erstes Event Driven Projekt

- Fazit: Warum “event-driven” kein Buzzword, sondern Pflicht ist – und wie du den Stack fit für die Zukunft machst

Die Event Driven Architecture (EDA) ist kein Hype, sondern der logische nächste Schritt für alle, die im Zeitalter der Microservices, Cloud-Native-Apps und Echtzeitdaten noch mitspielen wollen. Wer heute noch auf klassische, monolithische Request-Response-Muster setzt, kann direkt den Warteschlangenplatz im digitalen Museum reservieren. Aber was bedeutet das alles konkret? Wie unterscheidet sich ein sauber aufgesetzter Event Driven Stack von den Flickenteppichen, die viele “Enterprise-Architekten” bis heute als Status Quo verkaufen? Und warum ist ein Event Driven Stack der Schlüssel für Performanz, Skalierbarkeit und Flexibilität? Wir gehen der Sache auf den Grund – technisch, kritisch und ohne Bullshit.

Was ist ein Event Driven Stack? Die Architektur hinter dem Buzzword

Der Begriff “Event Driven Stack” wird im Tech-Jargon inflationär benutzt, selten jedoch klar erklärt. Ein Event Driven Stack ist eine Architektur, bei der nicht mehr klassische API-Calls oder direkte Datenbankzugriffe den Informationsaustausch bestimmen, sondern Events. Ein Event ist eine Zustandsänderung, die von einem Service als Nachricht veröffentlicht und von einem oder mehreren anderen Services konsumiert werden kann. Das klingt simpel, ist aber ein radikaler Paradigmenwechsel im Vergleich zu traditionellen, synchronen Architekturen.

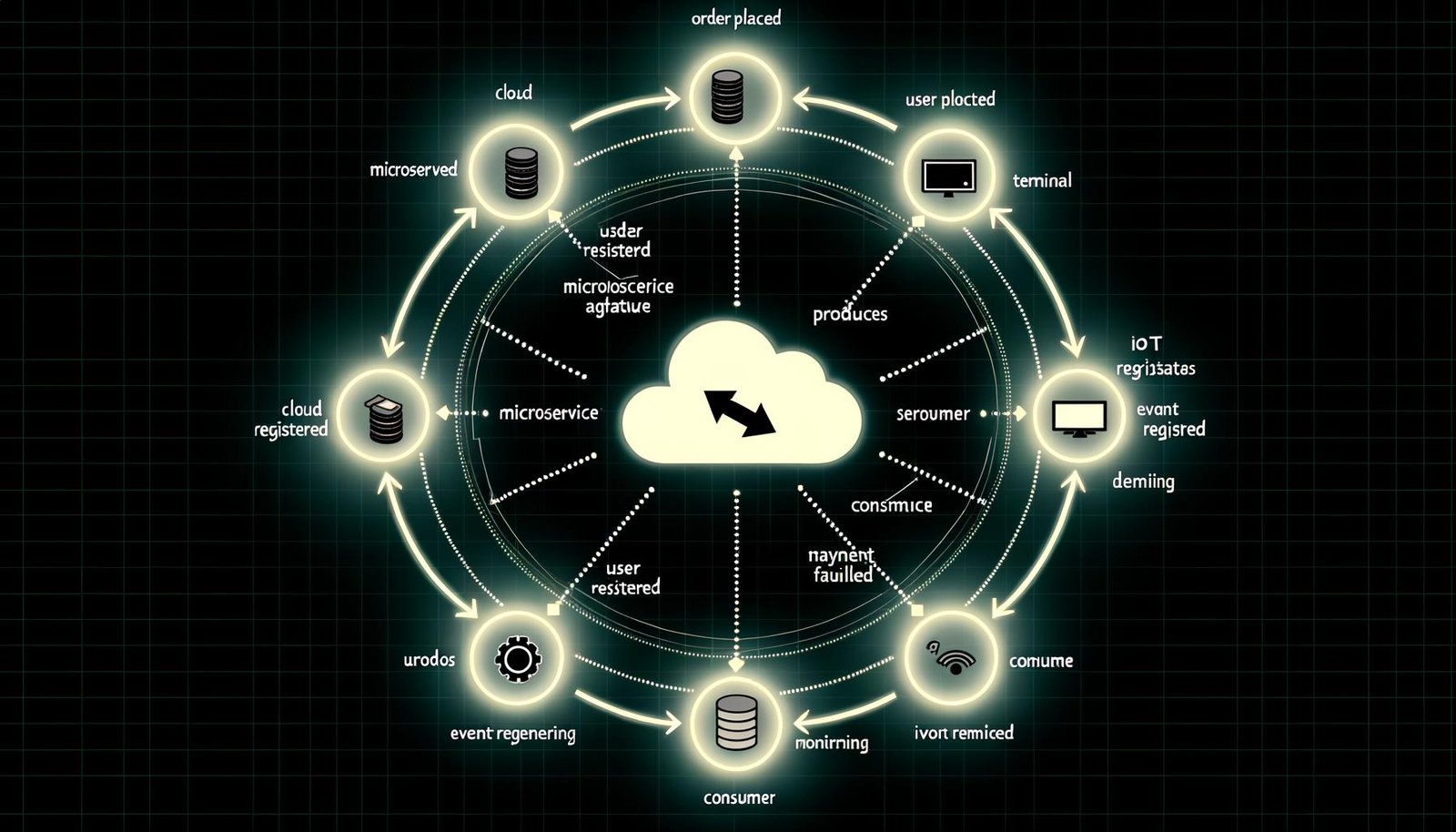

Im Zentrum des Event Driven Stacks steht der Event Broker – auch Message Broker oder Event Bus genannt. Hier werden Events als Messages persistent gespeichert, verteilt und verwaltet. Bekannte Vertreter sind Apache Kafka, RabbitMQ oder NATS. Services, die Events erzeugen, heißen Producer. Services, die auf diese Events reagieren, heißen Consumer. Die Events selbst werden häufig in logischen Kanälen (Topics, Queues, Streams) organisiert und können asynchron verarbeitet werden. Das A und O: Lose Kopplung. Producer und Consumer kennen sich nicht direkt, sondern kommunizieren ausschließlich über den Broker.

Der Vorteil: Ein Event Driven Stack ermöglicht es, komplexe Systeme zu zerlegen und unabhängig voneinander zu skalieren. Fehler in einem Service blockieren nicht das gesamte System – solange der Event Broker läuft, bleibt das System verfügbar. Zudem lassen sich Events speichern (Event Sourcing), nachverarbeiten (Replay) und für Auditing-Zwecke archivieren. Wer das Prinzip verstanden hat, kann Systeme bauen, die “von Natur aus” skalierbar, ausfallsicher und flexibel sind – und die klassischen Engpässe synchroner Architekturen elegant umgehen.

Und jetzt, Hand aufs Herz: Wie viele deiner Projekte setzen wirklich auf einen konsistenten Event Driven Stack – und wie viele verschleiern ihre REST-API-Orgien unter einem Haufen von “Event-Handlern”, die eigentlich nur Callback-Hölle produzieren? Wer es ernst meint, setzt auf echte Events, keine halbgaren Workarounds.

Die zentralen Komponenten eines Event Driven Stacks: Event Broker, Producer, Consumer & mehr

Ein Event Driven Stack besteht nicht aus einer Wunderwaffe, sondern aus einem fein abgestimmten Set von Technologien und Konzepten. Die wichtigsten Elemente im Überblick:

- Event Broker / Message Broker: Die Schaltzentrale, die Events empfängt, speichert, verteilt und im Idealfall auch persistiert. Kafka, RabbitMQ, NATS, AWS Kinesis oder Azure Event Hubs gehören zu den Platzhirschen. Der Broker sorgt für Entkopplung, Skalierung und garantiert, dass kein Event verloren geht.

- Producer: Services, die Events erzeugen und an den Broker schicken. Das kann alles sein: eine Webanwendung, ein IoT-Device, ein Cronjob oder ein Microservice. Wichtig: Producer sind dumm – sie wissen nichts darüber, wer ihre Events konsumiert.

- Consumer: Services, die Events konsumieren und darauf reagieren. Ein Consumer kann auf viele Topics hören und je nach Business Logic agieren: Datenbank schreiben, neue Events erzeugen, externe Systeme triggern.

- Topics/Queues/Streams: Logische Kanäle, über die Events gruppiert und verteilt werden. Ein Topic ist nicht nur ein “Ordner”, sondern definiert, wie Events verteilt, repliziert und ggf. partitioniert werden.

- Event Sourcing und Event Store: Events werden nicht nur verarbeitet, sondern als Quelle der Wahrheit gespeichert. Das erlaubt das vollständige Replay von Systemzuständen und eine lückenlose Historie.

- Event Schema Registry: Verwaltung und Versionierung der Event-Strukturen (meist als JSON Schema, Avro oder Protobuf). Wer hier schlampt, produziert Chaos beim Consumer-Upgrade.

Die große Kunst: All diese Komponenten müssen nicht nur einzeln funktionieren, sondern perfekt zusammenspielen. Jede Schwachstelle – etwa ein falsch konfigurierter Topic, ein Consumer ohne Retry-Mechanismus oder ein Broker ohne Persistenz – rächt sich spätestens im Live-Betrieb. Und noch schlimmer: Viele Entwickler verwechseln Event Driven mit “asynchronem Spaghetti-Code”. Das ist kein Stack, sondern ein Wartungsalbtraum.

Ein echter Event Driven Stack basiert immer auf technischer Disziplin: klare Schnittstellen, sauber definierte Event-Schemas, Monitoring auf allen Ebenen, dedizierte Error-Handling-Strategien und – ganz wichtig – ein Broker, der nicht bei 1.000 Events pro Sekunde in die Knie geht. Wer das ignoriert, baut kein skalierbares System, sondern ein digitales Kartenhaus.

Wie Events, Producer, Consumer und Topics technisch zusammenspielen

Events sind die DNA eines Event Driven Stacks – aber wie funktioniert das Zusammenspiel im Detail? Zeit für einen Deep Dive in die technischen Abläufe:

Ein Producer erzeugt einen Event, etwa “OrderPlaced”, “UserRegistered” oder “PaymentFailed”. Dieser Event wird als Message an den Broker geschickt, typischerweise in ein bestimmtes Topic. Der Broker übernimmt die Weiterleitung, Persistenz und Verteilung. Consumer subscriben auf relevante Topics und reagieren auf eingehende Events. Die Verarbeitung geschieht asynchron – das heißt, der Producer wartet nicht, bis alle Consumer fertig sind. Das entkoppelt die Komponenten vollständig und erlaubt eine massive Parallelisierung.

Die technische Umsetzung sieht typischerweise so aus:

- Producer serialisiert das Event (z.B. als JSON oder Avro), versieht es mit Metadaten (Timestamp, Correlation ID) und sendet es an den Broker.

- Der Broker nimmt die Nachricht entgegen, speichert sie persistent (je nach Broker bis zu mehreren Tagen oder Wochen) und verteilt sie an alle abonnierten Consumer.

- Consumer holen sich die Events, verarbeiten sie und bestätigen die erfolgreiche Verarbeitung (Commit/Acknowledge). Bei Fehlern greifen Retry-Strategien, Dead Letter Queues oder Alerting-Mechanismen.

- Wenn ein Consumer ausfällt, bleibt das Event im Topic/Queue und wird erneut ausgeliefert, sobald der Consumer wieder verfügbar ist.

Der Clou: Neue Consumer können jederzeit hinzugefügt werden, ohne dass die Producer angepasst werden müssen. So lassen sich Funktionen wie AnalyticsAnalytics: Die Kunst, Daten in digitale Macht zu verwandeln Analytics – das klingt nach Zahlen, Diagrammen und vielleicht nach einer Prise Langeweile. Falsch gedacht! Analytics ist der Kern jeder erfolgreichen Online-Marketing-Strategie. Wer nicht misst, der irrt. Es geht um das systematische Sammeln, Auswerten und Interpretieren von Daten, um digitale Prozesse, Nutzerverhalten und Marketingmaßnahmen zu verstehen, zu optimieren und zu skalieren...., Monitoring, Auditing oder Third-Party-Integrationen schnell und sauber andocken. Und niemand muss mehr Angst vor monolithischen Abhängigkeiten haben.

Aber Achtung: Wer Event-Schemas ändert, ohne Versionierung und strikte Validierung zu implementieren, sorgt für Inkompatibilitäten und Produktionsausfälle. “Schema Evolution” ist kein Nice-to-have, sondern Pflicht. Wer es ignoriert, darf nachts gerne den Pager tragen.

Warum Event Driven Architekturen für Skalierung, Fehlerresilienz und Echtzeitfähigkeit unverzichtbar sind

Jetzt wird es ernst: Warum solltest du den Aufwand für einen Event Driven Stack überhaupt betreiben? Die Antwort: Weil klassische Architekturen in Sachen Skalierung, Fehlerresilienz und Echtzeitfähigkeit einfach nicht mithalten können. Wer heute noch große Systeme mit synchronen REST-Calls, zentralen Datenbanken und harter Kopplung baut, bekommt spätestens bei Lastspitzen oder Systemausfällen die Quittung.

Event Driven Stacks erlauben horizontale Skalierung “by design”. Neue Consumer-Instanzen können einfach hinzugefügt werden, ohne dass bestehende Prozesse gestört werden. Der Broker puffert Lastspitzen, Events können im Batch oder verzögert verarbeitet werden, und der Systemzustand bleibt auch bei Teil-Ausfällen konsistent. Durch Event Sourcing können Fehler rückwirkend analysiert, Systeme auf beliebige Zeitpunkte zurückgesetzt und Datenintegrität garantiert werden.

Echtzeitfähigkeit ist ein weiteres Killer-Feature: Events werden innerhalb von Millisekunden verteilt, Consumer können sofort reagieren – perfekt für AnalyticsAnalytics: Die Kunst, Daten in digitale Macht zu verwandeln Analytics – das klingt nach Zahlen, Diagrammen und vielleicht nach einer Prise Langeweile. Falsch gedacht! Analytics ist der Kern jeder erfolgreichen Online-Marketing-Strategie. Wer nicht misst, der irrt. Es geht um das systematische Sammeln, Auswerten und Interpretieren von Daten, um digitale Prozesse, Nutzerverhalten und Marketingmaßnahmen zu verstehen, zu optimieren und zu skalieren...., Monitoring, Fraud Detection und IoT-Anwendungen. Klassische Cronjobs oder Pull-basierte Systeme sehen dagegen alt aus. Und sollte ein Service schlappmachen, verarbeitet er einfach später weiter – kein Datenverlust, keine Blockade.

Natürlich gibt es Herausforderungen: Eventual Consistency, Duplicate Delivery, Out-of-Order Processing. Aber dafür gibt es Lösungen – Idempotenz, genau-once-Semantik, dedizierte Event Stores und Monitoring. Wer sich davor drückt, bekommt am Ende ein System, das zwar “irgendwie läuft”, aber nie an die Performance, Zuverlässigkeit und Flexibilität eines echten Event Driven Stacks heranreicht.

Die größten Mythen & Fehler beim Event Driven Stack – und wie du sie vermeidest

Event Driven klingt schick – aber viele Projekte scheitern an immer denselben Missverständnissen. Hier die größten Stolperfallen und was du dagegen tun kannst:

- “Events sind nur für AnalyticsAnalytics: Die Kunst, Daten in digitale Macht zu verwandeln Analytics – das klingt nach Zahlen, Diagrammen und vielleicht nach einer Prise Langeweile. Falsch gedacht! Analytics ist der Kern jeder erfolgreichen Online-Marketing-Strategie. Wer nicht misst, der irrt. Es geht um das systematische Sammeln, Auswerten und Interpretieren von Daten, um digitale Prozesse, Nutzerverhalten und Marketingmaßnahmen zu verstehen, zu optimieren und zu skalieren.... und Logging”: Falsch. Ein Event Driven Stack ist die Basis für die gesamte Business-Logik, nicht nur für Telemetrie.

- “Ein Broker reicht, den Rest improvisiere ich”: Wer ohne sauberes Schema Management, Monitoring und Retry-Strategien startet, produziert Chaos.

- “Eventual Consistency ist ein No-Go”: Moderne Systeme leben mit kurzzeitigen Inkonsistenzen. Entscheidend ist, dass das System sich selbstständig konsolidiert.

- “Events sind immer schnell”: Alles hängt am Broker. Falsche Partitionierung, zu kleine Consumer-Gruppen oder fehlendes Backpressure-Management führen zu Latenz-Hölle.

- “Events ersetzen alle APIs”: Unsinn. Es gibt weiterhin Use Cases für synchrone Schnittstellen – aber der Default sollte Event First sein.

Merke: Der größte Fehler ist es, Events einfach “draufzupflanzen”, ohne die Infrastruktur und Prozesse darauf auszurichten. Ein Event Driven Stack ist kein Add-on, sondern eine eigene Disziplin. Wer sie ignoriert, baut einen Wartungsalbtraum – und wird in der ersten Lastspitze gnadenlos abgestraft.

Die wichtigsten Lessons Learned:

- Versioniere und validiere alle Event-Schemas.

- Implementiere Monitoring, Alerting und Dead Letter Queues von Anfang an.

- Plane mit Eventual Consistency und baue Idempotenz in jede Consumer-Logik ein.

- Skaliere Broker und Consumer unabhängig voneinander.

- Teste das gesamte System regelmäßig auf Backpressure und Fehlerfälle.

Die wichtigsten Tools & Frameworks für den Event Driven Stack

Ein Event Driven Stack steht und fällt mit der richtigen Toolchain. Hier die Platzhirsche, die du kennen und beherrschen musst:

- Apache Kafka: Der De-facto-Standard für Event Streaming. Hohe Durchsatzraten, starke Persistenz, mächtige Partitionierung und ein riesiges Ökosystem. Wer skalieren will, kommt an Kafka kaum vorbei.

- RabbitMQ: Solide Message Queue mit Fokus auf Zuverlässigkeit, Routing und einfache Integration. Perfekt für klassische Messaging-Patterns und moderate Event-Volumina.

- NATS: Extrem leichtgewichtig, super schnell und Cloud Native. Ideal für Microservices, bei denen Latenz und Ressourcenverbrauch kritisch sind.

- EventStoreDB: Speziell für Event Sourcing entwickelt. Bietet genau-once-Semantik, Versionierung und Replay-Funktionalitäten auf Enterprise-Niveau.

- Schema Registries: Tools wie Confluent Schema Registry oder Apicurio verwalten und versionieren Event-Schemas – ein Muss für sauberes Event Management.

- Frameworks & Libraries: Spring Cloud Stream, Akka Streams, Axon, MassTransit, NestJS/EventEmitter – je nach Programmiersprache und Anwendungsfall.

Die Auswahl hängt von Use Case, Skalierungsbedarf und Team-Kompetenz ab. Aber eines gilt immer: Wer die Basics nicht beherrscht, wird auch mit dem fancy Toolstack nur Probleme multiplizieren. Also: Erst Architektur und Prozesse sauber aufsetzen – dann Tools wählen.

Schritt-für-Schritt-Anleitung: Dein erster Event Driven Stack

Genug Theorie, jetzt wird geliefert. So setzt du in zehn Schritten einen funktionierenden Event Driven Stack auf:

- Architektur planen: Welche Services sollen Producer, welche Consumer sein? Welche Events werden benötigt? Wie sieht die Event-Domain aus?

- Broker auswählen und aufsetzen: Kafka für hohe Volumina, RabbitMQ für klassische Patterns, NATS für Speed. Installation, Konfiguration, Monitoring von Anfang an.

- Topics/Queues definieren: Logische Trennung nach Business-Domains, klare Namenskonventionen, Partitionierung beachten.

- Event Schemas festlegen: Präzise, versionierte Schemas (z.B. Avro/Protobuf/JSON Schema). Validierung und Evolution von Tag 1 an implementieren.

- Producer entwickeln: Saubere Event-Erzeugung, Fehlerhandling, Rückmeldung bei Delivery-Fails.

- Consumer entwickeln: Idempotente Verarbeitung, Retry-Mechanismen, Dead Letter Queues integrieren.

- Monitoring & Logging einrichten: Broker-Health, Event-Durchsatz, Fehlerquoten, Latenzen überwachen. Tools wie Prometheus, Grafana, ELK-Stack verwenden.

- Load Testing & Backpressure testen: Wie reagiert das System bei 10x, 100x Last? Wo entstehen Bottlenecks?

- Automatisiertes Deployment: Containerisierung (Docker), Orchestrierung (Kubernetes), CI/CD für Producer und Consumer.

- Disaster Recovery planen: Backups für den Broker, Replay-Strategien, Event-Archivierung, Failover-Tests durchführen.

Wer diese Schritte sauber durchzieht, hat nicht nur einen Event Driven Stack, sondern auch eine Architektur, die auf Wachstum, Wandel und Ausfallsicherheit ausgelegt ist. Alles andere ist Spielerei.

Fazit: Event Driven Stack – Pflichtprogramm für moderne Systeme

Der Event Driven Stack ist kein Buzzword, sondern der neue Standard für performante, skalierbare und resiliente Architekturen. Wer heute noch auf klassische, synchron gekoppelte Systeme setzt, sabotiert seine Zukunftsfähigkeit – und wird von der Konkurrenz gnadenlos überholt. Ein sauber aufgesetzter Event Driven Stack entkoppelt Komponenten, erlaubt Echtzeitreaktionen und macht Systeme fit für das, was morgen auf sie zukommt: mehr Daten, mehr Nutzer, mehr Komplexität.

Natürlich ist der Einstieg anspruchsvoll. Aber die Alternative – weiter mit monolithischen Systemen und REST-Orgien rumzudoktern – ist keine Lösung, sondern ein Rezept für Stillstand. Wer den Mut hat, sich mit den technischen Details auseinanderzusetzen, gewinnt: an Flexibilität, Geschwindigkeit und Innovationskraft. Die Zukunft ist Event Driven – und sie ist schon längst da.